Эффективный метод групповой свертки и слияния признаков для обнаружения сорняков

Обнаружение сорняков — ключевая задача для создания систем интеллектуальной прополки овощных культур. В настоящее время исследования в этой области всё ещё довольно ограничены, а существующие методы часто демонстрируют низкую точность и эффективность из-за сложных и изменчивых условий в естественной среде. Для решения этих проблем в данной статье представлена улучшенная модель YOLOv8-EGC-Fusion (YEF), основанная на YOLOv8.

Аннотация

Модель включает следующие легко интегрируемые модули: (1) Модуль Efficient Group Convolution (EGC), который использует фильтры свертки ядра разного размера в комбинации с групповой сверткой для значительного снижения вычислительной сложности. Интеграция EGC с модулем C2f позволила создать модуль C2f-EGC, повышающий способность модели анализировать локальный контекст.(2) Модуль Group Context Anchor Attention (GCAA), предназначенный для выявления сложных взаимосвязей между различными частями изображения, что улучшает общее понимание сцены моделью.(3) Модуль GCAA-Fusion, который обеспечивает эффективное объединение признаков с разных уровней детализации. Это позволяет решить проблему потери полезных деталей из исходных слоев сети и сохранить важную информацию. На основе GCAA-Fusion и PAFPN была разработана архитектура адаптивного слияния признаков (Adaptive Feature Fusion, AFF), которая усиливает способность модели извлекать информативные признаки.

Для всесторонней оценки модели был собран обширный набор изображений сорняков с различных овощных полей. Серия сравнительных экспериментов подтвердила высокую эффективность модели YEF. Результаты показывают, что она превосходит по точности исходную YOLOv8, а также модели Faster R-CNN, RetinaNet, TOOD, RTMDet и YOLOv5. Метрики обнаружения, достигнутые моделью YEF, следующие: точность 0,904, полнота 0,88, оценка F1 0,891 и mAP0.5 0,929. В заключение следует отметить, что модель YEF демонстрирует высокую точность обнаружения для идентификации овощей и сорняков, отвечая требованиям к точному детектированию в реальных условиях.

1. Введение

Овощи занимают значительное положение в мировом сельскохозяйственном производстве. В последние годы овощная отрасль Китая демонстрировала существенный рост, составляя 35% от потребления продовольствия на душу населения. В то время как овощи играют решающую роль в поддержании жизни людей, они также значительно повышают экономическое благосостояние производителей [1, 2, 3]. Будучи основным компонентом агроэкосистем, сорные растения конкурируют с овощными культурами за ресурсы роста [4], серьезно снижая как урожайность, так и качество овощей. В овощеводстве неконтролируемые сорняки могут вызывать потери урожая от 45% до 95% [5]. Поэтому эффективная борьба с сорняками играет жизненно важную роль в продуктивности овощных полей.

Благодаря развитию агротехнологий, интеллектуальные технологии прополки сделали возможным точное идентифицирование и управление сорняками в полях, снижая затраты на управление и минимизируя использование химических гербицидов. Однако сложные полевые условия повышают сложность точного распознавания сорняков [6, 7, 8]. В настоящее время компьютерное зрение — включая традиционное компьютерное зрение, машинное обучение и глубокое обучение — является основной технологией для распознавания сорняков. Традиционные методы компьютерного зрения могут использовать морфологические характеристики овощей и сорняков для детекции, но они требуют много времени и часто не соответствуют требованиям сельскохозяйственного производства [9]. Машинное обучение позволяет осуществлять автоматическое извлечение признаков и принятие решений, но зависит от ручного проектирования признаков (таких как метод опорных векторов (SVM) и деревья решений). Другие соответствующие методики, такие как анализ гиперспектральных изображений и методы дистанционного зондирования, также исследовались для детекции сорняков. Однако эти методы часто сталкиваются с ограничениями в стоимости, сложности обработки данных и применимости в реальном времени в сельскохозяйственных сценариях. В сравнении, алгоритмы детекции объектов на основе глубокого обучения обеспечивают более эффективное решение для задач обнаружения сорняков [10, 11].

Методы детекции объектов на основе глубокого обучения можно в целом разделить на одностадийные и двухстадийные модели. Двухстадийные модели предлагают более высокую точность распознавания, но менее подходят для приложений реального времени [12, 13, 14]. В contrast, как представитель одностадийных моделей, YOLO сохраняет высокую эффективность и производительность в реальном времени, обеспечивая при этом достаточную точность детекции, что делает его более подходящим для обнаружения сорняков в реальном времени на овощных полях [15]. Следовательно, модель YOLO используется в качестве базовой архитектуры для исследований [16].

В последние годы различные версии модели YOLO широко применялись в сельскохозяйственном производстве. Wu и соавт. разработали модель для обнаружения сорняков в капусте на основе YOLOv4, продемонстрировав улучшенную точность для мелких целей-сорняков и лучшую адаптируемость для различных культур. Модель достигла mAP0.5 85.2% [17]. Ying и соавт. модифицировали YOLOv4 для обнаружения сорняков в посевах моркови, включив MobileNetV3-Small Backbone и depth-wise separable convolution. Модификация привела к mAP0.5 89.11% и весу модели 159 МБ [18]. Hu и соавт. разработали многомодульную модель YOLOV-L, комбинируя механизмы внимания Efficient Channel Attention (ECA) и Coordinate Attention (CA) в YOLOv7. Эти улучшения повысили ее производительность, достигнув mAP0.5 97.1%, точности 97.5% и веса модели 18.4 МБ [19]. Solimani и соавт. представили модель детекции формы растений томата на основе YOLOv8, которая позволяет осуществлять мониторинг и оценку формы растений томата и условий их роста в реальном времени. Эта модель достигла mAP0.5 65.08% [20].

В то время как эти исследования продемонстрировали прогресс в обнаружении сорняков и растений, они в основном сосредоточены на улучшении производительности распознавания. Это часто приводило к увеличению сложности и высокой вычислительной нагрузки при обработке изображений, ограничивая их пригодность для встраиваемых систем в сельскохозяйственных сценариях. Кроме того, в цитируемых работах подчеркиваются такие проблемы, как ограниченная обобщающая способность в реальных условиях. Биологическое сходство между овощами и сорняками, нерегулярные контуры сорняков и слабые различия в текстуре и форме в различных полевых условиях создают значительные трудности для производительности распознавания [21, 22].

Модель YOLOv8 демонстрирует более сильные возможности многомасштабного обнаружения и обобщения, эффективно и точно идентифицируя сорняки и культуры на сложном фоне, что делает ее особенно подходящей для обнаружения сорняков на овощных полях. Хотя YOLOv9 и YOLOv10 увидели дальнейшие улучшения, они еще не получили широкой валидации и реже применяются [23, 24].

Данная статья сосредоточена на оптимизации модели YOLOv8 для решения этих проблем и лучшего захвата характеристик сорняков. Предлагаются новые модули слияния признаков и свертки. Конкретные улучшения заключаются в следующем:

(1) Для оптимизации сверточных операций предлагается подключаемый модуль Efficient Group Convolution (EGC). Этот модуль улучшает обработку карт признаков с большим количеством каналов, снижая вычислительную сложность при сохранении точности. Кроме того, EGC служит основой для нового модуля C2f-EGC, который дополнительно оптимизирует извлечение признаков.

(2) Разработан инновационный модуль извлечения признаков на основе внимания, Group Context Anchor Attention (GCAA), для захвата более богатой контекстной информации across признаков. На основе этого модуля разработан модуль GCAA-Fusion для смешивания признаков высокого и низкого уровня с целью повышения точности обнаружения сорняков, усовершенствующий традиционную структуру пирамиды признаков.

(3) Представлена модель YOLOv8-EGC-Fusion, которая построена на основе YOLOv8 с улучшенной структурой сети для повышения возможностей извлечения признаков, особенно для распознавания сорняков на сложном фоне.

2. Материалы и методы

2.1. Сбор и обработка данных

2.1.1. Сбор набора данных по сорнякам на овощных культурах

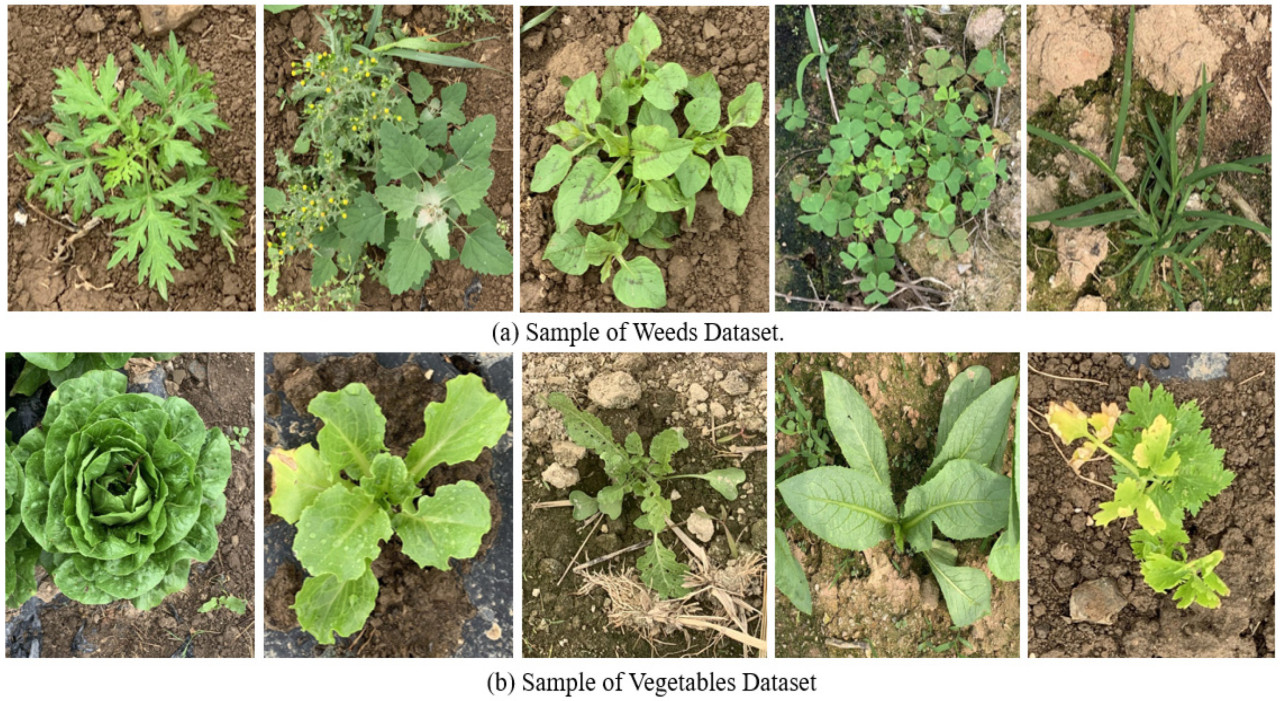

Сбор данных для этого исследования проводился в середине мая, конце июля и середине декабря 2023 года на исследовательской экспериментальной базе Цэнцунь Южно-Китайского сельскохозяйственного университета, расположенной в Гуанчжоу, провинция Гуандун, Китай (широта 23° с.ш., долгота 113° в.д.), как показано на Рисунке 1. Изображения для набора данных делались несколько раз в различных полевых условиях с использованием смартфонов iPhone XS и iPhone 15 (Apple, Купертино, Калифорния, США) (камеры 12 мегапикселей). Изображения были сделаны с высоты 90 см от земли для имитации типичной рабочей высоты робота для прополки, с вертикальным углом съемки и разрешением 3024 × 4032 пикселей. Набор данных включает различные типы и стадии роста как овощей, так и сорняков. Стадии роста овощей в основном варьировались от ранних до средних, с видами, включающими Lactuca sativa (салат), Brassica rapa subsp. pekinensis (пекинская капуста), Raphanus sativus (редис), Cichorium endivia L. (эндивий) и Brassica juncea (горчица сарептская), как показано на Рисунке 2b. Виды сорняков включали Artemisia argyi H. Lév. & Vaniot (полынь арги), Chenopodium album L. (марь белая), Amaranthus retroflexus (щирица запрокинутая), Oxalis corniculata L. (кислица рожковая) и Eleusine indica (L.) Gaertn. (елеусина индийская), как показано на Рисунке 2a. Изображения также охватывают разнообразные условия освещенности (такие как солнечно, облачно и после дождя), сложные среды и случаи occlusion листьев.

Рисунок 1. Местоположение участков отбора проб сорняков и овощей. Изображение получено с © Google Maps. Примечание: Термины не на английском языке на рисунке (например, «广州») являются китайскими названиями мест.

Рисунок 2. Сбор данных. Изображения, показывающие примеры образцов из набора данных, используемого для обучения модели.

2.1.2. Предварительная обработка изображений

Исходный набор данных состоял из 1300 изображений. Для имитации различных условий окружающей среды для роста овощей были использованы методы аугментации данных — включая регулировку яркости, вращение, изменение цвета и повышение резкости — в результате чего набор данных был расширен до 2750 изображений, как показано на Рисунке 3. После очистки данных для окончательного набора данных было сохранено 2666 изображений. Этот набор данных затем был разделен на 2155 изображений для обучающей выборки, 244 для валидационной выборки и 267 для тестовой выборки. Аннотирование изображений выполнялось вручную с использованием пользовательского программного обеспечения LabelImg (версия 1.8.6, инструмент с открытым исходным кодом, доступный на GitHub), с созданием ограничивающих рамок для 11 338 целей-овощей и 37 531 цели-сорняков.

Рисунок 3. Результат усиления изображения.

В полевых условиях размеры и пространственное распределение сорняков неравномерны, что создает проблему для обобщающей способности модели. Этот дисбаланс требует захвата как глобальной, так и локальной контекстной информации для улучшения способности модели точно обнаруживать как крупные, так и мелкие цели одновременно.

2.2. Модель обнаружения сорняков на основе улучшенного YOLOv8

Архитектура YOLOv8 состоит из трех основных компонентов: Backbone (основа), Neck (шейка) и Detection Head (головка детекции). Backbone отвечает за извлечение фундаментальных признаков из входного изображения. Neck затем интегрирует и улучшает эти многомасштабные признаки через Feature Pyramid Network (FPN), усиливая способность модели извлекать информацию при различных пространственных разрешениях.

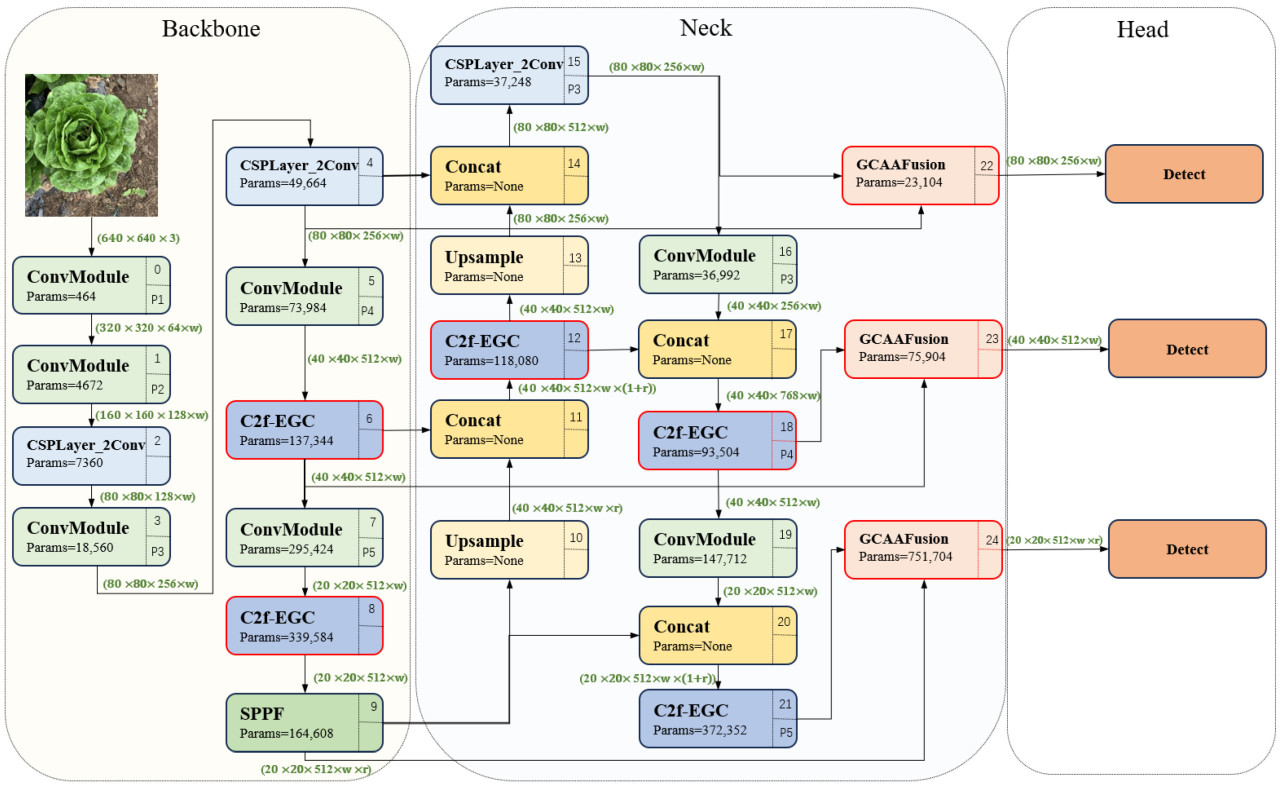

Учитывая ограниченные вычислительные ресурсы в сельскохозяйственных условиях, за основу данного исследования взята версия YOLOv8n (Nano), разработанная специально для легковесных приложений. В данной статье разрабатывается модель YOLOv8-EGC-Fusion (YEF) на основе фреймворка YOLOv8n. Архитектура модели проиллюстрирована на Рисунке 4. Ключевые модификации включают интеграцию Efficient Group Convolution (EGC) в Backbone, улучшая извлечение многомасштабных признаков и уменьшая количество параметров модели. Кроме того, разработан модуль GCAA-Fusion для улучшения захвата признаков низкого уровня путем оптимизации существующей структуры пирамиды признаков. Подробный дизайн и оптимизация производительности модели YEF further обсуждаются в этой статье.

Рисунок 4. Архитектура YOLOv8-EGC-Fusion.

2.2.1. Модуль C2f-EGC

(1) Efficient Group Convolution

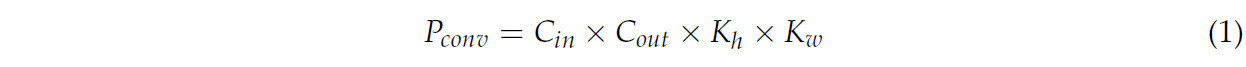

В исходной архитектуре YOLOv8 сверточный модуль, используемый на этапе извлечения признаков, применяет различные сверточные ядра для захвата полезных признаков из входных данных. Этот модуль в основном состоит из сверточных слоев, созданных с помощью conv2d, функций активации и слоев пакетной нормализации [25]. Вычислительная сложность сверточного модуля определяет скорость обработки данных, и количество параметров Pconv рассчитывается следующим образом:

где C_in представляет количество входных каналов. C_out представляет количество выходных каналов. K_h × K_w представляет высоту и ширину свёрточного ядра.

Каждый выходной канал в сверточном модуле выполняет сверточные операции по всем входным каналам. В сверточных модулях модели YOLOv8 размерности каналов составляют 128, 256, 512 и 1024, что означает, что как вычислительная стоимость, так и количество параметров растут с увеличением количества входных и выходных каналов. Это приводит к большему спросу на вычислительные ресурсы и увеличению времени обработки [26]. Кроме того, размер сверточного ядра в стандартных свертках фиксирован, что ограничивает устойчивость к неизвестным геометрическим преобразованиям, влияя таким образом на обобщающую способность модели [27].

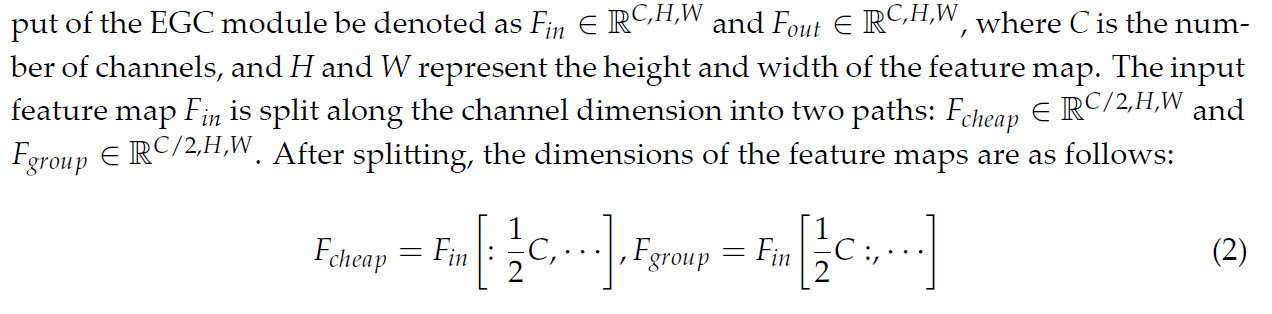

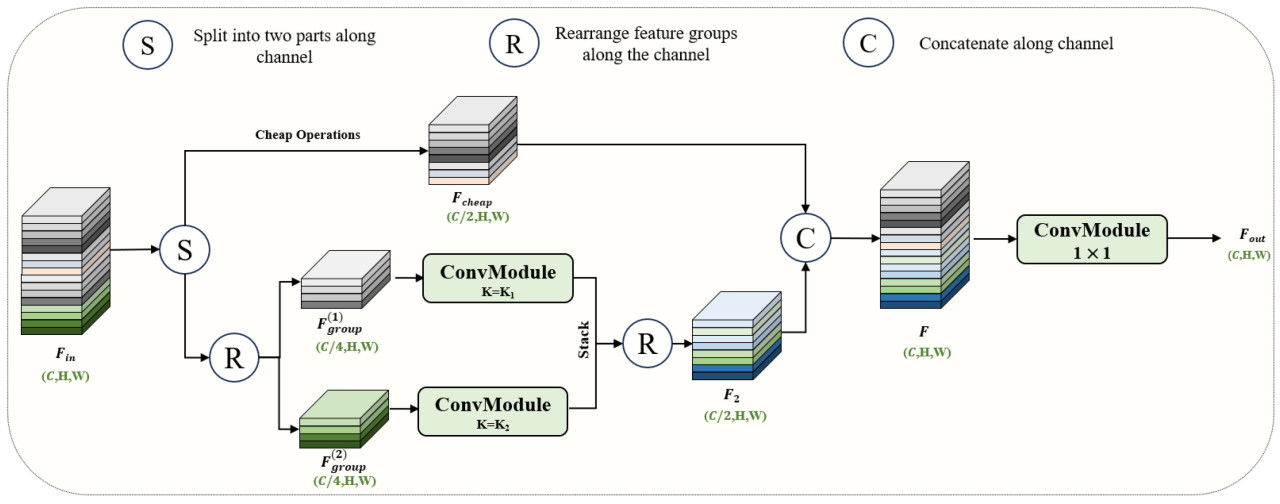

В данной статье предлагается модуль EGC для решения этой проблемы. Этот модуль использует групповые свертки с ядрами разного размера для уменьшения количества параметров, одновременно усиливая способность захватывать многомасштабные пространственные признаки и повышая обобщающую способность. Структура модуля показана на Рисунке 5. Обозначим вход и выход модуля EGC как `F_in ∈ ℝ^(C,H,W)` и `F_out ∈ ℝ^(C,H,W)`, где C — количество каналов, а H и W представляют высоту и ширину карты признаков. Входная карта признаков F_in разделяется по размерности канала на два пути: `F_cheap ∈ ℝ^(C/2,H,W)` и `F_group ∈ ℝ^(C/2,H,W)`. После разделения размерности карт признаков следующие:

где ":" используется для обозначения операций среза по измерениям.

Рисунок 5. Сетевая архитектура модуля EGC.

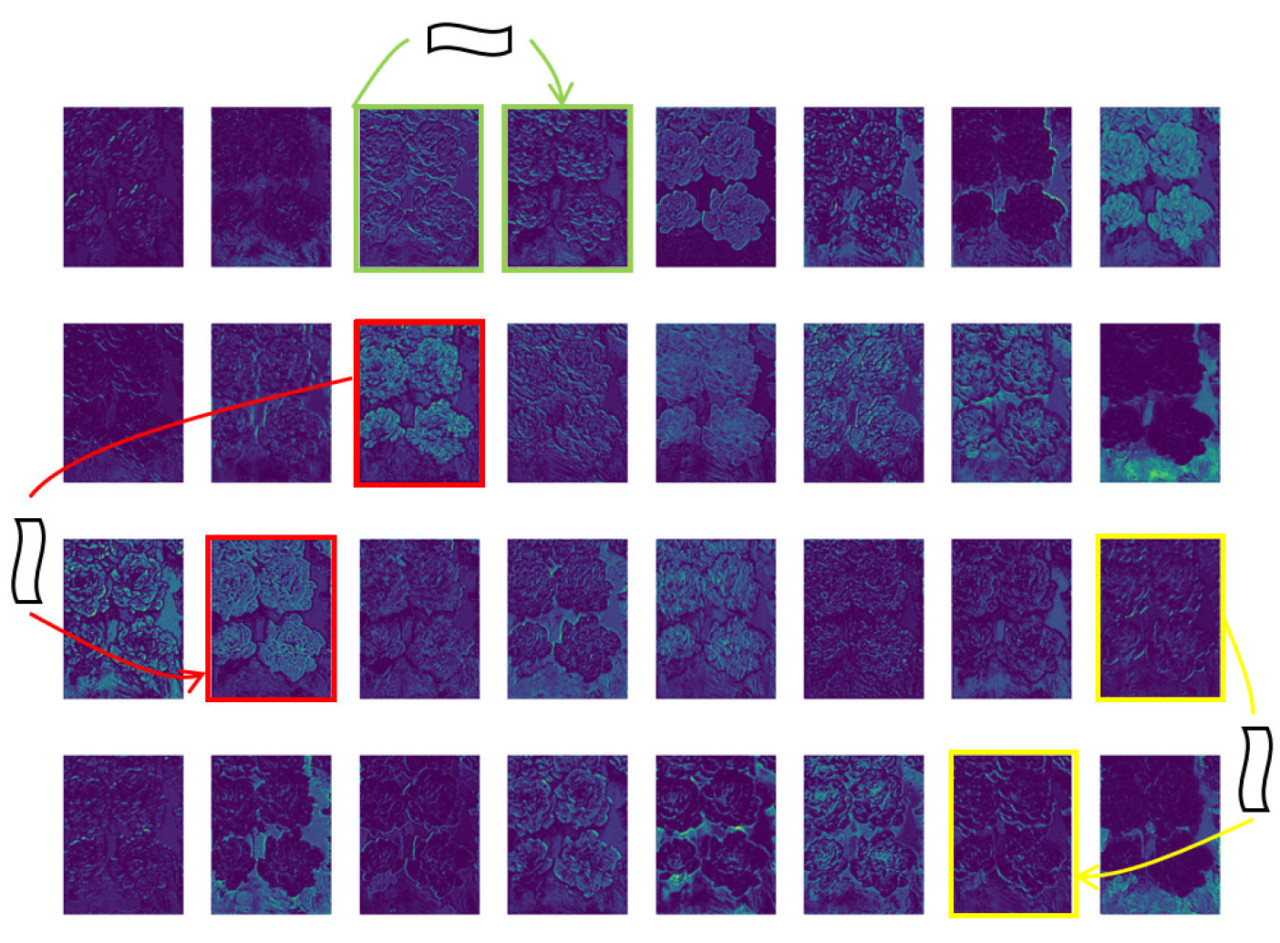

В EGC один путь (F_cheap) выполняет простую операцию для сохранения исходных признаков, уменьшая избыточность в отображении признаков, как показано на Рисунке 6. Другой путь (F_group) подвергается групповой свертке, где F_group разделяется на две группы: `F1_group, F2_group ∈ ℝ^(C/4,H,W)`. Они используются как вход для групповой свертки, которая после обработки и слияния признаков генерирует `F2 ∈ ℝ^(C/2,H,W)`. Наконец, применяется точечная свертка (pointwise convolution) для объединения каналов признаков с обоих путей, resulting in the fused output as:

Рисунок 6. Карты признаков, сгенерированные сетью Backbone YOLOv8.

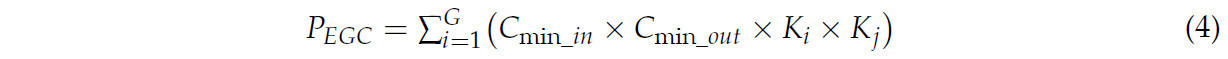

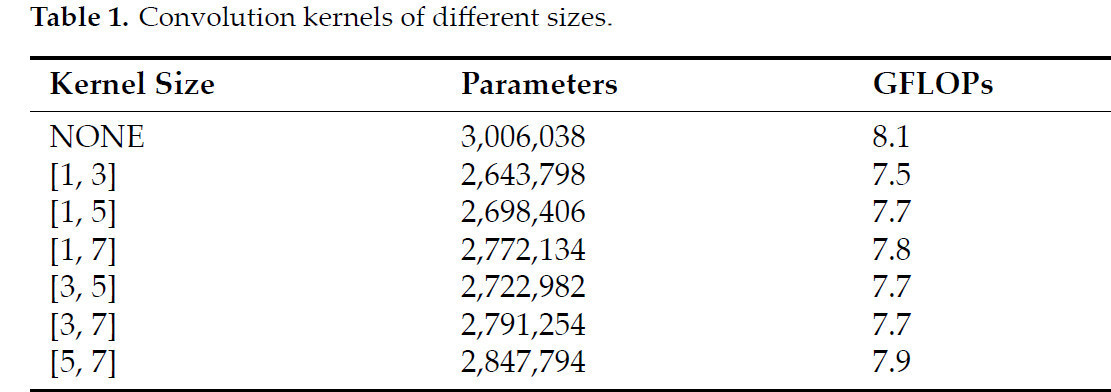

Применяя модуль EGC для сверточных операций, количество входных и выходных каналов уменьшается до одной четверти от исходного размера, что соответственно уменьшает количество параметров. Уравнение (4) иллюстрирует, как количество параметров может быть записано следующим образом:

где C_min_in, C_min_out представляют количество каналов после операции разделения. G обозначает количество групп. K_i и K_j ссылаются на ширину и высоту сверточных ядер групп соответственно.

На рецептивное поле для распознавания признаков изображения напрямую влияет размер сверточного ядра. Правильно выбранное сверточное ядро может улучшить как производительность модели, так и точность. Таблица 1 демонстрирует затраты параметров и вычислений для ядер разных размеров. Комбинируя ядра 1 × 1 и 3 × 3, можно сохранить производительность модели, одновременно повышая эффективность. Поэтому в данном исследовании принята комбинация ядер [1, 3] для оптимизации производительности модели.

Таблица 1. Сверточные ядра разных размеров.

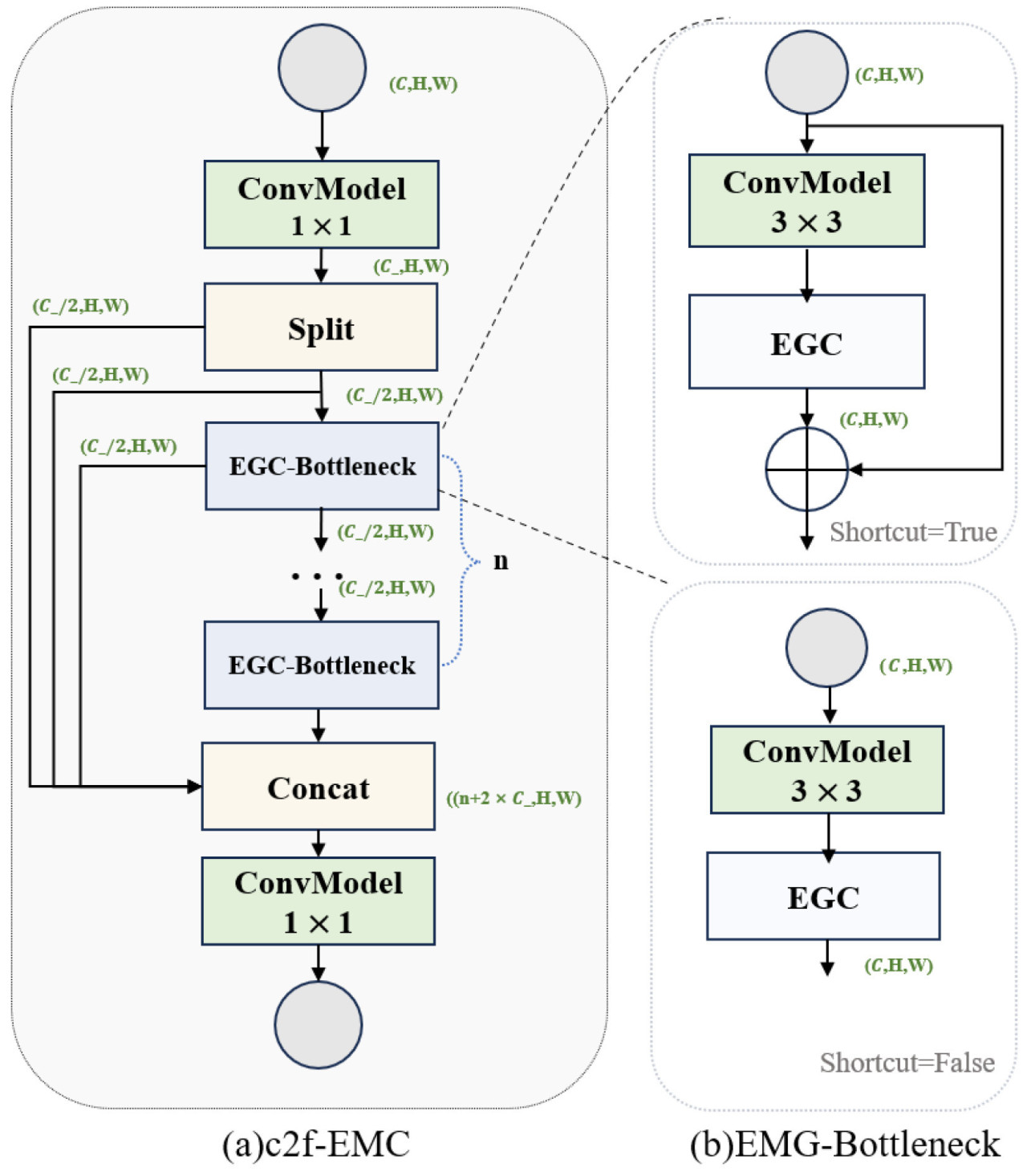

(2) Модуль C2f-EGC

В модели YOLOv8 модуль C2f primarily извлекает представления признаков более высокого уровня [28]. Его ядро comprises сверточные слои, функции активации и модули Bottleneck [29]. В данном исследовании второй стандартный сверточный модуль в Bottleneck заменен на модуль EGC, формируя модуль EGC-Bottleneck (как показано на Рисунке 7b) для содействия обмену многомасштабной информацией внутри модели и захвата локальной контекстной информации. Путем stacking нескольких модулей EGC-Bottleneck, создана новая сетевая структура, C2f-EGC (как показано на Рисунке 7a).

Рисунок 7. Структура модуля C2f-EGC, который заменяет EGC модуль на второй стандартный сверточный модуль в Bottleneck.

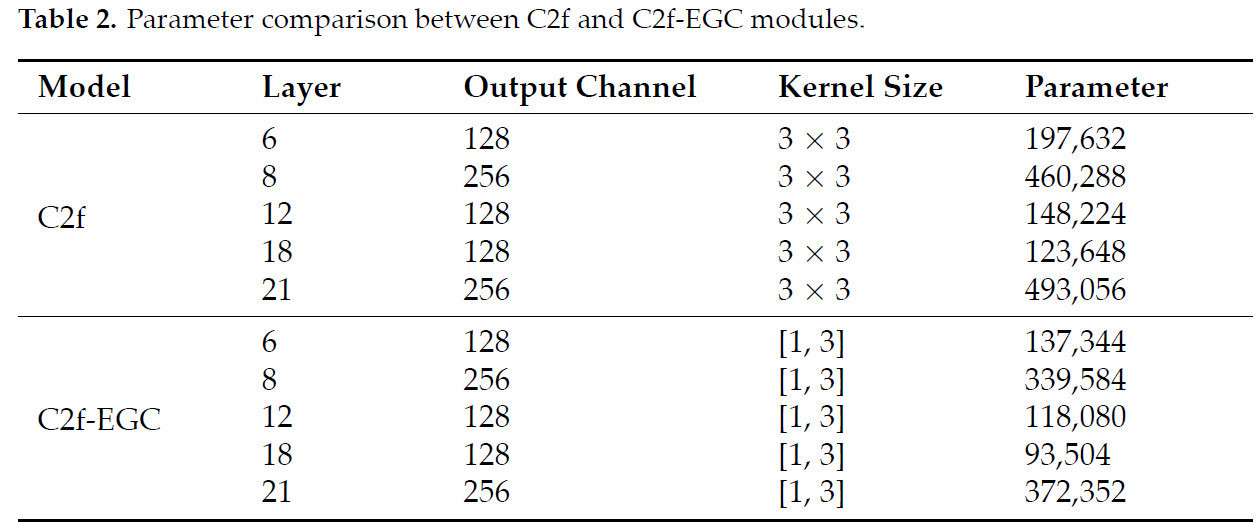

В сверточных слоях с большим количеством каналов (128 и выше) модель C2f-EGC заменяет исходный модуль C2f в данном исследовании. Для слоев с меньшим количеством каналов (менее 128) влияние групповой свертки минимально, поэтому исходный модуль C2f сохраняется. В Таблице 2 сравнивается количество параметров между модулями C2f и C2f-EGC для слоев с высоким количеством каналов. Результаты показывают, что модуль C2f-EGC уменьшает количество параметров более чем на 20%, не ставя под угрозу способность извлечения признаков.

Таблица 2. Сравнение параметров между модулями C2f и C2f-EGC.

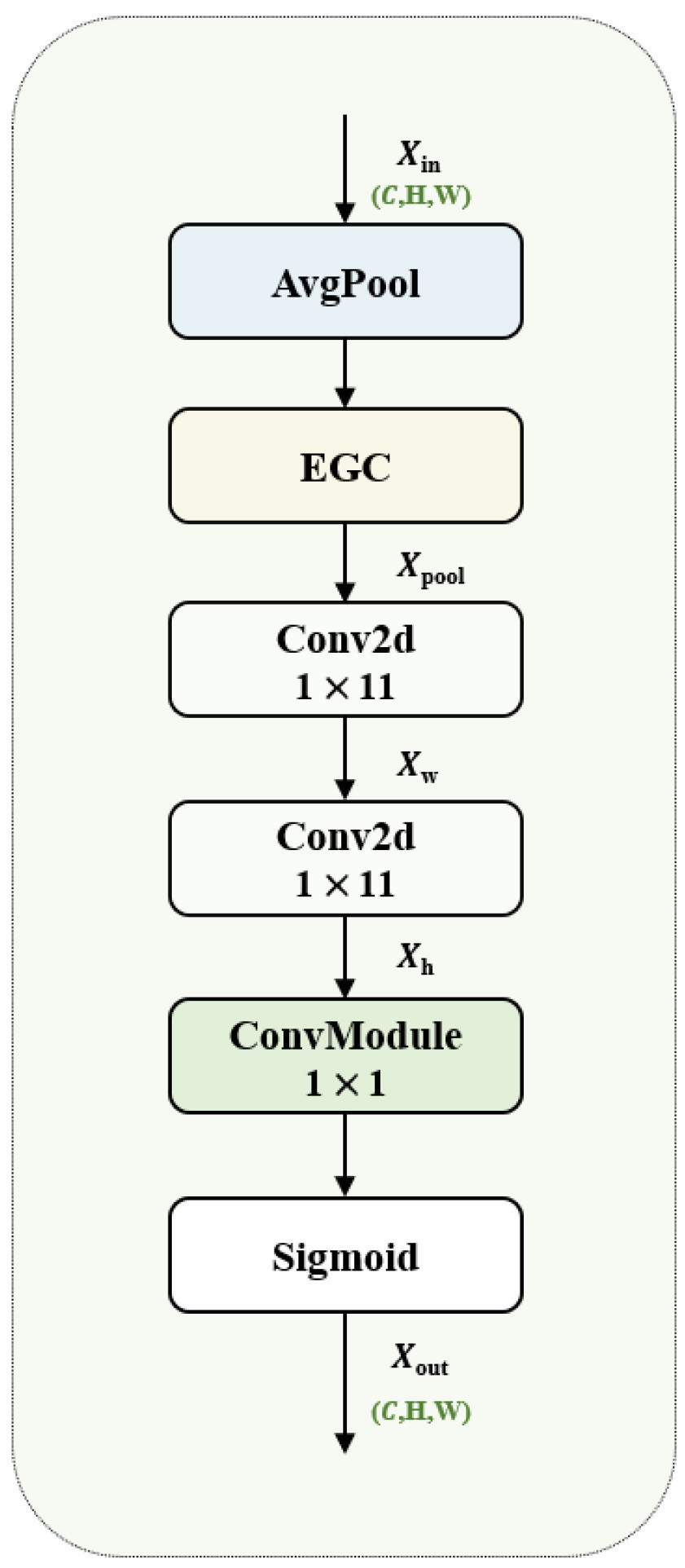

2.2.2. Group Context Anchor Attention

При детекции объектов локальная информация может быть подвержена влиянию локального размытия или шума, что приводит к снижению производительности модели. При распознавании овощей и сорняков овощи обычно высажены организованно, в то время как сорняки распределены случайным образом [30, 31]. В данной статье представлен механизм Group Context Anchor Attention (GCAA), состоящий primarily из слоев пулинга, модулей EGC, depth-wise separable сверток и функций активации. GCAA предназначен для улучшения пространственного представления признаков как сорняков, так и овощей путем увеличения способности модели захватывать глобальную контекстную информацию.

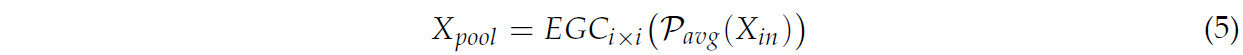

На Рисунке 8 иллюстрируется структура модели GCAA. Сначала применяется операция усредняющего пулинга (average pooling) к локальным областям, что усредняет локальные признаки, извлекает глобальные признаки и уменьшает размерность карты признаков. Затем признаки локальной области получаются с использованием процедуры EGC свертки. Формула операции следующая:

где EGC_i×i представляет операцию свертки модуля EGC с `i ∈ [1,3]`, указывая на размер сверточного ядра [1, 3]. `P_avg` представляет операцию усредняющего пулинга. `X_in` представляет входное значение.

Рисунок 8. Структура GCAA.

Затем применяется разделяемая по глубине свертка для захвата глобальных зависимостей как в горизонтальном, так и в вертикальном направлениях. Используются большие сверточные ядра размером 1 × 11 и 11 × 1 для выполнения сверток вдоль вертикальной и горизонтальной осей. Операция формулируется как:

где X_w и X_h представляют выходные значения после сверток 1 × 11 и 11 × 1. Conv представляет стандартную сверточную операцию.

Наконец, используется точечная свертка (pointwise convolution) для интеграции и сжатия признаков, извлеченных из separable свертки (X_h), по размерности канала. Применяется функция активации sigmoid для выполнения нелинейного преобразования, генерируя выходной признак X_out, как показано в Уравнении (8). Для последующего слияния признаков важно убедиться, что значения выходных признаков находятся между 0 и 1.

где `σ` обозначает функцию sigmoid.

2.2.3. Модель слияния на уровне признаков на основе GCAA

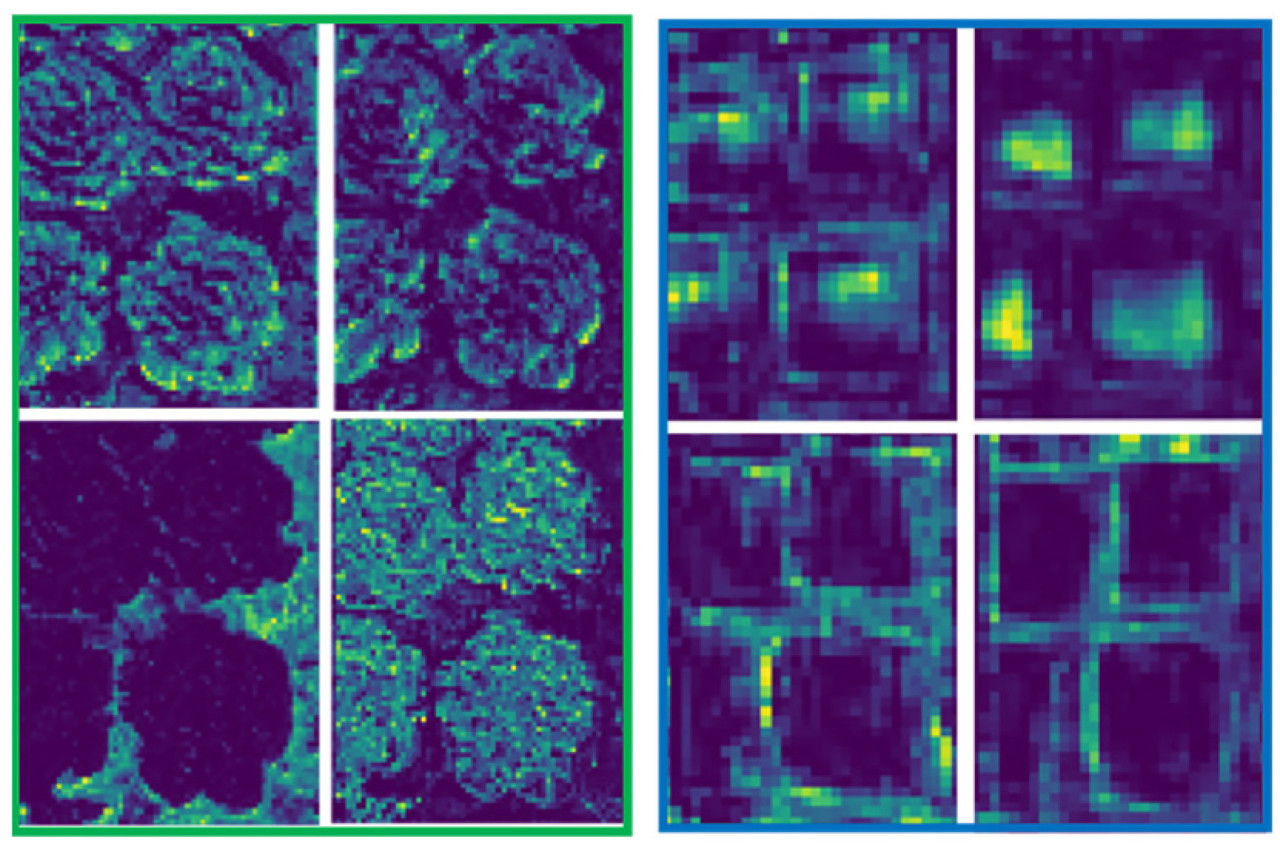

Неглубокие (мелкоуровневые) карты признаков содержат богатую низкоуровневую информацию, такую как границы и текстуры, которые могут эффективно различать тонкие различия между овощами и сорняками. Однако в процессе детекции объектов последовательные операции свертки и пулинга уменьшают разрешение глубоких карт признаков, приводя к потере мелкоуровневой информации. Глубокие сети primarily извлекают абстрактные признаки, такие как категории объектов, негативно влияя на распознавание мелких объектов и целей с похожими формами, как проиллюстрировано на Рисунке 9 [32, 33].

Рисунок 9. Показаны карты признаков из 4-го и 18-го слоев YOLOv8. Зеленая рамка представляет 4-й слой, а синяя рамка представляет 18-й слой, причем оба имеют одинаковое количество выходных каналов.

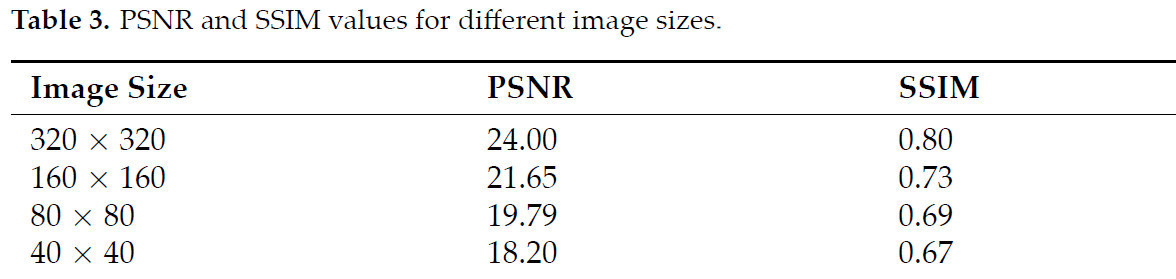

Мы оценили отношение пикового сигнала к шуму (PSNR) и индекс структурного сходства (SSIM) для изображений различного разрешения, как указано в Уравнениях (9) и (10), с целью лучшего изучения того, как разрешение изображения влияет на извлечение признаков и точность детекции объектов [34].

где MAX — максимальное значение пикселя изображения, а MSE — среднеквадратическая ошибка между двумя изображениями. Более высокое значение PSNR указывает на лучшее качество изображения.

где `μ_x` и `μ_y` — средние значения изображений x и y, `μ_x^2` и `μ_y^2` — их дисперсии, `σ_xy` — ковариация, `C_1` и `C_2` — константы для стабилизации деления. Более высокие баллы по шкале SSIM, которая варьируется от 0 до 1, указывают на большее сходство.

Результаты суммированы в Таблице 3. По мере уменьшения разрешения изображения значения PSNR и SSIM снижаются, указывая на потерю информации и структурного сходства. Изображения с более низким разрешением теряют более тонкие детали, что потенциально ухудшает способность глубоких сетей различать объекты.

Таблица 3. Значения PSNR и SSIM для разных размеров изображений.

Усиление признаков является ключом к решению проблемы исчезновения признаков. В предыдущих алгоритмах детекции объектов механизмы внимания часто используются для выделения ключевых признаков, что эффективно, но все же сталкивается с проблемой балансировки и сохранения низкоуровневых деталей и захвата высокоуровневой контекстной информации.

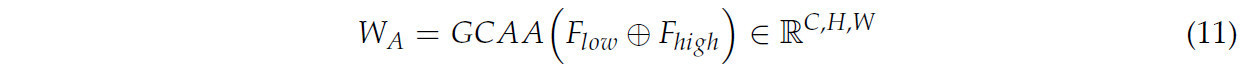

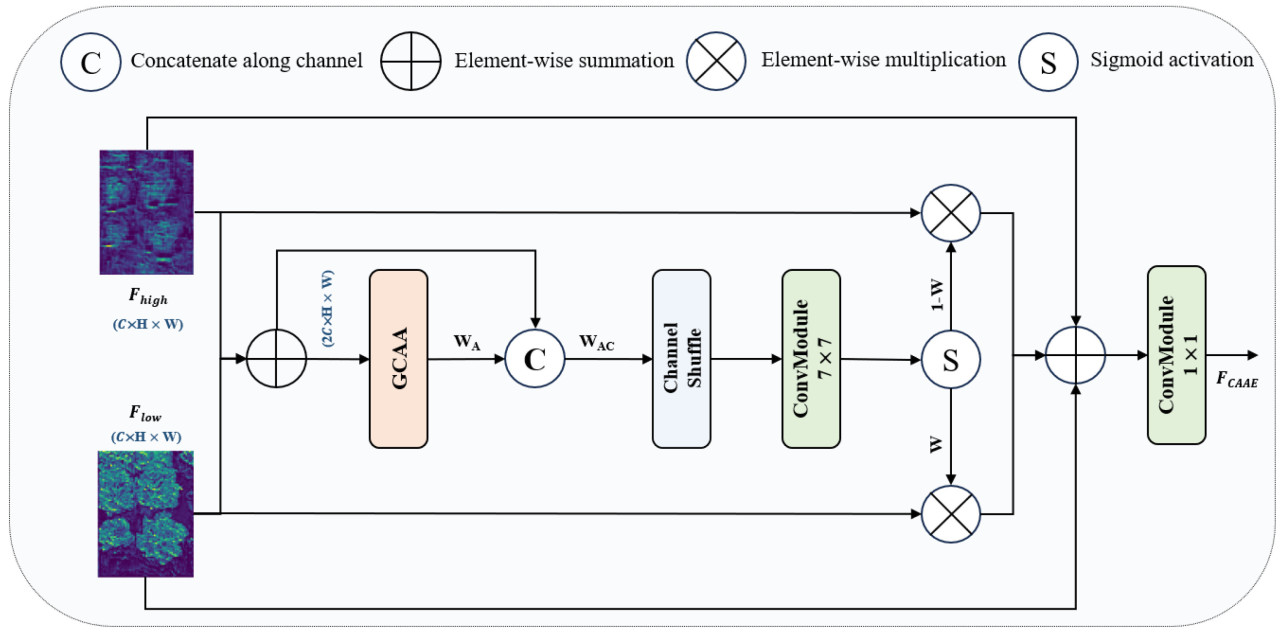

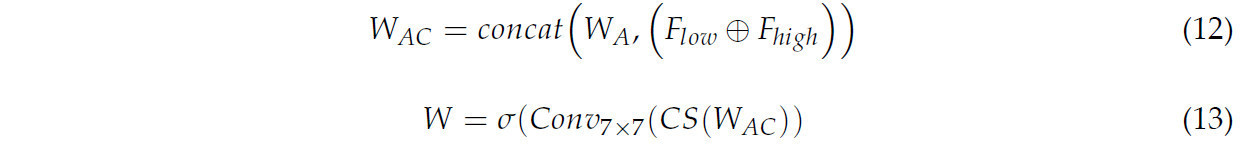

Для решения этой проблемы в данной статье представлен модуль слияния признаков на основе GCAA (GCAA-Fusion). Модуль адаптивно объединяет мелкоуровневые и глубокие карты признаков, усиливая как сохранение признаков, так и обратное распространение градиента. Как показано на Рисунке 10, карта признаков низкого уровня `F_low ∈ ℝ^(C,H,W)` объединяется с картой признаков высокого уровня `F_high ∈ ℝ^(C,H,W)` путем простого сложения. Объединенные признаки затем пропускаются через модуль внимания GCAA для генерации начальной карты внимания `W_A ∈ ℝ^(C,H,W)`, интегрируя глобальную контекстную информацию с детализированными признаками, как выражено в Уравнении (11).

где ⊕ представляет поэлементное суммирование.

Рисунок 10. Структурная схема модуля GCAA-Fusion.

Чтобы получить более точную карту значимых (saliency) признаков, начальная карта признаков внимания `W_A` сначала объединяется (concatenated) с исходной картой признаков после операции сложения, чтобы сформировать `W_AC ∈ ℝ^(C,H,W)`. Затем применяются операции channel shuffle для перестановки каналов `W_AC` alternately. Наконец, применяется операция свертки 7 × 7 с последующей функцией активации для получения весов признаков `W`. Процесс вычисления показан в Уравнениях (12) и (13).

где CS(·) относится к операции channel shuffle. `Conv_7×7` изображает операцию свертки с использованием размера ядра 7 × 7.

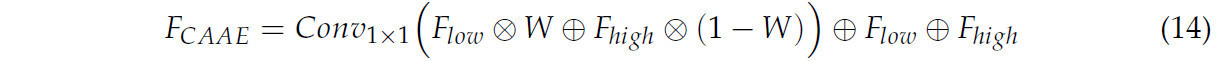

Точные карты признаков, сгенерированные посредством взвешенного суммирования, затем интегрируются, с введением skip connections для усиления входных признаков. Это помогает смягчить проблему исчезающего градиента и упрощает процесс обучения. Учитывая, что мелкоуровневые и глубокие признаки дополняют друг друга, сгенерированный вес W применяется к одному модулю, в то время как вес слияния для другого модуля представлен как 1 − W [33]. На основе этого, объединенные признаки отображаются с использованием сверточного слоя 1 × 1 для получения окончательного выхода признаков, как указано в Уравнении (14).

где ⊗ представляет поэлементное умножение.

2.2.4. Адаптивное слияние признаков (AFF)

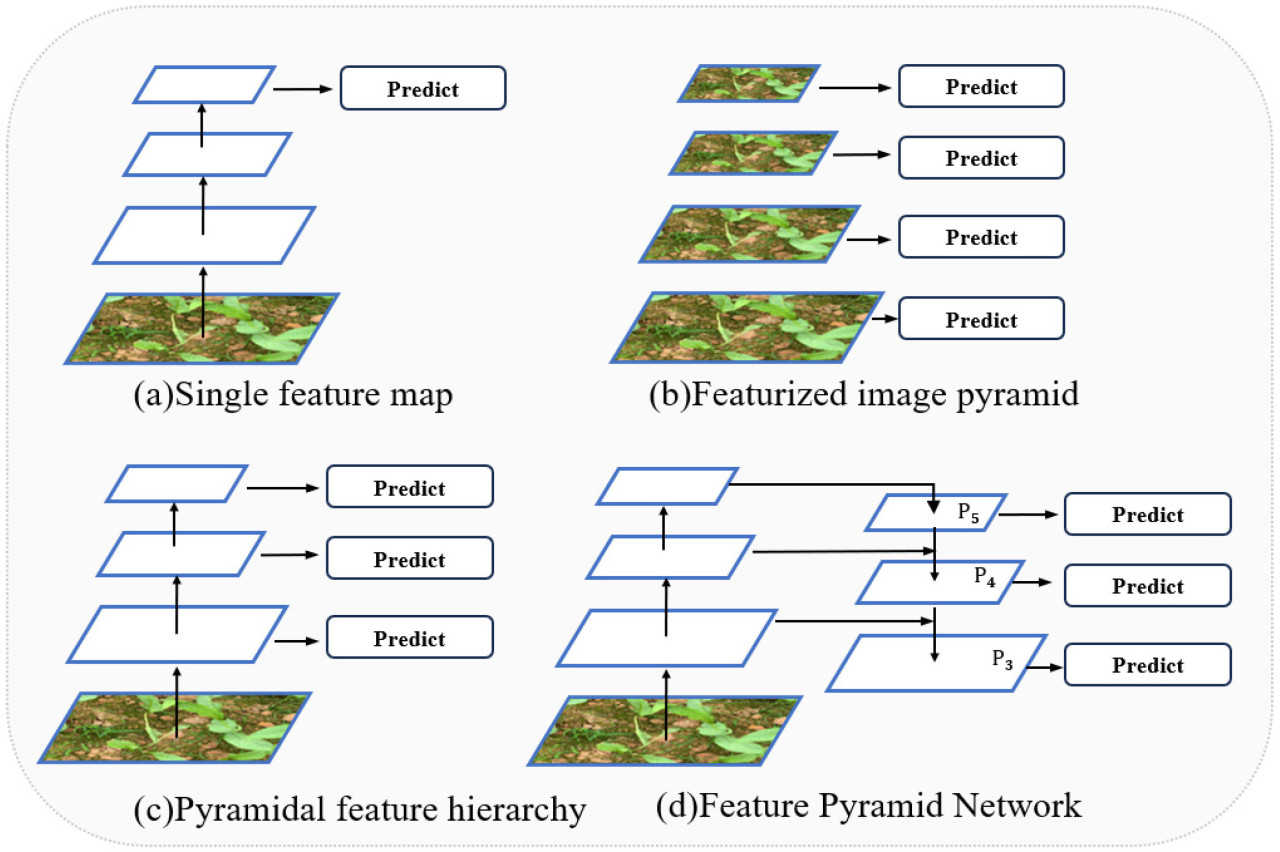

Feature Pyramid (Пирамида признаков) играет crucial роль в детекции объектов для захвата многомасштабных признаков. На Рисунке 11 outlined различные структуры пирамид. На Рисунке 11a для предсказания используется одна карта признаков, что ограничивает возможность использования многомасштабной информации. На Рисунке 11b представлен подход image pyramid, где карты признаков генерируются для каждого масштаба, но это влечет высокие вычислительные затраты [35]. На Рисунке 11c улучшена производительность детекции за счет использования многослойного извлечения признаков [36], хотя может не хватать точности в захвате мелких деталей. На Рисунке 11d focuses на решении проблемы многомасштабности в детекции объектов при одновременном снижении вычислительной сложности, хотя эффективность все еще может быть оптимизирована [37]. Улучшение методов извлечения признаков может существенно повысить точность обнаружения сети. YOLOv8 использует Path Aggregation Feature Pyramid Network (PAFPN) для облегчения слияния информации across различных слоев, но более глубокие сетевые слои могут приводить к потере признаков.

Рисунок 11. Различные структуры пирамиды признаков. P3, P4 и P5 представляют уровни признаков, генерируемые FPN.

В данной статье представлена структура AFF, построенная на архитектуре PaFPN, чтобы решить эту проблему. Как показано на Рисунке 4 и Рисунке 12, Оранжевые пунктирные линии соответствуют 9-му, 6-му и 4-му слоям, а выходные слои N5, N4 и N3 соответствуют 15-му, 18-му и 21-му слоям соответственно. Три модуля GCAA-Fusion incorporated перед каждой Detection Head, их входы берутся из 4-го и 15-го слоев, 6-го и 18-го слоев и 9-го и 21-го слоев. Структура AFF адаптивно объединяет признаки низкого и высокого уровня along размерности канала, увеличивая способность модели сохранять признаки и повышая точность и эффективность детекции объектов. Это приводит к большей устойчивости и адаптируемости для различных задач.

Рисунок 12. Структура модуля AFF. P3, P4 и P5 представляют уровни признаков, генерируемые FPN, в то время как N3, N4 и N5 указывают соответствующие вновь сгенерированные карты признаков.

2.3. Экспериментальная платформа и конфигурация параметров

Экспериментальная платформа работает под управлением Windows 10, оснащена GPU NVIDIA Quadro RTX 5000 (NVIDIA, Санта-Клара, Калифорния, США), CPU Intel(R) Xeon(R) Gold 6248R @ 3.00 ГГц (Intel, Санта-Клара, Калифорния, США) и 64.0 ГБ ОЗУ (Kingston, Фаунтин-Вэлли, Калифорния, США). В качестве фреймворка глубокого обучения используется PyTorch, с CUDA 11.6 в качестве платформы параллельных вычислений и модели программирования. В качестве языка программирования используется Python 3.9.

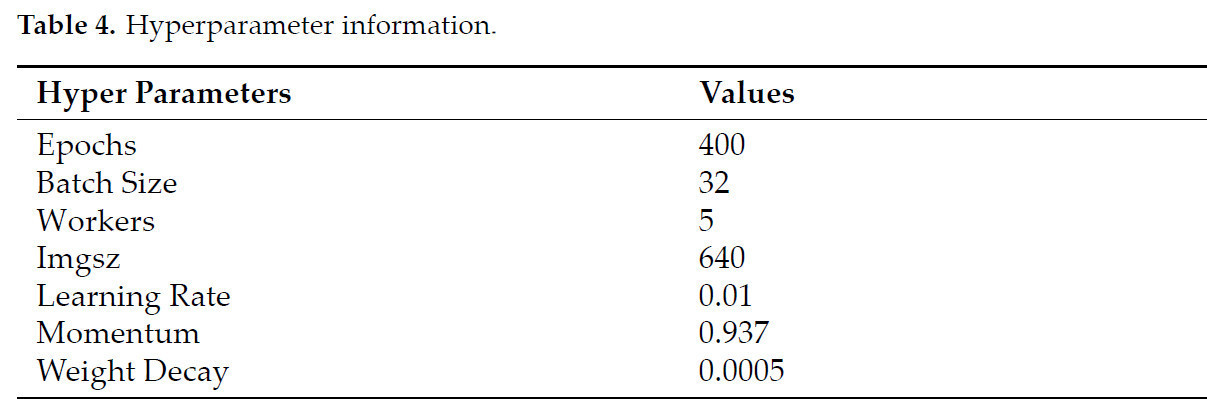

Большинство параметров эксперимента сохраняют настройки по умолчанию YOLOv8. Размер пакета (batch size) равен 32, количество работников (workers) равно 5, а размер входного изображения фиксирован на 640 × 640 пикселей. Затухание веса (weight decay) составляет 0.0005, момент (momentum) равен 0.937, а скорость обучения (learning rate) равна 0.01. В Таблице 4 представлена подробная информация о настройках гиперпараметров.

Таблица 4. Информация о гиперпараметрах.

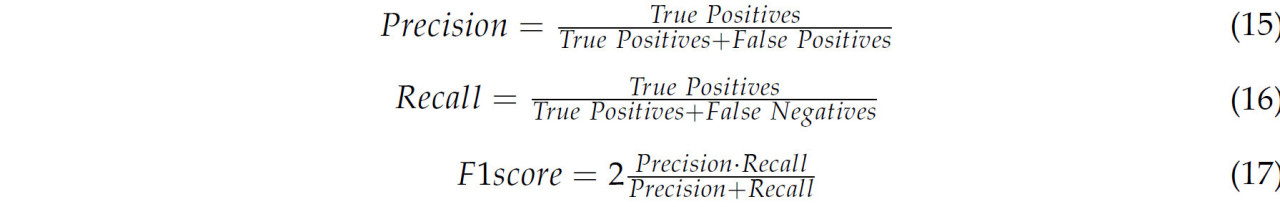

2.4. Метрики

Оценка производительности сети primarily основывается на mAP (Mean Average Precision) в процессе обучения и производительности модели на валидационной выборке после обучения. Для оценки производительности модели в данной статье используются пять ключевых метрик: точность (precision), полнота (recall), mAP, F1-score и параметры. Соответствующие расчетные формулы приведены ниже:

где True Positives (Истинно Положительные) представляют количество фактических образцов сорняков, точно классифицированных моделью как сорняки. False Positives (Ложноположительные) представляют количество фактических не-сорняковых образцов, ошибочно идентифицированных моделью как сорняки. False Negatives (Ложноотрицательные) представляют количество фактических образцов сорняков, неправильно идентифицированных моделью как не-сорняки.

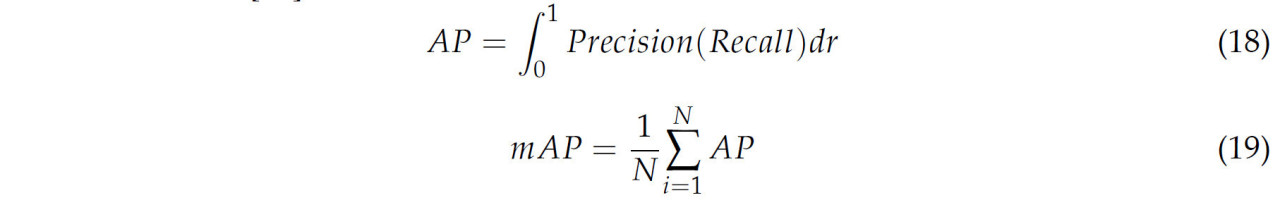

mAP — это важнейший показатель оценки производительности, который вычисляет среднее значение средней точности (AP) по всем категориям, как показано в уравнениях. mAP0.5 обозначает значение mAP, когда Intersection over Union (IoU) установлен на 0.5. mAP0.5–0.95 относится к mAP, оцененному при различных пороговых значенияхIoUв диапазоне от 0,5 до 0,95 с шагом 0,05 [38].

где N представляет категории классификации в данной статье.

3. Результаты и обсуждение

3.1. Эксперименты по производительности

В данном исследовании проводятся эксперименты с различным количеством модулей GCAA-Fusion для оценки влияния архитектуры сети AFF на производительность модели YOLOv8n при сохранении других параметров фиксированными. Fusion-1 представляет модель YOLOv8n, усиленную одним модулем GCAA-Fusion, в то время как Fusion-2 включает два модуля GCAA-Fusion. Результаты в Таблице 5 указывают, что добавление модулей GCAA-Fusion приводит к измеримым улучшениям по всем метрикам детекции по сравнению с базовой моделью YOLOv8n. Примечательно, что с добавлением трех модулей GCAA-Fusion (YEF) модель достигает оптимальных результатов по всем оценочным метрикам, подчеркивая значительное улучшение производительности, обеспечиваемое архитектурой сети AFF.

Таблица 5. Результаты для YOLOv8 с различным количеством модулей GCAA-Fusion.

Это исследование заменяет механизм внимания GCAA внутри модуля GCAA-Fusion альтернативными механизмами внимания — MLCA [38], CBAM [39], SE [40] и EMA [41] — чтобы сформировать новые модули слияния признаков и further оценить влияние слияния признаков на модель.

Результаты, представленные в Таблице 6, демонстрируют, что все модули слияния признаков улучшают метрики детекции по сравнению с базовой моделью YOLOv8n, подтверждая осуществимость и устойчивость предложенной структуры слияния признаков. F1-score показывает наиболее значительное улучшение среди всех метрик, указывая, что слияние признаков лучше балансирует точность и полноту.

Таблица 6. Метрики производительности модели с различными модулями слияния признаков.

Более того, модуль слияния на основе GCAA consistently превосходит другие механизмы внимания, достигая наивысших показателей mAP. Это подчеркивает силу механизма GCAA в оптимизации представления признаков путем объединения признаков высокого и низкого уровня. Кроме того, разные механизмы внимания демонстрируют уникальные преимущества для конкретных метрик; например, SE преуспевает в улучшении полноты, в то время как CBAM достигает конкурентоспособной производительности по большинству метрик. Эти механизмы внимания привносят уникальные характеристики, подходящие для разных задач, обеспечивая гибкость в выборе модулей слияния на основе конкретных целей распознавания.

На Рисунке 13 иллюстрируются значения mAP0.5 за эпохи обучения для моделей с различными модулями слияния. На ранних стадиях обучения значения mAP across модулей слияния схожи; однако на более поздних стадиях все модели, усиленные слиянием, превосходят базовую, причем модуль GCAA-Fusion дает наивысшее значение mAP0.5, подчеркивая его превосходную производительность детекции относительно других методов слияния.

Рисунок 13. Значения mAP across эпох обучения для моделей с различными модулями слияния признаков. «None» указывает на модель YOLOv8 без каких-либо модулей слияния признаков.

3.2. Сравнительные эксперименты с исходной моделью

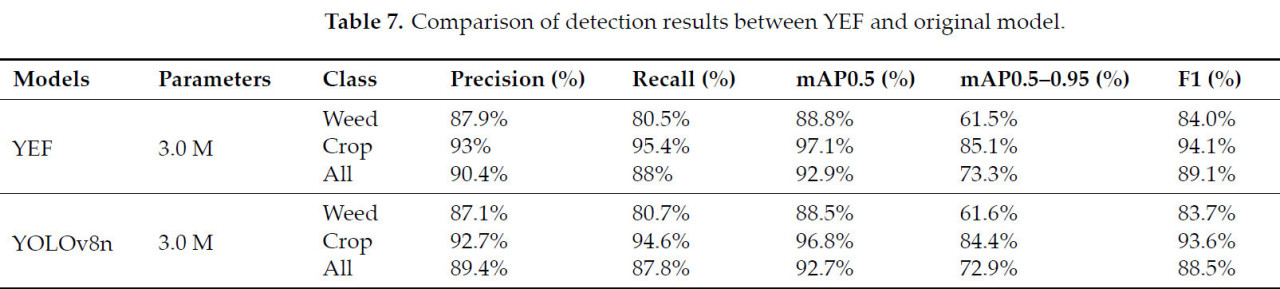

В данном исследовании представлены улучшения методов извлечения и слияния признаков модели YOLOv8. Были созданы различные сравнительные эксперименты для оценки эффективности этих изменений. Во-первых, используя тот же набор данных, производительность детекции модели YEF была сравнена с производительностью исходной модели YOLOv8n; результаты отображены в Таблице 7. Как указано, модель YEF превосходит YOLOv8n по всем метрикам во всех категориях без увеличения количества параметров. Примечательно, что точность достигает 90.4%, что представляет собой улучшение на 1% по сравнению с исходной моделью. Другие метрики также показывают varying степени улучшения, демонстрируя, что модификации effectively усиливают производительность детекции.

Таблица 7. Сравнение результатов детекции между YEF и исходной моделью.

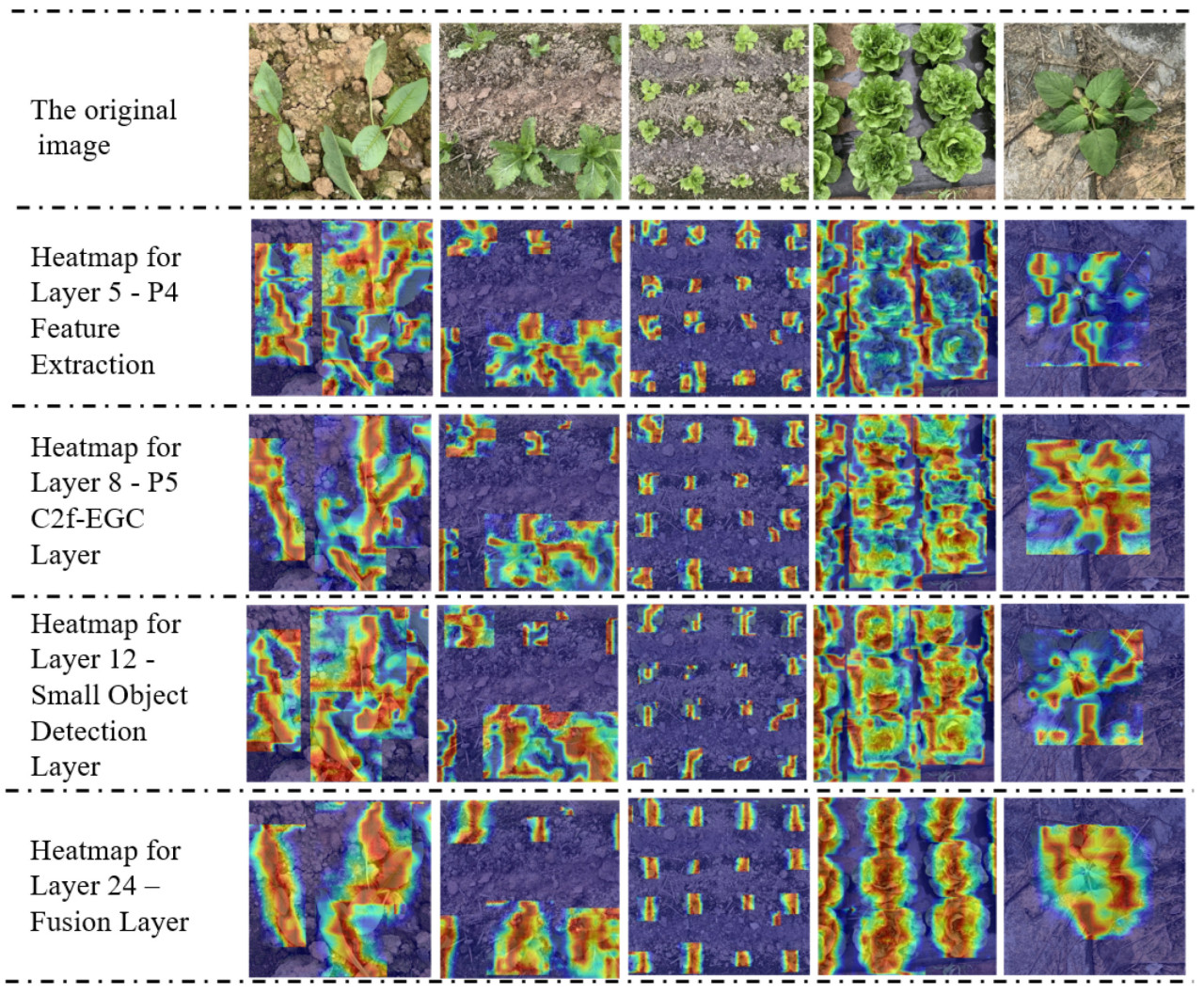

Grad-CAM — это методика, которая визуализирует распределение интенсивности признаков через изменения цвета, где более яркие цвета указывают на большее внимание [42]. Grad-CAM используется в этой работе для иллюстрации результатов детекции модели YEF. Как проиллюстрировано на Рисунке 14, неглубокий сетевой слой (слой 5) подчеркивает детальную информацию, такую как границы, текстуры и контуры объектов. С добавлением модуля C2f-EGC в сеть Backbone, семантическое понимание модели растений значительно улучшается. 12-й слой (слой детекции мелких объектов) effectively захватывает тонкие признаки мелких объектов, в то время как самый критический 24-й слой (слой слияния), усиленный модулем GCAA-Fusion, further улучшает способность интеграции многомасштабных признаков.

Рисунок 14. Результаты детекции модели и анализ тепловой карты (heatmap).

Эти визуализации подтверждают, что улучшения в модели YEF усиливают представление признаков. Путем effective захвата как высокоуровневых семантических признаков, так и низкоуровневых деталей, модель способна лучше представлять объекты, приводя к более точной детекции и локализации. Эта способность использовать оба типа признаков, особенно в сложных условиях, приводит к более точной и устойчивой производительности.

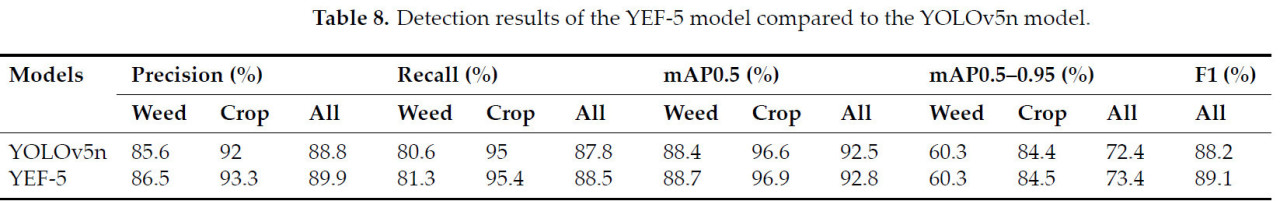

Чтобы дальше продемонстрировать обобщаемость предложенных модулей EGC и GCAA-Fusion, модуль EGC был встроен в модуль C3 модели YOLOv5, формируя модуль C3-EGC. Кроме того, модуль GCAA-Fusion был интегрирован для улучшенного слияния признаков, resulting in новой архитектуре модели под названием YEF-5. Были проведены сравнительные эксперименты для оценки производительности детекции YEF-5 по сравнению с базовой YOLOv5n.

Согласно Таблице 8, результаты показывают, что YEF-5 стабильно превосходит YOLOv5n по всем оценочным метрикам. На Рисунке 15 иллюстрируется эволюция mAP0.5 за эпохи обучения. Хотя YEF-5 изначально показывает немного более низкий mAP, чем YOLOv5n, она по мере обучения в конечном итоге превосходит базовый уровень. Эта тенденция свидетельствует, что YEF-5 требует более длительного периода адаптации на начальном этапе обучения, но в конечном итоге преуспевает в захвате критических особенностей данных, приводя к превосходной производительности на более поздних стадиях.

Рисунок 15. Кривые изменения метрик детекции с эпохами обучения.

Таблица 8. Результаты детекции модели YEF-5 по сравнению с моделью YOLOv5n.

Эти результаты подчеркивают положительное влияние введенных модулей на производительность модели, демонстрируя их адаптируемость к различным архитектурам и подтверждая их эффективность как в фреймворках YOLOv8n, так и YOLOv5n. Эти результаты подразумевают, что предложенные методы улучшения и модули могут быть обобщены для широкого спектра моделей детекции объектов, потенциально принося пользу сельскохозяйственным приложениям.

3.3. Сравнительные эксперименты с другими моделями

Преимущества модели YEF в задачах распознавания сорняков на овощных культурах были оценены в данном исследовании путем проведения сравнительных экспериментов на том же наборе данных с несколькими известными алгоритмами детекции объектов. Сначала она была сравнена с классической двухстадийной моделью Faster R-CNN, затем с классической одностадийной моделью RetinaNet. Далее были проведены сравнения с end-to-end моделью DINO, легковесными моделями RTMDet-Tiny и YOLOv10n, и, наконец, с моделью TOOD-R50 [43,44,45,46].

Согласно данным в Таблице 9 и результатам сравнительного эксперимента, модель YEF превосходит другие модели по нескольким ключевым метрикам. Среди протестированных моделей модель YEF достигает наивысшей точности (90.4%), mAP0.5 (92.9%) и mAP0.5–0.95 (73.3%). Примечательно, что TOOD-R50 и DINO демонстрируют впечатляющие результаты детекции со значениями mAP0.5 83.3% и 89% соответственно, но их количество параметров значительно выше — 321 М и 47 М соответственно — по сравнению с легковесными 3 М модели YEF. Аналогично, YOLOv10, компактная модель с 2.76 М параметрами, достигает высокой точности (89%) и mAP0.5 (91%), но все же уступает модели YEF по всем метрикам.

Таблица 9. Результаты детекции модели YEF по сравнению с другими моделями.

Эти результаты подчеркивают способность модели YEF к точному и эффективному обнаружению, что делает ее особенно подходящей для сельскохозяйственных приложений. Будущая работа может быть сосредоточена на оптимизации модели для лучшей эффективности развертывания в средах с ограниченными ресурсами.

3.4. Качественные результаты

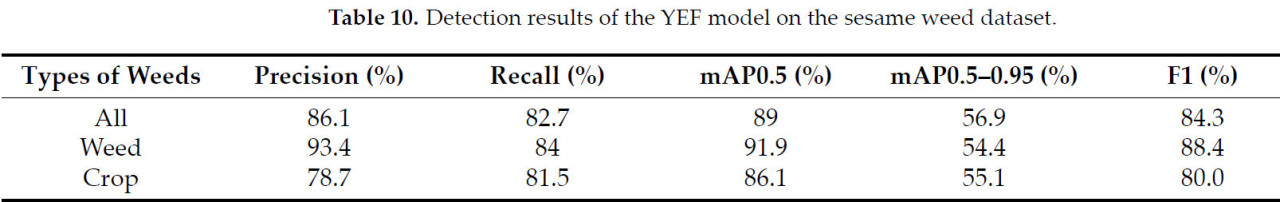

В данном исследовании использовались общедоступные наборы данных по сорнякам для оценки производительности детекции модели YEF, чтобы проверить надежность и обобщаемость предложенной модели. Первый использованный набор данных — это общедоступный набор данных по сорнякам в посевах кунжута [47], который включает 1300 изображений культур кунжута и различных типов сорняков, с размером каждого изображения 512 × 512 пикселей. В Таблице 10 представлены результаты детекции модели YEF, показывающие общую точность 86.1%, полноту 82.7%, mAP при IoU 0.5 89% и mAP при IoU 0.5–0.95 56.9%. В частности, для различных типов сорняков модель достигла точности 93.4% и полноты 84%.

Таблица 10. Результаты детекции модели YEF на наборе данных по сорнякам кунжута.

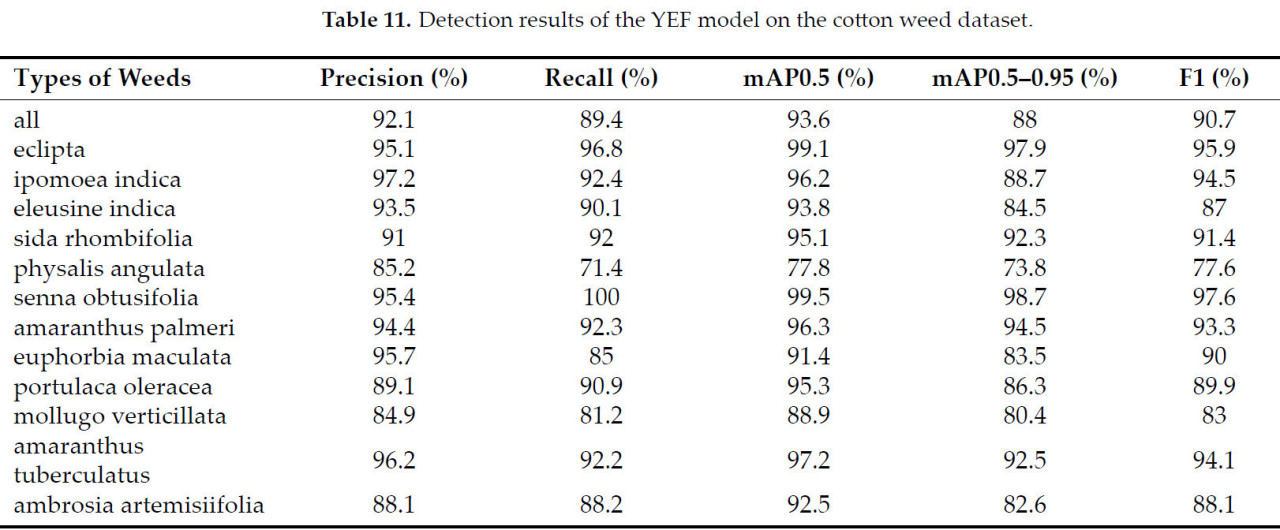

Второй использованный набор данных — это крупнейший в настоящее время общедоступный набор данных для обнаружения сорняков в системах производства хлопка [48]. Этот набор данных включает 12 распространенных типов сорняков, встречающихся в полях хлопка, состоящий из 5648 изображений и 9370 ограничивающих рамок. В Таблице 11 представлены результаты детекции модели YEF для различных типов сорняков, демонстрирующие превосходные возможности идентификации для большинства категорий. Например, точность для Eclipta достигла 95.1%, с полнотой 96.8%. Результаты из обоих наборов данных указывают, что модель YEF демонстрирует сильную производительность детекции при обработке различных типов наборов данных по сорнякам, тем самым доказывая свою эффективность и надежность для практических приложений.

Таблица 11. Результаты детекции модели YEF на наборе данных по сорнякам хлопка.

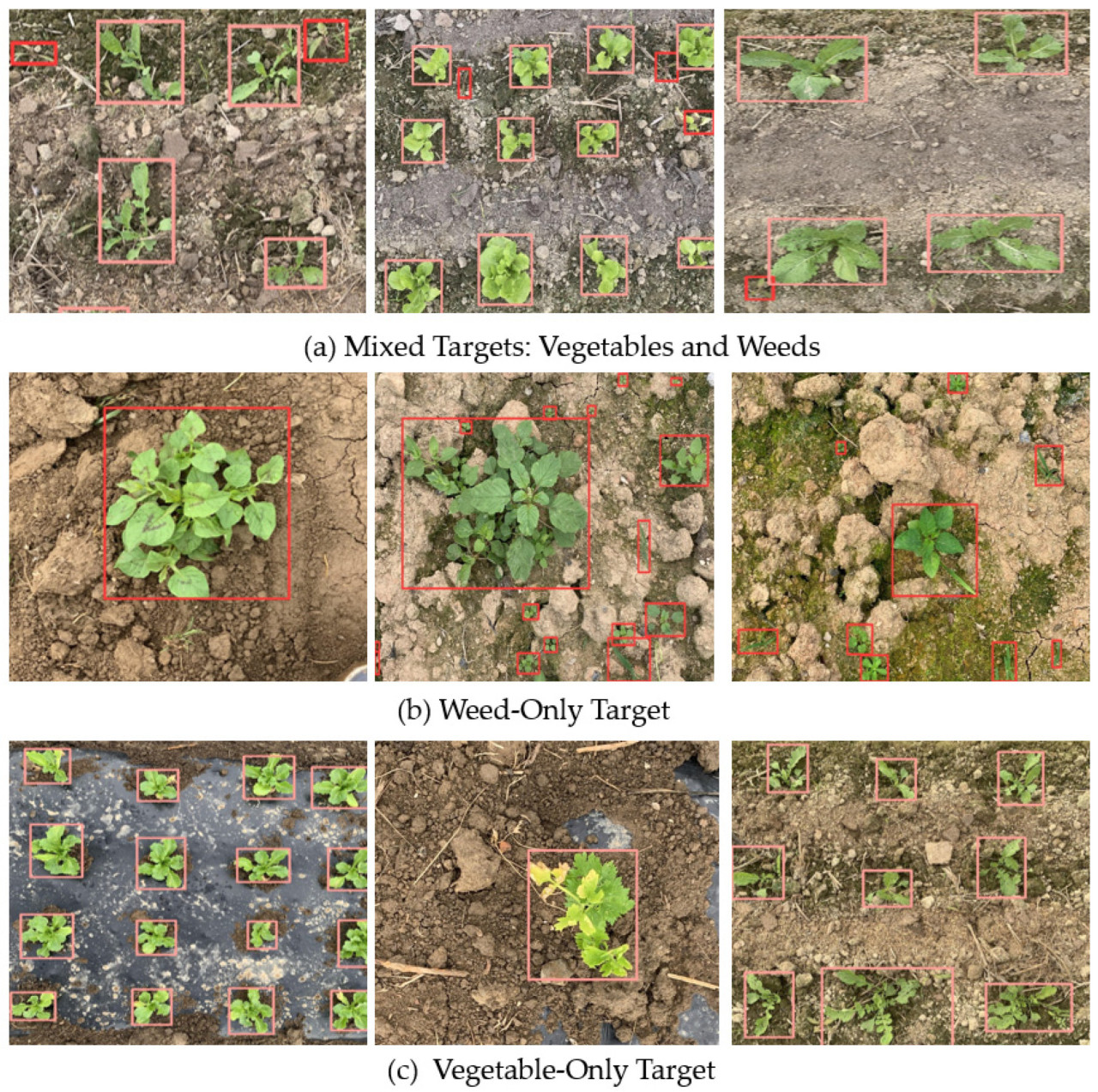

Как показано на Рисунке 16, качественные результаты детекции демонстрируют способность модели YEF точно идентифицировать культуры и сорняки в различных сложных условиях, включая сложный фон, разнообразные типы растений и varying размеры объектов. (a) иллюстрирует пример, содержащий как овощи, так и сорняки, (b) показывает цель только с сорняками, и (c) focuses исключительно на цели-овощах. Это комплексное представление highlights адаптируемость модели к различным сценариям детекции.

Рисунок 16. Качественные результаты детекции моделью YEF. Красные ограничивающие рамки представляют сорняки, в то время как розовые ограничивающие рамки представляют овощи.

4. Выводы

В данной статье представлена модель обнаружения овощей и сорняков YOLOv8-EGC-Fusion (YEF), способная различать сельскохозяйственные культуры и сорные растения в различных сложных условиях. Модель включает три легко внедряемых модуля: EGC, GCAA и GCAA-Fusion. Модуль EGC использует сверточные ядра разного размера для эффективной групповой свертки, обеспечивая захват пространственных признаков на разных масштабах, и объединяется с модулем C2f, формируя модуль C2f-EGC. Использование модуля C2f-EGC в слоях с большим количеством каналов значительно повышает способность сети анализировать локальный контекст. Модуль GCAA использует раздельные свертки для получения информации о глобальном контексте. Модуль GCAA-Fusion эффективно объединяет низкоуровневые и высокоуровневые признаки, решая проблему потери информации в глубине сети. Кроме того, в данной статье разработана новая архитектура пирамиды признаков — AFF — на основе GCAA-Fusion и PAFPN, которая дополнительно улучшает способность модели извлекать признаки.

Эффективность предложенной модели была успешно проверена в ходе серии экспериментов. Сравнительные тесты с исходной моделью и современными сетевыми архитектурами наглядно продемонстрировали, что модель YEF успешно справляется с задачами распознавания, действенно решая проблемы обнаружения объектов разного масштаба, и превосходит модель YOLOv8n, а также другие известные сети, такие как Faster R-CNN, RetinaNet, Tood, RTMDet и YOLOv5, по ключевым метрикам: точности, полноте и mAP. Результаты сравнительных экспериментов с модулями слияния признаков на основе разных механизмов внимания указывают, что модуль слияния на основе GCAA существенно усиливает выразительную способность алгоритма и улучшает качество обнаружения. Включение усовершенствованных модулей в модель YOLOv5 и последующее подтверждение их эффективности в сравнительных экспериментах доказывает, что предложенные модули обладают высокой способностью к обобщению, заметно повышая точность распознавания YOLOv5. Тестирование модели YEF на публичных наборах данных подтвердило ее выдающуюся производительность в различных сценариях и условиях, достигнув поставленных целей.

Модель YEF показала многообещающие результаты в задачах обнаружения овощей и сорняков и имеет потенциал для практического применения в сельском хозяйстве; однако у нее все еще есть некоторые ограничения: (1) модель требует дальнейшей оптимизации скорости работы и использования памяти перед развертыванием на оборудовании, и (2) модель была протестирована только для ограниченного числа видов овощей и сорняков, в то время как реальное сельскохозяйственное производство включает гораздо большее разнообразие культур и более сложные условия выращивания. Поэтому необходимы последующие исследования и проверка эффективности модели для других овощей и сорняков.

Ссылки

1. Ryder, E.J.; Dias, J.S. World Vegetable Industry: Production, Breeding, Trends. Hortic. Rev. 2011, 38, 299–356. [Google Scholar] [CrossRef]

2. Han, J.; Luo, Y.; Yang, L.; Liu, X.; Wu, L.; Xu, J. Acidification and Salinization of Soils with Different Initial pH under Greenhouse Vegetable Cultivation. J. Soils Sediments 2014, 14, 1683–1692. [Google Scholar] [CrossRef]

3. Tang, Y.; Dong, J.; Gruda, N.; Jiang, H. China Requires a Sustainable Transition of Vegetable Supply from Area-Dependent to Yield-Dependent and Decreased Vegetable Loss and Waste. Int. J. Environ. Res. Public Health 2023, 20, 1223. [Google Scholar] [CrossRef]

4. Iqbal, N.; Manalil, S.; Chauhan, B.S.; Adkins, S.W. Investigation of Alternate Herbicides for Effective Weed Management in Glyphosate-Tolerant Cotton. Arch. Agron. Soil Sci. 2019, 65, 1885–1899. [Google Scholar] [CrossRef]

5. Mennan, H.; Jabran, K.; Zandstra, B.H.; Pala, F. Non-Chemical Weed Management in Vegetables by Using Cover Crops: A Review. Agronomy 2020, 10, 257. [Google Scholar] [CrossRef]

6. Bakhshipour, A.; Jafari, A.; Nassiri, S.M.; Zare, D. Weed Segmentation Using Texture Features Extracted from Wavelet Sub-Images. Biosyst. Eng. 2017, 157, 1–12. [Google Scholar] [CrossRef]

7. Raja, R.; Slaughter, D.C.; Fennimore, S.A.; Nguyen, T.T.; Siemens, M.C. Crop Signalling: A Novel Crop Recognition Technique for Robotic Weed Control. Biosyst. Eng. 2019, 187, 278–291. [Google Scholar] [CrossRef]

8. Wang, X.; Wang, Q.; Qiao, Y.; Zhang, X.; Lu, C.; Wang, C. Precision Weed Management for Straw-Mulched Maize Field: Advanced Weed Detection and Targeted Spraying Based on Enhanced YOLO v5s. Agriculture 2024, 14, 2134. [Google Scholar] [CrossRef]

9. Wang, A.; Zhang, W.; Wei, X. A Review on Weed Detection Using Ground-Based Machine Vision and Image Processing Techniques. Comput. Electron. Agric. 2019, 158, 226–240. [Google Scholar] [CrossRef]

10. Aversano, L.; Bernardi, M.L.; Cimitile, M.; Iammarino, M.; Rondinella, S. Tomato Diseases Classification Based on VGG and Transfer Learning. In Proceedings of the 2020 IEEE International Workshop on Metrology for Agriculture and Forestry (MetroAgriFor), Trento, Italy, 4–6 November 2020; pp. 129–133. [Google Scholar] [CrossRef]

11. Meyer, G.E.; Neto, J.C. Verification of color vegetation indices for automated crop imaging applications. Comput. Electron. Agric. 2008, 63, 282–293. [Google Scholar] [CrossRef]

12. He, K.; Gkioxari, G.; Dollár, P.; Girshick, R. Mask R-CNN. In Proceedings of the IEEE International Conference on Computer Vision, Venice, Italy, 22–29 October 2017; pp. 2961–2969. [Google Scholar] [CrossRef]

13. Ren, S.; He, K.; Girshick, R.; Sun, J. Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks. IEEE Trans. Pattern Anal. Mach. Intell. 2017, 39, 1137–1149. [Google Scholar] [CrossRef]

14. Jiang, L.; Wang, Y.; Wu, C.; Wu, H. Fruit Distribution Density Estimation in YOLO-Detected Strawberry Images: A Kernel Density and Nearest Neighbor Analysis Approach. Agriculture 2024, 14, 1848. [Google Scholar] [CrossRef]

15. Chen, J.; Wang, H.; Zhang, H.; Luo, T.; Wei, D.; Long, T.; Wang, Z. Weed Detection in Sesame Fields Using a YOLO Model with an Enhanced Attention Mechanism and Feature Fusion. Comput. Electron. Agric. 2022, 202, 107412. [Google Scholar] [CrossRef]

16. Cao, Y.; Pang, D.; Zhao, Q.; Yan, Y.; Jiang, Y.; Tian, C.; Wang, F.; Li, J. Improved YOLOv8-GD Deep Learning Model for Defect Detection in Electroluminescence Images of Solar Photovoltaic Modules. Eng. Appl. Artif. Intell. 2024, 131, 107866. [Google Scholar] [CrossRef]

17. Wu, H.; Wang, Y.; Zhao, P.; Qian, M. Small-Target Weed-Detection Model Based on YOLO-V4 with Improved Backbone and Neck Structures. Precis. Agric. 2023, 24, 2149–2170. [Google Scholar] [CrossRef]

18. Ying, B.; Xu, Y.; Zhang, S.; Shi, Y.; Liu, L. Weed Detection in Images of Carrot Fields Based on Improved YOLOv4. Trait. Signal. 2021, 38, 341–348. [Google Scholar] [CrossRef]

19. Hu, R.; Su, W.; Li, J.; Peng, Y. Real-Time Lettuce-Weed Localization and Weed Severity Classification Based on Lightweight YOLO Convolutional Neural Networks for Intelligent Intra-Row Weed Control. Comput. Electron. Agric. 2024, 226, 109404. [Google Scholar] [CrossRef]

20. Solimani, F.; Cardellicchio, A.; Dimauro, G.; Petrozza, A.; Summerer, S.; Cellini, F.; Renò, V. Optimizing Tomato Plant Phenotyping Detection: Boosting YOLOv8 Architecture to Tackle Data Complexity. Comput. Electron. Agric. 2024, 218, 108728. [Google Scholar] [CrossRef]

21. Qu, H.-R.; Su, W.-H. Deep Learning-Based Weed–Crop Recognition for Smart Agricultural Equipment: A Review. Agronomy 2024, 14, 363. [Google Scholar] [CrossRef]

22. Su, D.; Qiao, Y.; Kong, H.; Sukkarieh, S. Real-Time Detection of Inter-Row Ryegrass in Wheat Farms Using Deep Learning. Biosyst. Eng. 2021, 204, 198–211. [Google Scholar] [CrossRef]

23. Wang, A.; Chen, H.; Liu, L.; Chen, K.; Lin, Z.; Han, J.; Ding, G. Yolov10: Real-Time End-to-End Object Detection. arXiv 2024, arXiv:2405.14458. [Google Scholar] [CrossRef]

24. Wang, C.Y.; Yeh, I.H.; Liao, H.Y.M. Yolov9: Learning What You Want to Learn Using Programmable Gradient Information. arXiv 2024, arXiv:2402.13616. [Google Scholar] [CrossRef]

25. Wen, C.; Guo, H.; Li, J.; Hou, B.; Huang, Y.; Li, K.; Lu, Y. Application of Improved YOLOv7-Based Sugarcane Stem Node Recognition Algorithm in Complex Environments. Front. Plant Sci. 2023, 14, 1230517. [Google Scholar] [CrossRef]

26. Han, K.; Wang, Y.; Tian, Q.; Guo, J.; Xu, C.; Xu, C. GhostNet: More Features from Cheap Operations. arXiv 2020, arXiv:2005.05928. Available online: https://arxiv.org/abs/2005.05928 (accessed on 27 November 2024).

27. Chen, J.; Kao, S.H.; He, H.; Zhuo, W.; Wen, S.; Lee, C.H.; Chan, S.H.G. Run, Don’t Walk: Chasing Higher FLOPS for Faster Neural Networks. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, Vancouver, BC, Canada, 17–24 June 2023; IEEE: Piscataway, NJ, USA, 2023; pp. 12021–12031. [Google Scholar] [CrossRef]

28. Xiong, C.; Zayed, T.; Abdelkader, E.M. A Novel YOLOv8-GAM-Wise-IoU Model for Automated Detection of Bridge Surface Cracks. Constr. Build. Mater. 2024, 414, 135025. [Google Scholar] [CrossRef]

29. Redmon, J.; Divvala, S.; Girshick, R.; Farhadi, A. You Only Look Once: Unified, Real-Time Object Detection. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, NV, USA, 27–30 June 2016; pp. 779–788. [Google Scholar] [CrossRef]

30. Huang, Z.; Wang, X.; Wei, Y.; Huang, L.; Shi, H.; Liu, W. CCNet: Criss-Cross Attention for Semantic Segmentation. IEEE Trans. Pattern Anal. Mach. Intell. 2023, 45, 6896–6908. [Google Scholar] [CrossRef]

31. Jing, X.; Liu, X.; Liu, B. Composite Backbone Small Object Detection Based on Context and Multi-Scale Information with Attention Mechanism. Mathematics 2024, 12, 622. [Google Scholar] [CrossRef]

32. Chen, Z.; He, Z.; Lu, Z.M. DEA-Net: Single Image Dehazing Based on Detail-Enhanced Convolution and Content-Guided Attention. IEEE Trans. Image Process. 2024, 33, 1002–1015. [Google Scholar] [CrossRef]

33. Tang, L.; Zhang, H.; Xu, H.; Ma, J. Rethinking the Necessity of Image Fusion in High-Level Vision Tasks: A Practical Infrared and Visible Image Fusion Network Based on Progressive Semantic Injection and Scene Fidelity. Inf. Fusion 2023, 99, 101870. [Google Scholar] [CrossRef]

34. Zhang, Z.; Wang, Z.; Lin, Z.; Qi, H. Image Super-Resolution by Neural Texture Transfer. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, Long Beach, CA, USA, 15–20 June 2019; pp. 7974–7983. [Google Scholar] [CrossRef]

35. Felzenszwalb, P.F.; Girshick, R.B.; McAllester, D.; Ramanan, D. Object Detection with Discriminatively Trained Part-Based Models. IEEE Trans. Softw. Eng. 2009, 32, 1627–1645. [Google Scholar] [CrossRef]

36. Liu, W.; Anguelov, D.; Erhan, D.; Szegedy, C.; Reed, S.; Fu, C.Y.; Berg, A.C. SSD: Single Shot Multibox Detector. In Computer Vision–ECCV 2016: 14th European Conference, Amsterdam, The Netherlands, 11–14 October 2016; Proceedings, Part I; Springer International Publishing: Berlin/Heidelberg, Germany, 2016; pp. 21–37. [Google Scholar] [CrossRef]

37. Lin, T.; Dollar, P.; Girshick, R.; He, K.; Hariharan, B.; Belongie, S. Feature Pyramid Networks for Object Detection. IEEE Comput. Soc. 2017, 41, 939–954. [Google Scholar] [CrossRef]

38. Wan, D.; Lu, R.; Shen, S.; Xu, T.; Lang, X.; Ren, Z. Mixed Local Channel Attention for Object Detection. Eng. Appl. Artif. Intell. 2023, 123, 106442. [Google Scholar] [CrossRef]

39. Woo, S.; Park, J.; Lee, J.-Y.; Kweon, I.S. CBAM: Convolutional Block Attention Module. In Proceedings of the European Conference on Computer Vision (ECCV), Munich, Germany, 8–14 September 2018; pp. 3–19. [Google Scholar] [CrossRef]

40. Hu, J.; Shen, L.; Sun, G. Squeeze-and-excitation networks. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Salt Lake City, UT, USA, 18–23 June 2018; pp. 7132–7141. [Google Scholar] [CrossRef]

41. Wang, A.; Chen, H.; Lin, Z.; Han, J.; Ding, G. Repvit-sam: Towards real-time segmenting anything. arXiv 2023, arXiv:2312.05760. Available online: https://arxiv.org/abs/2312.05760 (accessed on 27 November 2024).

42. Selvaraju, R.R.; Cogswell, M.; Das, A.; Vedantam, R.; Parikh, D.; Batra, D. Grad-CAM: Visual Explanations from Deep Networks via Gradient-Based Localization. Int. J. Comput. Vis. 2020, 128, 336–359. [Google Scholar] [CrossRef]

43. Feng, C.; Zhong, Y.; Gao, Y.; Scott, M.R.; Huang, W. TOOD: Task-Aligned One-Stage Object Detection. In Proceedings of the 2021 IEEE/CVF International Conference on Computer Vision, Montreal, QC, Canada, 10–17 October 2021; pp. 3490–3499. [Google Scholar] [CrossRef]

44. Lyu, C.; Zhang, W.; Huang, H.; Zhou, Y.; Wang, Y.; Liu, Y.; Chen, K. RTMDet: An Empirical Study of Designing Real-Time Object Detectors. arXiv 2022, arXiv:2212.07784. [Google Scholar] [CrossRef]

45. Lin, T.-Y.; Goyal, P.; Girshick, R.; He, K.; Dollár, P. Focal Loss for Dense Object Detection. IEEE Trans. Pattern Anal. Mach. Intell. 2020, 42, 318–327. [Google Scholar] [CrossRef]

46. Zhang, H.; Li, F.; Liu, S.; Zhang, L.; Su, H.; Zhu, J.; Ni, L.M.; Shum, H.Y. DINO: DETR with improved denoising anchor boxes for end-to-end object detection. arXiv 2022, arXiv:2203.03605. [Google Scholar] [CrossRef]

47. Ravirajsinh, D. Crop and Weed Detection Data with Bounding Boxes [Dataset]; Kaggle: San Francisco, CA, USA, 2020; Available online: https://www.kaggle.com/datasets/ravirajsinh45/crop-and-weed-detection-data-with-bounding-boxes (accessed on 27 November 2024).

48. Dang, F.; Chen, D.; Lu, Y.; Li, Z. YOLOWeeds: A Novel Benchmark of YOLO Object Detectors for Multi-Class Weed Detection in Cotton Production Systems. Comput. Electron. Agric. 2023, 205, 107655. [Google Scholar] [CrossRef]

Chen C, Zang Y, Jiao J, Yan D, Fan Z, Cui Z, Zhang M. An Efficient Group Convolution and Feature Fusion Method for Weed Detection. Agriculture. 2025; 15(1):37. https://doi.org/10.3390/agriculture15010037

Перевод статьи «An Efficient Group Convolution and Feature Fusion Method for Weed Detection» авторов Chen C, Zang Y, Jiao J, Yan D, Fan Z, Cui Z, Zhang M., оригинал доступен по ссылке. Лицензия: CC BY. Изменения: переведено на русский язык

Комментарии (0)