Исследование многомерного распознавания поведения молочных коров в сложных условиях на основе улучшенного YOLOv5

Повседневное поведение молочных коров, включая стояние, питье, прием пищи и лежание, тесно связано с их физическим здоровьем. Эффективное и точное распознавание поведения коров имеет решающее значение для своевременного мониторинга состояния их здоровья и повышения экономической эффективности ферм.

Аннотация

Для решения проблем, связанных со сложными условиями съемки и значительными вариациями размеров животных при распознавании поведения коров в условиях группового содержания, данное исследование предлагает усовершенствованный метод распознавания на основе YOLOv5. В процессы повышения и понижения разрешения в шейной части сети модели YOLOv5 интегрированы четыре модуля внимания с перемешиванием (SA) для улучшения извлечения глубинных признаков у мелкомасштабных целей и концентрации на пространственных признаках при сохранении сложности сети и производительности в реальном времени. Модуль C3 модели был улучшен за счёт включения деформируемой свёртки (DCNv3), что повышает точность идентификации характеристик поведения коров. Наконец, исходный головной блок обнаружения был заменён на динамический головной блок (DyHead) для повышения эффективности и точности обнаружения поведения коров в различных масштабах в сложных условиях. Был создан экспериментальный набор данных, включающий сложные условия съемки, несколько категорий поведения и объекты разного размера, для всесторонней проверки. Результаты экспериментов демонстрируют, что улучшенная модель YOLOv5 достигла средней точности (mAP) в 97,7%, что на 3,7% выше, чем у исходной модели YOLOv5. Более того, она превзошла модели, выбранные для сравнения, включая YOLOv4, YOLOv3 и Faster R-CNN, в задачах работы со сложной обстановкой, обнаружения объектов разного размера и различения типов поведения. Эксперименты с исключением компонентов дополнительно подтвердили эффективность модулей SA, DCNv3 и DyHead. Результаты исследования представляют собой ценный ориентир для мониторинга поведения коров в сложных условиях в режиме реального времени в течение дня.

1. Введение

Поведение молочных коров, находящееся под влиянием внутренних физиологических изменений или внешних стимулов окружающей среды, служит прямым или косвенным индикатором их здоровья и физиологического состояния. Оно играет ключевую роль в мониторинге заболеваний и выявлении аномалий у молочных коров [1,2,3]. Ежедневные поведенческие акты молочных коров включают ходьбу, лежание, питье, прием пищи и другие. Например, лежание является одним из наиболее важных элементов в повседневной активности молочных коров. Как правило, коровам требуется от 10 до 14 часов лежания в сутки. Это поведение не только важно для их физического здоровья, но и напрямую коррелирует с продуктивностью. Исследования показывают, что каждый дополнительный час времени лежания может увеличить надой примерно на 1.7 кг. Сокращение времени лежания может быть результатом таких факторов, как некомфортная подстилка или охота [4,5].

В современном молочном животноводстве традиционные методы визуального наблюдения непригодны для точного мониторинга поведения из-за своей низкой эффективности и отсутствия оперативности. Точное понимание уникальных привычек и поведенческих характеристик коров имеет важнейшее значение для профилактики, диагностики и лечения заболеваний [6,7,8]. Следовательно, автоматизация, интеллектуализация и точность стали неизбежными тенденциями в крупномасштабном, интенсивном молочном животноводстве для удовлетворения его потребностей развития [9,10,11]. С быстрым прогрессом технологии компьютерного зрения многочисленные исследователи начали изучение методов мониторинга поведения коров с использованием анализа видеоизображений. Ранние методы мониторинга поведения коров зависели от извлечения признаков из изображений или видео в сочетании с традиционными классификаторами, что значительно способствовало начальным исследованиям в области анализа поведения коров [12,13]. Связанные с этим исследования достигли высоких показателей распознавания задач с одним поведением с помощью специфических алгоритмов извлечения признаков, включая вычитание фона и анализ оптического потока [14,15]. Хэ и др. [16] достигли высокоточной детекции поведения, такого как лежание и стояние у телят, используя алгоритм циклического поиска цели по максимальной связанной области, добившись 100% показателя распознавания для определенных поведенческих актов. Дополнительно, Сун и др. [17] применили алгоритмы оптического потока для наблюдения за движением живота коровы во время дыхания, достигнув точной детекции со средней точностью 98.58%. Однако эти методы сильно зависят от искусственного проектирования признаков для конкретных поведенческих актов, чувствительны к фоновому шуму в сложных сценах и обладают ограниченными возможностями обобщения. Их производительность ограничена в задачах детекции множественного поведения, не удовлетворяя сложным требованиям практического применения на животноводческих фермах.

С быстрым развитием технологии глубокого обучения такие устройства, как камеры, теперь могут захватывать RGB-изображения для имитации биологического зрения, обеспечивая обнаружение целей и распознавание поведения животных [18,19,20,21]. Технология глубокого обучения использует сверточные нейронные сети (CNN) и сети с долгой краткосрочной памятью (LSTM) для автоматического изучения ключевых признаков из обширных данных, тем самым минимизируя зависимость от искусственного проектирования признаков [22,23,24,25]. Для идентификации единичного поведения Чжан и др. [26] использовали модель YOLOv3 для обнаружения целей (мясного скота), определения их позиций и идентификации поведения кормления через сверточную нейронную сеть, позволяя распознавать поведение кормления у множества целей. Лю и др. [27] улучшили структуру и параметры сверточной нейронной сети для достижения эффективного обнаружения поведения охотничьих садок у коров в едином фоне, достигнув точности 98.25%. Ван и др. [28] оптимизировали сеть YOLOv3, достигнув 99% показателя распознавания для единичного поведения садки в различных масштабах, но только 86.27% для поведения садки на большом расстоянии и в малом масштабе. Для обнаружения целей множественного поведения Инь и др. [29] применили двунаправленную пирамидальную сеть признаков и метод двунаправленной долгой краткосрочной памяти для различения естественного поведения, такого как лежание, стояние и ходьба, достигнув точности 97.87%. Ма и др. [30] расширили сеть RexNet 3D до трехмерного алгоритма, используя функцию SoftMax для классификации поведения лежания, стояния и ходьбы в сложном фоне, при этом результаты экспериментов показали точность 95%. Видео-основанные методы распознавания поведения коров демонстрируют высокую точность, но используемые наборы данных часто характеризуются простыми условиями с единичными целями, что приводит к плохому распознаванию поведения в различных масштабах. Эти ограничения препятствуют их способности удовлетворять практическим требованиям мониторинга в реальном времени в сложных условиях. Поэтому дополнительная оптимизация и улучшение алгоритма необходимы для практического применения.

Данное исследование направлено на повышение точности распознавания и обнаружения поведения коров в сложных условиях, смягчение влияния целей различных масштабов на результаты распознавания и улучшение производительности модели при идентификации множественного поведения. В данное исследование интегрирован SA [31], который объединяет механизмы внимания по каналам и пространственному вниманию для усиления фокуса модели на областях поведения, эффективного подавления интерференции сложного фона и усиления глубокого извлечения признаков и внимания к мелкомасштабным целям. Модуль C3 был улучшен за счет включения DCNv3 [32], что позволяет модели адаптироваться к вариациям масштаба цели и сложности формы и повышает точность идентификации характеристик поведения коров. Наконец, для улучшения производительности головы обнаружения исходная голова обнаружения была заменена на DyHead [33], что позволяет обеспечить эффективное и точное обнаружение поведения коров в различных масштабах в сложных условиях. Модель YOLOv5 была оптимизирована для улучшения ее способности обнаружения многомасштабных целей в сложных условиях, с целью улучшения распознавания поведения коров.

2. Материалы и методы

2.1. Источник данных

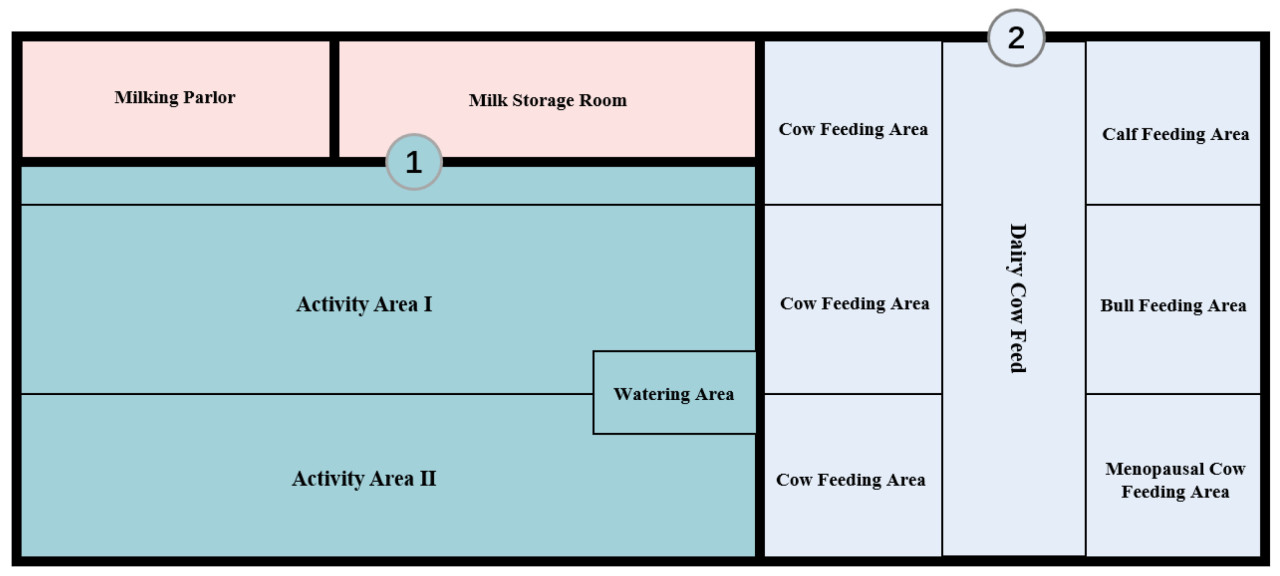

Данный эксперимент был сосредоточен на коровах голштинской породы и проводился на молочной ферме, расположенной в поселке Шаншилипо-Синьцунь, хошуне Тумэд-Цзо, город Хух-Хото, Автономный район Внутренняя Монголия (111°33′ в.д., 40°74′ с.ш., 1058 м над уровнем моря). План испытательной площадки для молочных коров представлен на Рисунке 1.

Рисунок 1. План испытательной площадки для молочных коров. Примечание: Камера 1 (Dahua P40A20-WT-1) захватывает зоны наружной активности I и II коров; Камера 2 (Xiaomi Smart Camera 3 Pan and Tilt Version) захватывает зону внутреннего кормления коров.

Две сетевые камеры, Dahua P40A20-WT-1 (Da Hua Technology, Ханчжоу, Китай) и Xiaomi Smart Camera 3 Pan and Tilt Edition (Xiaomi Technology, Шанхай, Китай), использовались для съемки зон активности и кормления коров, захватывая такие поведенческие акты, как прием пищи, питье, стояние и лежание. Зона кормления коров занимает примерно 200 м². Вторая камера была установлена на внутренней стене, на высоте 3.5 м над землей, в центре зоны, захватывая зону кормления коров с высоты птичьего полета для записи поведения кормления в помещении. Схематическая диаграмма установки камеры в зоне кормления в помещении представлена на Рисунке 2a. Зона активности коров занимает примерно 600 м². Камера была установлена на внешней стене доильного зала, на высоте 2.8 м над землей, в центре поля, захватывая зону активности коров с высоты птичьего полета для записи поведения стояния, питья и лежания на улице. Схематическая диаграмма установки камеры в зоне активности проиллюстрирована на Рисунке 2b.

Рисунок 2. Испытательная площадка для молочных коров. (a) Диаграмма камеры в зоне кормления коров; (b) диаграмма камеры в зоне активности коров.

2.2. Наборы данных и модели

2.2.1. Построение набора данных

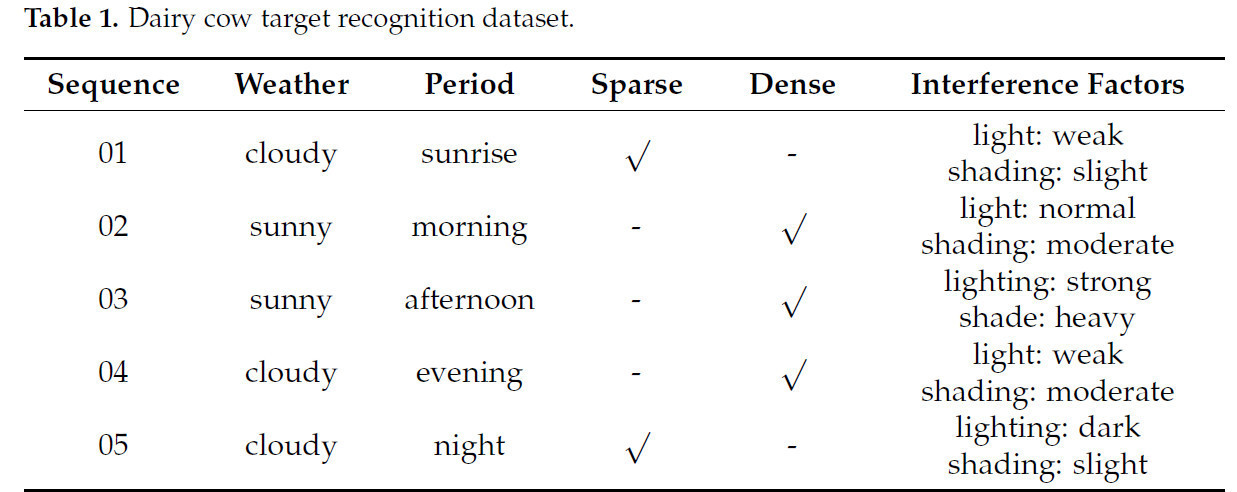

Для оценки производительности распознавания улучшенной сети YOLOv5 в качестве тестовых данных использовались реальные видеозаписи наблюдения из условий реального содержания. Чтобы оценить способность распознавания модели в различных сценариях, для тестирования были выбраны пять видеоклипов из разных условий, помеченных как 01-05. На основе визуального наблюдения видео с высокой плотностью коров и значительной окклюзией из-за перекрывающихся поз были классифицированы как плотные, в то время как те, где коров меньше и окклюзия минимальна, были классифицированы как разреженные. Подробности представлены в Таблице 1. Набор данных для распознавания целей молочных коров.

Таблица 1. Набор данных для распознавания целей молочных коров

Примечательно, что количество коров в зоне активности, как правило, выше в утренние (8:00–12:00) и дневные (12:00–17:00) периоды по сравнению с периодами восхода (5:00–7:00) и вечера (18:00–21:00), с более высокой вероятностью окклюзии между коровами. С точки зрения активности коров, утро и день — это периоды повышенной активности и более высокой вероятности скопления. Поведение коров в эти периоды отличается большим разнообразием. Сбор данных в эти периоды зафиксировал коров в различных состояниях, включая стояние, прием пищи с опущенной головой, питье и другие позы и движения.

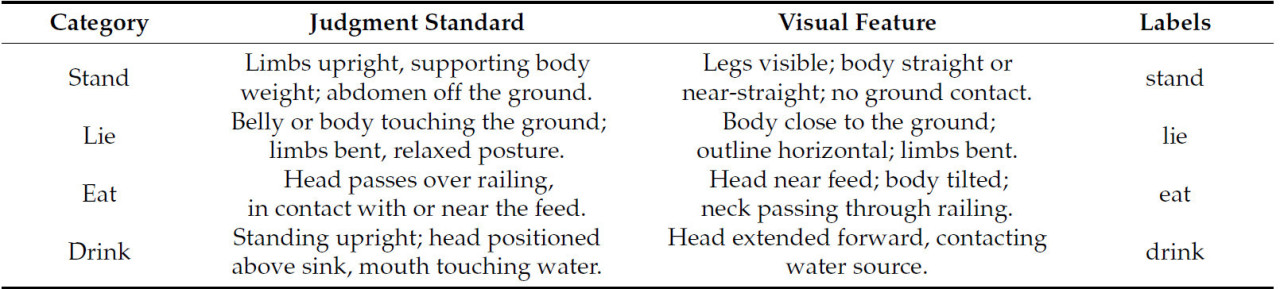

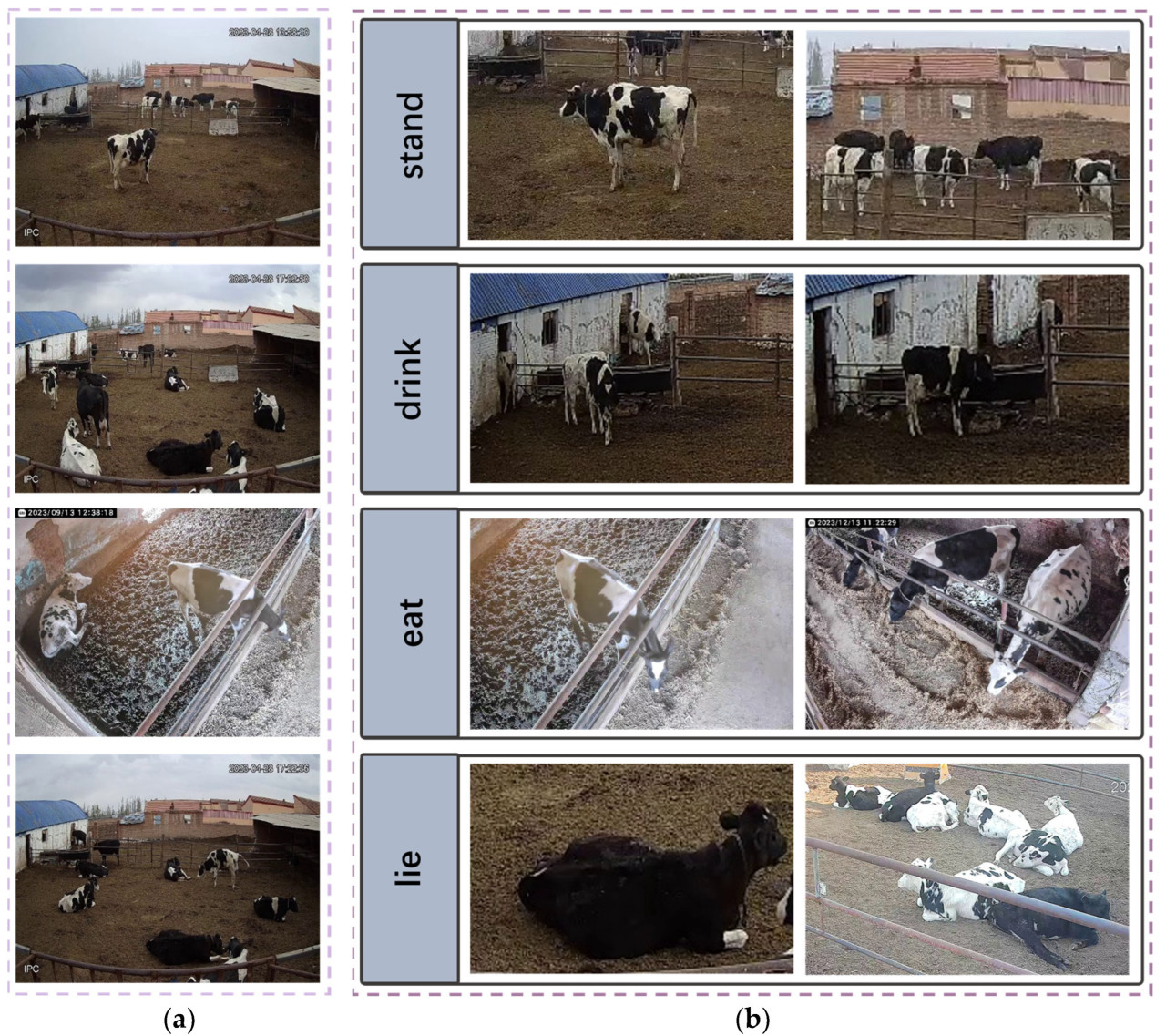

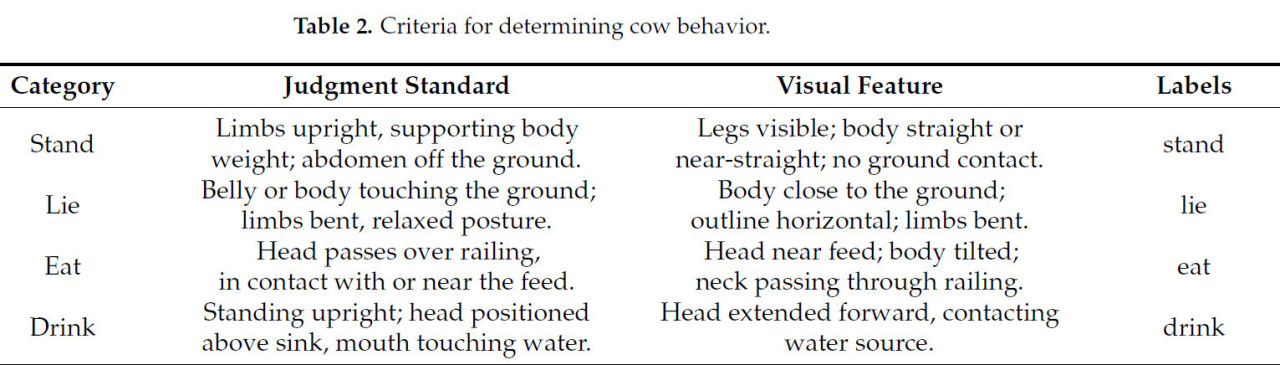

В данном исследовании в качестве объектов исследования участвовали 38 коров голштинской породы. Видеозаписи поведения коров собирались с апреля по декабрь 2023 года. Всего было отобрано 1044 видео с поведением коров, comprising 1008 коротких видео продолжительностью примерно 5 минут и 36 более длительных видео ranging от 0.5 до 3 часов, с разрешением 1920 × 1080 пикселей и частотой кадров 25 кадров/с. Чтобы уменьшить вычислительную нагрузку, повысить эффективность и обеспечить захват необходимой информации для задач распознавания, были implemented следующие video processing steps. First, кадры были извлечены из всех видеоклипов с использованием OpenCV, с частотой дискретизации каждые 25 кадров. Эта стратегия дискретизации минимизирует избыточные кадры и снижает вычислительные потребности. Next, основные поведения коров были размечены с использованием LabelImg. Метки included стояние (stand), лежание (lie), прием пищи (eat), и питье (drink). После фильтрации и обобщения, всего было размечено 3458 изображений. Набор данных был случайным образом разделен в соотношении 8:1:1 для создания обучающего набора (2766 изображений), проверочного набора (346 изображений), и тестового набора (346 изображений) для обучения модели и оценки. Пример поведения коров проиллюстрирован на Рисунке 3. Рисунок 3a изображает многомасштабное поведение коров в различных сценах и сложных фонах, включая поведения на both long и short расстояниях. Рисунок 3b представляет четыре примера поведения коров: стояние, питье, прием пищи, и лежание. Четыре поведения, relevant к оценке здоровья коров, были выбраны в качестве объектов исследования: стояние, лежание, питье, и прием пищи. Критерии определения поведения коров представлены в Таблице 2. Критерии определения поведения коров [34].

Таблица 2. Критерии определения поведения коров

Рисунок 3. Пример съемки поведения коров. (a) Сцена видеонаблюдения; (b) пример поведения коров.

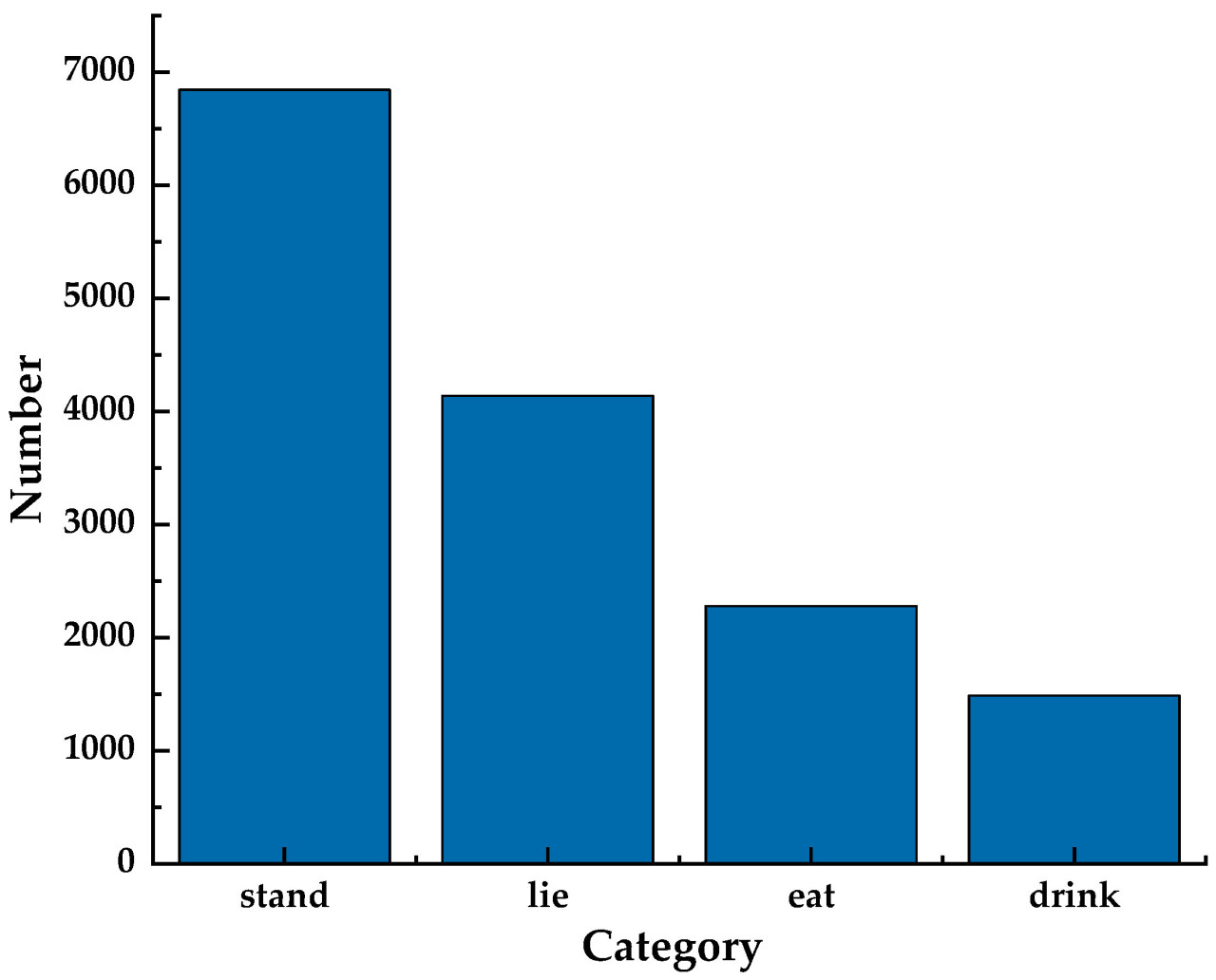

Таблица 2 описывает четыре поведения коров и соответствующие данные. Когда корова стоит, все четыре ноги прямые, поддерживая вес, живот находится на расстоянии от земли, тело в вертикальном положении, голова либо горизонтальна, либо опущена. Когда корова лежит, живот, грудь или часть тела касаются земли, конечности согнуты, поза расслаблена, голова лежит плоско или слегка приподнята, корова лежит горизонтально. Когда корова ест, конечности прямые, голова опущена, проходит через ограждение, и рот касается или находится близко к корму. Когда корова пьет, конечности прямые, поддерживая вес, голова находится над поилкой, и рот касается поверхности воды. На основе определений в Таблице 2, набор данных был размечен, в результате чего получилось 14,754 поведенческих актов, включая стояние (6845), лежание (4139), прием пищи (2280), и питье (1490). На Рисунке 4 представлено сравнение статистики меток. Коровы наиболее часто наблюдались стоящими, в то время как прием пищи и питье были наименее частыми поведениями. Это распределение closely mirrors наблюдаемое в реальных условиях фермы и соответствует требованиям для анализа поведения коров в сложных условиях.

Рисунок 4. Анализ размеченного поведения коров.

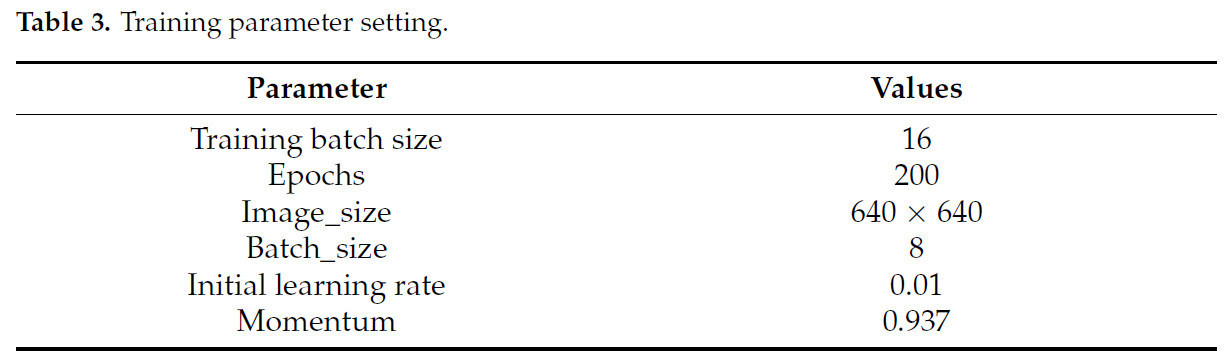

2.2.2. Платформа для обучения

Вычислительная платформа, использованная в данном исследовании, состояла из 12-го поколения Intel® Core™ i7-12700H CPU (Intel Corporation, Санта-Клара, Калифорния, США) процессора с тактовой частотой 2.30 ГГц, 24 ГБ ОЗУ, 1 ТБ SSD-накопителя, и видеокарты NVIDIA GeForce RTX 3070 с 16 ГБ видеопамяти. Программная среда included операционную систему Windows с установленными CUDA 12.1 и Python 3.9. Дополнительно, фреймворк глубокого обучения PyTorch 2.1.0 был использован в данном эксперименте. Технические характеристики аппаратного обеспечения подробно описаны в Таблице 3. Установка параметров обучения. Все алгоритмы сравнения были запущены в той же среде. Настройки параметров обучения сети показаны в Таблице 3 согласно условиям тестирования.

Таблица 3. Установка параметров обучения

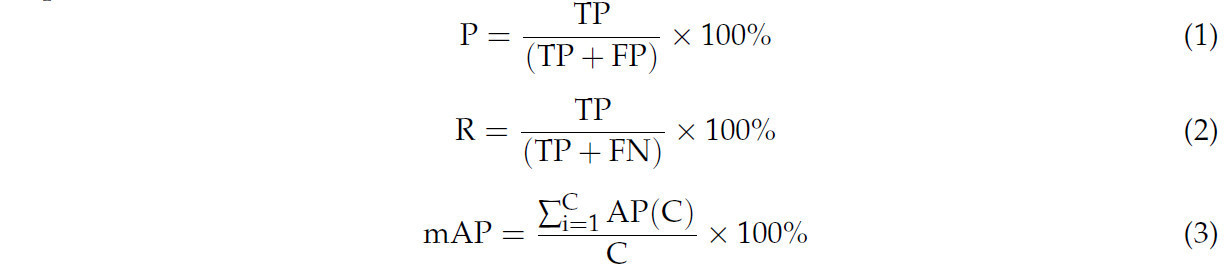

2.2.3. Модель Индекс Оценки

Чтобы проверить производительность этой улучшенной модели, в данном исследовании используются Точность (Precision, P), Полнота (Recall, R), Средняя Точность (Average Precision, AP), Средняя Средняя Точность (mean Average Precision, mAP), Params, Операции с плавающей запятой (Floating Point operations, FLOPs), и F1 Score. F1 Score - это показатель, используемый для оценки производительности модели классификации, объединяющий Точность и Полноту. Когда весовой коэффициент α = 0.5, по сравнению с commonly used F1 Score, P более важна, чем R и имеет удвоенный вес по сравнению с R. mAP50 относится к AP, рассчитанному для всех изображений в каждой категории, когда порог установлен на 0.5, а затем усредненному по всем категориям. mAP50-95 относится к AP, рассчитанному для всех изображений в каждой категории, когда порог установлен на 0.5–0.95, а затем усредненному по всем категориям. Вычисления P, R, и mAP показаны в Уравнениях (1)–(3) [35].

Здесь, TP (True Positives) представляет количество правильно классифицированных положительных примеров, FP (False Positives) обозначает количество отрицательных примеров, ошибочно классифицированных как положительные, FN (False Negatives) указывает количество положительных примеров, ошибочно классифицированных как отрицательные, и C представляет количество категорий обнаружения, которое в данном исследовании составляет C = 1.

2.3. Модель распознавания поведения коров на основе улучшенной сети YOLOv5

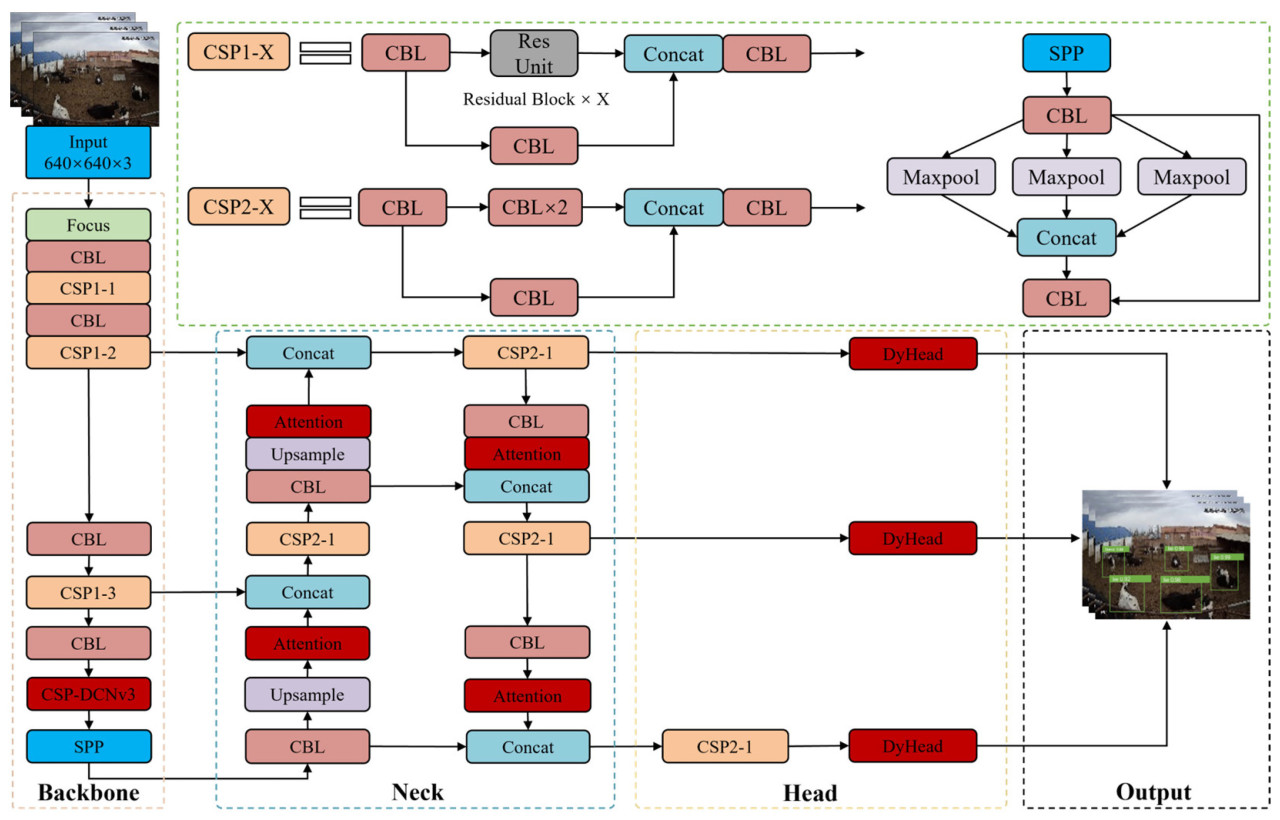

В данном исследовании сеть YOLOv5 была выбрана в качестве базовой модели для распознавания поведения коров. Чтобы решить вышеупомянутые проблемы, обученная модель YOLOv5 была улучшена для повышения производительности обнаружения без ущерба для точности. Три различных механизма внимания были включены для повышения чувствительности модели к мелкомасштабному поведению коров, поддержания эффективного обнаружения крупномасштабных коров и различения между поведенческими сходствами, такими как поза. Без увеличения сложности сети или ущерба для производительности в реальном времени, четыре модуля внимания были интегрированы в шейную сеть модели YOLOv5. Эти модули были implemented в процессах повышения и понижения разрешения для улучшения глубокого извлечения признаков мелкомасштабных целей коров и фокусировки на relevant информации признаков. Дополнительно, модуль C3 был улучшен, и модули деформируемой свертки были включены для дальнейшего улучшения точности модели в идентификации характеристик поведения коров. Наконец, чтобы оптимизировать производительность головы обнаружения, исходная голова обнаружения была заменена на динамическую голову, enabling эффективное и точное обнаружение поведения коров в различных масштабах в условиях фермы. Улучшенная сетевая структура проиллюстрирована на Рисунке 5, с измененными модулями, выделенными красным. Эти модификации значительно улучшили производительность модели в обнаружении поведения коров в условиях фермы, particularly ее способность различать коров размера размера, exhibiting сходные поведения.

Рисунок 5. Улучшенная сетевая структура модели YOLOv5.

2.3.1. Добавление Shuffle Attention

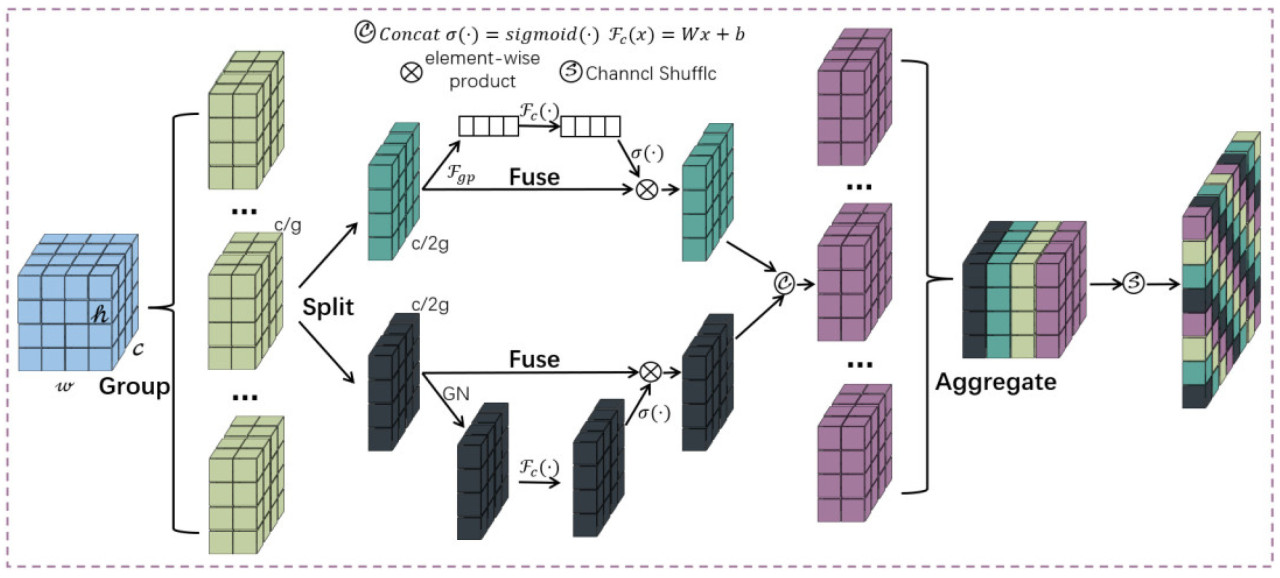

Shuffle Attention (SA) - это гибридный механизм внимания, который интегрирует механизмы внимания каналов и пространственного внимания. Он группирует входные карты признаков и независимо выполняет операции свертки внутри каждой группы. Он способствует обмену и слиянию признаков между группами через операции перетасовки каналов и использует стратегию двойного внимания для улучшения разнообразия признаков и выразительности, enabling более точный захват деталей изображения и контекстуальной информации [36]. Учитывая богатое и разнообразное поведение коров, каждое поведение exhibits отличительные характеристики на изображении. SA усиливает чувствительность модели к мелкомасштабному поведению коров, улучшает богатство и точность выражения признаков, и позволяет более точно захватывать ключевые поведенческие признаки, thereby повышая производительность многомасштабного распознавания поведения коров в сложных фонах. Структура модуля SA проиллюстрирована на Рисунке 6.

Рисунок 6. Структура модуля Shuffle Attention.

2.3.2. Введение Deformable Convolution DCNv3

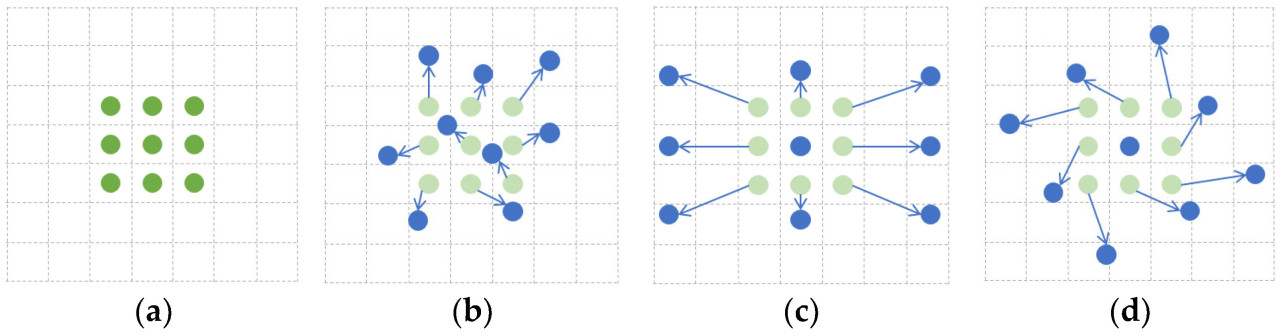

DCNv3 интегрирует разреженный механизм внимания со сверткой для обработки каждой выходной позиции скользящим оконным способом. Он динамически samples точки с адаптивным диапазоном и агрегирует пространственные признаки, используя веса внимания, зависящие от входа. Это позволяет модели более эффективно фокусироваться на коровах и relevant областях признаков в сложных фонах, адаптивно регулировать рецептивное поле на основе изменений фона, позиции коровы и позы, и улучшать извлечение признаков и устойчивость в сложных условиях. Принцип деформируемой свертки проиллюстрирован на Рисунке 7.

Рисунок 7. Принцип деформируемой свертки. (a) Обычная свертка; (b) деформируемая свертка; (c) специальная деформируемая свертка; (d) специальная деформируемая свертка. Зеленый indicates точки выборки регулярной свертки, и синий indicates динамически выбираемые точки деформируемой свертки.

Данное исследование фокусируется на обнаружении поведения молочных коров в условиях фермы. Сеть деформируемой свертки третьего поколения (DCNv3) была интегрирована для улучшения производительности обнаружения разнообразного поведения коров. Процесс реализации проиллюстрирован на Рисунке 8. По сравнению с традиционной деформируемой сверткой, DCNv3 не только захватывает информацию признаков цели, но и минимизирует интерференцию нерелевантной фоновой информации во время классификации коров с разнообразным поведением. Значительные улучшения производительности достигаются через следующие ключевые технические улучшения:

Рисунок 8. Процесс реализации свертки DCNv3.

(1) Механизм совместного использования весов (Weight Sharing Mechanism): Механизм совместного использования весов уменьшает сложность модели путем разделения весов на две части по глубинной размерности. Этот механизм упрощает структуру модели и повышает эффективность обработки. Конкретно, веса по глубинной размерности регулируются механизмом восприятия в исходной позиции, в то время как веса совместно используются across точки выборки. Этот дизайн уменьшает количество параметров и оптимизирует вычислительный процесс.

(2) Стратегия множественного разделения на группы (Multiple Group Segmentation Strategy): Механизм группировки реализован во время агрегации пространственной информации. Путем разделения процесса выборки на N групп, каждая со своим собственным смещением выборки и шкалой регулировки, модель достигает разнообразных режимов агрегации пространственной информации в пределах одного слоя. Эта стратегия позволяет модели захватывать более богатую и детальную информацию признаков, повышая точность обнаружения разнообразного поведения коров.

(3) Нормализация SoftMax (SoftMax Normalization): Для повышения стабильности обучения функция SoftMax заменяет традиционную функцию Sigmoid для нормализации. Это улучшение решает проблему исчезающего градиента, связанную с Sigmoid, обеспечивая стабильное обучение модели.

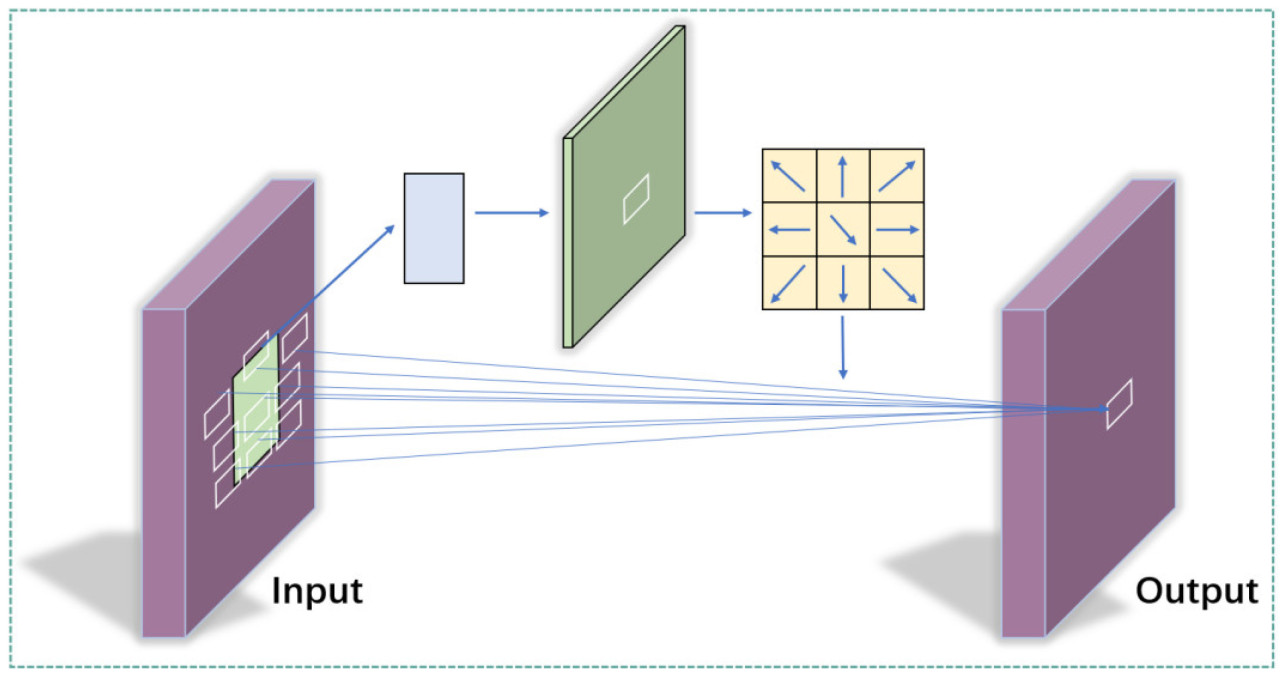

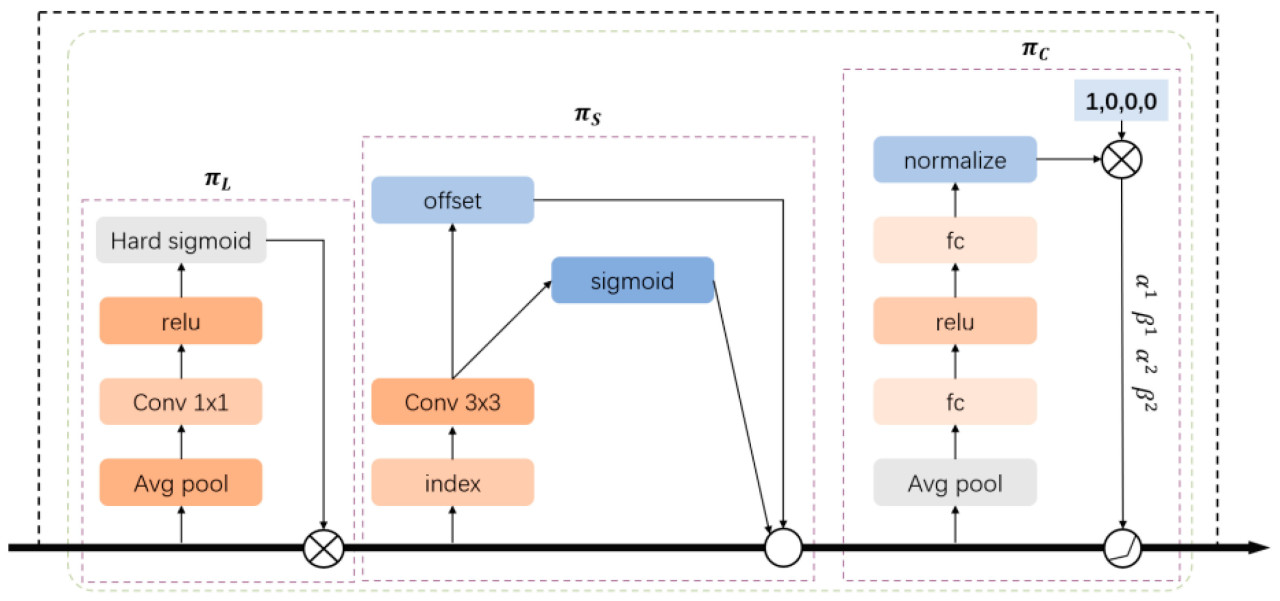

2.3.3. Замена Dynamic Head

Хотя традиционные алгоритмы направлены на улучшение головы обнаружения, им не хватает единого подхода. DyHead - это перспективная структура головы обнаружения объектов, специально разработанная для решения проблем сложных сцен, таких как обнаружение поведения молочных коров в условиях фермы. Эти сцены характеризуются различными размерами объектов, широким диапазоном поведений (например, кормление, лежание, стояние, и питье), и сходствами между определенными поведениями. DyHead эффективно адаптируется к этому разнообразию и сложности через динамический механизм внимания. Его структура проиллюстрирована на Рисунке 9. Он использует модули внимания, учитывающие масштаб (scale-aware), пространство (spatial-aware), и задачу (task-aware), для управления задачами обнаружения разнообразных объектов единым и гибким способом, enabling алгоритму лучше понимать и распознавать различные поведения коров.

Рисунок 9. Структура DyHead.

3. Результаты

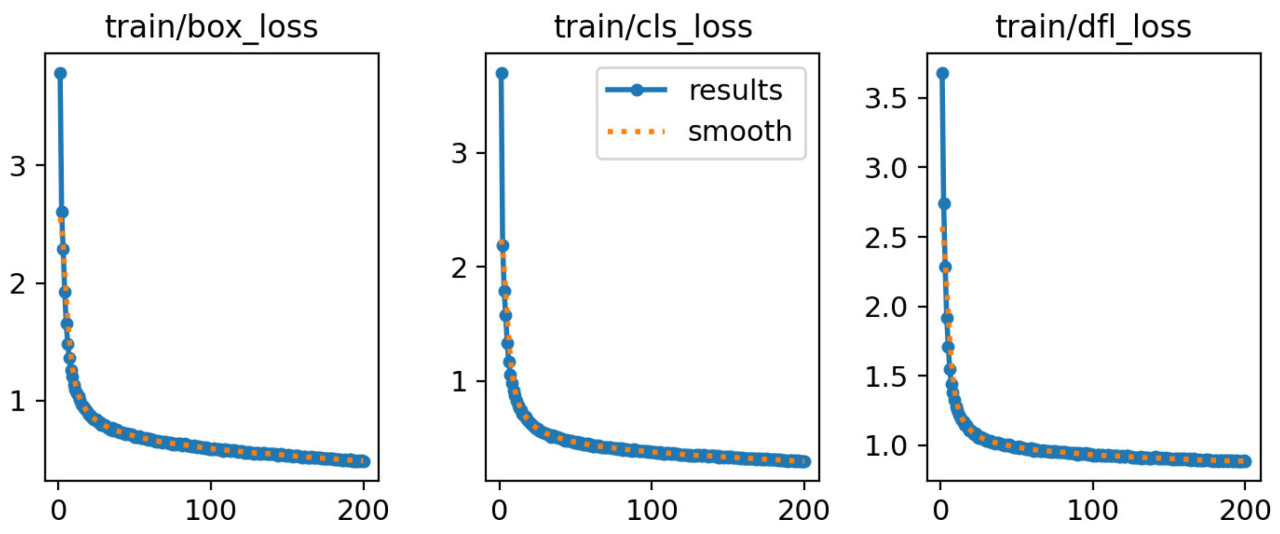

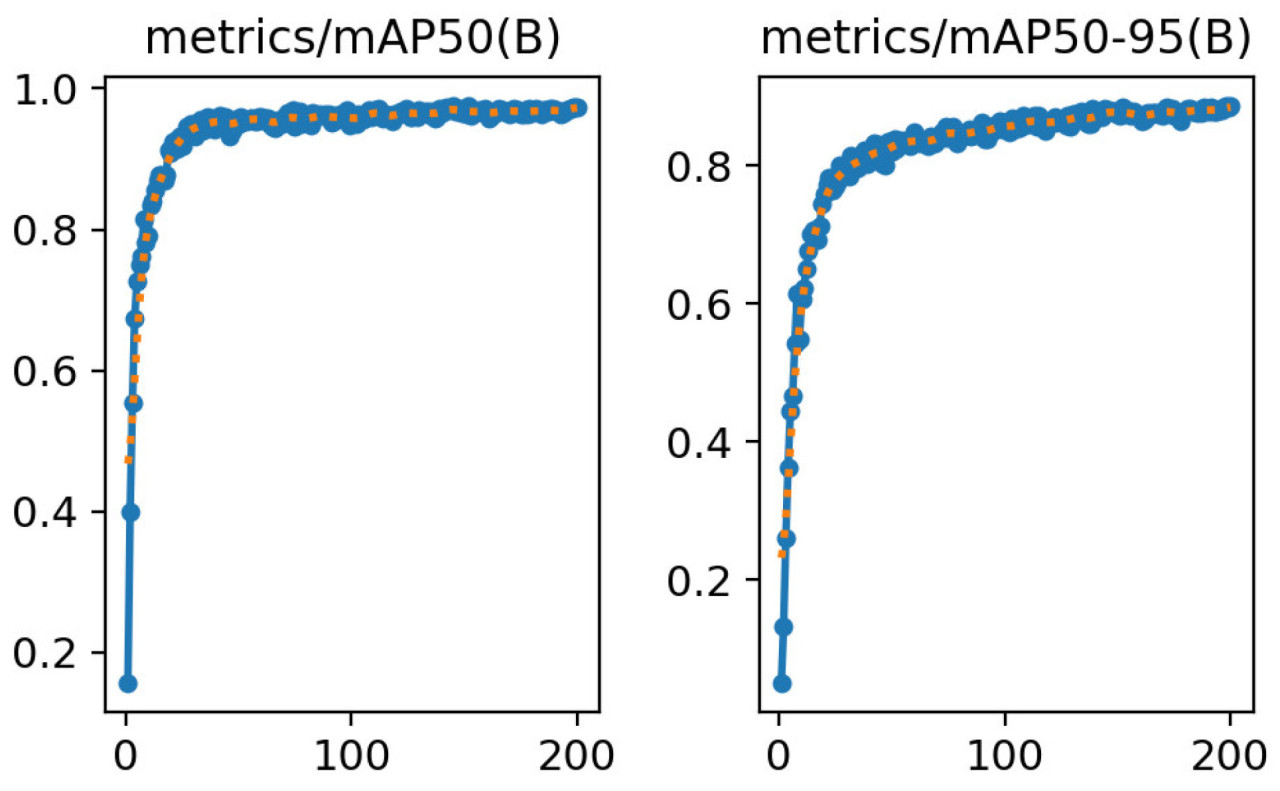

В данном исследовании производительность модели оценивалась путем мониторинга скорости потерь и точности во время обучения, с использованием техник заморозки слоев и передачи обучения для использования предварительных знаний и ускорения обучения. Процесс обучения состоял из 200 эпох, со стратегией частичной заморозки слоев, примененной в течение первых 50 эпох. Эта стратегия направлена на смягчение резких корректировок предварительно обученных параметров, обеспечивая стабильную оптимизацию без значительных нарушений. Тенденции в функции потерь и mAP указывают, что потери модели постепенно уменьшаются с течением времени, в то время как mAP стабильно увеличивается. Изменение функции потерь во время обучения проиллюстрировано на Рисунке 10. Хотя начальные потери были высокими, уровень ошибок значительно снизился по мере прогресса обучения, и точность обнаружения улучшалась постепенно. Изменение точности модели во время обучения изображено на Рисунке 11. Это явление не только подтверждает эффективность стратегии ранней заморозки, но и демонстрирует ее способность предотвращать переобучение и проблемы сходимости на ранней фазе обучения. По мере продвижения процесса обучения модель становилась более эффективной в изучении и идентификации ключевых признаков для обнаружения поведения молочных коров на ферме. В целом, стратегия обучения, использованная в данном исследовании, улучшила эффективность обучения, повысила способность модели к обобщению и увеличила общую точность обнаружения.

Рисунок 10. Изменение функции потерь во время обучения.

Рисунок 11. Изменение точности модели во время обучения.

3.1. Сравнение результатов модели распознавания поведения коров

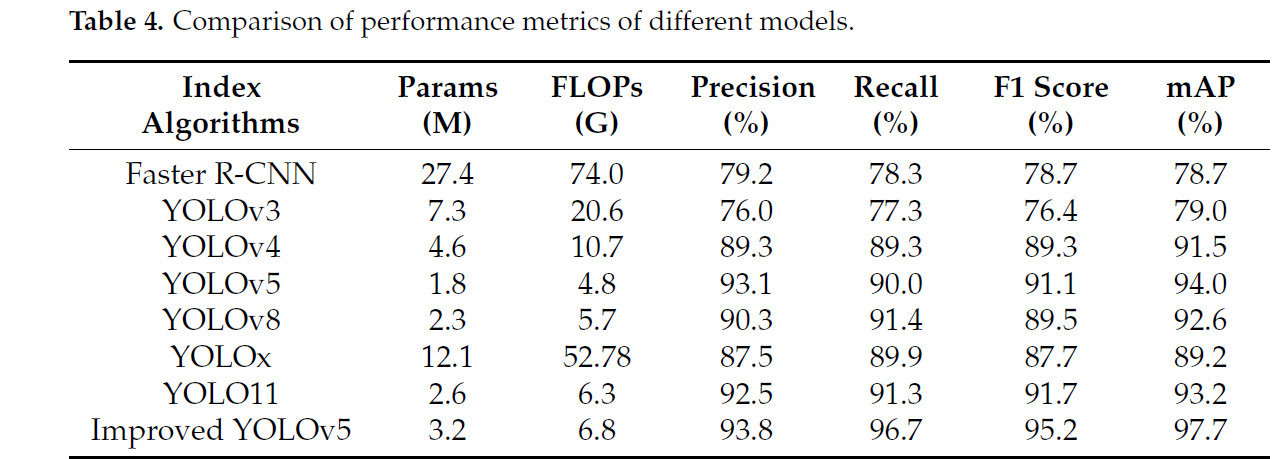

3.1.1. Сравнение производительности различных моделей

Для того чтобы оценить производительность различных моделей в распознавании поведения коров, в данной статье проводится комплексный анализ показателей, таких как Params, FLOPs, Точность, Полнота, F1 Score, и mAP, путем обучения и тестирования моделей на самостоятельно собранном наборе данных о поведении коров. Результаты экспериментов представлены в Таблице 4. Сравнение показателей производительности различных моделей.

Таблица 4. Сравнение показателей производительности различных моделей

Результаты экспериментов ясно демонстрируют преимущества и недостатки каждой модели в распознавании поведения коров в сложных сценариях.

Улучшенная модель YOLOv5 показывает значительные преимущества по всем показателям производительности, особенно в terms of Средней Средней Точности (mAP, 97.7%) и Полноты (Recall, 96.7%), которые заметно выше, чем у других сравниваемых моделей. Конкретно, модуль SA значительно усиливает способность модели к извлечению признаков для мелкомасштабных целей путем объединения механизмов внимания каналов и пространственного внимания. В частности, он может эффективно подавлять интерференцию фонового шума и улучшать способность модели фокусироваться на ключевых областях поведения в задаче распознавания поведения коров в сложных фонах. Модуль DCNv3 усиливает адаптивность модели к изменениям позы коров и сложности формы путем динамической регулировки рецептивных полей сверточных ядер, усиливая адаптивность модели к изменениям позы коров и сложности формы, thereby проявляя большую устойчивость в задачах обнаружения многомасштабных объектов. Модуль DyHead, с другой стороны, оптимизирует возможности обнаружения модели для объектов различных масштабов путем динамического назначения весов признаков, значительно улучшая показатель mAP.

Улучшенная модель YOLOv5 также превосходит по вычислительной эффективности. Хотя ее Params (3.2 M) и FLOPs (6.8 G) немного выше, чем у исходной модели YOLOv5 (1.8 M, 4.8 G), они намного ниже, чем у Faster R-CNN (27.4 M, 74.0 G) и YOLOx (12.1 M, 52.78 G), что указывает, что улучшенная модель имеет высокую вычислительную эффективность и возможность развертывания при сохранении высокой точности распознавания.

Дополнительно, улучшенная модель показывает особенно хорошие результаты в задачах обнаружения объектов в сложном фоне и многомасштабного обнаружения объектов. В сцене с большим количеством коров улучшенная модель может эффективно справляться с окклюзиями объектов и изменениями поз, значительно снижая уровень ложных обнаружений и пропущенных обнаружений. В отличие от этого, хотя YOLOv8 и YOLO11 показывают лучшие результаты в terms of параметров и вычислительной мощности, их показатели mAP на 5.1 и 4.5 процентных пункта ниже, чем у улучшенной модели, соответственно, что указывает, что их адаптивность в сложных сценах все еще имеет много возможностей для улучшения.

3.1.2. Сравнение результатов идентификации различных типов целей

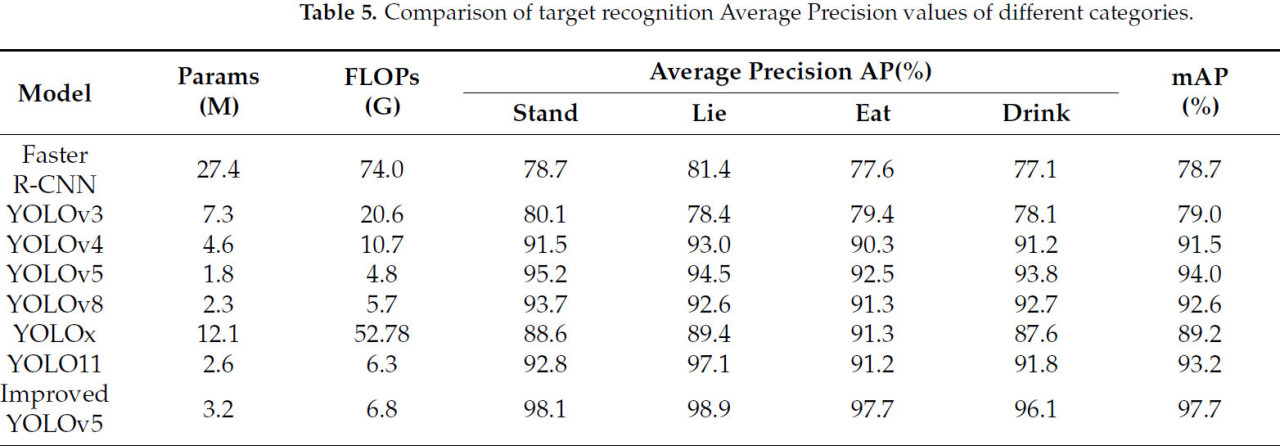

Результаты распознавания различных поведений коров отражают способность модели извлекать и различать признаки целей. Поэтому сравниваются результаты распознавания (значения AP) восьми моделей для единичной категории, как показано в Таблице 5. Сравнение значений средней точности распознавания целей различных категорий.

Таблица 5. Сравнение значений средней точности распознавания целей различных категорий

Улучшенная модель YOLOv5 показывает значительные преимущества во всех категориях поведения, особенно в поведении стояния (98.1%) и лежания (98.9%). Значение AP для поведения стояния (Stand) достигло 98.1%, увеличение на 2.9 процентных пункта по сравнению с исходной моделью YOLOv5 95.2% на 2.9 процентных пункта; значение AP для поведения лежания (Lie) достигло 98.9%, увеличение на 4.4 процентных пункта по сравнению с исходной моделью YOLOv5 94.5%. Это потому, что позы стояния и лежания относительно стабильны и поэтому легче обнаруживать. Дополнительно, в сложных условиях фермы, коровы могут иметь сходные позы, но разные масштабы. SA комбинирует механизмы внимания каналов и пространственного внимания, чтобы усилить способность модели фокусироваться на мелкомасштабных целях и подавлять нерелевантный фоновый шум, что помогает улучшить способность распознавать эти поведения. Значения AP модели для поведения приема пищи (Eat) и питья (Drink) были 97.7% и 96.1% соответственно, что является улучшением на 5.2% и 2.3% по сравнению с исходной моделью YOLOv5. Это потому, что питье и прием пищи включают более динамичные позы и специфическое оборудование, такие как очевидные облизывающие движения головы через ограждение при еде, и стояние рядом с поилкой с головой, расположенной над ней, при питье. Модуль DCNv3 улучшает способность модели адаптироваться к этим изменениям путем динамической регулировки рецептивного поля, в то время как динамическая голова обнаружения DyHead обеспечивает точное обнаружение в различных масштабах.

По сравнению с другими моделями, улучшенная модель YOLOv5 показала особенно хорошие результаты в поведении стояния и лежания. Значение AP Faster R-CNN для поведения стояния было 78.7%, на 19.4 процентных пункта ниже, чем у улучшенной модели YOLOv5; значение AP YOLOv3 для поведения лежания было 78.4%, на 20.5 процентных пункта ниже, чем у улучшенной модели YOLOv5. YOLOv4 показал лучшие результаты в поведении стояния и лежания, его значения AP были 91.5% и 93.0% соответственно, что все еще значительно ниже, чем у улучшенной модели YOLOv5. YOLOv8 и YOLO11 имели значения AP для поведения стояния и лежания 93.7% и 92.6%, и 92.8% и 97.1% соответственно, что было лучше, но все еще не так хорошо, как у улучшенной модели YOLOv5. Улучшенная модель YOLOv5 также показала хорошие результаты в распознавании динамических поведений, таких как прием пищи и питье. Например, улучшенная модель YOLOv5 достигла значения AP 97.7% для поведения приема пищи, что является улучшением на 6.4% по сравнению с YOLOv8 91.3% и на 6.5% по сравнению с YOLO11 91.2%. Для поведения питья, значение AP улучшенной модели YOLOv5 было 96.1%, что было на 3.4% и 4.3% выше, чем YOLOv8 92.7% и YOLO11 91.8% соответственно. Эти результаты дополнительно проверяют применимость и надежность улучшенной модели YOLOv5 в реальных условиях фермы.

3.2. Абляционный эксперимент

3.2.1. Анализ производительности DCNv3 и DyHead

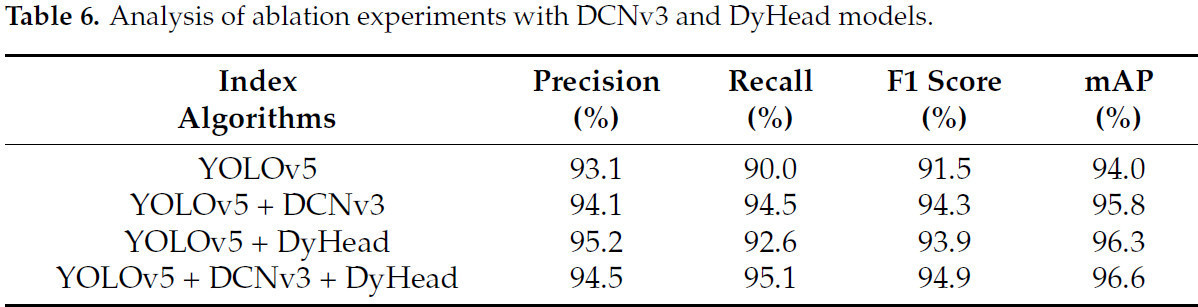

Анализ значений Средней Точности (AP) через все категории поведения демонстрирует эффективность улучшенной модели YOLOv5. Чтобы оценить влияние DCNv3 и DyHead на распознавание различных категорий поведения, были проведены абляционные эксперименты на основе YOLOv5, и результаты представлены в Таблице 6. Анализ абляционных экспериментов с моделями DCNv3 и DyHead.

Таблица 6. Анализ абляционных экспериментов с моделями DCNv3 и DyHead

Таблица 6 иллюстрирует вклад DCNv3 и DyHead в улучшение производительности YOLOv5. Результаты абляционного эксперимента указывают, что эти два модуля значительно улучшают точность и устойчивость распознавания поведения коров. Конкретно, с введением только DCNv3, Точность модели увеличилась с 93.1% до 94.1%, Полнота с 90.0% до 94.5%, F1 Score с 91.5% до 94.3%, и Средняя Средняя Точность (mAP) до 95.8%, подчеркивая значительные преимущества DCNv3 в улучшении извлечения признаков, адаптации к сложным фонам и обработке многомасштабных целей. С другой стороны, добавление DyHead улучшило Точность и Полноту до 95.2% и 92.6% соответственно, в то время как F1 Score и mAP достигли 93.9% и 96.3%, подтверждая эффективность DyHead в динамическом обнаружении целей и слиянии признаков. Когда DCNv3 и DyHead объединены, производительность модели дополнительно оптимизируется, с Точностью, Полнотой, F1 Score, и mAP, достигающими 94.5%, 95.1%, 94.9%, и 96.6% соответственно. Этот результат демонстрирует, что DCNv3 и DyHead проявляют синергию в захвате ключевых признаков, оптимизации границ объектов, динамическом назначении весов признаков и повышении устойчивости модели, предоставляя надежную техническую поддержку для обнаружения поведения коров в сложных сценах.

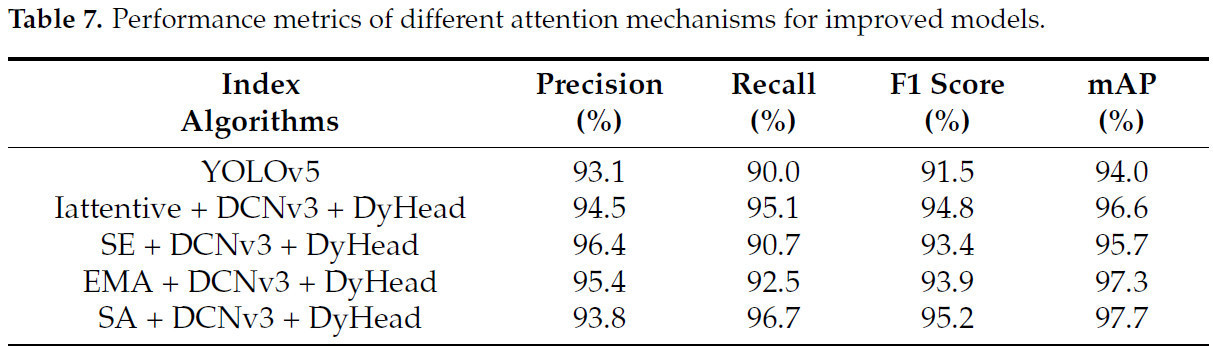

3.2.2. Влияние различных механизмов внимания на производительность улучшенной модели

Результаты экспериментов указывают, что включение механизма внимания дополнительно оптимизирует производительность распознавания модели, с SA, достигающим наилучших результатов. Без механизма внимания, модель достигла значений Точности, Полноты, F1 Score, и Средней Средней Точности (mAP) 94.5%, 95.1%, 94.9%, и 96.6% соответственно. С добавлением механизма внимания Squeeze-and-Excitation (SE), Точность увеличилась до 96.4%, но Полнота уменьшилась до 90.7%, указывая на его сильные стороны в точном обнаружении объектов, но ограничения в полноте объектов. В отличие от этого, механизм Efficient Multi-Scale Attention (EMA) улучшил Полноту до 92.5%, сохраняя высокую Точность 95.4%, демонстрируя его сбалансированное выражение признаков. Однако, с введением SA, производительность модели достигла пика, с Точностью, Полнотой, F1 Score, и mAP, увеличившимися до 93.8%, 96.7%, 95.2%, и 97.7% соответственно. Это значительное улучшение демонстрирует, что SA эффективно усиливает способность модели к распознаванию целей в сложных сценах путем усиления слияния канальных и пространственных признаков. В частности, SA проявляет отличную устойчивость при обработке многомасштабных целей и сложных поведенческих признаков, предоставляя критически важную техническую поддержку для дальнейшей оптимизации модели. В Таблице 7. Показатели производительности улучшенных моделей с различными механизмами внимания представлены метрики производительности улучшенной модели с различными механизмами внимания.

Таблица 7. Показатели производительности улучшенных моделей с различными механизмами внимания

3.3. Результаты распознавания поведения коров на основе улучшенной сети YOLOv5

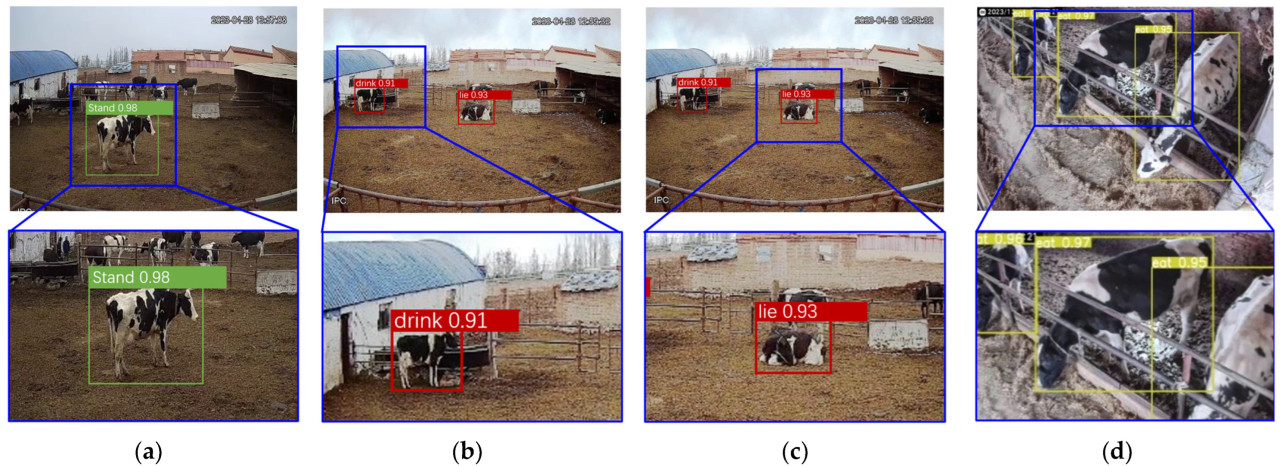

Чтобы оценить производительность улучшенной модели в реальных сценариях, 480 изображений, не включенных в обучающий набор, были выбраны для тестирования. Эти изображения охватывают широкий диапазон поведений коров в различных условиях фермы, обеспечивая всестороннюю и непредвзятую оценку. Результаты обнаружения проиллюстрированы на Рисунке 12. Результаты демонстрируют, что улучшенная модель достигает высокой точности в идентификации различных поведений коров в условиях фермы. Даже при сложных фонах или неоптимальных углах камеры, модель точно обнаруживает поведения коров, подчеркивая ее надежность и адаптивность в практических приложениях.

Рисунок 12. Улучшенный эффект распознавания модели YOLOv5. (a) Поведение стояния у уличных молочных коров; (b) поведение питья у уличных молочных коров; (c) поведение лежания у уличных молочных коров; (d) поведение кормления у внутренних молочных коров.

4. Обсуждение

4.1. Анализ пропущенных и ошибочно диагностированных поведений коров

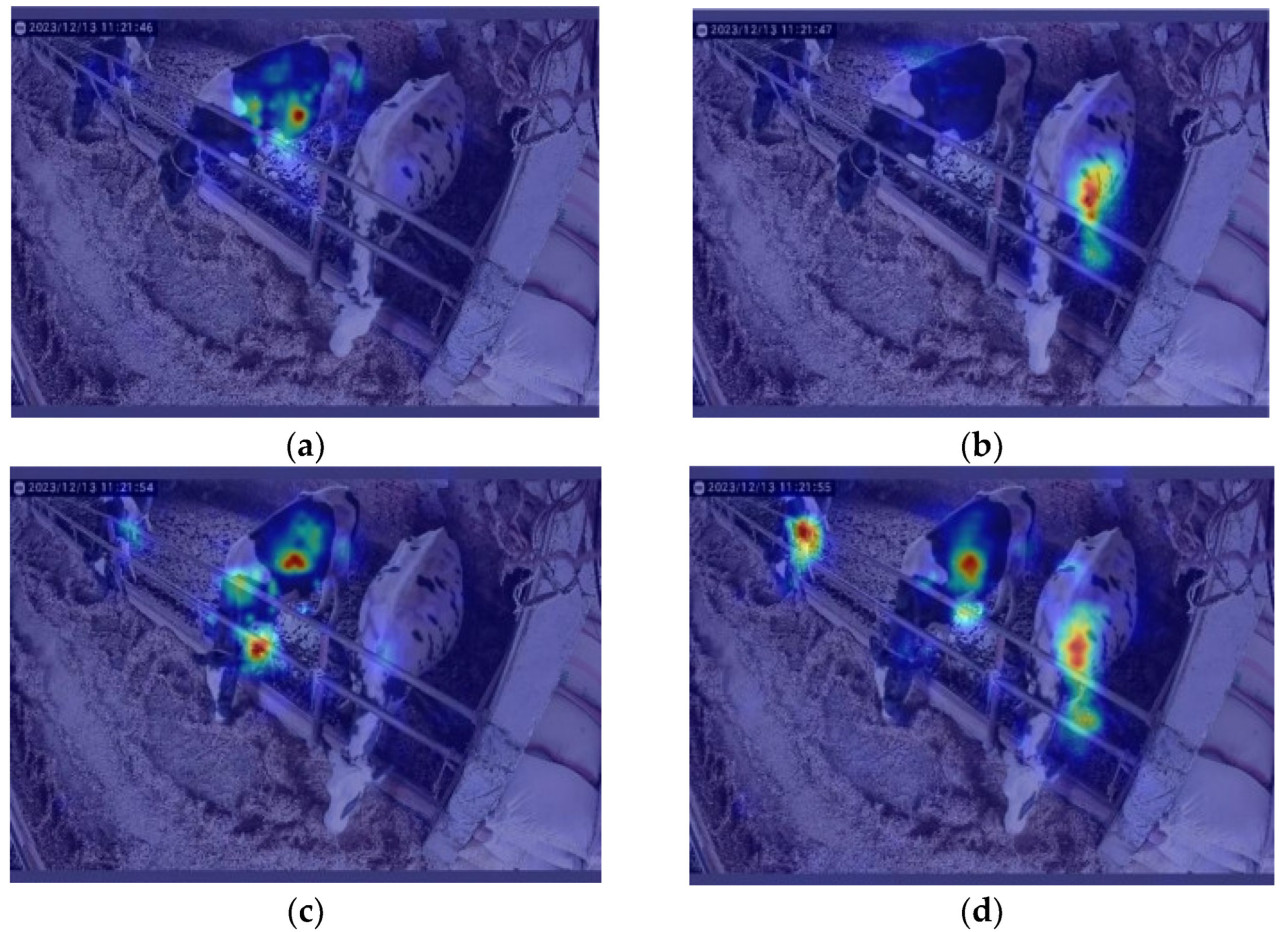

Чтобы лучше понять роль механизмов внимания в обнаружении поведения молочных коров на фермах, технология Градиент-взвешенного картирования активации классов (Gradient-weighted Class Activation Mapping, Grad-CAM) была использована для визуализации областей фокусировки модели при различных механизмах внимания. Grad-CAM - это инструмент визуализации для моделей глубокого обучения, который выделяет ключевые области изображения в процессе принятия решений моделью, помогая анализировать производительность модели в обнаружении поведения в сложных фонах. На Рисунке 13 проиллюстрированы результаты визуализации задач обнаружения поведения для моделей без механизмов внимания и с различными механизмами внимания.

Рисунок 13. Визуальное сравнение исходной модели и модели с вниманием. (a) Без механизма внимания; (b) механизм внимания SE; (c) механизм внимания EMA; (d) механизм внимания SA. Красный указывает на наивысший вес внимания; желтый указывает на средне-высокий вес внимания; зеленый указывает на средний вес внимания; синий указывает на низкий вес внимания; темно-синий указывает на самый низкий вес внимания.

Сравнение результатов показывает, что механизмы внимания значительно усиливают способность модели фокусироваться на ключевых областях поведения коров, особенно в сложных или зашумленных фонах. Как показано на рисунке, модель без механизма внимания проявляет рассеянный фокус при обработке множественных окклюзий целей и неоднозначных областей поведения, что приводит к пропущенным и ложным обнаружениям. Однако модели Squeeze-and-Excitation (SE) и Efficient Multi-Scale Attention (EMA) улучшают извлечение признаков в некоторой степени, усиливая фокус на ключевых областях поведения. SE проявляет отклонение внимания в некоторых сложных сценах, например, ошибочно идентифицируя фоновые области как цели, что приводит к ошибкам обнаружения. EMA, с другой стороны, показывает незначительные упущения в обнаружении динамических поведений (например, прием пищи и питье), вероятно, из-за недостаточной адаптивности к динамическим изменениям поведения.

В отличие от этого, гибридная модель SA продемонстрировала наилучшую производительность через все категории поведения. Ее изображения Grad-CAM показали точное внимание к ключевым областям признаков, уменьшая зависимость от фоновой интерференции и более точно захватывая ключевые признаки поведения коров. Эта производительность позволила SA достичь высокой точности обнаружения и стабильности в многозадачных сложных условиях, эффективно уменьшая случаи пропусков и ошибочных диагнозов и предоставляя более надежную техническую поддержку для обнаружения поведения коров.

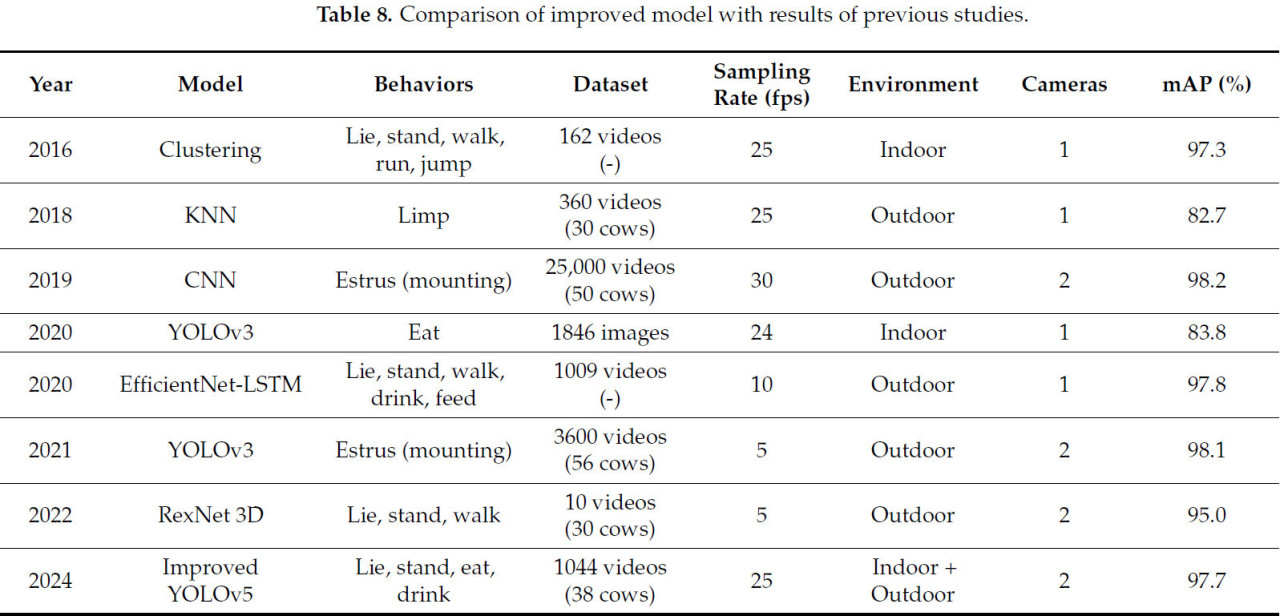

4.2. Сравнение улучшенной модели с результатами предыдущих исследований

Данное исследование интегрирует четыре механизма SA в YOLOv5 для улучшения извлечения признаков мелкомасштабных целей, улучшает точность распознавания множественного поведения через DCNv3 в модуле C3, и заменяет исходную голову обнаружения на DyHead для улучшения эффективности распознавания и точности в сложных условиях и для многомасштабных целей. Таблица 8. Сравнение улучшенной модели с результатами предыдущих исследований обобщает ключевые результаты исследований по распознаванию поведения коров за последние годы и сравнивает их с данным исследованием.

Таблица 8. Сравнение улучшенной модели с результатами предыдущих исследований

Данное исследование демонстрирует явные преимущества в нескольких аспектах. С точки зрения охвата категорий поведения, данное исследование включает четыре поведения: стояние, питье, прием пищи, и лежание, в то время как большинство существующих исследований фокусируются на обнаружении единичного поведения (например, прием пищи или поведение охотничьей садки), ограничивая их применимость к мониторингу множественного поведения в реальных условиях фермы. Что касается масштаба данных, набор данных данного исследования состоит из 1044 видеосегментов, значительно больше, чем 406 сегментов в исследовании на основе RexNet 3D, что существенно усиливает способность модели к обобщению. Дополнительно, Средняя Средняя Точность (mAP) данного исследования достигла 97.7%, демонстрируя отличную производительность распознавания в сложных фонах и сценариях с многомасштабными целями. Однако mAP исследования на основе YOLOv3 по распознаванию поведения коров была только 83.8%, что не может удовлетворить требования сложных реальных сценариев.

В области оптимизации структуры модели, данное исследование включает SA, DCNv3, и DyHead, усиливая возможности обнаружения модели для сложных фонов и многомасштабных целей при сохранении производительности в реальном времени. Данное исследование превосходит исследование на основе EfficientNet-LSTM по точности. В целом, данное исследование не только улучшает точность обнаружения множественных категорий поведения, но и демонстрирует высокую адаптивность в сложных условиях, предлагая эффективное решение для мониторинга поведения коров в реальном времени.

5. Выводы

5.1. Резюме

(1) Предложенная улучшенная модель эффективно решает проблемы сложных фонов и многомасштабных целей путем интеграции трех модулей: SA, DyHead, и DCNv3. Конкретно, SA значительно усиливает фокус модели на областях поведения, комбинируя механизмы внимания каналов и пространственного внимания, в то время как подавляя нерелевантные признаки в сложных фонах. DyHead оптимизирует обнаружение многомасштабных целей путем динамической регулировки весов признаков, особенно усиливая способность различать мелкие цели и те, которые имеют сходные поведенческие признаки. DCNv3 улучшает устойчивость модели в сценах с окклюзиями и сложными формами путем динамической регулировки рецептивного поля и адаптивной выборки областей признаков.

(2) Результаты указывают, что модель, включающая как DCNv3, так и DyHead, показывает наилучшую производительность, достигая увеличения mAP50 на 2.6% и увеличения mAP50-95 на 1.8% по сравнению с исходной моделью. Модель интегрирует DCNv3, DyHead, и механизм внимания для решения этих проблем, улучшая точность и эффективность путем назначения разных весов разным компонентам входа. Результаты демонстрируют, что улучшенная модель, комбинирующая SA, DCNv3, и DyHead, значительно усиливает распознавание многомасштабного поведения коров, достигая увеличения mAP на 3.7% по сравнению с исходной моделью. Результаты распознавания указывают, что улучшенная модель преуспевает в различении и идентификации поведений коров, превосходя точность модели YOLOv5. В тестах с использованием изображений из естественных условий, улучшенная модель продемонстрировала распознавание поведения коров с высокой точностью. Это преимущество значительно усиливает способность модели распознавать множественные поведения коров в реальных сценариях.

5.2. Перспективы

(1) Текущий фокус сосредоточен на оптимизации структуры модели. В дальнейшем работа может быть направлена на дальнейшее улучшение производительности модели на устройствах с пограничными вычислениями и достижение высокой эффективности выполнения путем интеграции передовых техник, таких как обрезка (pruning).

(2) Данное исследование фокусируется на четырех основных поведениях коров: стояние, лежание, питье, и прием пищи. Для комплексной оценки здоровья коров и репродуктивного статуса, будущие исследования должны расшириться, чтобы точно идентифицировать сложные поведения, такие как жевание жвачки, виляние хвостом, и садка, enabling более точные прогнозы здоровья.

Ссылки

1. Cheng, G.; Wu, J.; Xing, L.; Zhu, M.; Zhang, J.; Han, S. Fine-grained cows’ behavior classification method based on IMU. J. China Agric. Univ. 2022, 27, 179–186. [Google Scholar]

2. He, D.; Liu, D.; Zhao, K. Review of Perceiving Animal Information and Behavior in Precision Livestock Farming. Trans. Chin. Soc. Agric. Mach. 2016, 47, 231–244. [Google Scholar]

3. Wang, Z.; Song, H.; Wang, Y.; Hua, Z.; Li, R.; Xu, X. Research progress and technology trend of intelligent morning of dairy cow motion behavior. Smart Agric. 2022, 4, 36–52. [Google Scholar]

4. Wang, X.; Siqinbate; Turigengbaiyila. TURIGEN Baiyila.Research Progress of Dairy Cattle Lying Behavior. Mod. Anim. Husb. 2017, 5, 3–5. [Google Scholar] [CrossRef]

5. Bian, S. Factors affecting the duration of lying rest in dairy cows. Chin. Dairy Cow 2017, 7, 6–9. [Google Scholar] [CrossRef]

6. Teng, G. Information sensing and environment control of precision facility livestock and poultry farming. Smart Agric. 2019, 1, 3. [Google Scholar]

7. Liu, J.; Jiang, B.; He, D.; Song, H. Individual Recognition of Dairy Cattle Based on Gaussian Mixture Model and CNN. Comput. Appl. Softw. 2018, 35, 159–164. [Google Scholar]

8. Yongliang, Q.; He, K.; Cameron, C.; Sabrina, L.; Daobilige, S.; Stuart, E.; Salah, S. Intelligent Perception-Based Cattle Lameness Detection and Behaviour Recognition: A Review. Animals 2021, 11, 3033. [Google Scholar] [CrossRef] [PubMed]

9. Chu, M.; Liu, X.; Zeng, X.; Wang, Y.; Liu, G. Research advances in the automatic detection technology for mastitis of dairy cows. Trans. Chin. Soc. Agric. Eng. 2023, 39, 1–12. [Google Scholar]

10. Zhao, K.; Li, G.; He, D. Fine Segment Method of Cows’Body Parts in Depth Images Based on Machine Learning. Trans. Chin. Soc. Agric. Mach. 2017, 48, 173–179. [Google Scholar]

11. Stygar, A.H.; Gómez, Y.; Berteselli, G.V.; Costa, E.D.; Canali, E.; Niemi, J.K.; Llonch, P.; Pastell, M. A Systematic Review on Commercially Available and Validated Sensor Technologies for Welfare Assessment of Dairy Cattle. Front. Vet. Sci. 2021, 8, 634338. [Google Scholar] [CrossRef] [PubMed]

12. Wang, Z.; Zong, Z.; Wang, H.; Yang, J.; Liu, G.; Du, Y. Research status and development of digital detection methods for cow estrus. China Feed 2021, 1, 134–138. [Google Scholar]

13. Smith, D.; Rahman, A.; Bishop-Hurley, G.J.; Hills, J.; Shahriar, S.; Henry, D.; Rawnsley, R. Behavior classification of cows fitted with motion collars: Decomposing multi-class classification into a set of binary problems. Comput. Electron. Agric. 2016, 131, 40–50. [Google Scholar] [CrossRef]

14. Guo, Y.; He, D.; Chai, L. A Machine Vision-Based Method for Monitoring Scene-Interactive Behaviors of Dairy Calf. Animals 2020, 10, 190. [Google Scholar] [CrossRef]

15. Song, H.; Wu, D.; Yin, X.; Jiang, B.; He, D. Detection of cow breathing behavior based on the Lucas-Kanade sparse optical flow algorithm. Trans. Chin. Soc. Agric. Eng. 2019, 35, 215–224. [Google Scholar]

16. He, D.; Meng, F.; Zhao, K.; Zhang, Z. Basic behavior recognition of calves based on video analysis. Trans. Chin. Soc. Agric. Mach. 2016, 47, 294–300. [Google Scholar]

17. Song, H.; Jiang, B.; Wu, Q.; Li, T.; He, D. A cow lameness detection method based on fitting the slope feature of the straight line to the contour of the head and neck. Trans. Chin. Soc. Agric. Eng. 2018, 34, 190–199. [Google Scholar]

18. Zhang, S.; Tian, J.; Jian, L.; Ji, Z. A method for recognizing fighting behavior in piglets based on inter-frame difference method and single-point multi-frame detector. J. Jiangsu Agric. Sci. 2021, 37, 397–404. [Google Scholar]

19. Mao, Y.; Niu, T.; Wang, P.; Song, H.; He, D. Multi-objective cow mouth tracking and rumination monitoring using Kalman filtering and Hungarian algorithm. Trans. Chin. Soc. Agric. Eng. 2021, 37, 192–201. [Google Scholar]

20. Song, H.; Niu, M.; Ji, C.; Li, Z.; Zhu, Q. Multi-objective cow ruminant behavior monitoring based on video analysis. Trans. Chin. Soc. Agric. Eng. 2018, 34, 211–218. [Google Scholar]

21. Gu, J.; Wang, Z.; Gao, R.; Wu, H. A method for recognizing cow behavior based on fusing images and motion quantities. Trans. Chin. Soc. Agric. Mach. 2017, 48, 145–151. [Google Scholar]

22. Zhenwei, Y.; Yuehua, L.; Sufang, Y.; Ruixue, W.; Zhanhua, S.; Yinfa, Y.; Fade, L.; Zhonghua, W.; Fuyang, T. Automatic Detection Method of Dairy Cow Feeding Behaviour Based on YOLO Improved Model and Edge Computing. Sensors 2022, 22, 3271. [Google Scholar] [CrossRef] [PubMed]

23. Chen, C.; Zhu, W.; Norton, T. Behaviour recognition of pigs and cattle: Journey from computer vision to deep learning. Comput. Electron. Agric. 2021, 187, 106255. [Google Scholar] [CrossRef]

24. Achour, B.; Belkadi, M.; Filali, I.; Laghrouche, M.; Lahdir, M. Image analysis for individual identification and feeding behaviour monitoring of dairy cows based on Convolutional Neural Networks (CNN). Biosyst. Eng. 2020, 198, 31–49. [Google Scholar] [CrossRef]

25. Wang, Z.; Wang, S.; Wang, C.; Zhang, Y.; Zong, Z.; Wang, H.; Su, L.; Du, Y. A Non-Contact Cow Estrus Monitoring Method Based on the Thermal Infrared Images of Cows. Agriculture 2023, 13, 385. [Google Scholar] [CrossRef]

26. Zhang, H.; Wu, J.; Li, Y.; Li, S.; Wang, H.; Song, R. Research on the identification of the feeding behavior of multi-purpose beef cattle. Trans. Chin. Soc. Agric. Mach. 2020, 51, 259–267. [Google Scholar]

27. Liu, Z.; He, D. A method for recognizing the estrus behavior of cows based on convolutional neural networks. Trans. Chin. Soc. Agric. Mach. 2019, 50, 186–193. [Google Scholar]

28. Wang, S.; He, D. Research on the recognition of estrus behavior in dairy cows based on an improved YOLO v3 model. Trans. Chin. Soc. Agric. Mach. 2021, 52, 141–150. [Google Scholar]

29. Yin, X.; Wu, D.; Shang, Y.; Jiang, B. Huaibo SongUsing an EfficientNet-LSTM for the recognition of single Cow’s motion behaviours in a complicated environment. Comput. Electron. Agric. 2020, 177, 105707. [Google Scholar] [CrossRef]

30. Ma, S.; Zhang, Q.; Li, T.; Song, H. Basic motion behavior recognition of single dairy cow based on improved Rexnet 3D network. Comput. Electron. Agric. 2022, 194, 106772. [Google Scholar] [CrossRef]

31. Zhang, Q.-L.; Yang, Y.-B. SA-Net: Shuffle Attention for Deep Convolutional Neural Networks. arXiv 2021, arXiv:2102.00240. [Google Scholar]

32. Wang, G.; Li, H.; Ye, S.; Zhao, H.; Ding, H.; Xie, S. RFWNet: A Multiscale Remote Sensing Forest Wildfire Detection Network With Digital Twinning, Adaptive Spatial Aggregation, and Dynamic Sparse Features. IEEE Trans. Geosci. Remote Sens. 2024, 62, 4708523. [Google Scholar] [CrossRef]

33. Luo, Z.; Wang, C.; Qi, Z.; Luo, C. LA_YOLOv8s: A lightweight-attention YOLOv8s for oil leakage detection in power transformers. Alex. Eng. J. 2024, 92, 82–91. [Google Scholar] [CrossRef]

34. Bai, Q.; Gao, R.; Zhao, C.; Li, Q.; Wang, R.; Li, S. Multi-scale behavior recognition method for dairy cows based on improved YOLOV5s network. Trans. Chin. Soc. Agric. Eng. 2022, 38, 163–172. [Google Scholar]

35. Wang, Z.; Xu, X.; Hua, Z.; Shang, Y.; Duan, Y.; Song, H. Lightweight recognition for the oestrus behavior of dairy cows combining YOLO v5n and channel pruning. Trans. Chin. Soc. Agric. Eng. 2022, 38, 130–140. [Google Scholar]

36. Jannu, C.; Vanambathina, S.D. Shuffle Attention U-Net for Speech Enhancement in Time Domain. Int. J. Image Graph. 2023, 24, 2450043. [Google Scholar] [CrossRef]

Zong Z, Ban Z, Wang C, Wang S, Yuan W, Zhang C, Su L, Yuan Z. A Study on Multi-Scale Behavior Recognition of Dairy Cows in Complex Background Based on Improved YOLOv5. Agriculture. 2025; 15(2):213. https://doi.org/10.3390/agriculture15020213

Перевод статьи «A Study on Multi-Scale Behavior Recognition of Dairy Cows in Complex Background Based on Improved YOLOv5» авторов Zong Z, Ban Z, Wang C, Wang S, Yuan W, Zhang C, Su L, Yuan Z., оригинал доступен по ссылке. Лицензия: CC BY. Изменения: переведено на русский язык

Комментарии (0)