Не пропустить болезнь: новая архитектура нейросети для ранней и точной диагностики на устройствах с малой вычислительной мощностью

Сельское хозяйство является краеугольным камнем экономического процветания, однако болезни растений могут серьезно повлиять на урожайность и качество культур. Точное определение этих заболеваний часто затруднено из-за ограниченной доступности экспертов и неоднозначности информации. Системы раннего обнаружения и автоматизированной диагностики имеют решающее значение для смягчения этих проблем. Для решения этой задачи мы предлагаем легкую сверточную нейронную сеть (CNN), разработанную для устройств с ограниченными ресурсами, получившую название LeafNet.

Аннотация

LeafNet черпает вдохновение в послойной архитектуре VGG19, но включает несколько оптимизаций, включая уменьшенное количество параметров, меньший размер входных данных и более быстрое время вывода, сохраняя при этом конкурентоспособную точность. Предлагаемая LeafNet использует небольшие однородные сверточные фильтры для захвата мелкозернистых деталей признаков болезней растений, с увеличением количества каналов для улучшения извлечения признаков. Кроме того, она интегрирует механизмы внимания к каналам для эффективного определения приоритетности признаков, связанных с заболеваниями. Мы оценили предлагаемый метод на четырех наборах данных: эталонный PlantVillage (PV), репозиторий данных изображений листьев (DRLIs), новый специально созданный составной набор данных по растениям (PC) и набор данных BARI Sunflower (BARI-Sun), который включает разнообразные и сложные изображения из реального мира. Результаты показывают, что предложенный метод работает на уровне современных методов с точки зрения точности, частоты ложных срабатываний (FPR), размера модели и времени выполнения, что подчеркивает его потенциал для реальных приложений.

1. Введение

В последнее время сельское хозяйство стало основным источником средств к существованию для многих стран и играет жизненно важную роль в глобальной экономике. Согласно данным Всемирного банка [1], в 2018 году в сельском хозяйстве было занято более миллиарда человек, что составляет 28,5% от общей рабочей силы, и производилось примерно 10 миллионов тонн продовольствия ежедневно. Однако инфекции и болезни растений угрожают потенциалу сельского хозяйства, ставя под угрозу продовольственную безопасность. Патогены растений могут наносить значительные потери основным продовольственным культурам, таким как пшеница, рис, соевые бобы, кукуруза и картофель, которые могут составлять от 10% до 40% [2]. Может быть неэффективным и затратным по времени постоянно проверять признаки заболеваний для решения этих проблем, особенно на больших полях. Точное земледелие зависит от эффективного обнаружения инфекций растений. В результате исследовательские группы обратились к ML, чтобы использовать его потенциал для автоматического обнаружения болезней растений с помощью анализа изображений, полученных в полевых условиях. Эти исследователи анализируют эти изображения для извлечения значимых признаков. Например, в исследовании [3] классификация болезней листьев гуавы была выполнена с применением метода опорных векторов (SVM) после того, как характеристики изображения были извлечены с использованием масштабно-инвариантного преобразования признаков (SIFT). В другом подходе, перед использованием SVM, авторы работы [4] использовали матрицу совстречаемости уровней серого (GLCM) вместо SIFT. Другие исследования анализировали болезни растений с использованием различных методов извлечения признаков с значительными результатами [5,6,7,8].

Для сложных структур данных и больших наборов данных для обучения несколько исследователей предпочли использовать классификатор k-ближайших соседей (K-NN), а не метод опорных векторов (SVM). Например, локальные статистические входные характеристики были использованы для классификации болезни Cotton Grey Mildew с использованием K-NN [9]. Он также использовался для классификации болезней листьев риса и арахиса [10,11]. Однако все эти подходы требуют нескольких этапов для подготовки данных, предварительной обработки и извлечения признаков. Дополнительно, их эффективность в управлении многоклассовой категоризацией данных остается недоказанной, и они проявляют чувствительность к предопределенным параметрам, таким как параметры ядра 'k' в SVM и 'f' в K-NN [12]. Некоторые исследователи прибегли к подходам глубокого обучения (DL), чтобы преодолеть эти проблемы и улучшить идентификацию сельскохозяйственных заболеваний и инфекций. Система на основе DL под названием PV, например, была создана в [13] и способна точно идентифицировать 26 различных болезней растений. В отличие от методов явного извлечения признаков, алгоритмы DL автоматически распознают и извлекают релевантные свойства из входных фотографий. Однако, чтобы классифицировать 2D-изображения в 1D-векторы, традиционные классификаторы на основе искусственных нейронных сетей (ANN) теряют пространственную информацию, что повышает вычислительные и потребности в хранении. В другом исследовании авторы [14] представили методологию классификации болезней растений на основе нового набора данных под названием DRLI.

Было показано, что нейронные сети, в частности CNN, очень эффективны в устранении ограничений глубоких нейронных сетей (DNN) в сельском хозяйстве [15]. Например, модель MaskRCNN с трансферным обучением была использована в [16] для обнаружения фузариозного колоса у пшеницы. На тестовом наборе данных из примерно 450 фотографий их метод дал среднюю точность 92,01%. Аналогичная методология была использована в [17] для идентификации болезней листьев яблони. Они достигли точности распознавания 77,65%, 75,59% и 73,50% с использованием моделей ResNet152, Inception V3 и MobileNet соответственно. В [18] также разработали пользовательскую глубокую CNN с использованием набора данных PV для классификации инфекций огурца. Их модель достигла впечатляющей точности до 94%, используя предварительно обученную модель AlexNet. Другой пример — разработка модели Custom-Net в [19] с использованием Raspberry Pi (RPi) для классификации болезней жемчужного проса с ошеломляющей точностью 98,78%. Модели DL, которые часто используют набор данных PV, также широко применялись для идентификации различных болезней листьев. Эти подходы достигли высокой точности классификации, особенно когда речь идет об инфекции листа томата (точность 97,49%) [20] и болезнях листьев банана (точность 99,72%) [21].

Для помощи фермерам в решении проблем, включая нехватку воды, дисбаланс питательных веществ, болезни, сорняки и вредителей, модели искусственного интеллекта (AI) и подходы машинного обучения (ML) развертываются на дронах. Поскольку они являются быстрыми, доступными по цене и совместимыми с AI, дроны широко используются в точном земледелии [22]. В настоящее время выявлены и подчеркнуты следующие пробелы в исследованиях:

• Пригодность для среды IoT: Большинство существующих моделей, включая CNN и механизмы внимания, слишком ресурсоемки для устройств IoT, которые имеют ограниченную вычислительную мощность и память.

• Вычислительные ограничения и ограничения памяти: Текущие модели не учитывают серьезные ограничения в вычислительных ресурсах, энергопотреблении и емкости памяти, типичные для устройств IoT, что делает их непрактичными для развертывания в таких средах.

• Необходимость в облегченных моделях: Существует явная необходимость в разработке облегченных моделей, которые могут работать эффективно в условиях ограничений устройств IoT. Существующие решения не соответствуют этим требованиям, ограничивая их применимость в реальном мире.

Для решения этих проблем и исследовательских пробелов наша работа внесла следующие значительные вклады:

1. Мы разработали LeafNet, облегченную DL-модель, оптимизированную для работы на устройствах с ограниченными ресурсами (RCD), эффективно решающую проблему ограниченной вычислительной мощности реальных устройств IoT. Используя меньше параметров, LeafNet достигает более высокой точности по сравнению с другими облегченными сетями, такими как EfficientNetB0, MobileNetV1 и MobileNetV3Small. Примечательно, что LeafNet требует на 3,29 миллиона и 1,76 миллиона меньше параметров, чем MobileNetV1 и MobileNetV3Small, соответственно. Это сокращение повышает ее вычислительную эффективность, делая ее особенно хорошо подходящей для развертывания на устройствах с ограниченными вычислительными ресурсами. Для обеспечения воспроизводимости и содействия дальнейшим исследованиям исходный код находится в открытом доступе по адресу: (https://github.com/sanaparez/LeafNet) (дата обращения: 5 января 2024 г.).

2. Мы оценили нашу облегченную DL-модель, используя четыре набора данных для обнаружения болезней растений: PV, DRLI, наш собственный набор данных PC и набор данных BARI-Sun. Для сравнения ее производительности мы сравнили ее с несколькими современными (SOTA) моделями, включая VGG19 [23], VGG16 [23], EfficientNetB0 [24], MobileNetV1 [25], MobileNetV3Small [26], ResNet50 [27], ResNet152 [27], ViT-B/32 [28], MobileViT-S [29] и MobileOne-S0 [30]. LeafNet превзошел все эти современные модели с точки зрения точности, частоты ложных тревог (FAR) и вычислительной эффективности, продемонстрировав свое превосходство для обнаружения болезней растений.

3. Мы интегрировали модуль Внимания к Каналам (CA) для уточнения и улучшения промежуточного извлечения признаков, что значительно улучшило производительность модели за счет тонкой настройки наиболее релевантных характеристик. Эффективно извлекая признаки, LeafNet способен напрямую категоризировать входные изображения в отдельные группы без необходимости промежуточных процессов. Мы провели всестороннюю оценку LeafNet, учитывая такие факторы, как вычислительные требования, размер модели и время обучения. Результаты подчеркивают пригодность LeafNet для развертывания на устройствах с ограниченными вычислительными ресурсами, демонстрируя его эффективность и практичность.

Ниже представлены дальнейшие разделы этой статьи: Раздел 2 содержит предыдущие релевантные материалы. Методология, в которой излагаются основные процедуры и методы, используемые в этом исследовании, предоставлена в Разделе 3. Краткий обзор экспериментальных результатов, полученных из используемых наборов данных, приведен в Разделе 4. Исследование завершается Разделом 5, в котором суммируются ключевые результаты, вклады и предлагаемые направления будущих исследований.

2. Связанные работы

С акцентом на несколько моделей CNN, предложенных различными исследователями, в этом разделе рассматриваются предыдущие попытки, относящиеся к проблеме классификации болезней растений. Для обнаружения болезней у растений томата, картофеля и кукурузы, в [31] был представлен метод, сочетающий модуль Inception и остаточные связи. Они также предложили онлайн-платформу для обнаружения болезней в режиме реального времени. Используя набор данных из 10 851 полевых фотографий, модель CNN на основе внимания и плотных слоев смогла идентифицировать 44 различные категории болезней растений с точностью 97,33% [32]. CNN-подход на основе сверточного автоэнкодера был представлен в [33], который достиг точности 98,38% в классификации болезни Bacterial Spot у растений персика. В [34] предложили модифицированную версию модели CNN для идентификации болезней у пятнадцати различных растений. В [35] представили модель InceptionResNet, которая была направлена на категоризацию 15 различных форм болезней растений. В [36] представили концепцию EfficientNet, и 39 различных нарушений были обнаружены в наборе данных PV. Объединение характеристик из глубоких CNN-моделей EfficientNetB01 и DenseNet121 позволило авторам достичь точности 98,56% в диагностике болезней листьев кукурузы [37]. В другом исследовании авторы использовали предварительно обученную сеть Vision Transformer для идентификации болезней в наборе данных PV [38].

Работы, которые попадают в категорию прочих и предлагаются для классификации болезней растений различными исследователями, описаны ниже: Генеративно-состязательные сети были использованы в [39] для создания искусственных изображений больных листьев растений томата. Дополнительно, они достигли точности классификации 97,11%, применив модель DenseNet121 для классификации пяти различных типов болезней растений картофеля. Используя наборы данных Apple, Maize и Rice, в [40] достигли средней точности более 93% в классификации болезней растений с использованием архитектуры Vision Transformer (ViT). Метод глубокой CNN с механизмом внимания был представлен в [41] для классификации болезней листьев томата. При тестировании на 24 001 фотографиях их модель успешно идентифицировала 98% случаев. В другом исследовании [42] авторы предложили DFN-PSAN, который включает YOLOv5 в качестве экстрактора признаков и использует пирамидальное сжатое внимание (PSA) в сочетании с несколькими сверточными слоями для проектирования PSAN, который достигает точности 95,27% на наборе данных PV. Архитектуру учитель/ученик для распознавания 14 различных болезней растений предложили в [43].

Большинство описанных ранее усилий полагаются на методы свертки или внимания в архитектуре CNN. К сожалению, из-за ограничений памяти и вычислительной мощности эти модели не подходят для сценариев Интернета вещей (IoT). Ограниченная вычислительная мощность, память и ресурсы — это лишь некоторые из проблем, с которыми сталкивается IoT [44]. Предлагаемая работа предлагает облегченный, не сверточный метод с механизмом внимания, который решает эти проблемы и идеально подходит для реализации IoT. Предлагаемая модель использует многоуровневый мета-ансамблевый метод, в котором модель второго уровня обучается с использованием характеристик, полученных из вероятностей предсказания моделей, обученных на первом уровне. Классификационная производительность предлагаемого решения улучшается за счет использования мета-ансамблевого подхода.

3. Предлагаемая методология

В этом разделе дается техническое объяснение для каждого модуля предлагаемой модели. Предлагаемая архитектура LeafNet основана на модифицированной архитектуре VGG19, которая имеет точность Top-1 и Top-5 71,3% и 90,0% на эталонном наборе данных ImageNet, соответственно. Из-за архитектуры с высокой производительностью мы выбрали VGG19 и дополнительно модифицировали исходную архитектуру для поставленной задачи. Дополнительно, внимание к каналам было совмещено с базовым экстрактором признаков для дальнейшего улучшения выбора оптимальных характеристик. Предлагаемый метод оценивается на четырех общедоступных эталонных наборах данных. Дополнительные детали приведены в последующих разделах.

3.1. Архитектура LeafNet

CNN широко используются для мониторинга сложных задач видеонаблюдения, включая идентификацию объектов, категоризацию, обнаружение аномалий, а также распознавание активности и действий, а также различные приложения в идентификации, медицинской диагностике изображений, суммаризации видео и сегментации. Сверточный слой (CL), слои пулинга и полностью связанный слой составляют три основные части архитектуры CNN. Глубокая CNN состоит из одного входного слоя и нескольких скрытых слоев, полностью связанных слоев и слоев softmax. Для создания карт признаков из глубоких CNN используются такие параметры, как локальные рецептивные поля и различные ядра, чтобы выделить важные особенности объектов на изображениях. Для уменьшения размерности эти карты признаков уменьшаются путем субдискретизации с использованием усредняющего, минимального или максимального пулинга.

Выбор правильной архитектуры CNN для конкретного приложения — сложная задача, которая требует балансировки между необходимостью получения хороших результатов и вычислительной эффективностью. Каждая архитектура CNN имеет свой собственный набор сильных и слабых сторон. Конструкции VGG19 и AlexNet, например, довольно просты в проектировании и реализации. Стандарт в DL, AlexNet дебютировал в соревновании ImageNet. Считается, что производительность часто улучшается за счет увеличения количества CL в сети, как иллюстрирует модель VGG. Исследования предлагают VGG19, 19-слойную архитектуру, как надежный экстрактор признаков, который может обрабатывать большие наборы данных и сложные задачи идентификации фона. В задачах классификации эта конструкция значительно превосходит предыдущую, сохраняя при этом тот же размер фильтра.

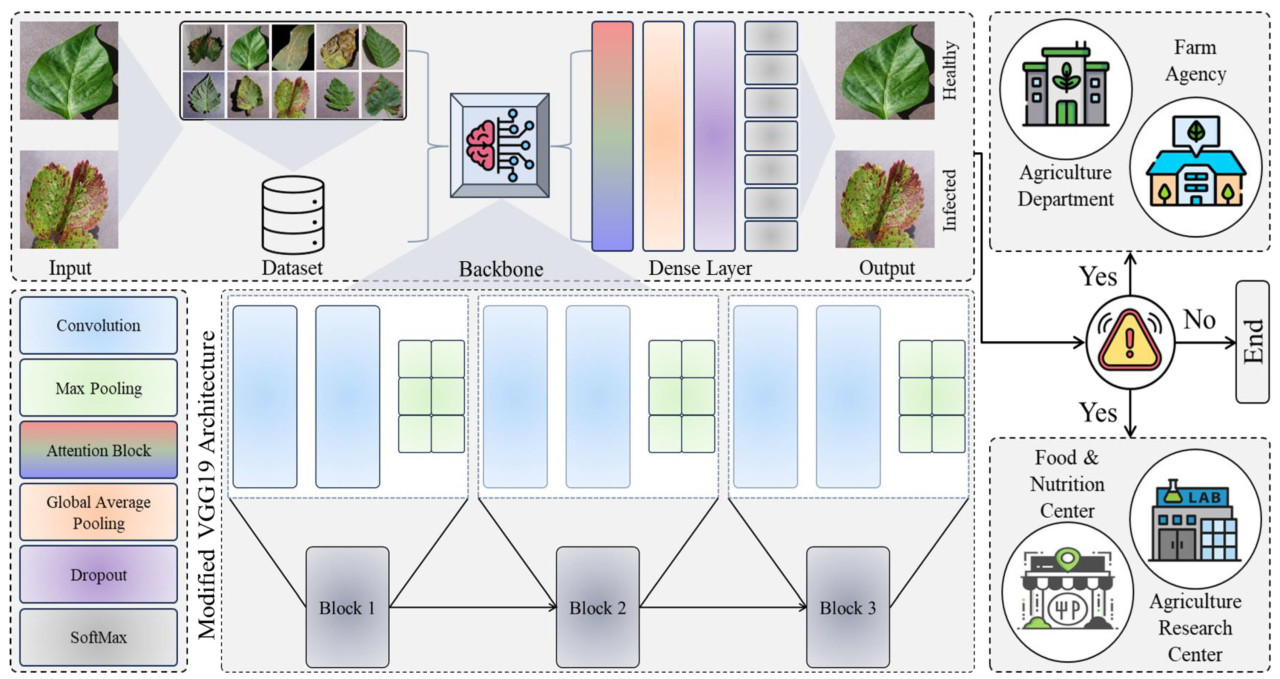

С точки зрения общего размера и параметров обучения, VGG19 и VGG16 не являются ресурсоэффективными, несмотря на их многочисленные преимущества. С EfficientNetB0 и MobileNetV1, специально созданными для быстрого времени вывода, эти архитектуры, а также MobileNetV3Small, MobileViT-S и MobileOne-S0 гораздо менее затратны и более надежны, чем другие. В этой статье предлагается эффективная модель обнаружения и классификации болезней растений, называемая LeafNet, принимая во внимание затраты на обработку ресурсов, реализацию в реальном мире и недостатки существующих облегченных моделей. На Рисунке 1 показана предлагаемая структура.

Рисунок 1. Предлагаемая оптимизированная LeafNet для эффективного обнаружения болезней растений.

Изначально мы оценили производительность известных предварительно обученных архитектур CNN, таких как VGG19, VGG16, EfficientNetB0, MobileNetV1, MobileNetV3Small, ResNet50, ResNet152, ViT-B/32, MobileViT-S и MobileOne-S0, прежде чем разработать нашу новую структуру. Это исследование особенно фокусируется на успешном извлечении зараженных пятен с использованием визуально воспринимаемых данных. Для улучшения распознавания областей заболевания мы использовали уменьшенную версию захваченного изображения, в отличие от предыдущих CNN. Мы также удалили Block-4, Block-5 и Block-6 модели VGG19, чтобы уменьшить количество параметров и время обучения. Несмотря на меньшее количество параметров, модель достигла более высокой точности по сравнению с другими современными моделями и предлагала более высокий показатель кадров в секунду (FPS). Дополнительно, подход использует меньший размер входа для захвата мельчайших деталей, позволяя классификатору изучать более отличительные признаки.

С тремя каналами и 32 различными фильтрами красного, зеленого и синего (RGB) цветов, размер входного изображения для предлагаемой модели составляет 128 × 128. Глубокое извлечение признаков достигается за счет постепенного увеличения масштаба каждого фильтра в каждом блоке. Размеры фильтров для первого, второго и третьего блоков установлены на 64, 128 и 256 соответственно. Каждый слой предлагаемой модели применяет линейную функцию, называемую выпрямленной линейной активацией (ReLU), которая выводит прямое значение, если вход положительный, и ноль в противном случае. Вход из третьего блока затем передается в слои пулинга, где применяется глобальный усредняющий пулинг (GAP), прежде чем быть переданным на слой Softmax. Этот слой категоризирует выходные данные на два класса: здоровые и зараженные.

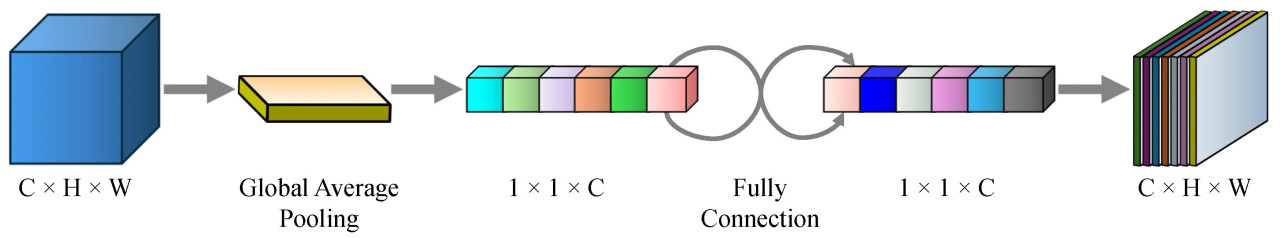

3.2. Механизм внимания к каналам

Мы используем модуль внимания к каналам для повторной калибровки признаков, чтобы эффективно выбирать характеристики, которые существенно вносят вклад в конечный результат. Модуль внимания к каналам состоит из двух полностью связанных слоев, операции умножения и операции глобального усредняющего пулинга (GAP), как показано на Рисунке 2.

Рисунок 2. Два полностью связанных слоя, операция умножения и GAP составляют модуль внимания к каналам. Этот модуль способен повторно калибровать входные карты признаков.

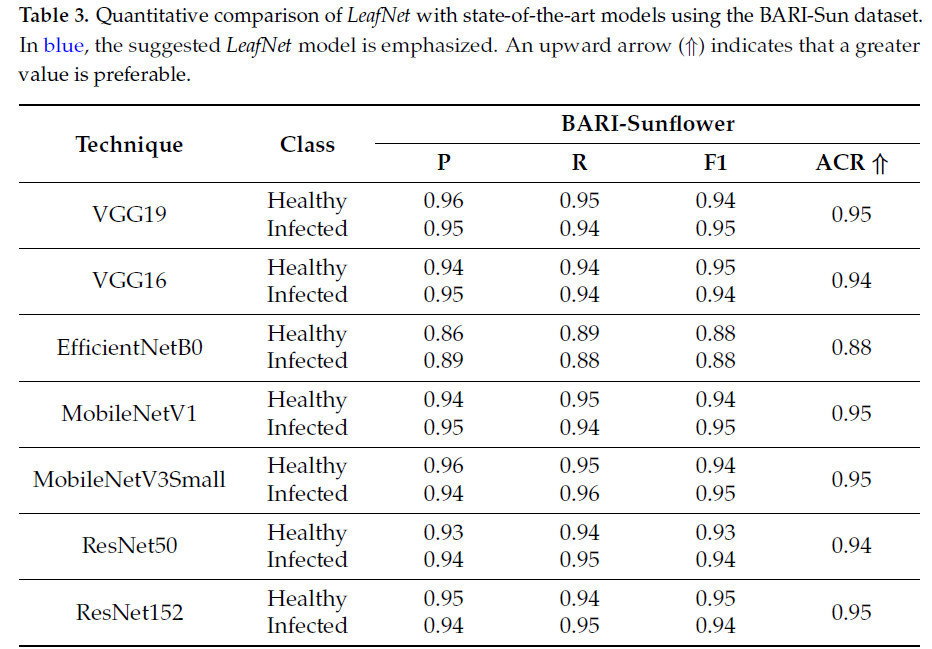

Для каждого 𝑖, 𝑗 и c в c-й карте признаков, где 𝑖∈[0,𝐻−1], 𝑗∈[0,𝑊−1] и 𝑐∈[0,𝐶−1], пусть 𝑢𝑐(𝑖,𝑗) представляет интенсивность признака (значение активации) в пространственном местоположении (𝑖,𝑗) в c-м канале входной карты признаков. Чтобы сжать карту признаков 𝑢𝑐 в вектор вдоль пространственного измерения (размера 1×1×𝐶), применяется GAP, который вычисляет среднее значение пространственных активаций. Полученный вектор захватывает глобальное рецептивное поле входных карт признаков и определяется как:

Здесь 𝑧𝑐 обозначает выходной вектор для канала c, а 𝐺(·) представляет операцию глобального усредняющего пулинга. Затем вектор 𝑧𝑐 пропускается через два сложенных полностью связанных слоя для генерации обучаемых параметров.

Процесс получения обучаемых параметров 𝑠𝑐 иллюстрируется Уравнением (2):

Здесь 𝑤1 и 𝑤2 обозначают матрицы весов, 𝛿 представляет функцию активации ReLU, 𝜎 — функцию активации сигмоиды, а операция свертки обозначается символом “⊗”.

Повторная калибровка исходных признаков достигается путем применения поэлементного умножения по каналам. Конкретно, взвешенная комбинация исходных признаков 𝑢𝑖 и обучаемых параметров 𝑠𝑐 дает итоговый выходной признак для каждого канала. Этот процесс выражается как:

4. Экспериментальные результаты и обсуждение

Метрики и процедуры для оценок рассматриваются в этом разделе. Мы сначала описываем экспериментальный план и ключевые показатели производительности, а затем обсуждаем результаты оценки. Чтобы сохранить ранее изученную информацию, все модели, включая наш предлагаемый LeafNet, обучались с небольшой скоростью обучения в течение всего 10 эпох. С целью максимизации производительности на целевом наборе данных предварительно обученная модель постоянно модифицировала свои параметры.

4.1. Детали реализации

Вновь разработанная модель LeafNet использует размер входа 128 × 128 и размер пакета 32, тогда как каждая модель была переобучена с использованием ее стандартного размера входа 224 × 224 после получения первых результатов. Скорость обучения 1 × 10^(-4) и момент 0,9 использовались для оптимизатора Adam. Видеокарта NVIDIA GeForce RTX 3090 с 24 ГБ встроенной памяти и 64 ГБ оперативной памяти была использована в этом исследовании. Эта видеокарта достигает максимум 36 Терафлопс (операций с плавающей запятой в секунду). Мы использовали TensorFlow 2.9.1 в качестве бэкенда и фреймворк глубокого обучения Keras [45] для экспериментов. Несколько стандартных метрик производительности, таких как точность, F1-мера, точность (precision) и полнота (recall), использовались для оценки предлагаемой модели LeafNet.

4.2. Наборы данных

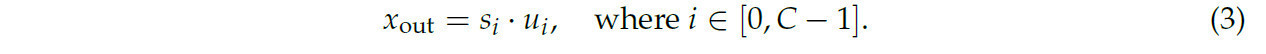

В исследовании использовались PV и DRLI, два широко используемых стандартных набора данных, чтобы оценить эффективность предложенной модели. Дополнительно, новый набор данных под названием PC, который был создан путем объединения двух наборов данных, использовался для оценки надежности теории. Хотя подробная информация приведена ниже, детали объединенного набора данных показаны в Таблице 1.

Таблица 1. Количество образцов для здоровых и зараженных категорий в используемых наборах данных.

1. Набор данных PV — это обширная и сложная коллекция данных, охватывающая 14 различных видов растений и включающая в общей сложности 38 уникальных классов. Среди этих классов двадцать шесть посвящены изображению зараженных растений, а остальные 12 изображают здоровые. С точки зрения объема этот набор данных содержит существенные 54 305 изображений, из которых 15 084 представляют классы здоровых растений и значительные 39 221 показывают классы зараженных растений. Стоит отметить, что этот разнообразный набор данных содержит изображения различных типов растений, включая томаты, клубнику, виноград и апельсины.

2. Набор данных DRLI состоит из дюжины различных типов растений, т.е. джамун, базилик, гранат, ятрофа, лимон, астония, арджун, баел, гуава, манго и сколарис. Исследователи фотографировали листочки как в здоровом, так и в зараженном состоянии, классифицируя их как «здоровые» или «зараженные». Набор данных содержит около 4503 изображений, из которых 2278 представляют здоровые листья и 2225 показывают больные листья. Для удобства исследователей набор данных был разделен на двадцать две предметные группы, каждая из которых соответствует определенному виду растений.

3. Набор данных PC: Авторы объединили два общедоступных набора данных, PV и DRLI, чтобы провести эксперимент по оценке надежности предлагаемой модели LeafNet. В результате этого слияния был создан новый и более разнообразный набор данных, что увеличило сложность задачи для модели. Всего 58 807 изображений, этот составной набор данных на 7,6% больше, чем PV, и значительно больше, чем набор данных DRLI, т.е. на 92,3%. Модель должна была пройти тщательную процедуру обучения из-за большего набора данных и включения большего разнообразия видов растений. В результате модель продемонстрировала лучшие способности к обобщению и повышенную надежность для сценариев, связанных с идентификацией болезней растений в реальном времени, предоставляя бесценное визуальное пособие.

4. Набор данных BARI-Sun был создан с использованием изображений, собранных с демонстрационной фермы Бангладешского научно-исследовательского института сельского хозяйства (BARI) в Газнипуре. Этот набор данных изначально состоял из 467 исходных изображений, содержащих как здоровые листья и цветы подсолнечника, так и пораженные болезнями [46]. Чтобы удовлетворить потребность в большем наборе данных, который необходим для обучения моделей DL, были применены методы аугментации данных. Пространственные аугментации включали случайное вращение, масштабирование, кадрирование, сдвиг, а также добавление шума и размытие. Для улучшения цвета были отрегулированы яркость, контрастность, насыщенность и оттенок изображений. После аугментации набор данных расширился и стал включать 470 образцов ложной мучнистой росы (Downy mildew), 509 образцов листовых рубцов (Leaf scars), 398 образцов серой гнили (Gray mold) и 515 образцов свежих (здоровых) листьев. Все изображения были изменены до размера 512 × 512 пикселей и сохранены в формате JPG.

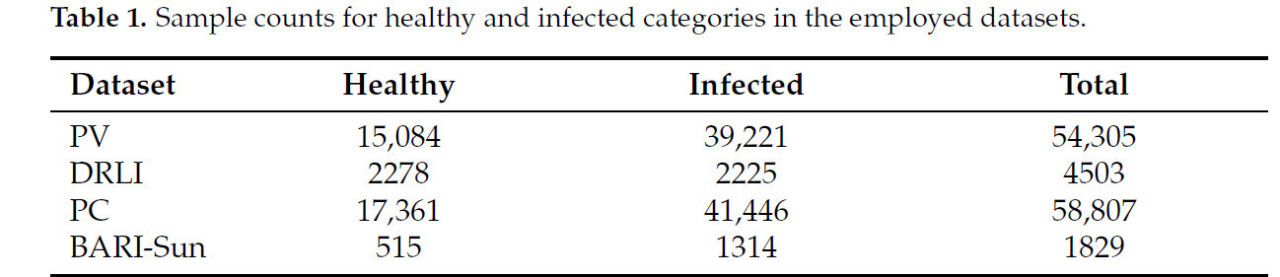

4.3. Метрики оценки

Ряд критериев оценки, включая точность (accuracy), точность (precision), полноту (recall) и F1-меру, использовались для оценки предлагаемой модели LeafNet.

4.4. Количественные результаты

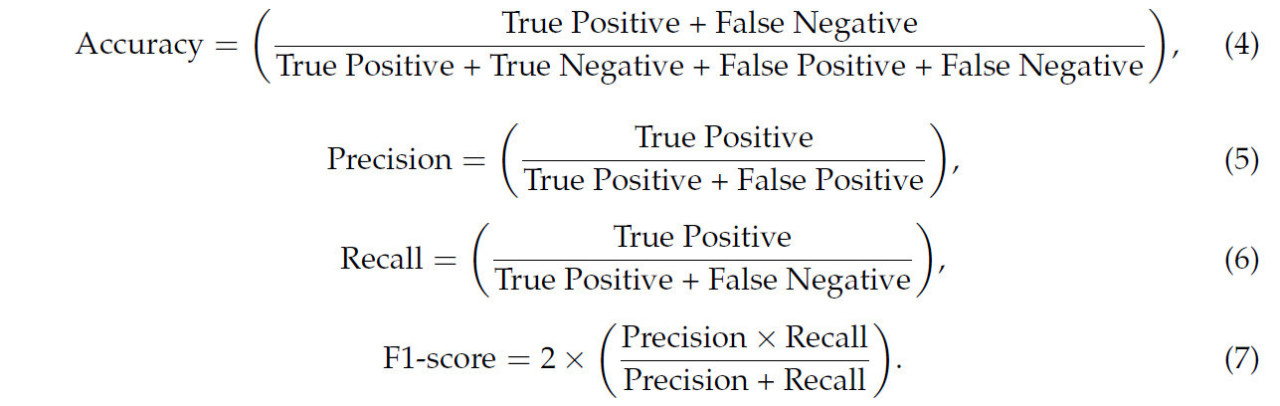

Чтобы идентифицировать болезни растений, это исследование сравнило ряд предварительно обученных CNN-архитектур с LeafNet. Точность (accuracy), точность (precision), полнота (recall), F1-мера и количество обучаемых параметров были основными критериями оценки во время сравнения производительности. Большинство исследуемых моделей, включая ViT-B/32, EfficientNetB0, MobileNetV1, MobileNetV3Small, ResNet50, ResNet152, VGG19, VGG16, а также MobileViT-S и MobileOne-S, показали сопоставимые результаты. Напротив, предлагаемая модель LeafNet продемонстрировала самую низкую FAR по сравнению с другими современными моделями и достигла превосходной точности 99%, 98%, 99% и 96% на всех четырех наборах данных. Тем не менее, ViT-B/32 показал наихудшие результаты по сравнению с другими моделями. Интересно, что предлагаемый LeafNet превзошел все доступные наборы данных и показал низкую FAR по сравнению с MobileNetV1, несмотря на то, что обе модели показали почти одинаковую вычислительную эффективность. Таблица 2 и Таблица 3 предоставляют тщательное сравнение производительности используемых моделей. Очевидно, что обученные модели хорошо работают с небольшим FAR. Тем не менее, есть возможности для улучшения, поскольку FAR все еще высок. Поэтому, с акцентом на точность и сокращение ложных предсказаний, это исследование исследует предварительное обучение и оптимизацию архитектуры CNN, а именно LeafNet. С наиболее точным обнаружением среди других моделей, LeafNet показывает лучшие результаты после тонкой настройки.

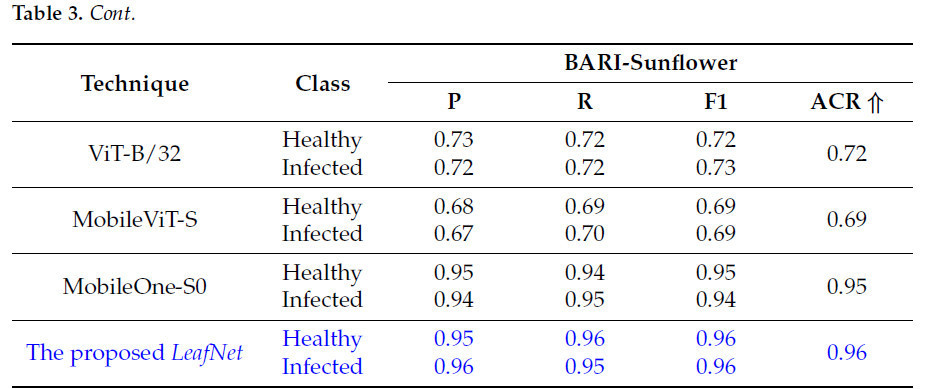

Таблица 2. Количественное сравнение LeafNet с современными моделями с использованием предоставленных наборов данных. Синим цветом выделена предлагаемая модель LeafNet. Стрелка вверх (⇑) указывает, что большее значение предпочтительнее.

Таблица 3. Количественное сравнение LeafNet с современными моделями с использованием набора данных BARI-Sun. Синим цветом выделена предлагаемая модель LeafNet. Стрелка вверх (⇑) указывает, что большее значение предпочтительнее.

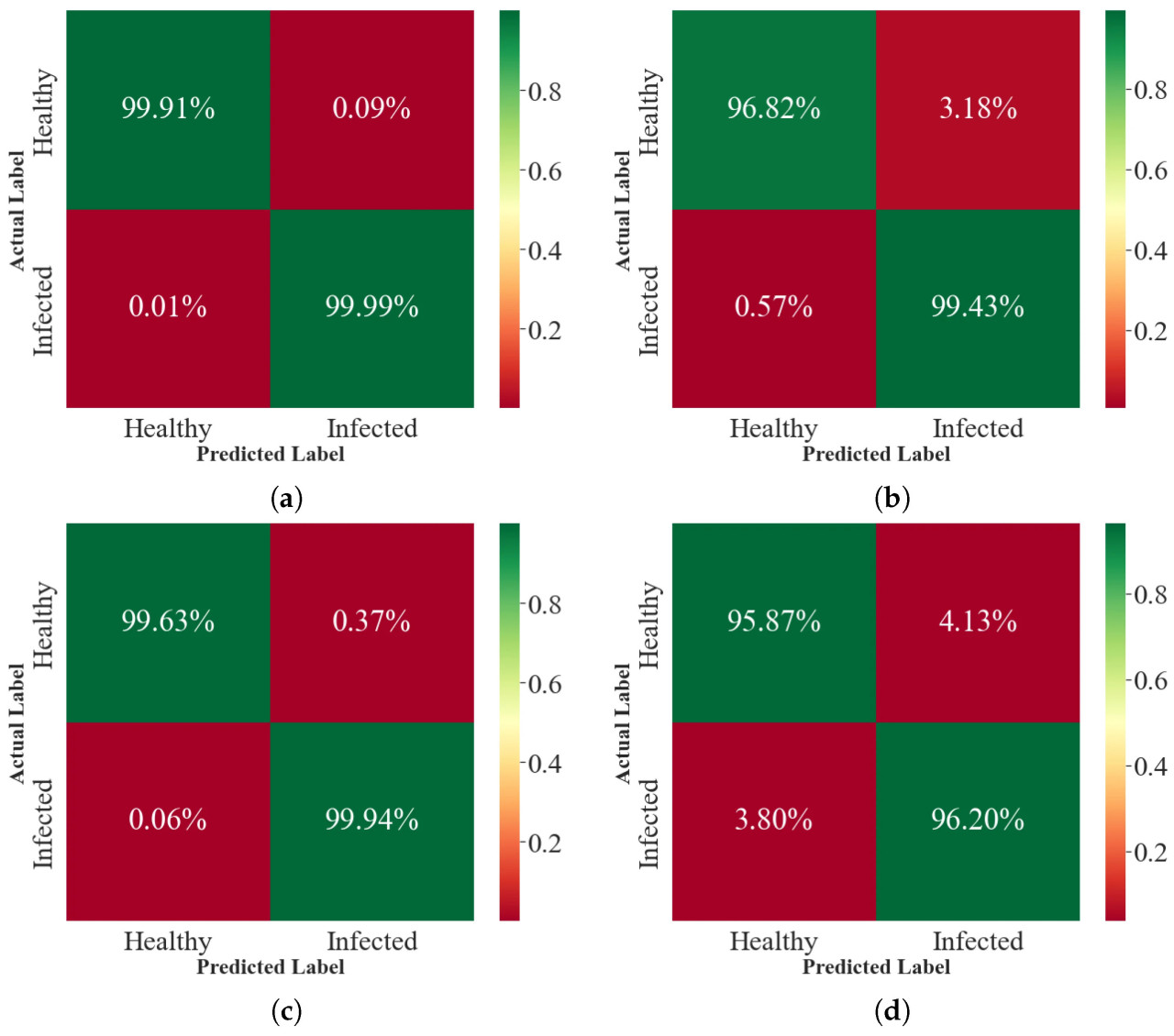

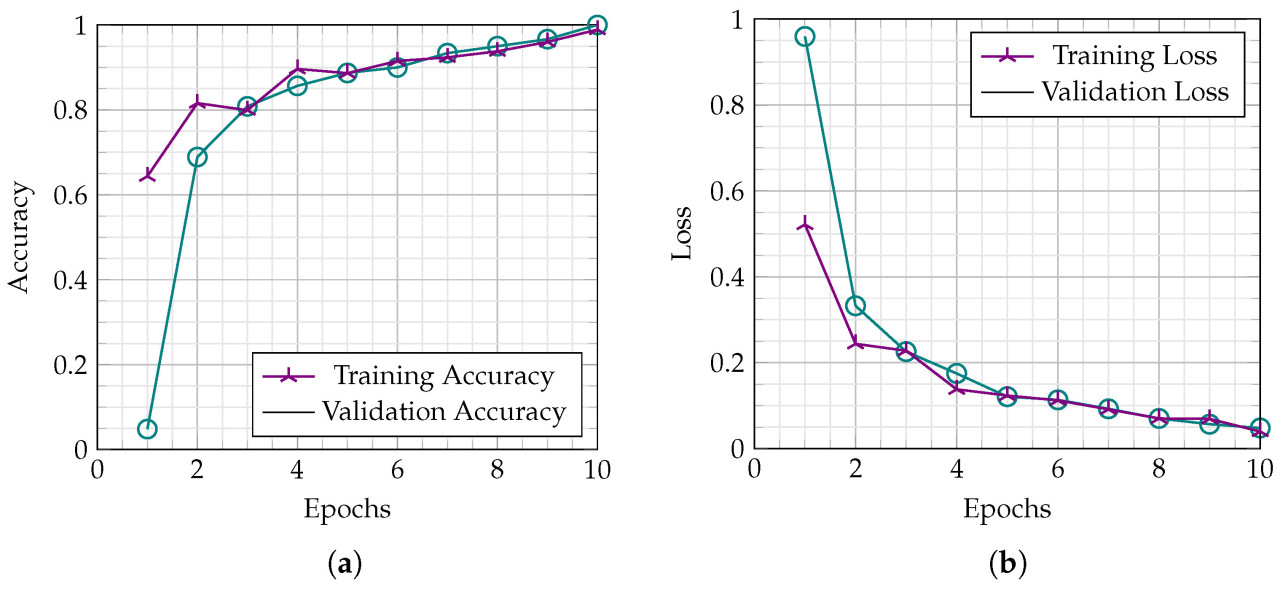

На Рисунке 3 отображена матрица ошибок метода LeafNet, который был обучен с использованием предоставленных эталонных наборов данных. Зеленая диагональ указывает истинно положительные и истинно отрицательные результаты, а красная показывает ошибочные классификации. По сравнению с современными моделями, рекомендуемый LeafNet показывает превосходную общую точность классификации, несмотря на некоторые ошибки классификации внутри обеих категорий. Графики точности и потерь для обучения показаны на Рисунке 4. Хотя в каждой категории есть случайные ошибки классификации, предлагаемый LeafNet превосходит современные модели с точки зрения общей точности классификации. Рисунок 4 показывает графики точности и потерь, полученные во время обучения. Точность и потери отображаются на вертикальной оси, в то время как общее количество эпох отображается на горизонтальной. Чтобы увидеть, насколько успешно LeafNet идентифицирует болезни растений, см. Рисунок 4. Увеличение количества циклов обучения и валидации вызывает вариации в линейных графиках точности обучения и валидации, как показано на Рисунке 4a. Для наборов данных PV, DRLI, PC и BARI-Sun соответственно предлагаемый LeafNet сходится после семи эпох и дает 99%, 97%, 99% и 96% точности обучения и валидации. Рисунок 4b иллюстрирует, как значения потерь обучения и валидации меняются и в конечном итоге приближаются к нулю. Сравнение предлагаемого LeafNet с другими предварительно обученными моделями также показано в Таблице 2 и Таблице 3. Производительность предлагаемого LeafNet лучше, чем у других предварительно обученных моделей, что очевидно из обширного количественного анализа всех четырех наборов данных против десяти современных моделей в Таблице 2 и Таблице 3.

Рисунок 3. Матрицы ошибок предлагаемого LeafNet для каждого набора данных, входящего в эксперимент. (a) PV. (b) DRLI. (c) PC. (d) BARI-Sun.

Рисунок 4. Точность и потери предлагаемого метода LeafNet во время обучения и валидации на наборе данных PC. (a) Точность. (b) Потери.

4.5. Качественные результаты

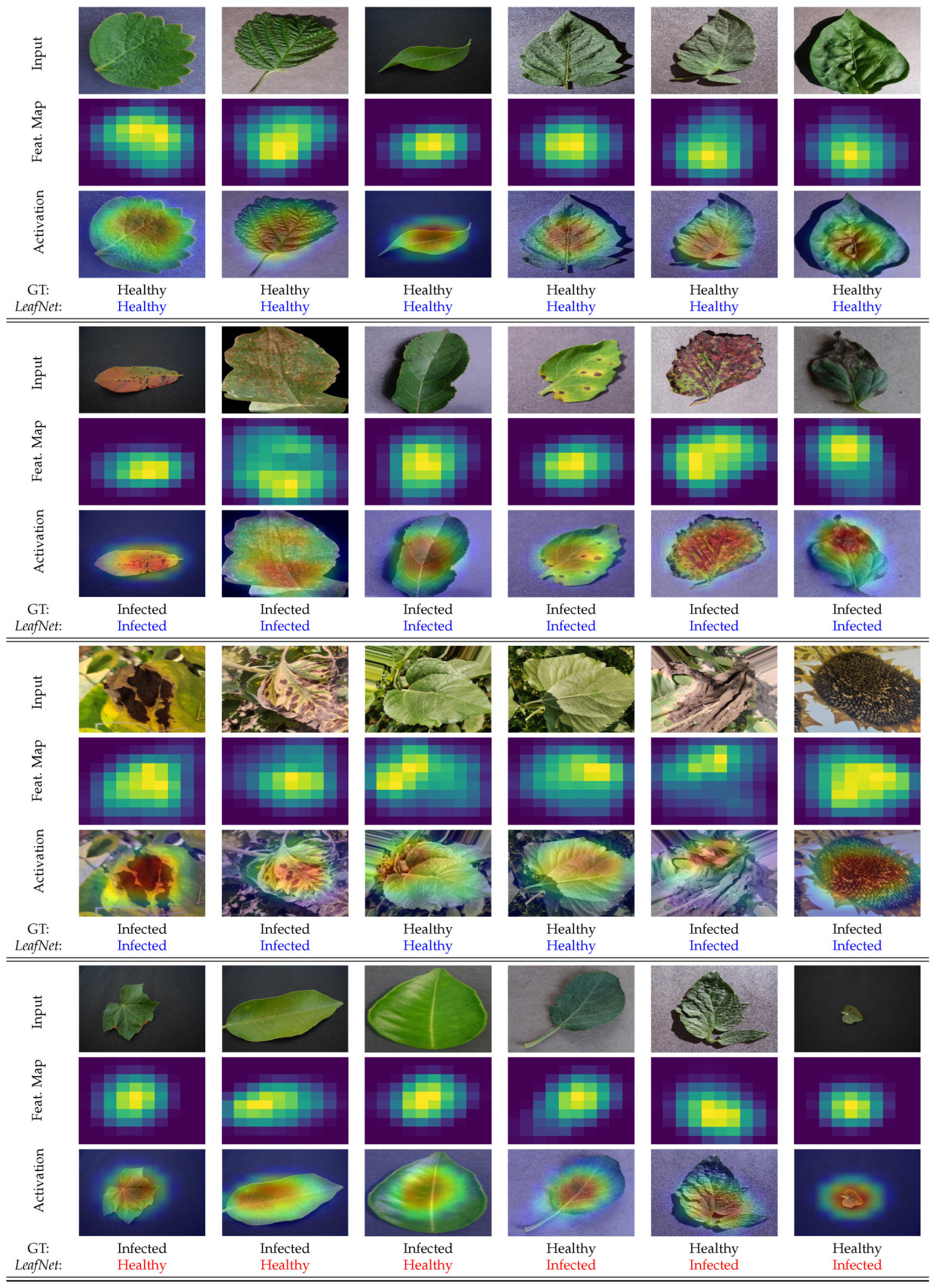

Мы провели исследование, чтобы оценить качественную производительность предлагаемого метода LeafNet на основе активации классов и локализации. Результаты показаны на Рисунке 5, который показывает, насколько хорошо LeafNet обнаруживает здоровые и пораженные области внутри сложных входных изображений. Дополнительно, мы включили карты признаков на основе активации и базовых карт LeafNet для каждого тестового образца. Эти карты признаков подчеркивают наиболее выдающиеся элементы данного изображения листа, которые модель сочла интересными. LeafNet выделяет локализованные области с использованием тепловых карт Grad-CAM (градиентно-взвешенного картирования активации классов). Grad-CAM выделяет область интереса, представляя тепловые карты. Область, которая более значима для принятия решений в классификации, изображена красным или оранжевым цветом, подчеркивая ключевые особенности. Напротив, более холодные области менее заметны для целевой модели. На Рисунке 5 представлены визуальные результаты структуры LeafNet для наиболее сложных примеров, которые были взяты случайным образом из используемых наборов данных. Входные фотографии из включенных наборов данных представлены первой, шестой, одиннадцатой и шестнадцатой строками для каждой коллекции. Карты активации и основные карты признаков для каждого класса показаны во второй и третьей строках. С другой стороны, последняя и предпоследняя строки показывают предсказанную метку с использованием LeafNet и истинную метку (GT).

Рисунок 5. Качественная оценка LeafNet с использованием включенных наборов данных. Результаты для точного предсказания входных изображений выделены синим, а красным — неточные.

Первая, вторая и третья группы входных изображений, которые являются здоровыми и зараженными соответственно, были успешно промаркированы, а последняя группа входных изображений, содержащая три изображения зараженных листьев и три изображения здоровых листьев, была полностью ошибочно классифицирована. На трех зараженных изображениях модель не смотрит на зараженные области, которые слишком малы и их трудно идентифицировать даже невооруженным глазом; вместо этого LeafNet фокусируется на здоровых частях листа. Напротив, для трех здоровых изображений LeafNet ошибочно классифицирует здоровые входные изображения как зараженные, хотя четвертое и пятое изображения показывают, что листья здоровы, но есть некоторые сходства, которые соответствуют и выглядят как инфекция мучнистой росы, из-за чего модель ошибочно классифицирует целевое изображение. Последний здоровый образец довольно обманчив для LeafNet из-за его небольшого размера и малого количества таких образцов в наборе данных.

4.6. Анализ временной сложности

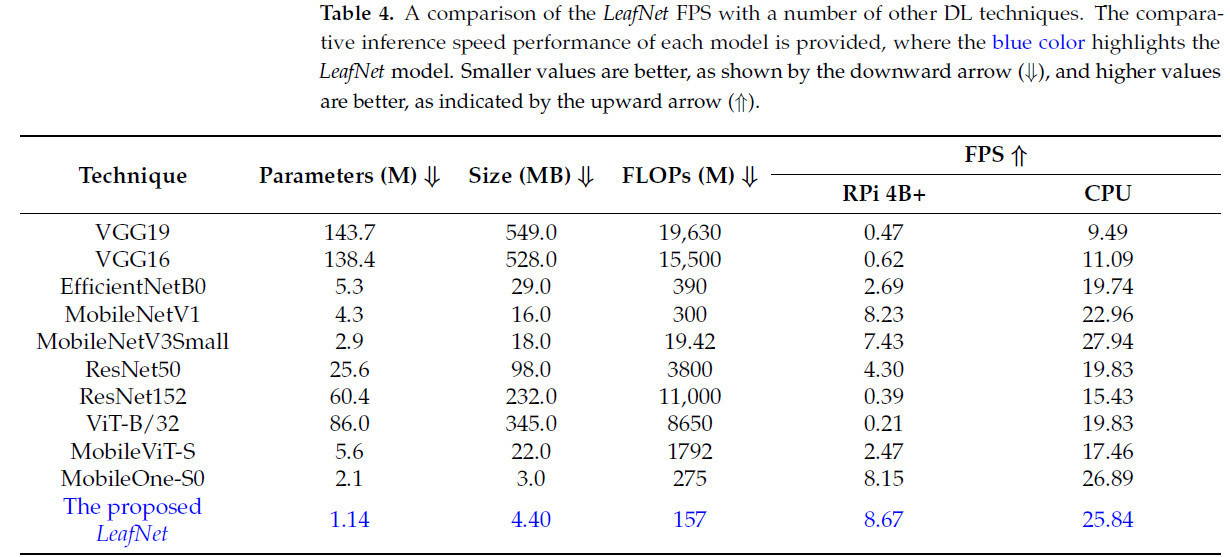

Оценка в реальном времени на различных устройствах необходима для достоверной оценки эффективности, производительности и пригодности к развертыванию модели DL. Одним из таких устройств является Raspberry Pi 4 (Model B+), небольшое периферийное устройство с четырехъядерным процессором Cortex-A72 64-бит, работающим на частоте 1,5 ГГц и с 4 ГБ оперативной памяти. В Разделе 4.1 содержатся подробные спецификации ЦП и анализ кадров в секунду (FPS) для предлагаемого LeafNet. FPS 30 или более является стандартом для оценки производительности модели в идеальных приложениях, поскольку это считается подходящим для реальных условий [47]. Мы использовали видео о болезнях растений из онлайн-источника, чтобы оценить производительность модели. Используя RPi 4B+ и системный ЦП, наша предлагаемая модель LeafNet дала значения FPS 8,67 и 25,84 соответственно. Ближайшими к LeafNet с точки зрения FPS и размера модели были MobileNetV1 и MobileOne-S; однако предлагаемый метод работает лучше с малым размером на диске — 4,40 мегабайта (МБ), меньшим количеством обучаемых параметров и FLOPs, т.е. 1,14 миллиона и 157 миллионов соответственно. FPS производительность предлагаемой модели LeafNet противопоставлена другим базовым моделям в Таблице 4.

Таблица 4. Сравнение FPS модели LeafNet с рядом других методов DL. Представлено сравнительное быстродействие вывода каждой модели, где синим цветом выделена модель LeafNet. Меньшие значения лучше, как показано стрелкой вниз (⇓), а большие значения лучше, как указано стрелкой вверх (⇑).

4.7. Обсуждение

Это исследование подчеркивает важность раннего обнаружения болезней растений для устойчивости сельского хозяйства и представляет LeafNet как облегченное, эффективное решение, разработанное для сред с ограниченными ресурсами. Значительно уменьшив размер модели с 143 млн до 1,14 млн параметров при сохранении конкурентоспособной точности, LeafNet преодолевает разрыв между высокопроизводительным DL и применимостью в реальном мире. Интеграция механизмов внимания к каналам в модель улучшает ее способность фокусироваться на признаках, связанных с болезнями, что подтверждается экспериментами на четырех наборах данных: PV, DRLI, PC и наборе данных BARI-Sun. Надежные значения точности 99%, 98%, 99% и 96% демонстрируют адаптивность LeafNet к разнообразным внутренним и внешним условиям. По сравнению с другими облегченными моделями, такими как MobileOne-S0 и MobileNetV3Small, LeafNet предлагает уникальный компромисс между размером модели, вычислительной эффективностью и точностью. Например, в то время как MobileOne-S0 достигает сопоставимого FPS 8,15 на RPi 4B+, LeafNet немного превосходит его с показателем 8,67 FPS, сохраняя при этом меньше параметров (1,14 млн против 2,1 млн) и более низкие FLOPs (157 млн против 275 млн). Это подчеркивает эффективность LeafNet, особенно в сценариях, требующих обнаружения болезней в реальном времени на периферийных устройствах. Результирующий FPS 8,67 на RPi 4B+ является адекватным для приложений реального времени, что подтверждается ссылками [47,48,49,50,51], указывающими на аналогичные эталоны в реальных случаях использования. Однако определенные ограничения остаются. Текущая реализация сосредоточена на ограниченном диапазоне культур и болезней, и дальнейшие исследования должны расширить ее применимость на более разнообразные наборы данных. Дополнительно, производительность модели может выиграть от тестирования в различных, неконтролируемых условиях, чтобы лучше имитировать реальные сельскохозяйственные условия.

Потенциальные применения LeafNet включают интеграцию с системами IoT для автоматического мониторинга заболеваний и точного сбора данных, прокладывая путь для прогнозной аналитики в умном сельском хозяйстве. Исследование передовых механизмов внимания также может улучшить его возможности извлечения признаков, делая его еще более надежным в сложных сценариях, таких как закрытые или поврежденные листья. В итоге, LeafNet предлагает убедительную комбинацию точности, эффективности и масштабируемости, утверждая себя в качестве преобразующего инструмента для точного земледелия. Его готовность к развертыванию и потенциал для поддержки устойчивых методов ведения сельского хозяйства делают его ценным вкладом в современные сельскохозяйственные технологии.

5. Выводы

Это исследование претендует на представление улучшенного подхода на основе VGG19 для обнаружения болезней и инфекций растений, который превосходит текущие современные исследования. Дополнительно, предлагаемый LeafNet был изменен, чтобы уменьшить количество параметров с 143 млн до 1,14 млн с целью улучшения производительности метода. Всего четыре набора данных — PC, DRLI, PV и BARI-Sun — использовались для оценки предлагаемого LeafNet. Чтобы продемонстрировать способность модели к применению в практических контекстах, исследование также представляет обширные количественные и качественные исследования. Используя периферийное устройство, такое как RPi 4B+, предлагаемый LeafNet был протестирован на FPS.

Ограничения и будущая работа: Предлагаемый LeafNet имеет некоторые ограничения, как это видно из качественного исследования, где он ошибочно классифицировал определенные образцы. Эти ограничения в основном происходят из таких факторов, как небольшое количество экземпляров, изображения с низким разрешением и, в некоторых случаях, недостаточная фокусировка на небольших зараженных областях. Чтобы решить эти проблемы, будущая работа может исследовать включение механизмов самовнимания и перекрестного внимания. Эти подходы имеют потенциал для улучшения извлечения признаков за счет лучшего захвата релевантных деталей, особенно в сценариях, связанных со слабыми или локализованными инфекциями. В контексте интеллектуальных периферийных устройств использование этих продвинутых моделей на основе внимания предлагает перспективное направление для дальнейших исследований и улучшений.

Ссылки

1. Bank, W. World Bank Survey. 2021. Available online: https://data.worldbank.org/indicator/SL.AGR.EMPL.ZS (accessed on 5 June 2023).

2. Clock, W.F. World Food Clock. 2014. Available online: http://worldfoodclock.com/ (accessed on 5 June 2023).

3. Thilagavathi, M.; Abirami, S. Application of image processing in diagnosing guava leaf diseases. Int. J. Sci. Res. Manag. 2017, 5, 5927–5933. [Google Scholar]

4. Gavhale, K.R.; Gawande, U.; Hajari, K.O. Unhealthy region of citrus leaf detection using image processing techniques. In Proceedings of the International Conference for Convergence for Technology—2014, Pune, India, 6–8 April 2014; IEEE: Piscataway, NJ, USA, 2014; pp. 1–6. [Google Scholar]

5. Padol, P.B.; Yadav, A.A. SVM classifier based grape leaf disease detection. In Proceedings of the 2016 Conference on Advances in Signal Processing (CASP), Pune, India, 9–11 June 2016; IEEE: Piscataway, NJ, USA, 2016; pp. 175–179. [Google Scholar]

6. Masazhar, A.N.I.; Kamal, M.M. Digital image processing technique for palm oil leaf disease detection using multiclass SVM classifier. In Proceedings of the 2017 IEEE 4th International Conference on Smart Instrumentation, Measurement and Application (ICSIMA), Putrajaya, Malaysia, 28–30 November 2017; IEEE: Piscataway, NJ, USA, 2017; pp. 1–6. [Google Scholar]

7. Islam, M.; Dinh, A.; Wahid, K.; Bhowmik, P. Detection of potato diseases using image segmentation and multiclass support vector machine. In Proceedings of the 2017 IEEE 30th Canadian Conference on Electrical and Computer Engineering (CCECE), Windsor, ON, Canada, 30 April–3 May 2017; IEEE: Piscataway, NJ, USA, 2017; pp. 1–4. [Google Scholar]

8. Agrawal, N.; Singhai, J.; Agarwal, D.K. Grape leaf disease detection and classification using multi-class support vector machine. In Proceedings of the 2017 International Conference on Recent Innovations in Signal Processing and Embedded Systems (RISE), Bhopal, India, 27–29 October 2017; IEEE: Piscataway, NJ, USA, 2017; pp. 238–244. [Google Scholar]

9. Parikh, A.; Raval, M.S.; Parmar, C.; Chaudhary, S. Disease detection and severity estimation in cotton plant from unconstrained images. In Proceedings of the 2016 IEEE International Conference on Data Science and Advanced Analytics (DSAA), Montreal, QC, Canada, 17–19 October 2016; IEEE: Piscataway, NJ, USA, 2016; pp. 594–601. [Google Scholar]

10. Suresha, M.; Shreekanth, K.; Thirumalesh, B. Recognition of diseases in paddy leaves using knn classifier. In Proceedings of the 2017 2nd International Conference for Convergence in Technology (I2CT), Mumbai, India, 7–9 April 2017; IEEE: Piscataway, NJ, USA, 2017; pp. 663–666. [Google Scholar]

11. Vaishnnave, M.; Devi, K.S.; Srinivasan, P.; Jothi, G.A.P. Detection and classification of groundnut leaf diseases using KNN classifier. In Proceedings of the 2019 IEEE International Conference on System, Computation, Automation and Networking (ICSCAN), Pondicherry, India, 29–30 March 2019; IEEE: Piscataway, NJ, USA, 2019; pp. 1–5. [Google Scholar]

12. Liu, H.; Lang, B. Machine learning and deep learning methods for intrusion detection systems: A survey. Appl. Sci. 2019, 9, 4396. [Google Scholar] [CrossRef]

13. Mohanty, S.P.; Hughes, D.P.; Salathé, M. Using deep learning for image-based plant disease detection. Front. Plant Sci. 2016, 7, 1419. [Google Scholar] [CrossRef] [PubMed]

14. Chouhan, S.S.; Singh, U.P.; Kaul, A.; Jain, S. A data repository of leaf images: Practice towards plant conservation with plant pathology. In Proceedings of the 2019 4th International Conference on Information Systems and Computer Networks (ISCON), Mathura, India, 21–22 November 2019; IEEE: Piscataway, NJ, USA, 2019; pp. 700–707. [Google Scholar]

15. Dhaka, V.S.; Meena, S.V.; Rani, G.; Sinwar, D.; Ijaz, M.F.; Woźniak, M. A survey of deep convolutional neural networks applied for prediction of plant leaf diseases. Sensors 2021, 21, 4749. [Google Scholar] [CrossRef] [PubMed]

16. Qiu, R.; Yang, C.; Moghimi, A.; Zhang, M.; Steffenson, B.J.; Hirsch, C.D. Detection of fusarium head blight in wheat using a deep neural network and color imaging. Remote Sens. 2019, 11, 2658. [Google Scholar] [CrossRef]

17. Bi, C.; Wang, J.; Duan, Y.; Fu, B.; Kang, J.R.; Shi, Y. MobileNet based apple leaf diseases identification. Mob. Netw. Appl. 2022, 27, 172–180. [Google Scholar] [CrossRef]

18. Lee, S.H.; Goëau, H.; Bonnet, P.; Joly, A. New perspectives on plant disease characterization based on deep learning. Comput. Electron. Agric. 2020, 170, 105220. [Google Scholar] [CrossRef]

19. Kundu, N.; Rani, G.; Dhaka, V.S.; Gupta, K.; Nayak, S.C.; Verma, S.; Ijaz, M.F.; Woźniak, M. IoT and interpretable machine learning based framework for disease prediction in pearl millet. Sensors 2021, 21, 5386. [Google Scholar] [CrossRef]

20. Rangarajan, A.K.; Purushothaman, R.; Ramesh, A. Tomato crop disease classification using pre-trained deep learning algorithm. Procedia Comput. Sci. 2018, 133, 1040–1047. [Google Scholar] [CrossRef]

21. Amara, J.; Bouaziz, B.; Algergawy, A. A deep learning-based approach for banana leaf diseases classification. In Datenbanksysteme für Business, Technologie und Web (BTW 2017)-Workshopband; German Informatics Society: Bonn, Germany, 2017. [Google Scholar]

22. Barbedo, J.G.A. A review on the use of unmanned aerial vehicles and imaging sensors for monitoring and assessing plant stresses. Drones 2019, 3, 40. [Google Scholar] [CrossRef]

23. Simonyan, K.; Zisserman, A. Very deep convolutional networks for large-scale image recognition. arXiv 2014, arXiv:1409.1556. [Google Scholar]

24. Tan, M.; Le, Q. Efficientnet: Rethinking model scaling for convolutional neural networks. In Proceedings of the International Conference on Machine Learning, PMLR, Long Beach, CA, USA, 9–15 June 2019; pp. 6105–6114. [Google Scholar]

25. Howard, A.G.; Zhu, M.; Chen, B.; Kalenichenko, D.; Wang, W.; Weyand, T.; Andreetto, M.; Adam, H. Mobilenets: Efficient convolutional neural networks for mobile vision applications. arXiv 2017, arXiv:1704.04861. [Google Scholar]

26. Howard, A.; Sandler, M.; Chu, G.; Chen, L.C.; Chen, B.; Tan, M.; Wang, W.; Zhu, Y.; Pang, R.; Vasudevan, V.; et al. Searching for mobilenetv3. In Proceedings of the Proceedings of the IEEE/CVF International Conference on Computer Vision, Seoul, Republic of Korea, 27 October–2 November 2019; pp. 1314–1324. [Google Scholar]

27. He, K.; Zhang, X.; Ren, S.; Sun, J. Deep residual learning for image recognition. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, NV, USA, 27–30 June 2016; pp. 770–778. [Google Scholar]

28. Dosovitskiy, A.; Beyer, L.; Kolesnikov, A.; Weissenborn, D.; Zhai, X.; Unterthiner, T.; Dehghani, M.; Minderer, M.; Heigold, G.; Gelly, S.; et al. An image is worth 16x16 words: Transformers for image recognition at scale. arXiv 2020, arXiv:2010.11929. [Google Scholar]

29. Mehta, S.; Rastegari, M. Mobilevit: Light-weight, general-purpose, and mobile-friendly vision transformer. arXiv 2021, arXiv:2110.02178. [Google Scholar]

30. Vasu, P.K.A.; Gabriel, J.; Zhu, J.; Tuzel, O.; Ranjan, A. Mobileone: An improved one millisecond mobile backbone. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, Vancouver, BC, Canada, 18–22 June 2023; pp. 7907–7917. [Google Scholar]

31. Zhao, Y.; Sun, C.; Xu, X.; Chen, J. RIC-Net: A plant disease classification model based on the fusion of Inception and residual structure and embedded attention mechanism. Comput. Electron. Agric. 2022, 193, 106644. [Google Scholar] [CrossRef]

32. Pandey, A.; Jain, K. A robust deep attention dense convolutional neural network for plant leaf disease identification and classification from smart phone captured real world images. Ecol. Inform. 2022, 70, 101725. [Google Scholar] [CrossRef]

33. Bedi, P.; Gole, P. Plant disease detection using hybrid model based on convolutional autoencoder and convolutional neural network. Artif. Intell. Agric. 2021, 5, 90–101. [Google Scholar] [CrossRef]

34. Chohan, M.; Khan, A.; Chohan, R.; Katpar, S.H.; Mahar, M.S. Plant disease detection using deep learning. Int. J. Recent Technol. Eng. 2020, 9, 909–914. [Google Scholar] [CrossRef]

35. Hassan, S.M.; Maji, A.K. Plant disease identification using a novel convolutional neural network. IEEE Access 2022, 10, 5390–5401. [Google Scholar] [CrossRef]

36. Atila, Ü.; Uçar, M.; Akyol, K.; Uçar, E. Plant leaf disease classification using EfficientNet deep learning model. Ecol. Inform. 2021, 61, 101182. [Google Scholar] [CrossRef]

37. Amin, H.; Darwish, A.; Hassanien, A.E.; Soliman, M. End-to-end deep learning model for corn leaf disease classification. IEEE Access 2022, 10, 31103–31115. [Google Scholar] [CrossRef]

38. Maurya, R.; Pandey, N.N.; Singh, V.P.; Gopalakrishnan, T. Plant disease classification using interpretable vision transformer network. In Proceedings of the 2023 International Conference on Recent Advances in Electrical, Electronics & Digital Healthcare Technologies (REEDCON), New Delhi, India, 1–3 May 2023; IEEE: Piscataway, NJ, USA, 2023; pp. 688–692. [Google Scholar]

39. Abbas, A.; Jain, S.; Gour, M.; Vankudothu, S. Tomato plant disease detection using transfer learning with C-GAN synthetic images. Comput. Electron. Agric. 2021, 187, 106279. [Google Scholar] [CrossRef]

40. Thakur, P.S.; Khanna, P.; Sheorey, T.; Ojha, A. Explainable vision transformer enabled convolutional neural network for plant disease identification: PlantXViT. arXiv 2022, arXiv:2207.07919. [Google Scholar]

41. Karthik, R.; Hariharan, M.; Anand, S.; Mathikshara, P.; Johnson, A.; Menaka, R. Attention embedded residual CNN for disease detection in tomato leaves. Appl. Soft Comput. 2020, 86, 105933. [Google Scholar]

42. Dai, G.; Tian, Z.; Fan, J.; Sunil, C.; Dewi, C. DFN-PSAN: Multi-level deep information feature fusion extraction network for interpretable plant disease classification. Comput. Electron. Agric. 2024, 216, 108481. [Google Scholar] [CrossRef]

43. Shah, D.; Trivedi, V.; Sheth, V.; Shah, A.; Chauhan, U. ResTS: Residual deep interpretable architecture for plant disease detection. Inf. Process. Agric. 2022, 9, 212–223. [Google Scholar] [CrossRef]

44. Gupta, B.B.; Quamara, M. An overview of Internet of Things (IoT): Architectural aspects, challenges, and protocols. Concurr. Comput. Pract. Exp. 2020, 32, e4946. [Google Scholar] [CrossRef]

45. Keras. Keras Applications. 2024. Available online: https://keras.io/api/applications/ (accessed on 23 December 2024).

46. Sara, U.; Rajbongshi, A.; Shakil, R.; Akter, B.; Sazzad, S.; Uddin, M.S. An extensive sunflower dataset representation for successful identification and classification of sunflower diseases. Data Brief 2022, 42, 108043. [Google Scholar] [CrossRef] [PubMed]

47. Parez, S.; Dilshad, N.; Alghamdi, N.S.; Alanazi, T.M.; Lee, J.W. Visual intelligence in precision agriculture: Exploring plant disease detection via efficient vision transformers. Sensors 2023, 23, 6949. [Google Scholar] [CrossRef] [PubMed]

48. Parez, S.; Dilshad, N.; Alanazi, T.M.; Lee, J.W. Towards Sustainable Agricultural Systems: A Lightweight Deep Learning Model for Plant Disease Detection. Comput. Syst. Sci. Eng. 2023, 47, 515–536. [Google Scholar] [CrossRef]

49. Dilshad, N.; Khan, S.U.; Alghamdi, N.S.; Taleb, T.; Song, J. Towards efficient fire detection in IoT environment: A modified attention network and large-scale dataset. IEEE Internet Things J. 2023, 11, 13467–13481. [Google Scholar] [CrossRef]

50. Dilshad, N.; Khan, T.; Song, J. Efficient Deep Learning Framework for Fire Detection in Complex Surveillance Environment. Comput. Syst. Sci. Eng. 2023, 46, 749–764. [Google Scholar] [CrossRef]

51. Khan, Z.A.; Ullah, F.U.M.; Yar, H.; Ullah, W.; Khan, N.; Kim, M.J.; Baik, S.W. Optimized Cross-Module Attention Network and Medium-Scale Dataset for Effective Fire Detection. Pattern Recognit. 2024, 161, 111273. [Google Scholar] [CrossRef]

Parez S, Dilshad N, Lee JW. A Channel Attention-Driven Optimized CNN for Efficient Early Detection of Plant Diseases in Resource Constrained Environment. Agriculture. 2025; 15(2):127. https://doi.org/10.3390/agriculture15020127

Перевод статьи «A Channel Attention-Driven Optimized CNN for Efficient Early Detection of Plant Diseases in Resource Constrained Environment» авторов Parez S, Dilshad N, Lee JW., оригинал доступен по ссылке. Лицензия: CC BY. Изменения: переведено на русский язык

Комментарии (0)