WED-YOLO: Модель для обнаружения сафлора в сложных неструктурированных условиях

Точное распознавание сафлора является важнейшей исследовательской задачей в области автоматизированного сбора урожая сафлора. Условия выращивания сафлора, включая такие факторы, как переменные погодные условия в неструктурированных средах, расстояния съемки и разнообразные морфологические характеристики, создают значительные трудности для обнаружения. Для решения этих проблем и обеспечения точного распознавания сафлора в сложных условиях в данном исследовании предлагается улучшенная модель обнаружения сафлора, WED-YOLO, основанная на YOLOv8n.

Аннотация

Во-первых, исходная функция потерь ограничивающей рамки заменена динамическим немонотонным механизмом фокусировки Wise Intersection over Union (WIoU), что повышает способность модели к подгонке ограничивающей рамки и ускоряет сходимость сети. Затем модуль повышения разрешения в «шейке» сети заменен более эффективным и универсальным динамическим модулем повышения разрешения DySample для повышения точности повышения разрешения карты признаков. Одновременно механизм внимания EMA интегрирован в модуль C2f базовой сети для усиления возможностей модели по извлечению признаков. Наконец, в блок обнаружения встроен слой обнаружения мелких целей, позволяющий модели фокусироваться на небольших объектах из сафлора. Модель обучается и проверяется с использованием специально созданного набора данных по сафлору. Экспериментальные результаты показывают, что улучшенная модель достигает значений точности (P), полноты (R), средней точности (mAP) и показателяF1 ,равных 93,15%, 86,71%, 95,03% и 89,64% соответственно. Эти результаты представляют собой улучшение на 2,9%, 6,69%, 4,5% и 6,22% по сравнению с базовой моделью. По сравнению с Faster R-CNN, YOLOv5, YOLOv7 и YOLOv10, WED-YOLO достиг наивысшего значенияmAP. Он превосходит упомянутый модуль на 13,06%, 4,85%, 4,86% и 4,82% соответственно. Усовершенствованная модель демонстрирует превосходную точность и более низкий процент ошибок при распознавании сафлора, обеспечивая надежную алгоритмическую основу для интеллектуального сбора урожая сафлора.

1. Введение

Сафлор — это важная техническая культура. Натуральный краситель сафлоровый жёлтый, экстрагируемый из лепестков сафлора, широко используется в медицине благодаря своей высокой лекарственной ценности [1,2]. Китай является одним из крупнейших производителей сафлора [3]. Уборка сафлора отличается высокой сезонностью и трудоёмкостью. В настоящее время сбор сафлора в основном осуществляется вручную, что неэффективно и затратно. Кроме того, из-за задержки сбора часть лепестков сафлора вянет, что приводит к снижению урожайности. Таким образом, интеллектуальная уборка сафлора стала ключевой областью исследований. Сафлор цветёт несколькими волнами, каждая из которых проходит периоды раскрытия и опадения цветков [4,5]. Цветки сафлора мелкие, многочисленные, расположены плотно и имеют разную высоту, что затрудняет эффективное извлечение признаков мелких объектов — цветков сафлора. Кроме того, сложный фон в неструктурированной среде вносит значительный шум, что дополнительно влияет на процесс извлечения признаков. В конечном итоге это снижает точность распознавания сафлора и препятствует развитию автоматизированной уборки. Следовательно, существует острая необходимость в разработке алгоритмов, которые могут эффективно извлекать признаки мелких объектов (цветков сафлора) в сложных условиях, минимизировать фоновый шум и обеспечивать точное распознавание в разные периоды цветения. Такие алгоритмы могут предоставить ценную основу для интеллектуальной уборки сафлора.

Многочисленные методы глубокого обучения были использованы для идентификации и обнаружения цветков и плодов сельскохозяйственных культур в сложных условиях [6,7,8]. Алгоритмы обнаружения объектов делятся на двухэтапные и одноэтапные методы. Двухэтапные алгоритмы работают путём первоначального генерирования серии кандидатных ограничивающих рамок, которые затем классифицируются с использованием свёрточных нейронных сетей. Farjon и др. [9] использовали Faster R-CNN [10] для обнаружения цветков яблони, достигнув значения mAP 68%. Zhang и др. [11] улучшили базовую сеть извлечения признаков, структуру генерации якорей и механизм отображения признаков сети Faster R-CNN. Улучшенный алгоритм достиг mAP 91,49% для обнаружения сафлора. Bhattarai и др. [12] использовали алгоритм Mask R-CNN для сегментации цветков яблони, проводя эксперименты по оптимизации гиперпараметров сети глубокого обучения в процессе обучения и достигнув средней точности (AP) 86%. Tian и др. [13] предложили модель Mask Scoring R-CNN с базовой сетью U-Net для обнаружения и сегментации различных форм цветков яблони, включая бутоны, полураскрытые и полностью раскрытые цветки.

В отличие от них, одноэтапные алгоритмы обнаружения обходятся без этапа генерации кандидатных рамок, формулируя задачу локализации объектов как проблему регрессии. Это фундаментальное различие в конструкции даёт двухэтапным методам небольшое преимущество в точности обнаружения и локализации, в то время как одноэтапные методы превосходят по скорости обработки. Однако с непрерывным развитием серии YOLO одноэтапные алгоритмы добились значительного улучшения точности, сохраняя при этом своё преимущество в скорости, сокращая разрыв в производительности с двухэтапными методами. Zhang и др. [14] предложили GSC-YOLOv3 на основе алгоритма YOLOv3 для обнаружения лепестков сафлора, достигнув mAP 91,89%. Guo и др. [15] представили алгоритм обнаружения и локализации пестиков сафлора на основе YOLOv5m, включив механизм внимания CBAM, что привело к AP 95,2%. Wang и др. [16] представили подход к распознаванию сафлора в сложных условиях, используя улучшенный алгоритм YOLOv7. Оптимизация включала интеграцию механизма внимания Swin Transformer и доработку функции потерь Focal Loss, что привело к AP 88,5%, что на 7% выше по сравнению с исходной моделью. Wang и др. [17] представили алгоритм обнаружения объектов на основе YOLOv5 для обнаружения в реальном времени плодоножек и чашелистиков яблок, достигнув mAP 88%. Bhattarai и др. [18] предложили сеть на основе глубокой регрессии, AgRegNet, способную оценивать плотность, количество и местоположение цветков и плодов в кронах деревьев. В неструктурированной среде сада их модель достигла mAP 81% для обнаружения цветков яблони. Dias и др. [19] предложили улучшенную сквозную остаточную свёрточную нейронную сеть для повышения чувствительности к цвету. Используя метод Deeplab + RGR, они достигли точного распознавания цветков с показателями полноты (Recall) и точности (Precision), превышающими 90%. Qi и др. [20] представили алгоритм TC-YOLO, который использует улучшенную базовую сеть для извлечения признаков и обнаружения хризантем в сложных условиях. Bai и др. [21] разработали улучшенный алгоритм YOLOv7, предназначенный для распознавания цветков и плодов у рассады клубники в теплице. Они классифицировали цветки на периоды бутона и цветка, достигнув значения mAP 94,7% для цветков и 89,5% для плодов. Zhao и др. [22] предложили метод распознавания и обнаружения периода цветения томатов на основе каскадной свёрточной нейронной сети, с точностью (Precision) 76,67% в условиях стеклянной теплицы. Хотя эти исследования достигли перспективных результатов в распознавании и обнаружении цветков и плодов, они часто упускают из виду проблемы, создаваемые сложным фоном, размытыми изображениями и низкокачественными образцами во время реальной уборки. Эти факторы приводят к нечётким признакам обнаруживаемых целей на разных расстояниях, что снижает точность обнаружения. Для решения этих задач в данном исследовании были собраны изображения сафлора при различных погодных условиях и дистанциях съёмки для создания набора данных, подходящего для обучения и оценки модели. На основе модели YOLOv8n мы предлагаем улучшения и оптимизации для обнаружения лепестков сафлора. Основные вклады этого исследования можно обобщить следующим образом:

(1) Учитывая значительные вариации размера и формы сафлора при изменении дистанции съёмки, функция потерь была заменена на WIoU, лучше подходящую для обработки этих вариаций.

(2) Для сохранения более детальной информации о признаках сафлора в процессе повышения разрешения модуль повышения разрешения в шейке сети был заменён на модуль DySample, что усиливает способность модели к повышению разрешения.

(3) Для лучшего захвата признаков сафлора модуль EMA был интегрирован в модуль C2f базовой сети, улучшив способность базовой сети извлекать признаки целей сафлора.

(4) Был добавлен слой обнаружения малых объектов для улучшения способности модели извлекать и идентифицировать признаки мелких целей сафлора в наборе данных, что обеспечивает точный метод обнаружения для автоматизации уборки сафлора.

Остальная часть исследования структурирована следующим образом: Раздел 2 даёт обзор соответствующих материалов и детализирует методы распознавания и обнаружения, использованные в этом исследовании; Раздел 3 описывает экспериментальную установку, представляет метрики оценки и сообщает о результатах экспериментов; наконец, Раздел 4 предлагает обсуждение результатов, представляет выводы и выделяет потенциальные направления для будущей работы.

2. Материалы и методы

2.1. Материал

2.1.1. Сбор данных изображений

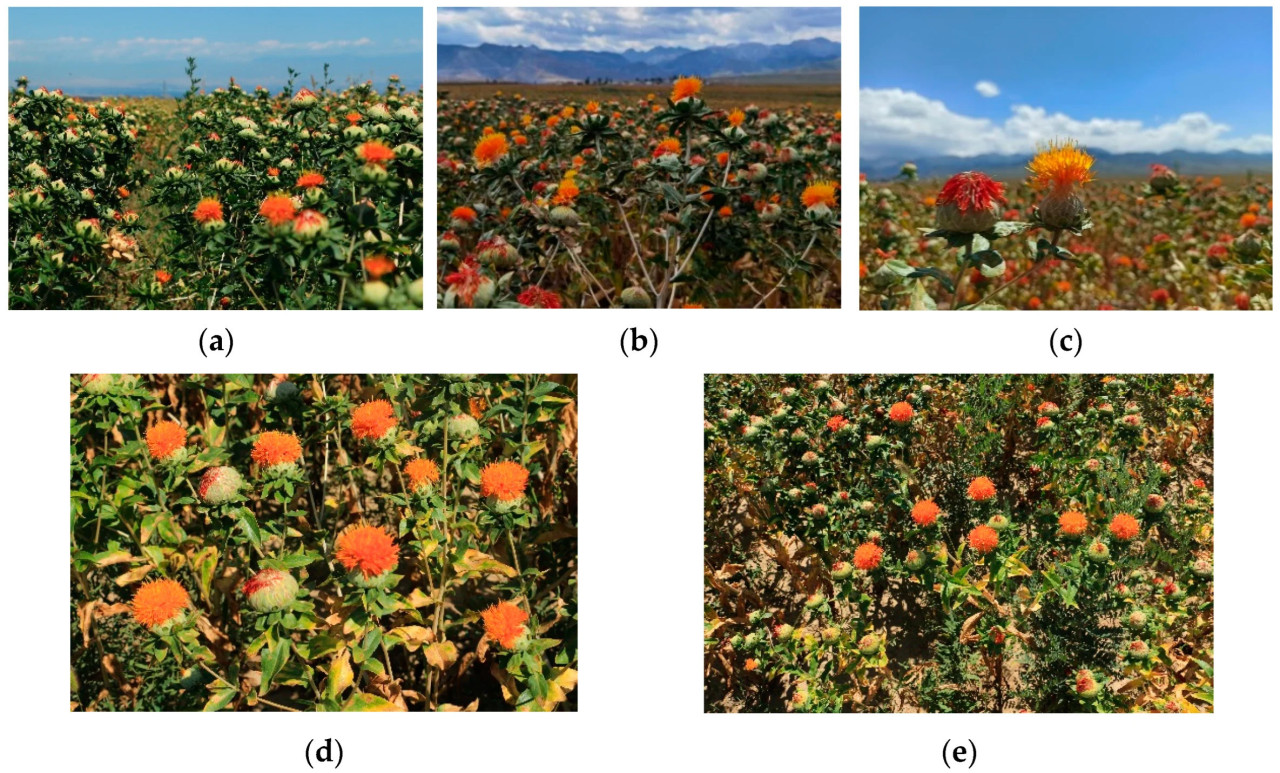

Сафлор является объектом эксперимента в данном исследовании. Структура сафлора состоит из трёх основных частей, расположенных сверху вниз: лепесток, плодовая головка и стебель. Он проходит два основных периода цветения: период раскрытия и период опадения. Набор данных по сафлору был собран на базе выращивания сафлора, расположенной на 81°8′ в.д. и 43°33′ с.ш. в Чапчал-Сибинском автономном уезде, Или, Синьцзян, Китай. Устройства для съёмки включают цифровую камеру Canon (E700D) (Canon Inc., Токио, Япония) и Huawei P50 (Huawei Technologies Co., Ltd., Шэньчжэнь, Китай). Чтобы обеспечить универсальность и рабочий диапазон интеллектуальной уборочной техники для сафлора, набор данных был спроектирован разнообразным. Он включает образцы сафлора, снятые при различных погодных условиях и на разных расстояниях. Кроме того, каждое изображение содержит несколько растений сафлора на разных стадиях цветения. Погодные условия во время сбора данных были классифицированы как солнечные, облачные и пасмурные. Поскольку растение сафлора обычно состоит из нескольких ветвей и имеет определённый разброс с вариациями по высоте, дистанция съёмки была выбрана в диапазоне от 0,4 до 1 м, чтобы соответствовать рабочему диапазону оборудования. Набор данных был разделён на две категории на основе дистанции съёмки: близкая (0,4~0,7 м) и дальняя (0,7~1 м). Этот диапазон гарантирует, что вариации высоты растений сафлора остаются в управляемом диапазоне, максимизируя видимость всех цветков в кадре. Набор данных включает изображения, снятые в различных погодных условиях, включая солнечные, облачные, пасмурные, а также на близком и дальнем расстояниях. Такое сочетание позволяет обеспечить гибкость в задачах выборочной уборки. Всего было собрано 1126 RGB-изображений для обучения и тестирования модели, с категориями и количеством, подробно описанными в Таблице 1. Некоторые изображения показаны на Рисунке 1.

Рисунок 1. Пример набора данных изображений сафлора в сложной среде: (a) Солнечно, (b) пасмурно, (c) облачно, (d) близкое расстояние (0,4~0,7 м), (e) дальнее расстояние (0,7~1 м).

Таблица 1. Набор данных и их количество при различных условиях.

2.1.2. Аугментация и обработка набора данных изображений лепестков сафлора

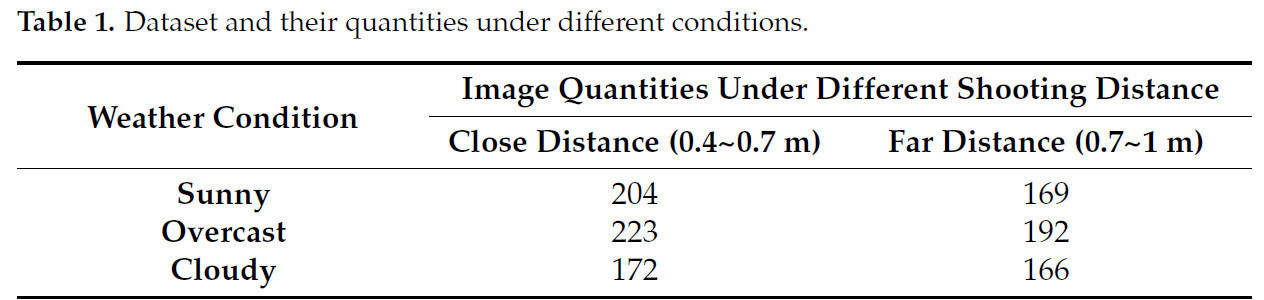

Для смягчения переобучения во время обучения к исходному набору данных были применены различные методы аугментации данных. Использованные методы включали повороты (90°, 180° и 270°), добавление шума, зеркальное отражение по горизонтали и вертикали, а также изменение яркости. Такая аугментация эффективно расширила набор данных, выделив как глобальные, так и локальные признаки образцов сафлора и увеличив контраст между различными стадиями цветения. Этот подход способствует повышению способности к обучению глубоких нейронных сетей. Расширение вариативности набора данных значительно улучшило устойчивость и обобщающую способность модели. Примеры аугментированных изображений показаны на Рисунке 2.

Рисунок 2. Аугментация данных: (a) Исходное изображение, (b) поворот, (c) зеркальное отражение по горизонтали, (d) гауссовский шум, (e) случайное кадрирование, (f) регулировка яркости.

Набор данных был снят при различных погодных условиях и на разных дистанциях съёмки, чтобы обеспечить его разнообразие. Чтобы гарантировать точность параметров данных, набор данных был вручную размечен с использованием инструмента LabelImg перед обучением модели. Аннотации следовали формату YOLO, при этом сафлор в фазе цветения помечался как Opening_period (период раскрытия), а сафлор в фазе увядания — как Flower_shedding_period (период опадения). При аннотировании в качестве истинной ограничивающей рамки использовался минимальный ограничивающий прямоугольник вокруг лепестков сафлора, чтобы минимизировать включение нерелевантных пикселей фона. После аннотирования генерировались соответствующие файлы аннотаций .txt. После аугментации данных было получено в общей сложности 3940 изображений сафлора. Они были разделены на обучающую, валидационную и тестовую выборки в соотношении 8:1:1. Итоговое распределение состояло из 3152 изображений в обучающем наборе, 394 изображений в валидационном наборе и 394 изображений в тестовом наборе. Обучающий и валидационный наборы использовались для обучения модели и промежуточной оценки в течение каждого цикла обучения, в то время как тестовый набор был зарезервирован для окончательной оценки производительности обнаружения модели.

2.2. Методы

2.2.1. Модель YOLOv8

Серия алгоритмов YOLO (You Only Look Once) включает в себя одноэтапные модели обнаружения, которые достигают эффективного баланса между скоростью обнаружения и точностью, особенно при обнаружении мелких объектов. Эти модели позволяют осуществлять быструю классификацию и обнаружение непосредственно на изображениях [23,24,25]. YOLOv8 — это одноэтапный алгоритм обнаружения объектов без якорей (anchor-free), который стал одной из ведущих моделей в категории современных (SOTA). Архитектура YOLOv8 во многом следует модели YOLOv5, при этом вводя новые функции и улучшения для дальнейшего повышения её производительности и гибкости. В YOLOv8 структура C2f заменяет структуру C3, используемую в YOLOv5. Модуль C2f спроектирован с учётом вдохновения как от модуля C3, так и от концепции ELAN [26]. Он разделяет входную карту признаков на две части по одному измерению, уменьшая вычислительную сложность и одновременно обогащая поток градиентов, что улучшает способность модели представлять нелинейные признаки. Кроме того, YOLOv8 включает в себя разделённую голову (Decoupled-Head) в качестве финальной головы обнаружения, которая разделяет задачи классификации и регрессии, позволяя делать независимые предсказания. Этот подход уменьшает конфликты между двумя задачами и вводит метод без якорей, упрощая конвейер обнаружения объектов и повышая производительность модели. Структурная схема модели показана на Рисунке 3.

Рисунок 3. Частичная схема архитектуры модели. (a) Структура модуля C2f и (b) структура разделённой головы (Decoupled-Head).

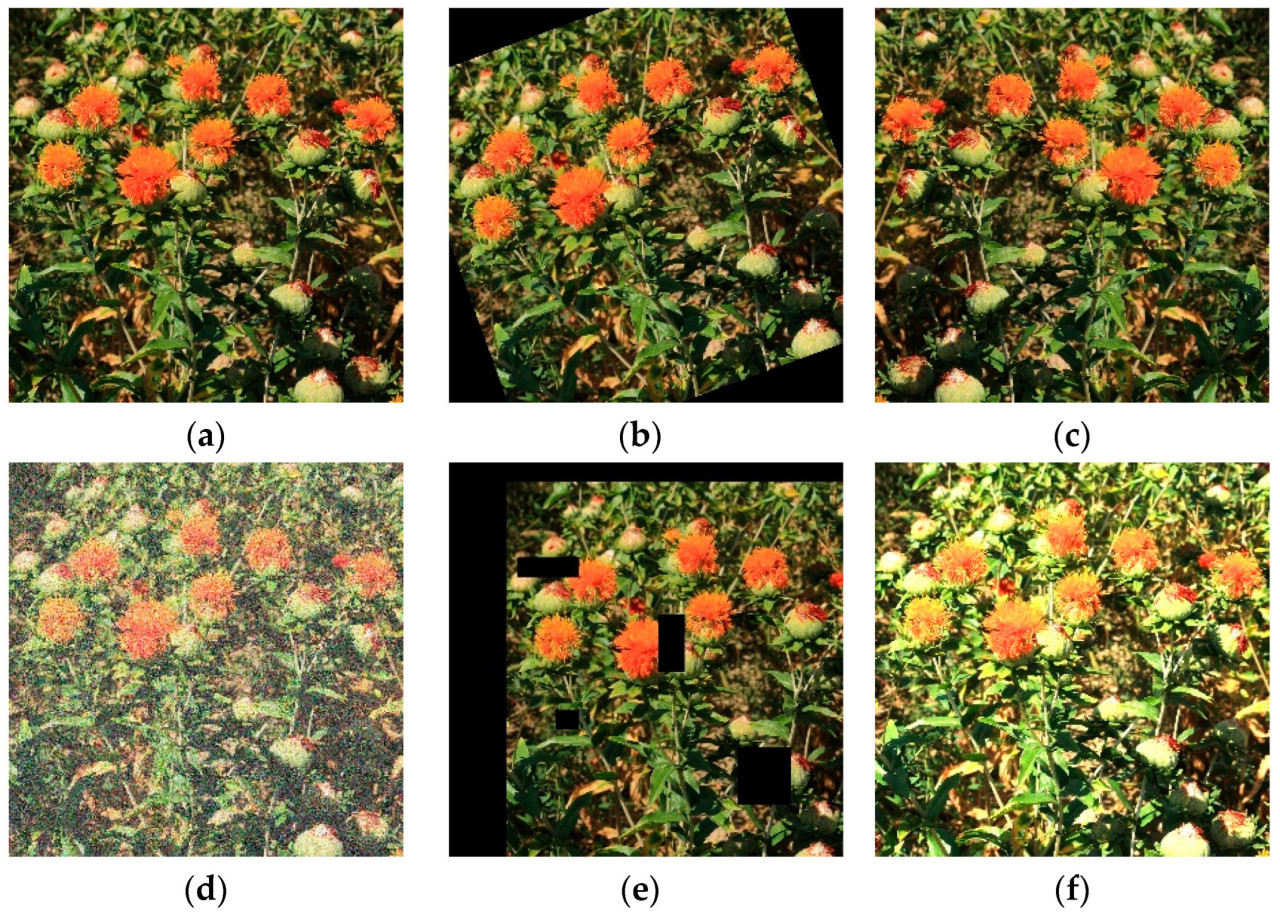

2.2.2. Улучшенная модель YOLOv8 для обнаружения мелких объектов — лепестков сафлора

Из-за того, что лепестки сафлора имеют малый размер и их много, точная идентификация признаков лепестков сафлора, генерация ограничивающих рамок целей, а также идентификация различных периодов цветения лепестков сафлора в естественных условиях являются основными направлениями исследований данной статьи. Основные улучшения включают:

(1) Замена функции потерь CIoU исходной модели на функцию потерь WIoU. WIoU назначает различные веса целям сафлора разного размера, что может улучшить способность к подгонке ограничивающих рамок и ускорить сходимость сети.

(2) В шейке сети вводится модуль DySample для замены модуля Upsample исходной модели. DySample может улучшить способность к повышению разрешения для целей сафлора на изображениях низкого разрешения или в дальнем поле обзора, а затем уменьшить потерю признаков сафлора в процессе сэмплирования.

(3) Включение эффективного многомасштабного механизма внимания в модуль C2f в базовой сети для улучшения способности извлечения признаков сафлора базовой сетью.

(4) Добавлена голова предсказания для мелких объектов размером 160 × 160 × 32, предназначенная для улучшения способности обнаружения мелких целей — образцов сафлора. Структура модели YOLOv8-WED показана на Рисунке 4.

Рисунок 4. Сетевая структура улучшенного YOLOv8. C2f-EMA относится к модулю C2f, в который интегрирован эффективный многомасштабный механизм внимания, Concat — к модулю конкатенации признаков, DySample — к механизму динамического повышения разрешения.

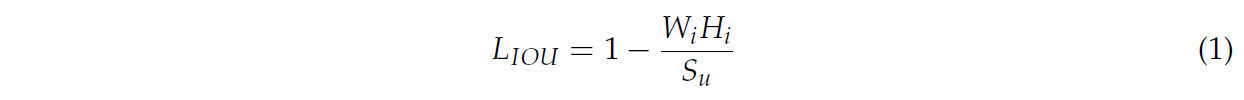

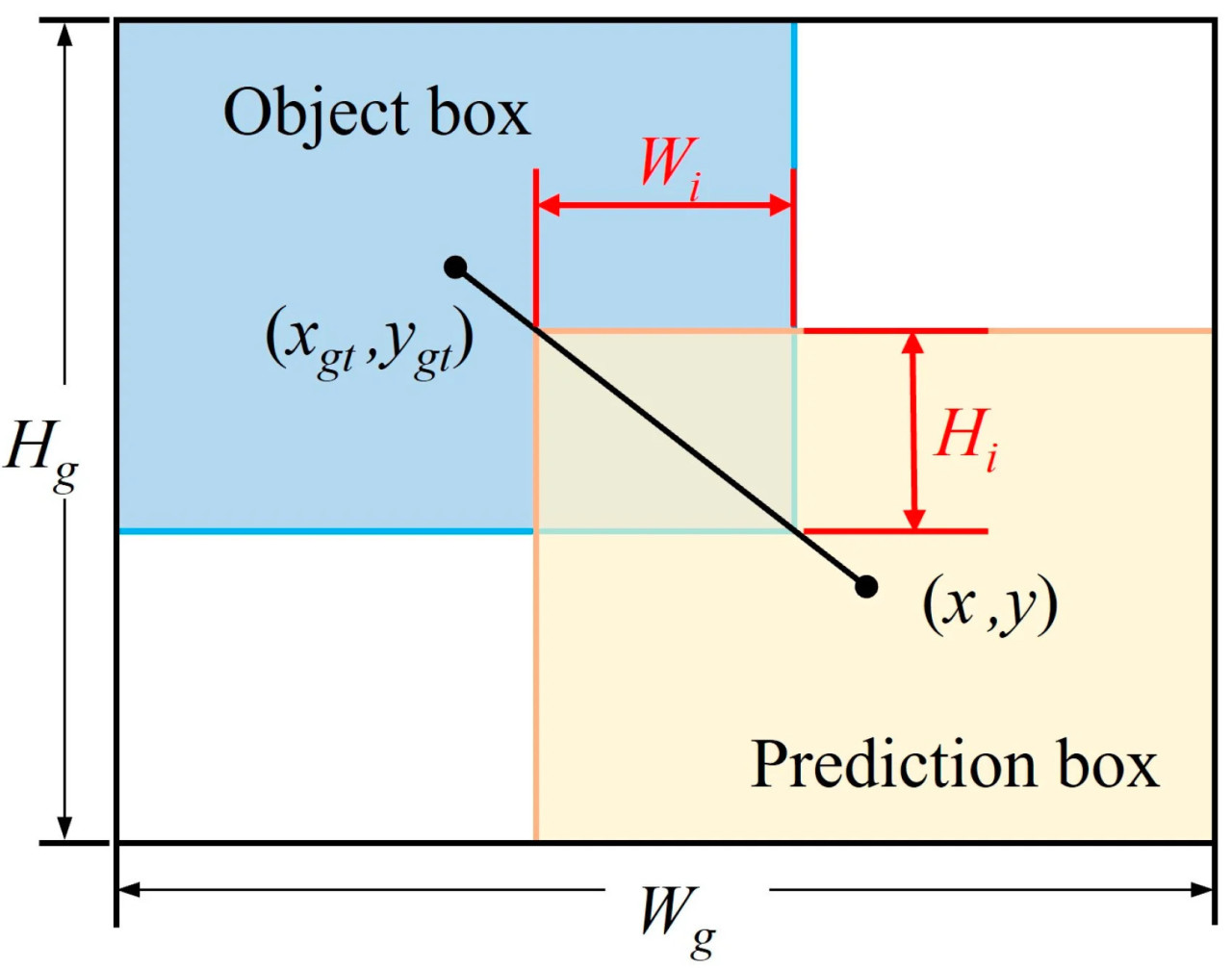

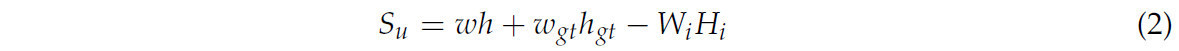

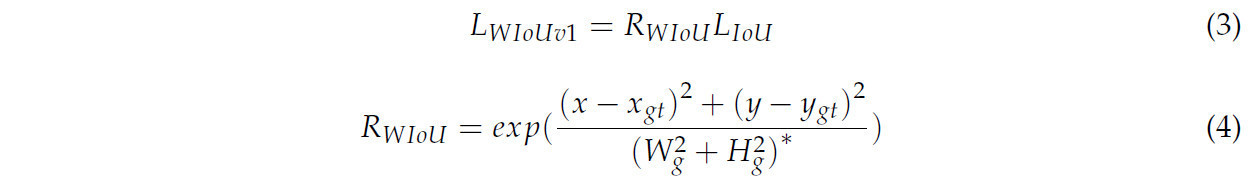

2.2.3. Функция потерь WIoU

На разных расстояниях в поле зрения фактические размер и форма красных цветков претерпевают значительные изменения. Чёткость и качество изображений, захваченных камерой, также зависят от различных размеров поля зрения. Кроме того, когда набор данных содержит большое количество образцов сафлора с низкой чёткостью, простое улучшение способности функции потерь к подгонке ограничивающей рамки не приводит к значительному улучшению её производительности локализации и может даже ухудшить её. Однако, будучи исходной функцией потерь регрессии ограничивающих рамок в YOLOv8, CIoU фокусируется исключительно на точности подгонки ограничивающей рамки. Когда предсказанная рамка и истинная рамка имеют одинаковое соотношение сторон, но различаются по ширине и высоте, CIoU может препятствовать дальнейшей оптимизации модели. Чтобы решить эту проблему, в данной статье вводится Wise-IOU (WIoU) [27] для улучшения производительности локализации ограничивающих рамок в образцах сафлора с различными уровнями чёткости в разных полях зрения. Функция потерь WIoU использует динамический немонотонный механизм фокусировки, который заменяет IoU на степень выброса (outlier degree) для оценки качества якорных рамок. Она также включает стратегию распределения градиентного усиления, которая усиливает фокус на высококачественных якорных рамках, одновременно смягчая негативное влияние низкокачественных образцов в наборе данных. Метод вычисления показан на Рисунке 5, а формула для расчёта значения потерь выглядит следующим образом:

Рисунок 5. Иллюстрация метода расчёта функции потерь WIoU. (xgt, ygt) представляет координаты центральной точки истинной ограничивающей рамки объекта; (x, y) представляет координаты центральной точки предсказанной ограничивающей рамки; Wg представляет ширину минимальной ограничивающей рамки для предсказанной ограничивающей рамки; Hg представляет высоту минимальной ограничивающей рамки для истинной ограничивающей рамки.

Su представляет площадь пересечения, а формула расчёта выглядит следующим образом:

где w и h представляют ширину и высоту предсказанной ограничивающей рамки соответственно; wgt и hgt представляют ширину и высоту истинной ограничивающей рамки объекта; Wi и Hi представляют ширину и высоту области пересечения между истинной и предсказанной ограничивающими рамками.

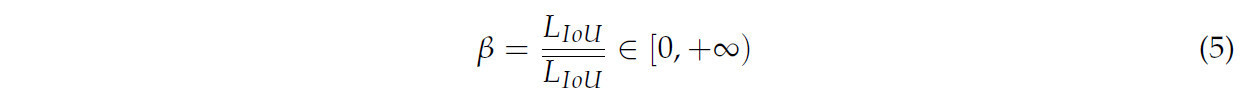

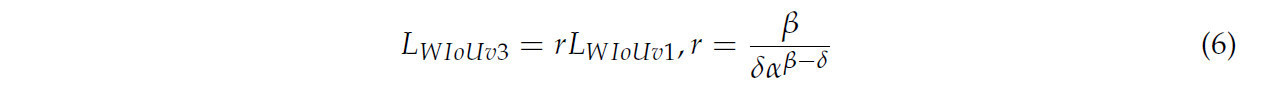

В функции потерь WIoU мы приняли более производительную WIoUv3 [28], её формула выражается следующим образом:

Когда предсказанная ограничивающая рамка перекрывается с ограничивающей рамкой объекта, потеря LIoU ослабляет штраф за геометрические факторы и смещает фокус на расстояние между центрами. Немонотонный коэффициент фокусировки RWIoU в формуле (4) помогает сбалансировать вклад градиентов, обеспечивая, чтобы низкокачественные образцы не оказывали отрицательного влияния на процесс обучения. Более того, в агрегационный фактор r вводится значение выброса β для оценки уровня аномальности якорной рамки, выраженное как:

где α и δ — гиперпараметры. Когда степень выброса якорной рамки достигает определённой константы, якорная рамка достигает наивысшего градиентного усиления. Динамические характеристики LIoU также делают критерий классификации качества β для якорных рамок динамическим. Это позволяет WIoUv3 динамически определять наиболее подходящую стратегию распределения градиентного усиления для данного сценария, позволяя модели концентрироваться больше на среднекачественных якорных рамках образцов сафлора, что, в свою очередь, повышает общую производительность обнаружения. Кроме того, инвариантность масштаба, обеспечиваемая LWIoUv3 в формуле (6), гарантирует, что модель стабильно демонстрирует постоянную производительность на образцах сафлора разного размера. Это эффективно решает значительные вариации в образцах сафлора, вызванные изменениями расстояния и окружающей среды в реальных сценариях уборки. Следовательно, модель обнаружения становится более устойчивой и точной, особенно в сложных погодных условиях, тем самым улучшая её обобщающую способность в сложных реальных сценариях уборки.

2.2.4. DySample

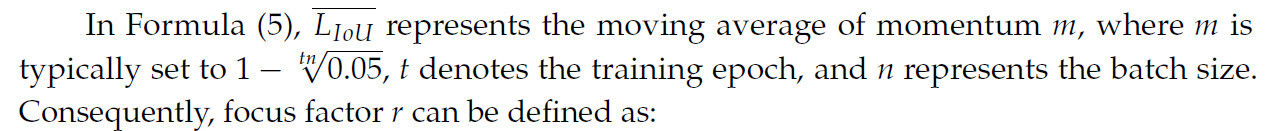

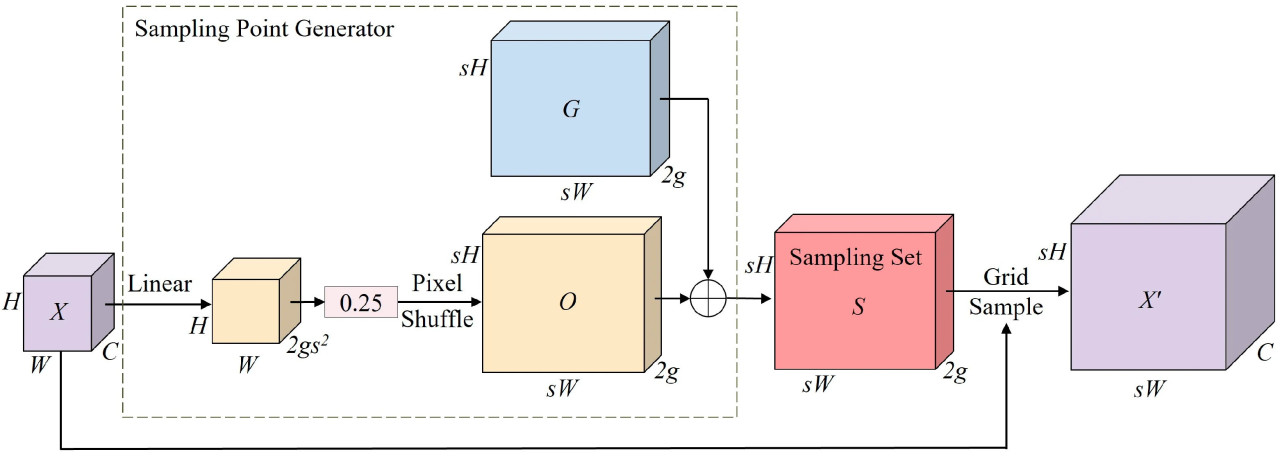

В реальных образцах изображений сафлора размер цветков варьируется в зависимости от расстояния, и образцы сафлора на заднем плане могут испытывать пиксельные искажения. Это искажение приводит к потере мелких деталей в лепестках, затрудняя для модели изучение истинных признаков образцов сафлора в задачах распознавания. YOLOv8 использует слой повышения разрешения, Upsample, в своей сети улучшения признаков шейки, который применяет алгоритм интерполяции ближайшего соседа. Этот метод полагается на ближайшие соседние пиксели и не может эффективно захватывать тонкие изменения и плотную семантическую информацию в признаках сафлора, что приводит к потере признаков. Кроме того, этот метод требует значительных вычислительных затрат и параметров. Чтобы решить эту проблему, в данной статье вводится оператор DySample [29] на основе динамического точечного сэмплирования, который направлен на улучшение способности сети к повышению разрешения для целей сафлора в сценах с низким разрешением или на дальнем расстоянии. Этот модуль уменьшает потерю признаков сафлора в процессе сэмплирования. Более того, он не требует дополнительных пакетов CUDA, предлагая значительное снижение вычислительных затрат и параметров по сравнению с исходным модулем во время работы.

Структура DySample показана на Рисунке 6. Сначала, учитывая входную карту признаков X с размерами C × H × W, коэффициент повышения разрешения s и статический коэффициент диапазона 0,25 для ограничения перемещения позиции сэмплирования. Линейный слой с указанными размерами входных и выходных каналов C и 2s2 соответственно используется для генерации смещений признаков размером H × W × 2s2. Эти смещения преобразуются в размер 2g × sH × sW с помощью операции Pixel Shuffle для получения окончательных динамических смещений O. Наконец, смещения O добавляются к исходной сетке сэмплирования G, что даёт набор сэмплирования S. Затем набор S используется для выполнения операции grid sampling с исходным входом X, создавая увеличенную карту признаков X’ размером C × sH × sW. Этот метод динамического точечного сэмплирования эффективно повышает разрешение карт признаков низкого разрешения до более высокого, что важно для распознавания сафлора. При более высоком разрешении более тонкие детали сафлора могут быть лучше сохранены и представлены, что в конечном итоге повышает точность распознавания.

Рисунок 6. Структура DySample. X, X’, O, G обозначают входную карту признаков, увеличенную карту признаков, сгенерированные смещения и исходную сетку соответственно.

2.2.5. Модуль C2f-EMA

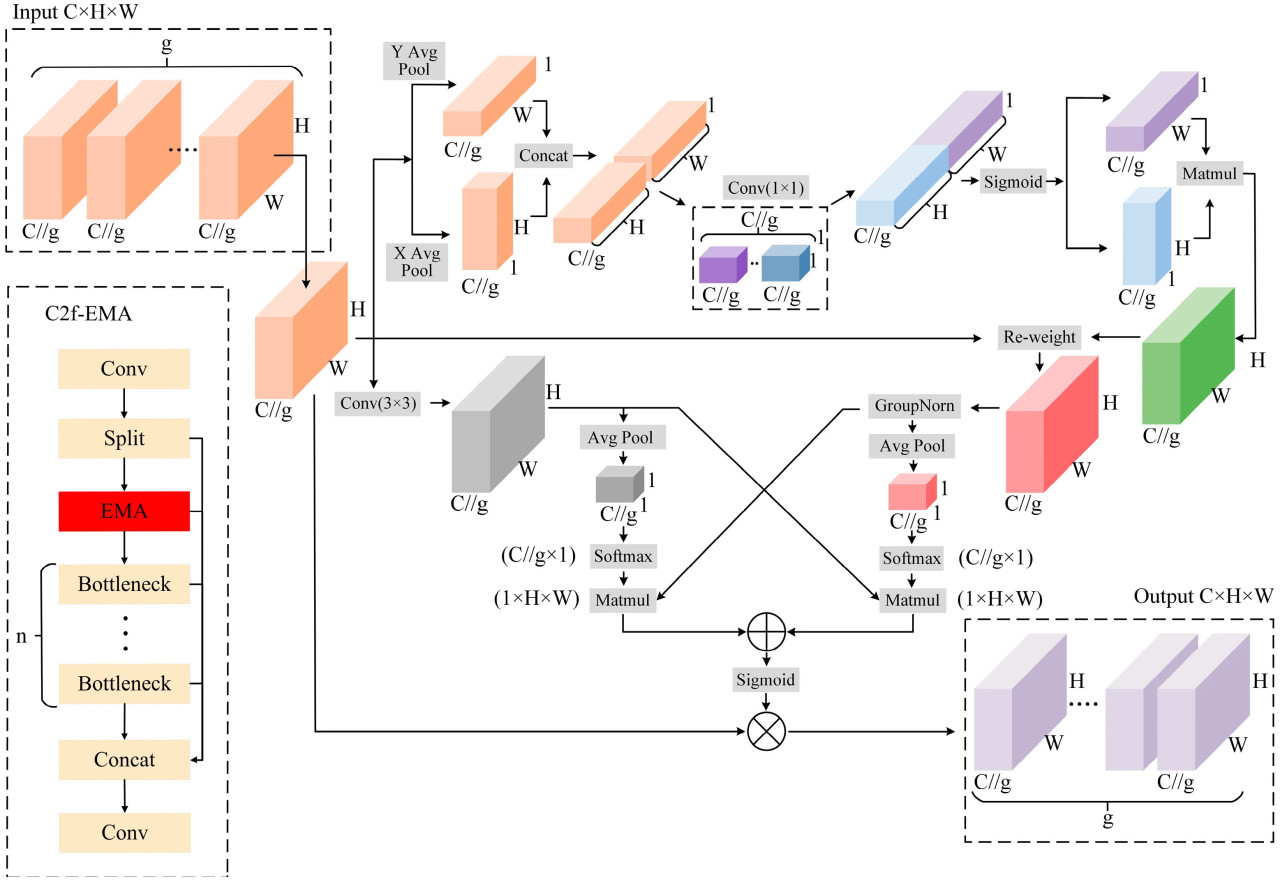

Набор данных содержит сафлор в нескольких масштабах; в то же время фон имеет много объектов, таких как ветви, листья и сорняки, цвет которых схож с цветом сафлора. Эти элементы существенно мешают обнаружению сафлора. Поэтому крайне важно эффективно извлекать признаки сафлора из сложного фона для достижения точных результатов обнаружения. Чтобы решить эту задачу, в данной статье представлен эффективный многомасштабный модуль внимания (EMA) [30], который интегрирован в модуль C2f базовой сети, образуя структуру C2f-EMA. Этот модуль изменяет форму определённых каналов в размерность пакета (batch dimension) и группирует канальные размеры в несколько подпризнаков. Это позволяет ему сохранять ключевые признаки сафлора в каждом канале, одновременно уменьшая помехи, вызванные сложным фоном. В результате улучшается способность представления признаков входного изображения, повышая общую производительность извлечения признаков сафлора.

Структура модуля EMA показана на Рисунке 7. Вход сначала группируется, а затем обрабатывается через три параллельные ветви. В двух ветвях 1 × 1 применяется одномерное глобальное среднее пулирование для кодирования каналов в обоих пространственных направлениях. Карты внимания по каналам внутри каждой группы затем комбинируются с использованием базовых операций умножения, облегчая межканальные взаимодействия между двумя параллельными путями. В ветви 3 × 3 складывается одна свёртка 3 × 3 для расширения пространства признаков, позволяя захватывать многомасштабные признаки. Два набора признаков, полученных из разных ветвей, обрабатываются через модуль кросс-пространственного обучения и функцию Sigmoid, что даёт итоговую выходную карту признаков.

Рисунок 7. Структурная схема модуля EMA. g представляет количество групп, на которые разделены входные каналы. X Avg Pool и Y Avg Pool обозначают операции одномерного глобального среднего пулинга, применяемые в горизонтальном и вертикальном направлениях соответственно. Sigmoid — это функция активации, а Softmax относится к нормированной экспоненциальной функции.

2.2.6. Слой обнаружения мелких целей

В процессе распознавания изображений мелких целей сафлора ввод чрезмерно больших изображений приводит к масштабированию, которое уменьшает пиксельное покрытие мелких целей, тем самым затрудняя точное распознавание сафлора. Чтобы решить эту задачу и повысить точность обнаружения мелких целей, сеть YOLOv8 оптимизируется путём включения дополнительной головы предсказания, специально предназначенной для обработки мелких целей. Это изменение позволяет сети более эффективно фокусироваться на образцах сафлора с меньшими размерами в пикселях, таким образом улучшая точность распознавания мелких целей [31]. В частности, сеть улучшается путём слияния выходных карт признаков из модуля C2f-EMA второго слоя и модуля динамического повышения разрешения. Это слияние интегрирует информацию на нескольких глубинах сети, эффективно связывая признаки высокого уровня с деталями низкого уровня. Такое сочетание значительно улучшает способность модели точно распознавать мелкие цели сафлора. Объединённые карты признаков комбинируются для генерации вновь созданного высокоразрешенного слоя обнаружения размером 160 × 160 × 32. Этот слой специально адаптирован для улучшения возможностей идентификации и обнаружения мелких целей сафлора.

3. Результаты

3.1. Экспериментальная установка

3.1.1. Тестовая платформа

Эксперимент проводился на системе под управлением Windows 11, с процессором Intel(R) Core (TM) i9-10700K, работающим на частоте 3,80 ГГц (базовая тактовая частота 3,79 ГГц) и видеокартой NVIDIA GeForce GTX 4070. Использовалась общая архитектура параллельных вычислений CUDA 11.0, с библиотекой ускорения глубоких нейронных сетей CUDNN V8.0.5.39. Используемый фреймворк глубокого обучения — PyTorch 1.7.1, а среда программирования — PyCharm, с языком программирования Python 3.9.

3.1.2. Метрики оценки

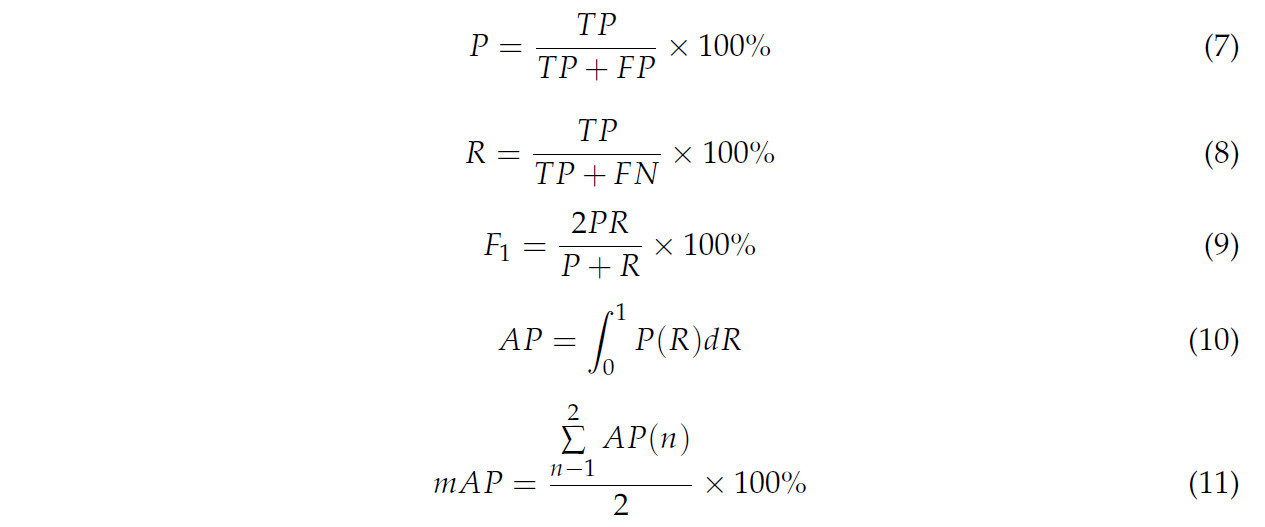

В данном исследовании выбраны следующие метрики для оценки производительности модели распознавания сафлора: точность (Precision, P), полнота (Recall, R), F1-мера (F1 score), средняя точность (Average Precision, AP) и средняя средняя точность (Mean Average Precision, mAP). AP определяется как площадь под кривой точности-полноты, где более высокое значение AP отражает превосходную производительность модели. mAP — это среднее значение AP по всем классам, рассчитанное при заданном пороге пересечения по объединению (Intersection over Union, IoU). Формулы для метрик оценки следующие:

В уравнениях TP обозначает количество правильно обнаруженных целевых объектов, FP представляет количество ложно обнаруженных целевых объектов, а FN относится к количеству целевых объектов, которые не были обнаружены. Точность (P) определяется как отношение правильно обнаруженных лепестков к общему количеству обнаруженных лепестков, выраженное в процентах. Полнота (R) — это отношение правильно обнаруженных ограничивающих рамок лепестков к общему количеству истинных ограничивающих рамок лепестков, также выраженное в процентах. F1-мера — это гармоническое среднее точности и полноты. AP представляет среднюю точность для конкретного класса лепестков сафлора, выраженную в процентах. Наконец, mAP обозначает среднюю среднюю точность, то есть среднюю точность по обоим периодам — раскрытия и опадения цветков сафлора, выраженную в процентах.

3.2. Результаты эксперимента

3.2.1. Обучение модели

Обучение проводилось с использованием гиперпараметров по умолчанию для YOLOv8n. Начальный размер изображения был установлен на 640 × 640 пикселей, с размером пакета 16. Использовалась скорость обучения 0,01, а также коэффициент затухания весов 0,0005 и коэффициент импульса 0,937. Модель обучалась в общей сложности 1000 итераций, и анализировались оптимальные результаты. Как показано на Рисунке 8, кривая функции потерь и кривая mAP в процессе обучения показывают, что с увеличением числа итераций общая потеря уменьшается. Как показано на Рисунке 8a, когда число итераций обучения достигает 900, кривая потерь начинает выходить на плато и в конечном итоге стабилизируется на минимальном значении 0,080. Одновременно кривая mAP неуклонно растёт с каждой итерацией обучения и в конечном итоге достигает стабильности. Как показано на Рисунке 8b, mAP (при IoU = 0,5) достигает значения 95,03%. Тренды кривых на протяжении всего процесса обучения эффективно отражают прогресс обучения модели и общую эффективность обучения.

Рисунок 8. Результаты обучения: (a) кривая потерь и (b) кривая mAP.

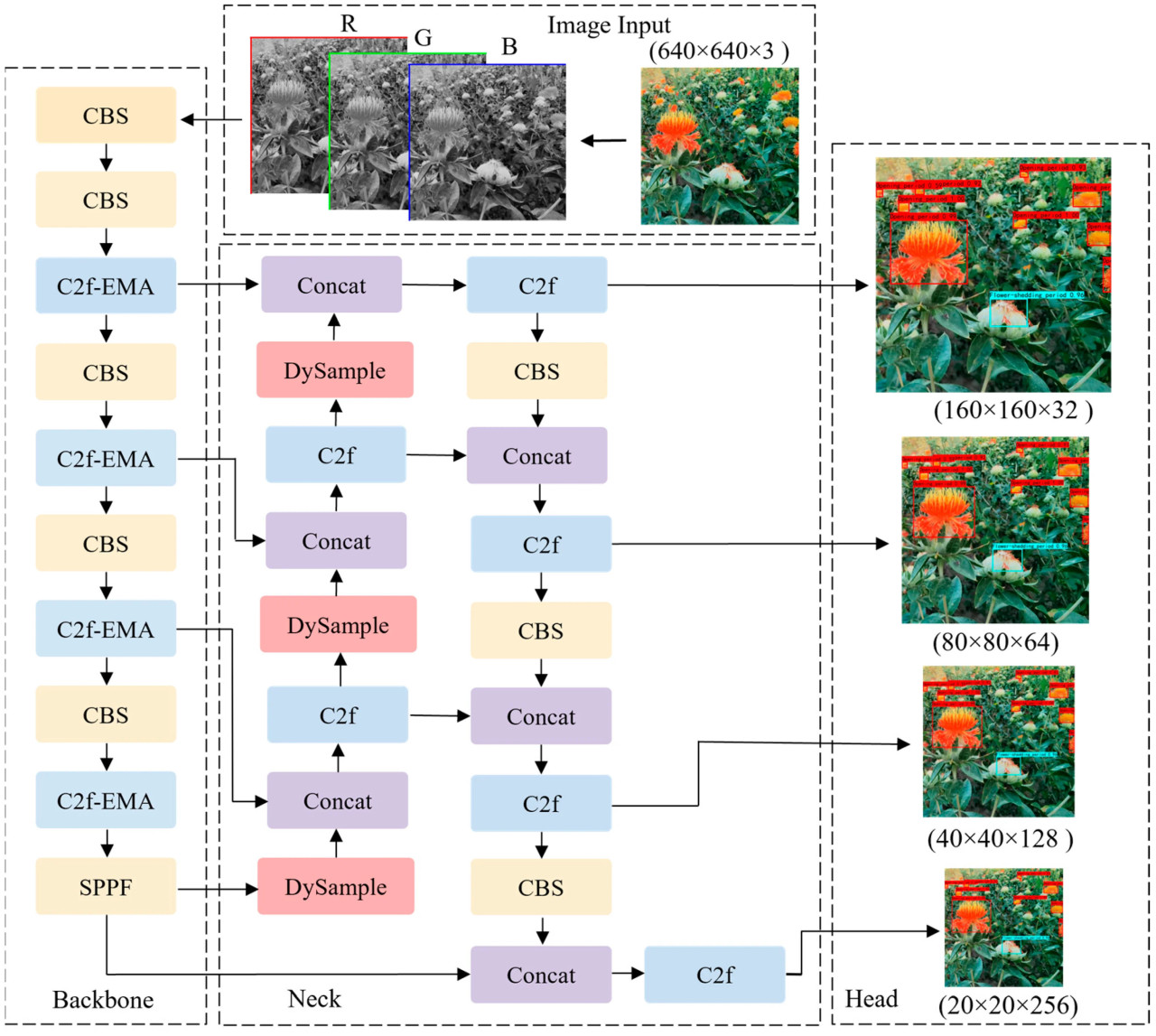

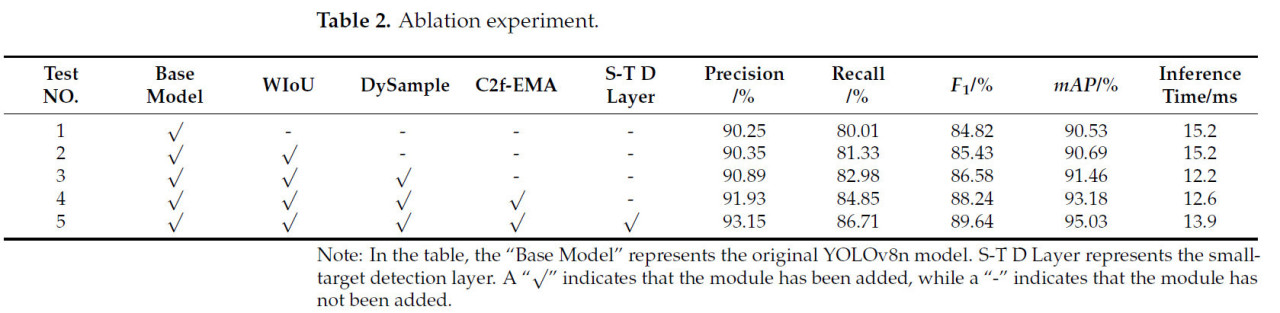

3.2.2. Абляционный эксперимент

Чтобы оценить вклад предложенных улучшений в общую производительность модели, были проведены абляционные эксперименты, и результаты представлены в Таблице 1. Как показано в таблице, замена функции потерь на WIoU привела к улучшениям в точности, полноте и mAP, демонстрируя, что функция потерь WIoU улучшает способность модели к подгонке и точность распознавания. Кроме того, когда модуль повышения разрешения в шейке сети был заменён на модуль динамического повышения разрешения, модель достигла увеличения на 0,54%, 1,65%, 1,15% и 0,77% в точности, полноте, F1-мере и mAP соответственно по сравнению с Тестом №2. В то же время время вывода изображений сократилось на 3 мс. Это улучшение связано с модулем DySample. Он не требует дополнительных пакетов CUDA, что отличает его от традиционных методов повышения разрешения. В результате он значительно снижает вычислительные затраты и затраты на параметры, тем самым повышая общую вычислительную эффективность. Эти результаты указывают на то, что модуль DySample эффективно усиливает способность модели обнаруживать сафлор с низким разрешением и мелкие цели. Более того, когда модуль C2F в базовой сети был заменён на модуль C2f-EMA, модель показала существенные улучшения в точности, полноте, F1-мере и mAP по сравнению с Тестом №3. Улучшения составили 1,04%, 1,87%, 1,66% и 1,72% соответственно. Эти данные свидетельствуют о том, что включение механизма внимания значительно увеличивает фокус модели на мелких целях сафлора. Наконец, улучшенная модель YOLOv8n, предложенная в этом исследовании, продемонстрировала немного большее время вывода по сравнению с Тестом №4, но достигла наилучшей производительности по всем остальным метрикам оценки. Она превзошла Тест №4 по точности, полноте, F1-мере и mAP на 1,22%, 1,86%, 1,4% и 1,85% соответственно. При времени вывода изображения 13,9 мс она способна соответствовать требованиям практических сценариев уборки. Это указывает на то, что вновь введённый слой обнаружения мелких целей эффективно улучшает способность модели обнаруживать мелкие цели сафлора, тем самым повышая общую производительность обнаружения.

4. Обсуждение

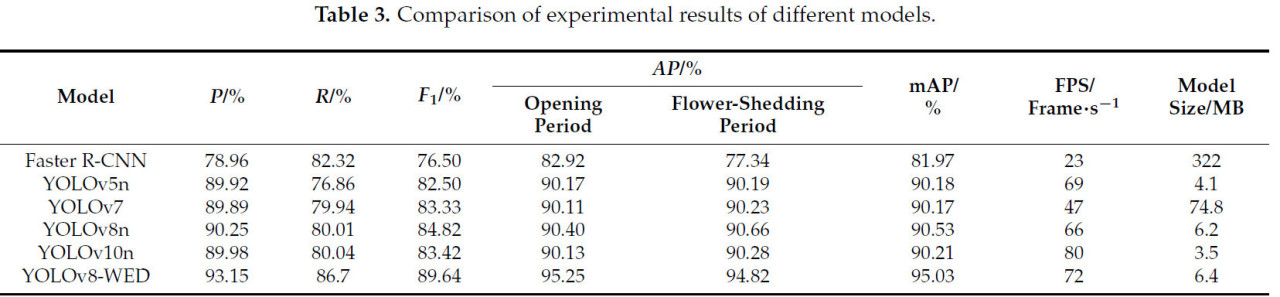

4.1. Сравнение различных методов обнаружения объектов

Чтобы дополнительно подтвердить преимущества улучшенного алгоритма YOLOv8 в распознавании красных цветков (сафлора), был проведён сравнительный эксперимент с использованием моделей обнаружения объектов Faster R-CNN, YOLOv5n, YOLOv7, YOLOv8n и YOLOv10n. Эксперименты проводились с использованием созданного набора данных по красным цветкам для обучения с последующей оценкой на том же тестовом наборе для шести сетей обнаружения. Результаты экспериментов показаны в Таблице 2.

Таблица 2. Абляционный эксперимент.

Как показано в Таблице 3, двухэтапный алгоритм обнаружения Faster R-CNN демонстрирует самую низкую точность обнаружения, самую низкую скорость вывода и наибольший размер модели, что делает его непригодным для обнаружения мелких целей сафлора. Среди одноэтапных алгоритмов обнаружения YOLOv5n, YOLOv7, YOLOv8n и YOLOv10 показывают схожую производительность с точки зрения точности, полноты, mAP и F1-меры. Однако YOLOv7 показывает плохие результаты по скорости вывода и размеру модели, с размером модели 74,8 МБ, что значительно больше, чем у трёх других алгоритмов. Улучшенная модель YOLOv8n демонстрирует наилучшую производительность по точности, полноте, mAP и F1-мере. Причина заключается в том, что лепестки занимают лишь небольшое количество пикселей на изображениях, что приводит к ухудшению качества признаков лепестков сафлора. Это затрудняет достижение удовлетворительных результатов для других алгоритмов с более слабыми возможностями обнаружения мелких объектов. В отличие от этого, алгоритм WED-YOLO значительно улучшает производительность обнаружения мелких объектов и способность к извлечению признаков благодаря улучшениям, упомянутым в разделе 2.2.2, при этом его значение mAP существенно превосходит другие алгоритмы. В частности, его точность превышает таковую у Faster R-CNN, YOLOv5n, YOLOv7n, YOLOv8n и YOLOv10 на 14,19%, 3,23%, 3,26%, 2,9% и 3,17% соответственно; полнота превышает на 4,38%, 9,84%, 6,76%, 6,69% и 6,66%; mAP превышает на 13,06%, 4,85%, 4,86%, 4,5% и 4,82%; F1-мера превышает на 13,14%, 7,14%, 6,31%, 4,82% и 6,22% соответственно. Скорость вывода улучшенного YOLOv8n составляет 72 кадра в секунду (FPS), что немного ниже скорости YOLOv10n, но имеет более высокое значение mAP. Среди этих моделей предложенный алгоритм демонстрирует наивысший mAP в обнаружении мелкого сафлора, с умеренным весом модели, что делает его подходящим для точного обнаружения сафлора как в периоды раскрытия, так и опадения цветков.

Таблица 3. Сравнение экспериментальных результатов различных моделей.

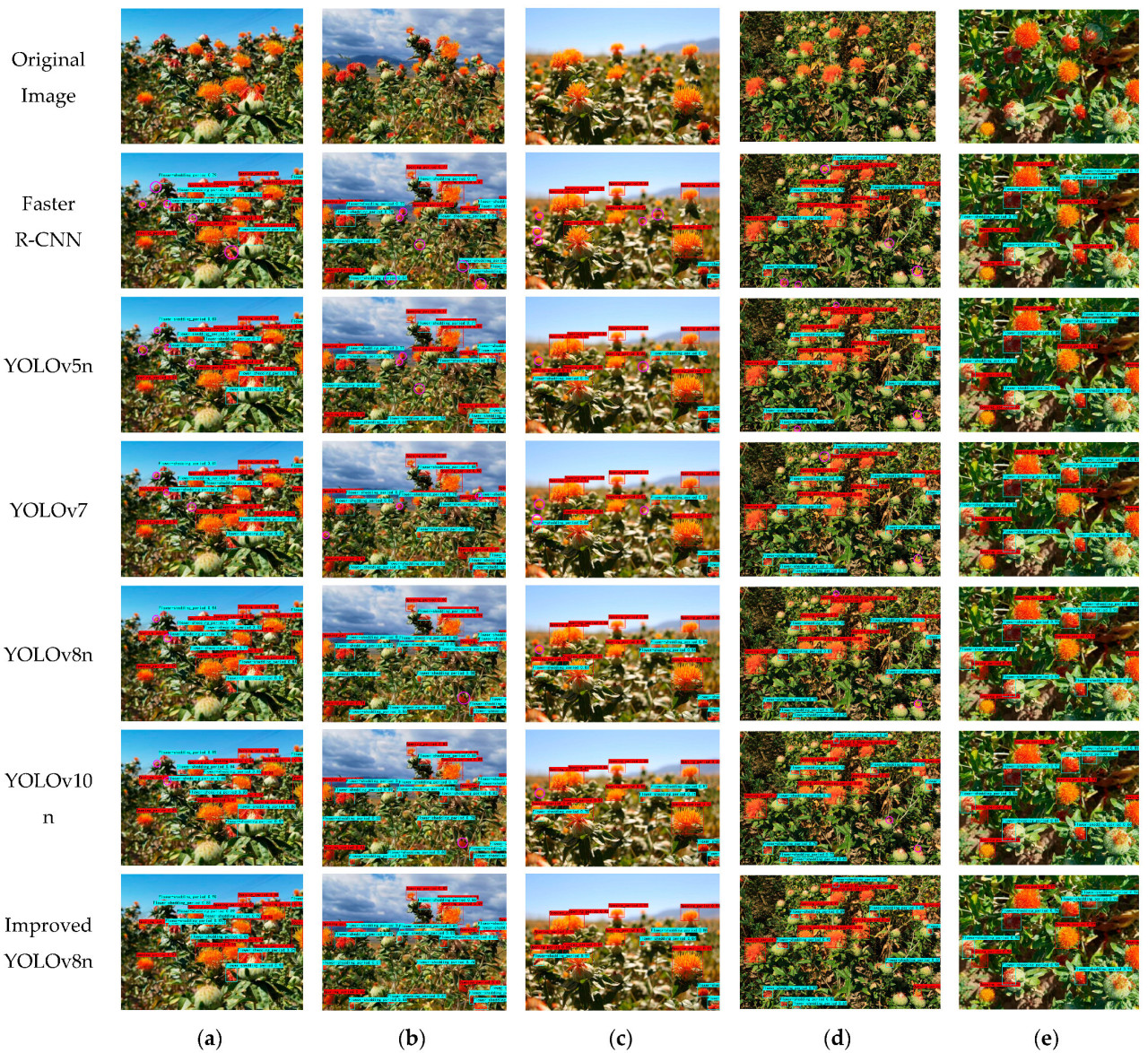

Чтобы оценить производительность обнаружения при различных погодных условиях, мы выбрали по одному изображению для каждого погодного условия — солнечного, облачного и пасмурного — снятого на разных расстояниях (дальнем и близком). Показаны результаты обнаружения шести моделей. Красная рамка обнаружения с пометкой "Flower-opening period" (период раскрытия) указывает на обнаружение сафлора в период цветения, а синяя рамка обнаружения с пометкой "Flower-shedding period" (период опадения) указывает на сафлор в период опадения. Числа после меток представляют значения достоверности обнаружения. Как показано на Рисунке 9, из-за того, что сеть генерации регионов-кандидатов двухэтапного алгоритма обнаружения сильно зависит от карт признаков большого масштаба для генерации кандидатных рамок, Faster R-CNN с трудом захватывает многомасштабные признаки в сцене, что приводит к плохому обнаружению мелких целей сафлора. Это приводит к значительным пропускам, при этом многие мелкие цели сафлора не генерируются или распознаются сетью регионов-кандидатов правильно. YOLOv5n, YOLOv7, YOLOv8n и YOLOv10 демонстрируют схожую производительность обнаружения, с лишь несколькими пропущенными обнаружениями. Например, на пасмурных изображениях есть некоторые образцы сафлора на дальнем расстоянии, из-за чего признаки сафлора имеют низкое качество на изображениях. При обработке этих низкокачественных изображений сафлора YOLOv5n и YOLOv7 обнаружили 9 цветков сафлора в периоде раскрытия и 12 — в периоде опадения. Между тем, YOLOv8n и YOLOv10n обнаружили 8 цветков в периоде раскрытия и 15 — в периоде опадения. Все эти модели превзошли Faster R-CNN и показали похвальную производительность. Однако некоторые цветки сафлора с низкокачественными признаками всё ещё были неправильно идентифицированы всеми моделями. Только улучшенная модель YOLOv8n достигла наилучшей производительности обнаружения. На пасмурных изображениях она обнаружила 9 цветков сафлора в периоде раскрытия и 16 — в периоде опадения, превзойдя все другие модели. Аналогично, на облачных изображениях также были некоторые образцы сафлора с размытыми внешними контурами и низкокачественными признаками. Все модели пропустили обнаружение в этих случаях, но улучшенная модель YOLOv8n показала лучший результат. Это превосходство можно объяснить улучшенной способностью улучшенной модели извлекать признаки мелких целей сафлора, что позволяет ей эффективно распознавать сафлор на изображениях низкого качества.

Рисунок 9. Эффекты обнаружения различных моделей на изображениях сафлора при различной погоде и дистанции съёмки: (a) Солнечно, (b) пасмурно, (c) облачно, (d) дальнее расстояние и (e) близкое расстояние. Красные рамки обозначают лепестки в периоде раскрытия, синие рамки обозначают лепестки в периоде опадения, а розовые рамки обозначают лепестки, которые были пропущены во время обнаружения.

4.2. Сравнение различных функций потерь

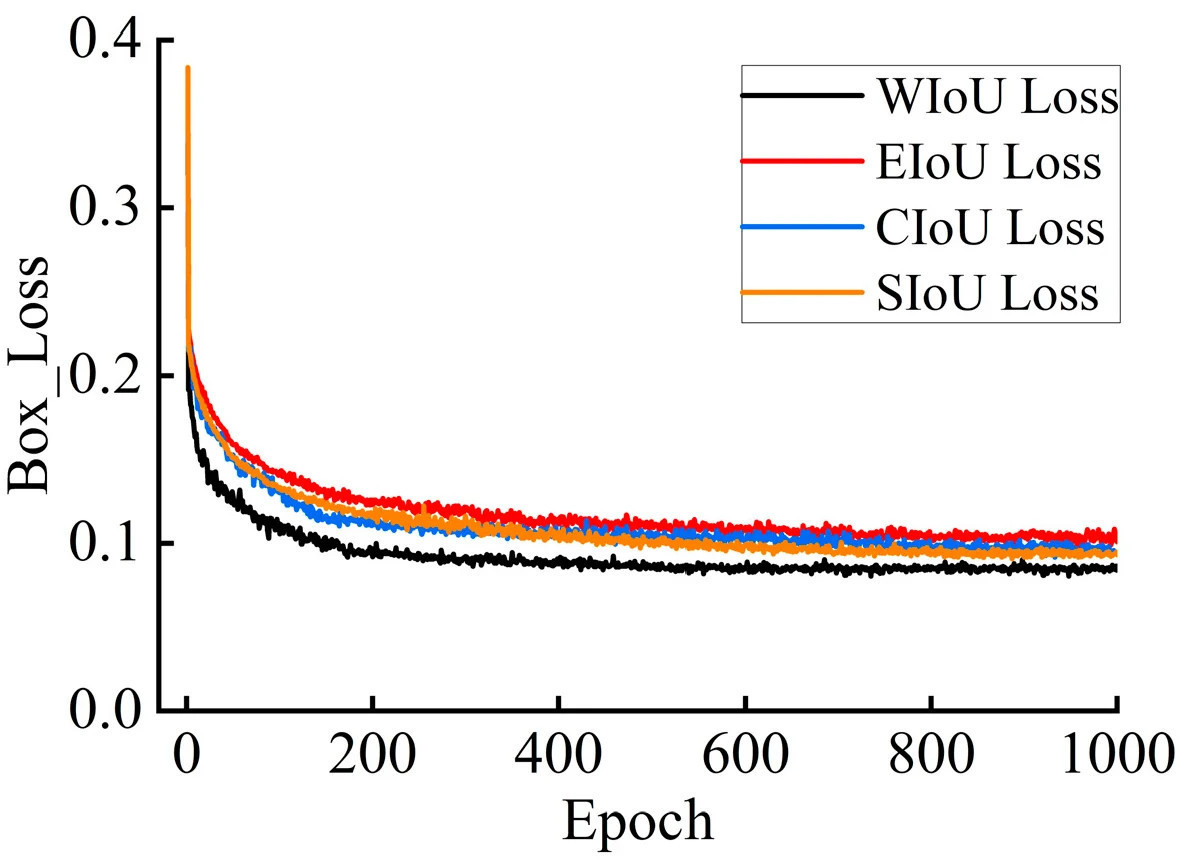

Исходная модель обнаружения объектов YOLOv8 использует CIoU в качестве своей функции потерь регрессии ограничивающих рамок. Во время обучения эта функция потерь демонстрирует сильную способность к подгонке; однако, поскольку соотношение сторон предсказанной рамки является относительным значением, в вычислении присутствует внутренняя неопределённость. Кроме того, как высококачественные, так и низкокачественные ошибочные предсказания негативно влияют на потерю регрессии. В данном исследовании изучается поведение сходимости улучшенной модели YOLOv8 с различными функциями потерь, включая WIoU, CIoU, EIoU [32] и SIoU [33]. Результаты экспериментов проиллюстрированы на графике сравнения потерь.

Как показано на Рисунке 10, при использовании EIoU скорость сходимости самая медленная, а конечное значение потерь — самое высокое. Скорость сходимости SIoU и CIoU немного выше, чем у EIoU, с конечными значениями потерь немного ниже, чем у EIoU. Однако при использовании WIoU модель демонстрирует самый быстрый градиентный спуск во время обучения, быстро сходясь в течение первых 300 эпох и достигая конечного значения потерь, значительно более низкого, чем у трёх других функций потерь. Кроме того, как указано в Таблице 1 абляционного исследования, использование WIoU привело к улучшениям по различным метрикам оценки, включая точность, полноту и mAP.

Рисунок 10. Сходимость различных функций потерь для ограничивающих рамок. CIoU Loss указывает, что модель использует CIoU в качестве функции потерь для ограничивающих рамок. EIoU Loss указывает, что модель использует EIoU в качестве функции потерь для ограничивающих рамок. SIoU Loss указывает, что модель использует SIoU в качестве функции потерь для ограничивающих рамок. WIoU Loss указывает, что модель использует WIoU в качестве функции потерь для ограничивающих рамок.

4.3. Визуализация тепловой карты

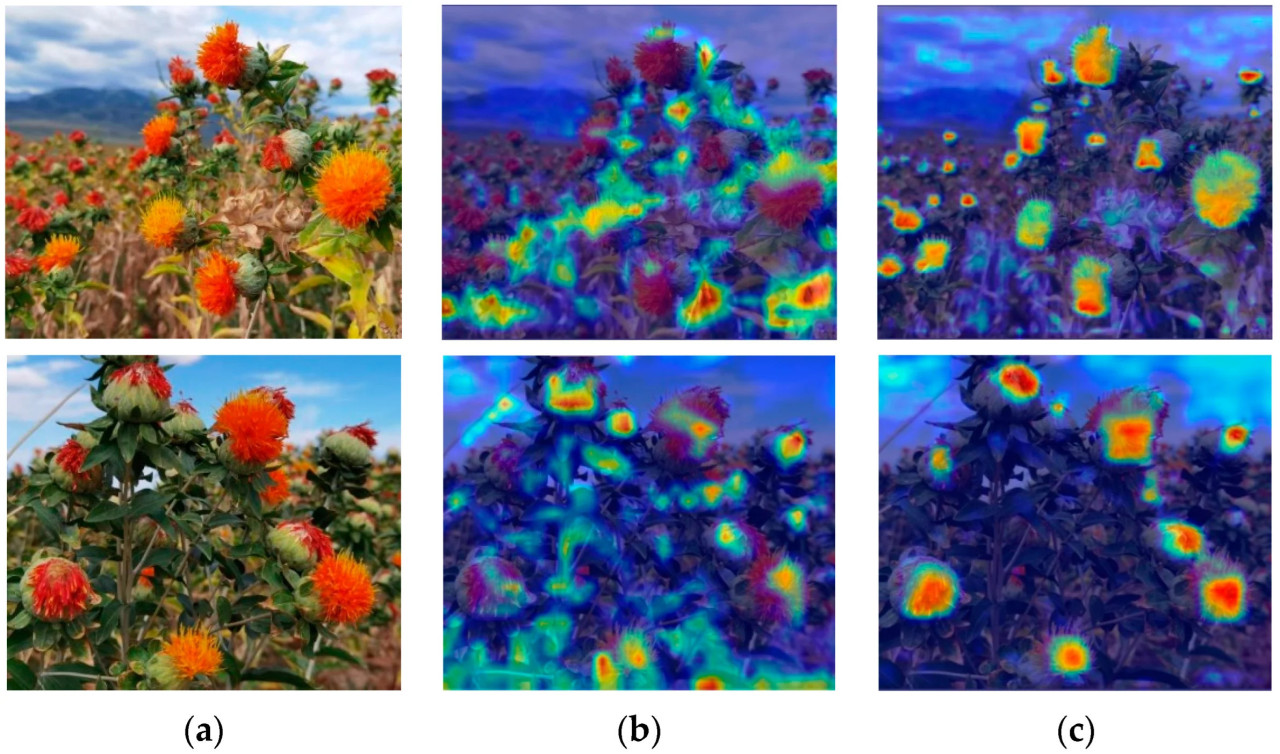

Чтобы наглядно продемонстрировать эффект оптимизации предложенной модели WED-YOLOv8 на наборе данных красных цветков, для визуализации использовался алгоритм Gradient-weighted Class Activation Mapping (Grad-CAM) [34]. На тепловой карте разные цвета указывают на важность каждой позиции на изображении для задачи обнаружения красных цветков. Более тёмные цвета указывают на области, на которых модель концентрирует больше внимания. Как показано на Рисунке 11, YOLOv8n подвержен влиянию шума от фоновой области во время обнаружения, что заставляет модель фокусироваться на нерелевантных фоновых регионах. В отличие от этого, улучшенная модель значительно снижает внимание к шуму от фона, позволяя точно фокусироваться на области красных цветков. Это показывает, что улучшенная модель лучше извлекает признаки красных цветков в сложных условиях, тем самым повышая точность модели в задачах распознавания и обнаружения в условиях сложного фона.

Рисунок 11. Результаты визуализации тепловой карты. (a) Исходное изображение, (b) YOLOv8 и (c) WED-YOLO. Цвета представляют скаляр одной величины, при этом тёплые цвета (например, красный или жёлтый) указывают на области высокой активности или важности, а холодные цвета (например, синий или зелёный) указывают на области низкой активности или важности.

5. Выводы

Для достижения точного распознавания сафлора в сложных неструктурированных условиях предложена новая методология обнаружения, WED-YOLO. Во-первых, были выбраны образцы сафлора как из периода раскрытия, так и из периода опадения цветков в качестве целей обнаружения для создания набора данных по сафлору. Были реализованы ряд надёжных техник аугментации данных, включая случайное затенение и увеличение яркости, для повышения разнообразия набора данных. Далее, исходная функция потерь CIoU модели была заменена на WIoU, что смягчило негативные эффекты низкокачественных образцов в наборе данных сафлора, улучшило производительность подгонки модели и ускорило сходимость сети. Впоследствии, механизм повышения разрешения в шейке сети, UpSample, был заменён на механизм динамического повышения разрешения, DySample, который дополнительно усиливает способность модели к обнаружению мелких целей сафлора на изображениях низкого разрешения или в дальнем поле зрения, улучшая способность к обучению и устойчивость модели. Основываясь на этом, механизм внимания EMA был интегрирован в модуль C2f базовой сети, усиливая способность модели к извлечению признаков сафлора. Наконец, был добавлен слой обнаружения мелких целей, чтобы позволить сети больше фокусироваться на более мелких образцах сафлора, тем самым повышая точность распознавания мелких целей сафлора. По сравнению с другими алгоритмами обнаружения, включая Faster R-CNN, YOLOv5n, YOLOv7, YOLOv8n и YOLOv10n, предложенная модель WED-YOLO продемонстрировала превосходную производительность, достигнув наивысшего значения mAP (mAP = 95,03%). Она превосходит упомянутые модули на 13,06%, 4,85%, 4,86%, 4,5% и 4,82% соответственно. Производительность также более сбалансирована с точки зрения точности обнаружения и скорости обнаружения, с умеренным размером модели. Результаты экспериментов демонстрируют, что модель WED-YOLO эффективна для распознавания сафлора в сложных неструктурированных условиях. Точность соответствует требованиям роботов для уборки сафлора, предоставляя алгоритмическую основу для интеллектуальной уборки сафлора.

В будущих исследованиях будет важно собрать большее разнообразие изображений сафлора для улучшения разнообразия набора данных. В то же время модель YOLOv8 будет подвергаться дальнейшим улучшениям и оптимизациям, чтобы более эффективно адаптироваться к задачам обнаружения в различных сценариях, облегчая расширение модели YOLOv8-WED. Более того, если применять её к задачам в реальном времени, таким как динамический подсчёт сафлора, вычислительная эффективность подхода должна быть дополнительно улучшена. Эти задачи останутся в центре продолжающихся исследований и изысканий в будущих исследовательских усилиях.

Ссылки

1. Kassa, B.A.; Mekbib, F.; Assefa, K. Effects of plant hormones and genotypes on anther culture response of safflower (Carthamus tinctorius L.). Sci. Afr. 2024, 26, e02367. [Google Scholar] [CrossRef]

2. Chen, Y.; Li, M.; Wen, J.; Pan, X.; Deng, Z.; Chen, J.; Chen, G.; Yu, L.; Tang, Y.; Li, G.; et al. Pharmacological activities of safflower yellow and its clinical applications. Evid.-Based Complement. Altern. Med. 2022, 2022, 2108557. [Google Scholar] [CrossRef] [PubMed]

3. Gongal, A.; Amatya, S.; Karkee, M.; Zhang, Q.; Lewis, K. Sensors and systems for fruit detection and localization: A review. Comput. Electron. Agric. 2015, 116, 8–19. [Google Scholar] [CrossRef]

4. Zhang, Z.; Guo, J.; Yang, S.; Zhang, X.; Niu, Q.; Han, C.; Lv, Q. Feasibility of high-precision numerical simulation technology for improving the harvesting mechanization level of safflower filaments: A review. Int. Agric. Eng. J. 2020, 29, 139–150. [Google Scholar]

5. Zhang, Z.; Xing, Z.; Yang, S.; Feng, N.; Liang, R.; Zhao, M. Design and experiments of the circular arc progressive type harvester for the safflower filaments. Trans. Chin. Soc. Agric. Eng. 2022, 38, 10–21. [Google Scholar] [CrossRef]

6. Fan, X.; Zhou, J.; Xu, Y.; Li, K.; Wen, D. Identification and localization of weeds based on optimized faster R-CNN in cotton seedling stage. Trans. Chin. Soc. Agric. Mach. 2021, 52, 26–34. [Google Scholar] [CrossRef]

7. Lin, G.; Tang, Y.; Zou, X.; Li, J.; Xiong, J. In-field citrus detection and localisation based on RGB-D image analysis. Biosyst. Eng. 2019, 186, 34–44. [Google Scholar] [CrossRef]

8. Deng, X.; Zhou, B.; Hou, Y. A reliability test method for agricultural paddy field intelligent robot. NMATEH-Agric. Eng. 2021, 3, 271–280. [Google Scholar] [CrossRef]

9. Farjon, G.; Krikeb, O.; Hillel, A.B.; Alchanatis, V. Detection and counting of flowers on apple trees for better chemical thinning decisions. Precis Agric. 2020, 21, 503–521. [Google Scholar] [CrossRef]

10. Ren, S.; He, K.; Girshick, R.; Sun, J. Faster R-CNN: Towards real-time object detection with region proposal networks. IEEE Trans. Pattern Anal. Mach. Intell. 2016, 39, 1137–1149. [Google Scholar] [CrossRef]

11. Zhang, Z.; Shi, R.; Xing, Z.; Guo, Q.; Zeng, C. Improved Faster Region-Based Convolutional Neural Networks (R-CNN) model based on split attention for the detection of safflower filaments in natural environments. Agronomy 2023, 13, 2596. [Google Scholar] [CrossRef]

12. Bhattarai, U.; Bhusal, S.; Majeed, Y.; Karkee, M. Automatic blossom detection in apple trees using deep learning. IFAC-PapersOnLine 2020, 53, 15810–15815. [Google Scholar] [CrossRef]

13. Tian, Y.; Yang, G.; Wang, Z.; Li, E.; Liang, Z. Instance segmentation of apple flowers using the improved mask R–CNN model. Biosyst. Eng. 2020, 193, 264–278. [Google Scholar] [CrossRef]

14. Zhang, Z.; Xing, Z.; Zhao, M.; Yang, S.; Guo, Q.; Shi, R.; Zeng, C. Detecting safflower filaments using an improved YOLOv3 under complex environments. Trans. Chin. Soc. Agric. Eng. 2023, 39, 162–170. [Google Scholar] [CrossRef]

15. Guo, H.; Chen, H.; Gao, G.; Zhou, W.; Wu, T.; Qiu, Z. Safflower corolla object detection and spatial positioning methods based onYOLO v5m. Trans. Chin. Soc. Agric. Mach. 2023, 54, 272–281. [Google Scholar] [CrossRef]

16. WANG, X.; XU, Y.; ZHOU, J.; CHEN, J. Safflower picking recognition in complex environments based on an improved YOLOv7. Trans. Chin. Soc. Agric. Eng. 2023, 39, 169–176. [Google Scholar] [CrossRef]

17. Wang, Z.; Jin, L.; Wang, S.; Xu, H. Apple stem/calyx real-time recognition using YOLO-v5 algorithm for fruit automatic loading system. Postharvest Biol. Technol. 2022, 185, 111808. [Google Scholar] [CrossRef]

18. Bhattarai, U.; Bhusal, S.; Zhang, Q.; Karkee, M. AgRegNet: A deep regression network for flower and fruit density estimation, localization, and counting in orchards. Comput. Electron. Agric. 2024, 227, 109534. [Google Scholar] [CrossRef]

19. Dias, P.A.; Tabb, A.; Medeiros, H. Multispecies fruit flower detection using a refined semantic segmentation network. IEEE Robot. Autom. Lett. 2018, 3, 3003–3010. [Google Scholar] [CrossRef]

20. Qi, C.; Gao, J.; Pearson, S.; Harman, H.; Chen, K.; Shu, L. Tea chrysanthemum detection under unstructured environments using the TC-YOLO model. Expert Syst. Appl. 2022, 193, 116473. [Google Scholar] [CrossRef]

21. Bai, Y.; Yu, J.; Yang, S.; Ning, J. An improved YOLO algorithm for detecting flowers and fruits on strawberry seedlings. Biosyst. Eng. 2024, 237, 1–12. [Google Scholar] [CrossRef]

22. Zhao, C.; Wen, C.; Lin, S.; Guo, W.; Long, J. Tomato florescence recognition and detection method based on cascaded neural network. Trans. Chin. Soc. Agric. Eng. 2020, 36, 143–152. [Google Scholar] [CrossRef]

23. Liu, W.; Ren, G.; Yu, R.; Guo, S.; Zhu, J.; Zhang, L. Image-adaptive YOLO for object detection in adverse weather conditions. In Proceedings of the AAAI Conference on Artificial Intelligence, Virtually, 22 February–1 March 2022; Volume 36, pp. 1792–1800. [Google Scholar] [CrossRef]

24. Jiang, F.; Zhang, H.; Feng, C.; Zhu, C. A Closed-Loop Detection Algorithm for Indoor Simultaneous Localization and Mapping Based on You Only Look Once v3. Traitement du Signal 2022, 39, 109–117. [Google Scholar] [CrossRef]

25. Rahim, U.F.; Mineno, H. Data augmentation method for strawberry flower detection in non-structured environment using convolutional object detection networks. J. Agric. Crop Res. 2020, 8, 260–271. [Google Scholar] [CrossRef]

26. Wang, C.Y.; Bochkovskiy, A.; Liao, H.Y.M. YOLOv7: Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, Vancouver, BC, Canada, 17–24 June 2023; pp. 7464–7475. [Google Scholar] [CrossRef]

27. Tong, Z.; Chen, Y.; Xu, Z.; Yu, R. Wise-IoU: Bounding box regression loss with dynamic focusing mechanism. arXiv 2023, arXiv:2301.10051. [Google Scholar] [CrossRef]

28. Xu, X.; Zhang, G.; Zheng, W.; Zhao, A.; Zhong, Y.; Wang, H. High-precision detection algorithm for metal workpiece defects based on deep learning. Machines 2023, 11, 834. [Google Scholar] [CrossRef]

29. Liu, W.; Lu, H.; Fu, H.; Cao, Z. Learning to upsample by learning to sample. In Proceedings of the IEEE/CVF International Conference on Computer Vision, Paris, France, 2–3 October 2023; pp. 6027–6037. [Google Scholar]

30. Ouyang, D.; He, S.; Zhang, G.; Luo, M.; Guo, H.; Zhan, J.; Huang, Z. Efficient multi-scale attention module with cross-spatial learning. In Proceedings of the ICASSP 2023—2023 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), Rhodes Island, Greece, 4–10 June 2023; IEEE: Piscataway, NJ, USA, 2023; pp. 1–5. [Google Scholar] [CrossRef]

31. Pan, Y.; Xiao, X.; Hu, K.; Kang, H.; Jin, Y.; Chen, Y.; Zou, X. Odn-pro: An improved model based on yolov8 for enhanced instance detection in orchard point clouds. Agronomy 2024, 14, 697. [Google Scholar] [CrossRef]

32. Zhang, Y.F.; Ren, W.; Zhang, Z.; Jia, Z.; Wang, L.; Tan, T. Focal and efficient IOU loss for accurate bounding box regression. Neurocomputing 2022, 506, 146–157. [Google Scholar] [CrossRef]

33. Gevorgyan, Z. SIoU Loss: More Powerful Learning for Bounding Box Regression. arXiv 2022, arXiv:2205.12740. [Google Scholar] [CrossRef]

34. Selvaraju, R.R.; Cogswell, M.; Das, A.; Vedantam, R.; Parikh, D.; Batra, D. Grad-CAM: Visual explanations from deep networks via gradient-based localization. Int. J. Comput. Vis. 2020, 128, 336–359. [Google Scholar] [CrossRef]

Zhang Z, Wang Y, Xu P, Shi R, Xing Z, Li J. WED-YOLO: A Detection Model for Safflower Under Complex Unstructured Environment. Agriculture. 2025; 15(2):205. https://doi.org/10.3390/agriculture15020205

Перевод статьи «WED-YOLO: A Detection Model for Safflower Under Complex Unstructured Environment» авторовUsturo., оригинал доступен по ссылке. Лицензия: CC BY. Изменения: переведено на русский язык

Комментарии (0)