Как научить робота точно срезать цитрусовые: быстрый и легкий алгоритм на базе YOLOv8

Локализация точек сбора цитрусовых имеет решающее значение для автоматизированной уборки урожая цитрусовых. В связи со сложными условиями произрастания цитрусовых и ограничениями оборудования, разработка эффективного метода локализации точек сбора является актуальной задачей исследований. В данном исследовании разработан новый и эффективный рабочий процесс локализации точек сбора цитрусовых, названный CPPL.

Аннотация

CPPL реализуется в два этапа: этап обнаружения и этап сегментации. На этапе обнаружения мы определяем модель KD-YOLOP для точного обнаружения плодов цитрусовых с целью быстрой локализации исходной области сбора. Модель KD-YOLOP основана на обучении с использованием дистилляции знаний и прореживании модели для снижения вычислительных затрат при сохранении конкурентоспособной точности. На этапе сегментации мы определяем модель RG-YOLO-seg для эффективной сегментации ветвей цитрусовых с целью вычисления точек сбора. Модель RG-YOLO-seg предложена с использованием RGNet для извлечения эффективных признаков и GSNeck для объединения разномасштабных признаков. Таким образом, благодаря использованию дистилляции знаний, прореживанию модели и легковесной модели для сегментации ветвей, предложенный CPPL обеспечивает точную локализацию точек сбора цитрусовых в реальном времени. Мы провели обширные эксперименты для оценки нашего метода; многочисленные результаты показывают, что предложенный CPPL превосходит существующие методы и достигает достаточной точности. Он представляет собой эффективный и надежный новый метод для сбора цитрусовых в реальном времени в практических сельскохозяйственных приложениях.

1. Введение

Сбор плодов является важнейшей процедурой в плодоовощной промышленности. В связи с быстрым ростом мировой индустрии цитрусовых, проблемы с рабочей силой становятся все более острыми для большинства стран-производителей цитрусовых [1,2]. Например, цитрусовая промышленность Белиза сталкивается с критической нехваткой рабочей силы из-за высоких затрат и строгих требований к трудовым мигрантам, что приводит к значительному сокращению объема собранных цитрусовых и потенциальным экономическим потерям до 15 миллионов долларов [3]. В США Министерство сельского хозяйства пытается внедрить программу по решению проблемы нехватки рабочей силы в цитрусовой отрасли путем предоставления стимулов [4]. В Китае производство цитрусовых выросло на 7%, достигнув более 64 миллионов метрических тонн, и эта тенденция продолжит расти [5]. Таким образом, существует насущная необходимость повышения производительности в цитрусовой промышленности. В большинстве регионов сбор цитрусовых по-прежнему преимущественно осуществляется вручную. Из-за сезонности, высокой урожайности и короткого периода сбора урожая ручной труд не справляется с нагрузкой [6]. Автоматизированная уборка урожая является одним из ключевых направлений модернизации сельского хозяйства; автоматический сбор плодов стал заметным направлением исследований, демонстрируя потенциал для решения проблемы нехватки рабочей силы [7].

В исследованиях, посвященных автоматическим роботам для сбора плодов, разработка алгоритмов машинного зрения на основе глубокого обучения стала горячей темой в последние годы. Ключевая проблема автоматического сбора плодов заключается в точной и стабильной локализации точек сбора плодов на основе рабочего органа робота и целевого плода [8,9]. На точность локализации точек сбора может влиять множество факторов, такие как сложные условия произрастания плодов, скученность плодов и их затенение, условия освещения и погодные условия [10]. Несмотря на эти трудности, автоматический сбор плодов должен удовлетворять таким требованиям, как точное и быстрое позиционирование, быстрый сбор, адаптируемость к различным условиям среды, низкая повреждаемость и т.д. [11]. Для решения этих проблем исследователи сосредоточили усилия на разработке более эффективных и практичных методов локализации точек сбора. Помимо влияния самих роботизированных устройств, плодов и условий их уборки, существующие методы локализации точек сбора в основном опираются на алгоритмы обнаружения объектов и инстанс-сегментации. Основываясь на обнаружении объектов, инстанс-сегментации и постобработке, можно выделить три типа методов локализации точек сбора: методы на основе обнаружения, методы на основе сегментации и методы на основе комбинации обнаружения и сегментации.

Методы на основе обнаружения и методы на основе сегментации обычно сначала оптимизируют алгоритм обнаружения плодов или алгоритм инстанс-сегментации плодов, а затем вводят некоторые априорные предположения, основанные на особенностях роста плодов, для локализации точек сбора. В одном из примеров методов на основе обнаружения, Чжан и др. [12] объединили лазерную активно-визионную систему с моделью YOLOv5 для локализации яблок на деревьях, достигнув средней точности (mAP) 92.86%. Получив точные двухмерные пиксельные координаты и преобразовав их в трехмерные мировые координаты, они определили координаты плода как точки сбора. Аналогичные подходы были применены к различным плодам, включая цитрусовые [13,14], яблоки [12,15,16,17], ананасы [11], виноград [18,19], томаты [20,21], личи [22], нектарины [23], киви [24], маракуйю [25] и др. Что касается методов на основе сегментации, Ли и др. [26] разработали оптимизированную одноэтапную модель инстанс-сегментации для сбора личи и объединили результат сегментации со статистической информацией о гроздьях личи для локализации точки сбора, достигнув точности 82%. Аналогичные стратегии были применены к голубике [27,28], винограду [29,30], восковнице [31], клубнике [32,33], томатам [34] и др. Эти методы демонстрируют универсальность подходов на основе обнаружения и сегментации для различных типов плодов и сценариев уборки. Однако эти методы ограничены более сложными условиями в реальных садах, что приводит к низкой точности локализации точек сбора из-за их зависимости от результатов обнаружения или сегментации и собственных методов постобработки.

Чтобы дальнейший повысить эффективность и точность локализации точек сбора различных плодов, исследователи разрабатывают множество методов на основе комбинации обнаружения и сегментации, которые интегрируют алгоритм обнаружения объектов и алгоритм инстанс-сегментации одновременно. Например, Хуан и др. [35] представили оптимизированную сеть для локализации гроздей винограда, объединяющую обнаружение и инстанс-сегментацию в рамках Mask R-CNN. Их результаты были на 1.4% и 1.5% выше, чем у исходной модели. Аналогично, Ян и др. [36] предложили улучшенный алгоритм на основе модели YOLOv8 и достигли mAP 98.3% в распознавании яблок и mAP 81.6% в сегментации ветвей и стволов, что позволило одновременно выполнять обнаружение плодов яблок и сегментацию ветвей для точной локализации точек сбора. Эти подходы на основе комбинации обнаружения и сегментации используют преимущества обнаружения и сегментации, предоставляя детальную пространственную и структурную информацию о плодах и их окружении, тем самым улучшая процесс локализации. Поэтому было предложено множество других методов, применяемых к таким плодам, как виноград [37], яблоки [38], киви [39], цитрусовые [40], клубника [41] и др. Хотя все эти методы повышают точность локализации, однако они требуют одновременного получения результатов обнаружения и сегментации, поэтому необходимо иметь несколько нейронных сетей. Эти исследования чрезмерно сосредоточены на улучшении отдельных метрик обнаружения или сегментации, без оптимизации конструкции совместно с аппаратным обеспечением. Это ключевой фактор, учитывая низкую вычислительную мощность роботов для сбора урожая.

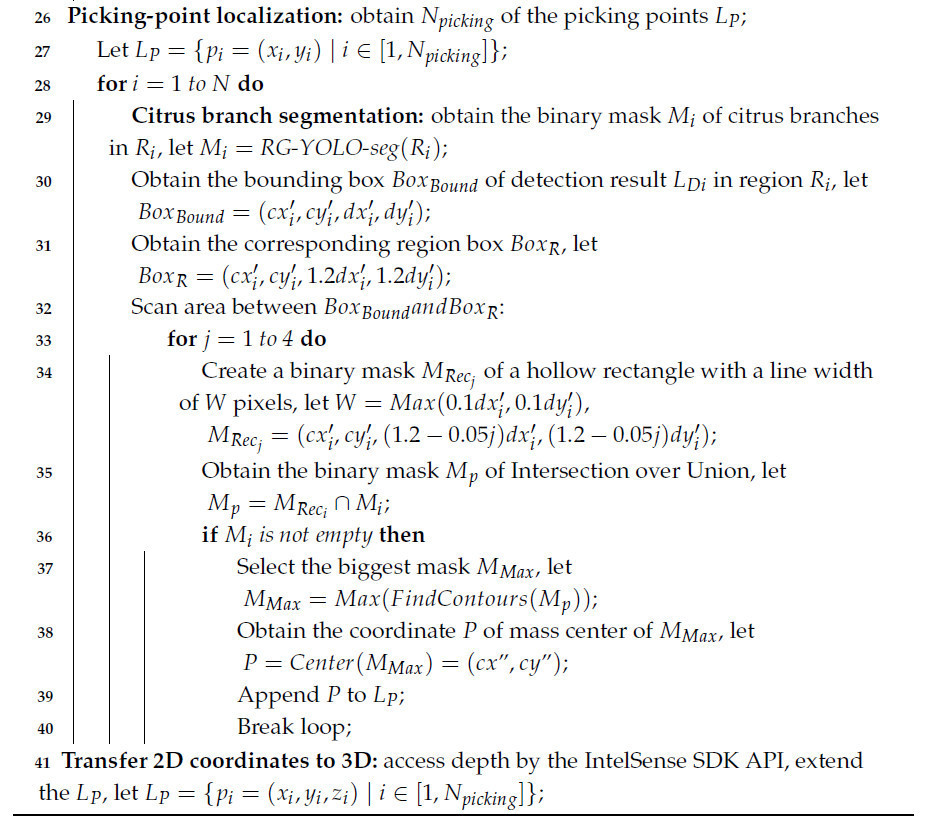

Для решения этих проблем мы ставим целью спроектировать весь процесс сбора цитрусовых в сотрудничестве с партнером по аппаратному обеспечению и оптимизировать модели главным образом с точки зрения задержки (латентности). Чтобы повысить эффективность автоматического сбора цитрусовых, мы изучаем реальный процесс сбора, выполняемый работником в настоящем саду. Как показано на Рисунке 1, интуитивный процесс сбора работником включает: приближение к дереву, выбор грозди цитрусовых плодов и отрезание ветви, соединенной с цитрусовыми плодами. В своей реальной работе работники не всегда срезают ветви, соединенные с плодом; иногда им также необходимо срезать ветви, которые загораживают плод. Поэтому мы выбираем ножничный резак в качестве нашего рабочего органа и оставляем потенциал для плановой обрезки в период вегетации. Мы выбираем камеру глубины IntelSense Depth Camera для зрения. В качестве базовой модели мы выбрали YOLOv8, поскольку она была наиболее широко используемой в последние два года в области исследований автоматического сбора плодов, с целью сделать наши результаты более воспроизводимыми и популяризировать достоинства нашего подхода.

Рисунок 1. Процесс сбора цитрусовых.

В отличие от большинства предыдущих работ, это исследование не концентрируется исключительно на улучшении оценочных метрик модели обнаружения или сегментации. Однако для оптимизации производительности задержки в этом исследовании используются три метода, включая оптимизированные модули, дистилляцию знаний и прореживание модели. Что касается оптимизированных модулей, мы в основном выбираем легковесные модули GSConv [42] и RepGhost [43], хотя это может немного снизить точность. Дистилляция знаний и прореживание модели — это два часто используемых метода оптимизации в реальном времени в области глубокого обучения. Дистилляция знаний — это вид эффективного метода трансферного обучения, используемого для сжатия и оптимизации модели [44]. Основная идея заключается в получении знаний от большой модели (называемой моделью-учителем) путем обучения малой модели (называемой моделью-студентом). Этот процесс направлен на уменьшение размера модели с одновременным максимально возможным сохранением ее производительности, что делает ее пригодной для сред с ограниченными ресурсами, таких как мобильные устройства или встраиваемые системы. Прореживание модели используется для отсечения избыточных нейронов; оно может эффективно уменьшить количество параметров модели, существенно не влияя на производительность. В глубоких нейронных сетях разные нейроны по-разному влияют на производительность. Для свежеобученной нейронной сети может существовать большое количество избыточных параметров, где у большого числа нейронов значения активации стремятся к 0, что означает, что эти нейроны не участвуют в обучении или инференсе. В заключение, все наши методы оптимизации в первую очередь предназначены для развертывания на реальных устройствах, а затем для балансировки производительности точности и задержки.

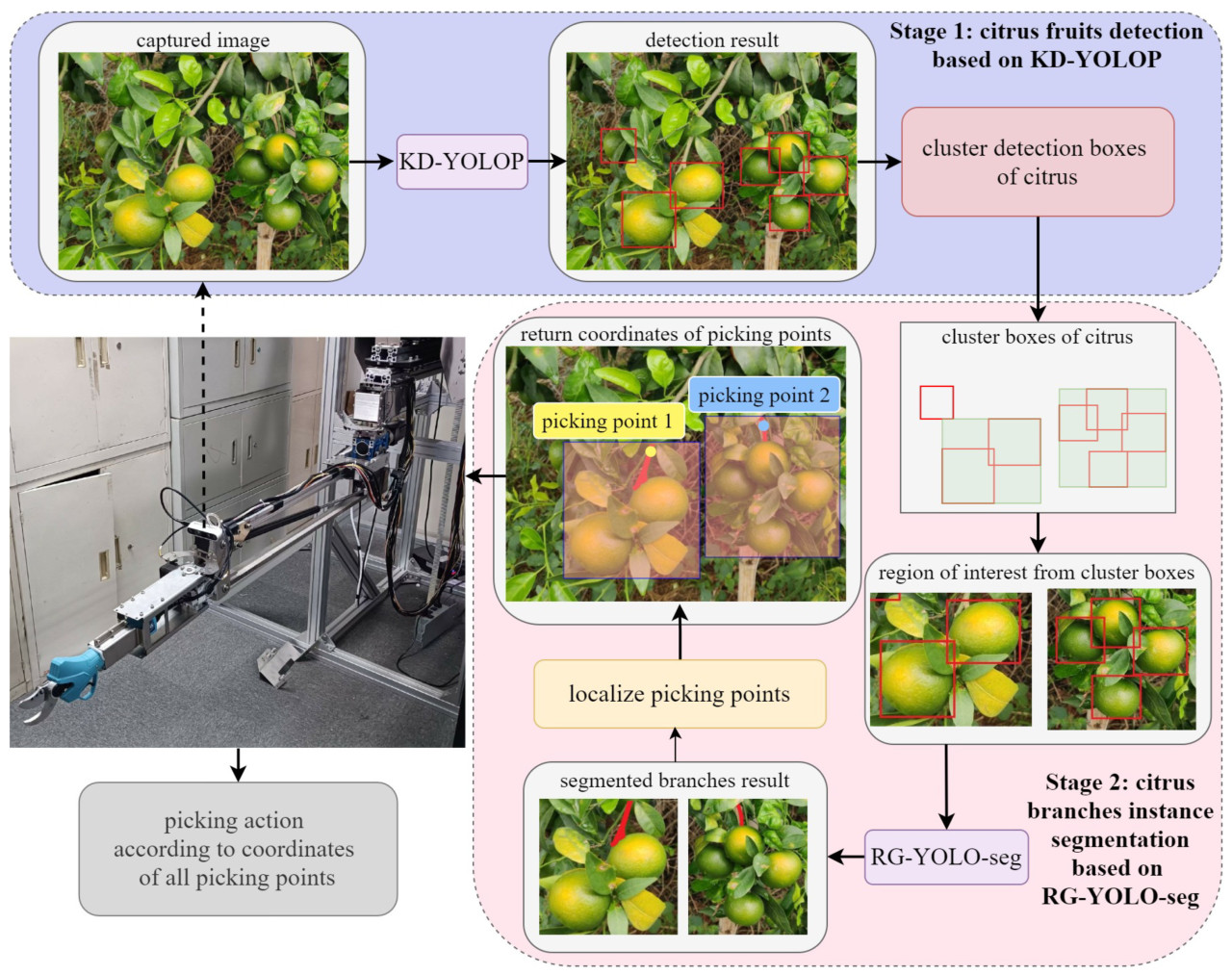

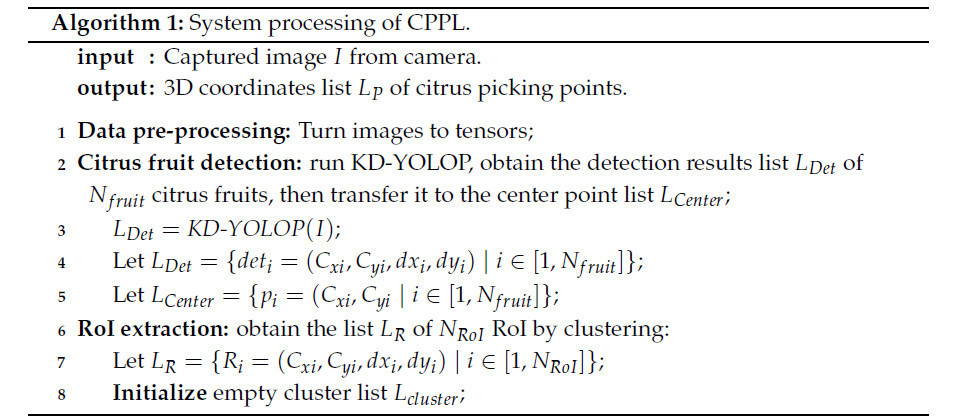

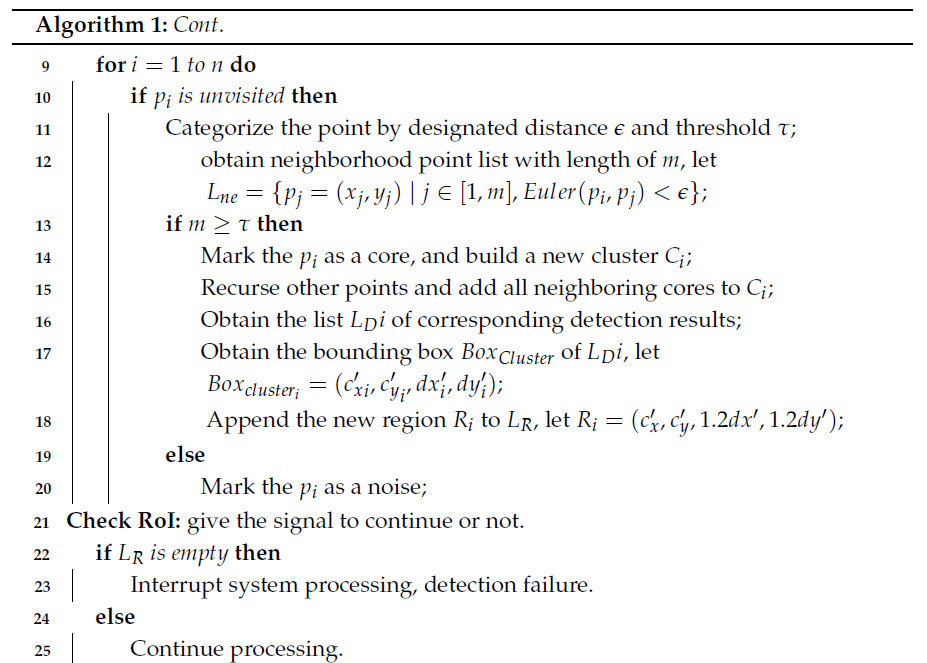

Чтобы снизить задержку всего системного процесса, мы предложили новый рабочий процесс для локализации точек сбора цитрусовых (CPPL). Как показано на Рисунке 2 и в Алгоритме 1, мы разрабатываем CPPL на основе соображений оптимизации интеграции аппаратного и программного обеспечения. CPPL построен путем определения KD-YOLOP для обнаружения плодов цитрусовых, алгоритма пространственной кластеризации для извлечения RoI, RG-YOLO-seg для сегментации ветвей цитрусовых и эффективного самостоятельно разработанного алгоритма обработки изображений для локализации точек сбора. Во-первых, KD-YOLOP используется для получения координат плодов цитрусовых. Во-вторых, алгоритм пространственной кластеризации применяется к результатам обнаружения плодов цитрусовых. На основе кластеров плодов цитрусовых извлекаются несколько RoI. В-третьих, RG-YOLO-seg используется для получения результата сегментации ветвей цитрусовых. С результатом обнаружения и пикселями сегментации мы получаем координаты из каждой RoI. Многочисленные эксперименты показали, что CPPL обеспечивает локализацию пиксельных точек сбора для цитрусовых плодов в реальном времени, предоставляя значительное улучшение по сравнению с существующими методами. Наш основной вклад заключается в следующем:

Рисунок 2. Рабочий процесс локализации точек сбора цитрусовых.

(1) Мы предлагаем эффективный и практичный рабочий процесс для локализации точек сбора цитрусовых (CPPL). CPPL удовлетворяет низким вычислительным требованиям автоматического робота для сбора урожая и адаптируется к реальным условиям сада. CPPL состоит из предложенных нами алгоритмов обнаружения (KD-YOLOP) и инстанс-сегментации (RG-YOLO-seg), обеспечивая точную локализацию точек сбора цитрусовых в реальном времени.

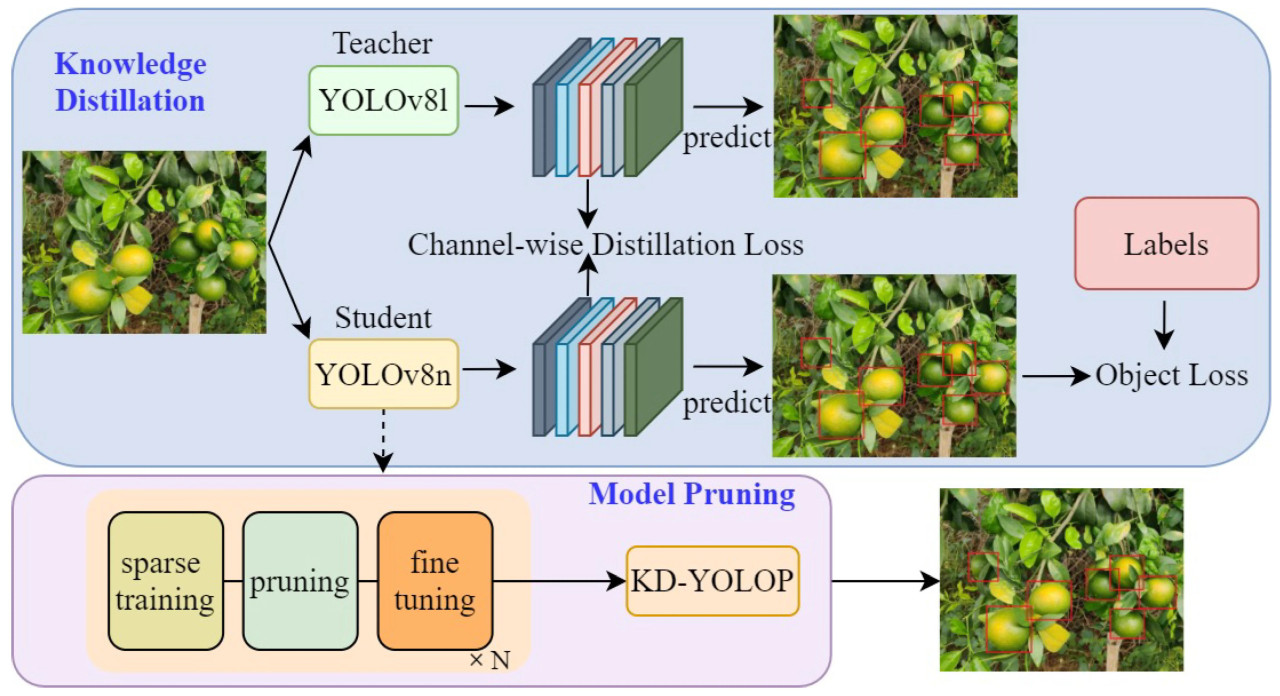

(2) Мы разрабатываем KD-YOLOP — новую модель обнаружения плодов цитрусовых, которая балансирует точность и задержку. Модель использует фреймворк дистилляции знаний, используя YOLOv8l в качестве модели-учителя и YOLOv8n в качестве модели-студента, с поканальной функцией потерь, обеспечивающей эффективное выравнивание знаний. После четырех раундов прореживания KD-YOLOP значительно сокращает количество параметров по сравнению с существующими методами обнаружения, сохраняя при этом конкурентоспособную точность.

(3) Мы разрабатываем RG-YOLO-seg — легковесную модель инстанс-сегментации, оптимизированную для сегментации ветвей цитрусовых. Эта модель включает RGNet в качестве основы (backbone) и GSNeck в качестве соединения (neck). RGNet использует эффективный модуль RepGhost для легковесного извлечения признаков, в то время как GSNeck применяет GSConv для эффективного слияния разномасштабных признаков. Предложенный RG-YOLO-seg снижает вычислительную сложность, сохраняя при этом высокую производительность сегментации.

(4) Мы проводим обширные эксперименты для оценки предложенных нами методов, разделяя их на количественный и качественный анализ. Результаты показывают, что предложенные нами алгоритмы превосходят другие, а предложенный CPPL достигает адекватной производительности.

2. Материалы и методы

2.1. Набор данных

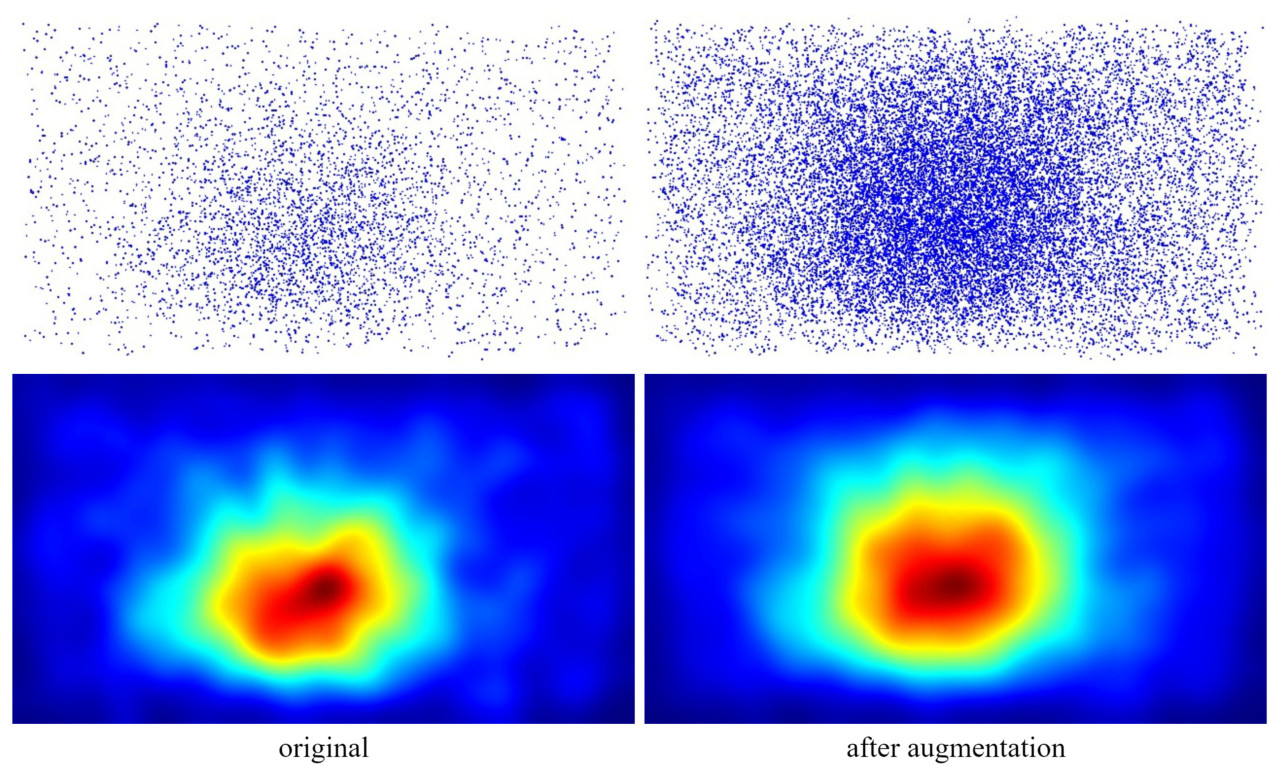

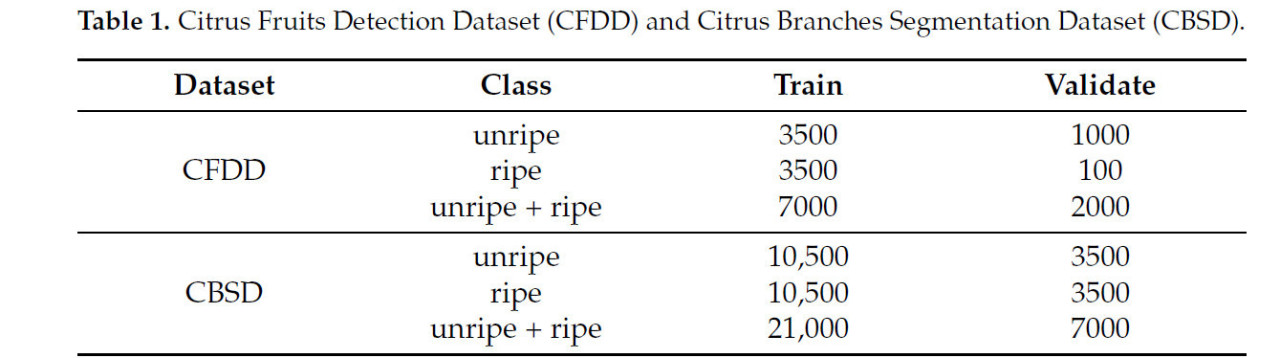

Изображения, использованные в этом исследовании, были получены в цитрусовых садах, расположенных в Наньнине, провинция Гуанси, Китай. Все данные были собраны в дневное время и включают спелые и незрелые плоды, как показано на Рисунке 3. Чтобы имитировать ракурс камеры на роботе, мы собирали изображения с расстояния от камеры до плода от 0.5 м до 1.0 м в солнечных, облачных и ветреных условиях. Из-за сложности садовой среды и в целях личной безопасности мы не проводили сбор данных в экстремальных условиях (например, в дождливые дни или ночью). Все изображения были предварительно обработаны до разрешения 1280 × 720 пикселей. Инструмент аннотации — Labelme (https://github.com/wkentaro/labelme (доступ открыт 9 октября 2022 г.)). Были созданы два набора данных: Набор данных для обнаружения плодов цитрусовых (CFDD) и Набор данных для сегментации ветвей цитрусовых (CBSD). Как показано на Рисунке 4, мы применили аугментацию данных, включая отражение, сдвиг, регулировку яркости, регулировку насыщенности, добавление шума и поворот, для расширения исходного набора данных. Как показано на Рисунке 5, мы нанесли на график положение плодов цитрусовых в виде точечной диаграммы и тепловой карты; после аугментации данных распределение пространственных местоположений стало более сбалансированным. Набор данных CFDD включает 9000 размеченных изображений, а набор данных CBSD включает 28 000 размеченных изображений. Как представлено в Таблице 1, мы разделили наборы данных CFDD и CBSD на подмножества для обучения и валидации.

Рисунок 3. Исходные данные изображений цитрусовых.

Рисунок 4. Примеры аугментации данных.

Рисунок 5. Изменения статистических характеристик при аугментации данных.

Таблица 1. Набор данных для обнаружения плодов цитрусовых (CFDD) и Набор данных для сегментации ветвей цитрусовых (CBSD).

2.2. Рабочий процесс локализации точек сбора цитрусовых

Предложенный новый и эффективный рабочий процесс для локализации точек сбора цитрусовых (CPPL) показан на Рисунке 2. Рисунок также демонстрирует наше аппаратное обеспечение, где рабочим органом роботизированной руки является самостоятельно разработанный ножничный резак, а камера, установленная на роботизированной руке, — Intel RealSense Depth Camera D435i. На первом этапе захваченное изображение передается в наш предложенный алгоритм KD-YOLOP для обнаружения плодов цитрусовых. Затем результаты обнаружения используются для получения области интереса с помощью алгоритма пространственной кластеризации. На втором этапе извлеченные области интереса передаются в наш предложенный RG-YOLO-seg для инстанс-сегментации ветвей цитрусовых. Наконец, результаты обнаружения плодов цитрусовых и результаты сегментации ветвей цитрусовых используются для локализации точек сбора всех извлеченных областей интереса с помощью нашего разработанного алгоритма обработки изображений и логики. Координаты точек сбора преобразуются в трехмерные путем доступа к глубине захваченного изображения; впоследствии робот для сбора урожая воздействует на эти координаты одну за другой. Чтобы проиллюстрировать это более ясно, мы представляем следующий псевдокод в Алгоритме 1.

В частности, этап локализации точек сбора может быть оптимизирован для параллельных вычислений; представленный выше циклический обход приведен для простоты понимания.

2.3. KD-YOLOP для обнаружения плодов цитрусовых на основе дистилляции знаний и прореживания модели

Рисунок 6 иллюстрирует построение предложенного KD-YOLOP для обнаружения цитрусовых; он разделен на два этапа: дистилляция знаний (KD) и прореживание модели (MP). Для этапа KD модель YOLOv8l обучается на наборе данных CFDD, чтобы служить сетью-учителем, в то время как модель YOLOv8n назначается сетью-студентом. Впоследствии сеть-студент обучается для дистилляции знаний с использованием набора данных CFDD и выходных данных сети-учителя. Для этапа MP модель-студент с предыдущего этапа прореживается произвольное количество раз. Чем больше итераций прореживания, тем меньше параметров сохраняет KD-YOLOP.

Рисунок 6. Процесс обучения KD-YOLOP и генератора кластеров цитрусовых.

(1) Дистилляция знаний

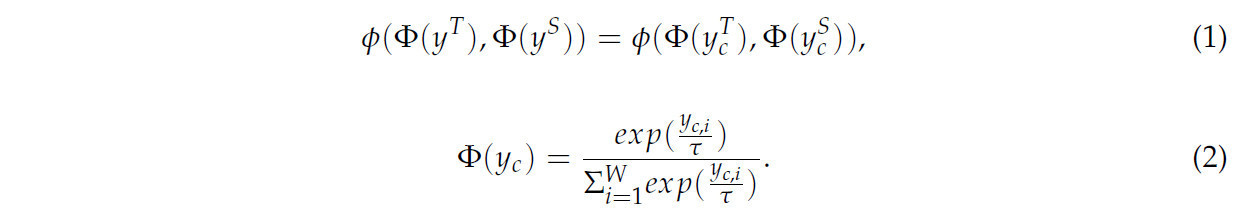

Дистилляция знаний (KD) является одной из техник сжатия и ускорения моделей, используемых при разработке эффективных глубоких моделей [44]. Обычно она применяется для передачи большей части производительности крупномасштабной нейронной сети меньшей по размеру. Помимо исходной функции потерь для обнаружения целей, вводится дополнительная функция потерь дистилляции знаний для измерения разницы между сетью-учителем и сетью-студентом. Минимизируя функцию потерь дистилляции знаний, сеть-студент может лучше усвоить «знания» сети-учителя, согласовывая их параметры признаков. В этой статье в качестве функции потерь дистилляции выбрана поканальная дистилляция (CWD) (как показано в Уравнении (1)), которая достигается путем нормализации карт активации каждого канала двух сетей и преобразования их в вероятностные распределения, а затем использования дивергенции Кульбака-Лейблера (KL) (как показано в Уравнении (2)) для измерения разницы между двумя моделями и, наконец, уменьшения разницы между двумя моделями через обратное распространение моделей. Функция потерь CWD и функция дивергенции KL показаны в Уравнениях (1) и (2):

В Уравнении (1) T и S обозначают сеть-учителя и сеть-студента соответственно. и обозначают активации этих двух сетей соответственно. Φ(·) — это функция преобразования, которая отвечает за преобразование значений активации сети в вероятностное распределение. В Уравнении (2) c=1,2,3… обозначает канал, i обозначает индекс каждого канала, τ — это гиперпараметр температуры, а — выходные данные каждого канала в сети-студенте. ϕ(·) — это функция рассеяния KL, которая используется для измерения разницы между распределениями каналов двух сетей.

(2) Прореживание модели

Нижняя часть Рисунка 6 иллюстрирует фреймворк прореживания для дистиллированной модели (сети-студента с предыдущего этапа). Чтобы эффективно снизить вычислительные затраты, сохраняя при этом точность, применяется прореживание модели; эта техника направлена на устранение избыточных нейронов, которые не вносят вклад в получение значимых результатов. Прореживание модели в основном включает разреженное обучение, прореживание и дообучение. Во-первых, разреженное обучение снижает вычислительные затраты и использование памяти путем обнуления менее важных весов. Затем прореживание удаляет неважные веса. Наконец, дообучение настраивает оставшиеся параметры для улучшения производительности модели. В этом разделе мы применяем четыре итерации прореживания к дистиллированной модели-студенту. Как показано в Уравнении (3), мы вводим члены L1-регуляризации на каждый слой пакетной нормализации (Batch Normalization) дистиллированной модели-студента для облегчения разреженного обучения.

В Уравнении (3) l представляет исходную функцию потерь модели, где (x, y) соответствует обучающим данным и меткам. W обозначает обучаемые параметры модели, в то время как g(·) представляет член штрафа, применяемый к масштабирующему коэффициенту. Параметр λ служит балансирующим фактором, контролирующим компромисс между исходной потерей и членом регуляризации. Наконец, γ — это масштабирующий коэффициент, введенный во время разреженного обучения.

На этапе прореживания мы фокусируемся на слоях Conv2d и BatchNorm2d внутри модулей Conv и C2f, а также на полносвязном слое (Linear) в декомпозированной голове. Этап дообучения гарантирует, что модель заново изучит любые утерянные признаки или адаптируется к новой прореженной структуре. Основываясь на этих процедурах, мы выполняем четыре итерации прореживания модели. Наконец, мы выбираем веса модели, которые обеспечивают наилучший баланс между вычислительными затратами и точностью, и обозначаем эту модель как KD-YOLOP.

2.4. RG-YOLO-seg для сегментации ветвей цитрусовых на основе легковесных модулей

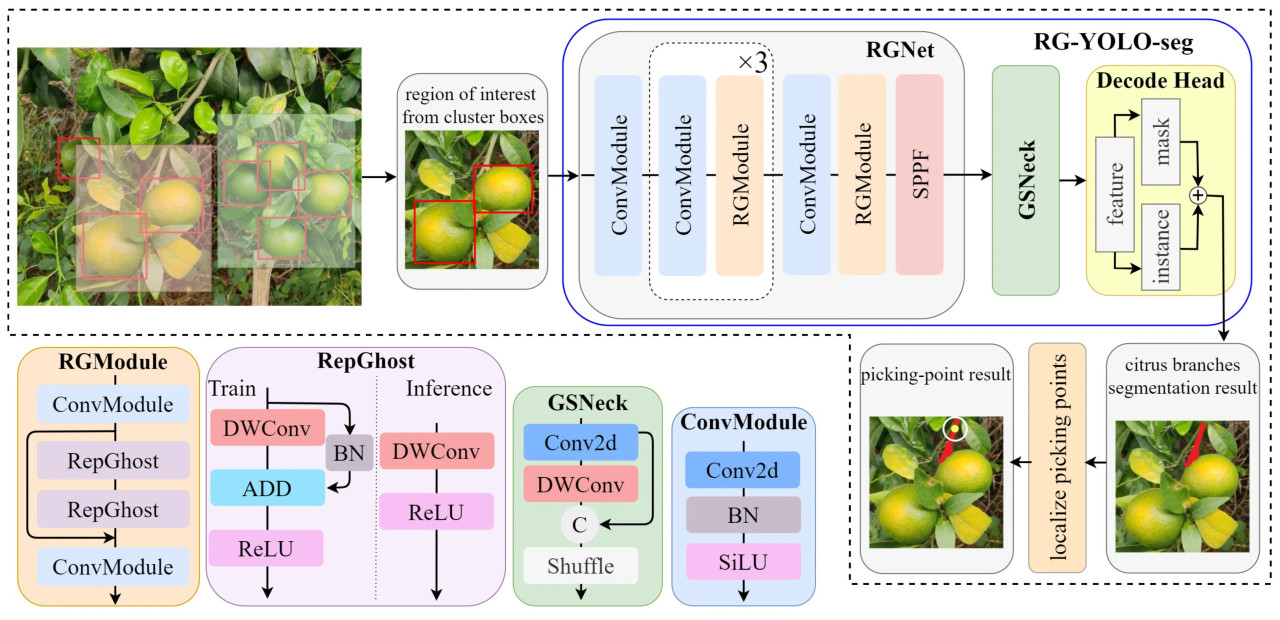

Используя предложенный KD-YOLOP, описанный в Разделе 2.3, плоды цитрусовых обнаруживаются на захваченном изображении. Впоследствии области интереса извлекаются на основе результатов обнаружения (красные ограничивающие рамки плодов цитрусовых на Рисунке 7). Как показано на Рисунке 7, локализация точек сбора цитрусовых достигается с помощью RG-YOLO-seg, который выполняет инстанс-сегментацию ветвей цитрусовых.

Рисунок 7. Обзор предлагаемого RG-YOLO-seg.

Фреймворк RG-YOLO-seg состоит из трех основных компонентов: основы (backbone) — RGNet, соединения (neck) — GSNeck и головы сегментации (Decode Head). RGNet, разработанная с использованием модуля RepGhost, служит основой и улучшает извлечение признаков, сохраняя при этом легковесную структуру. GSNeck, заимствующий принципы из GSConv, интегрирован как соединение для обеспечения эффективной обработки разномасштабных признаков. Голова декодирования (Decode Head), адаптированная из YOLOv8-seg, включена для выполнения инстанс-сегментации, эффективно дополняя предложенные RGNet и GSNeck.

Как показано на Рисунке 7, RGNet состоит из пяти слоев. За исключением первого и пятого слоев, каждый слой включает сверточный модуль (ConvModule) и RG-модуль (RGModule). ConvModule интегрирует двумерную свертку, слой пакетной нормализации и функцию активации SiLU. RGModule использует модуль RepGhost, основанную на репараметризации конструкцию, которая декомпозирует стандартную свертку на первичные и дешевые операции для снижения вычислительной стоимости извлечения признаков. За счет включения двух модулей RepGhost, соединенных прыжковой связью, RGModule способствует повторному использованию признаков. Эта структура позволяет генерировать разнообразные карты признаков с пониженными вычислительными затратами, тем самым расширяя емкость сети и улучшая общую эффективность извлечения признаков. Кроме того, модуль SPPF, включенный как часть RGNet, служит продвинутой версией модуля пространственного пирамидального пулинга (SPP), преобразуя карты признаков различных размеров в векторы признаков фиксированной длины для дальнейшей оптимизации эффективности представления.

GSNeck интегрирован в RG-YOLO-seg для балансировки сохранения семантической информации и эффективности модели. Этот модуль, как показано в зеленой рамке на Рисунке 7, использует операцию GSConv исключительно в соединении, где размерности карт признаков уже сжаты. Стратегическое размещение уменьшает количество параметров модели, сохраняя при этом глубину представления. Сохраняя важные соединения каналов без введения дополнительных преобразований, GSNeck эффективно повышает общую эффективность сети и ее производительность в реальном времени, достигая оптимального баланса между инновационностью и вычислительными затратами.

3. Эксперименты

Этот раздел описывает экспериментальную установку и анализ. Во-первых, экспериментальная среда, конфигурации параметров и оценочные метрики представлены в Разделе 3.1. Во-вторых, оценка производительности и сравнительные эксперименты проводятся для валидации предложенных методов в Разделах 3.2 и 3.3. В-третьих, проводится качественный анализ в Разделе 3.4. Наконец, выполняются абляционные исследования для анализа вклада ключевых компонентов в Разделе 3.5.

3.1. Экспериментальная среда и настройки параметров

Эксперименты в этом исследовании проводятся с использованием NVIDIA GeForce RTX 3090 GPU в паре с процессором Intel Xeon Silver 4214R. Операционная система — Ubuntu 18.04, драйвер GPU — CUDA 11.4, объем ОЗУ — 128 ГБ, объем памяти GPU — 24 ГБ. Программное обеспечение разработано с использованием Python 3.7.13 и PyTorch 1.7.1.

В процессе обучения размер пакета (batch size) установлен на 48, количество эпох обучения — 100, а скорость обучения (learning rate) зафиксирована на уровне 0.001. Уровень отсева (dropout rate) для KD-YOLOP и RG-YOLO-seg установлен на 0. Стратегия оптимизации для KD-YOLOP и RG-YOLO-seg — стохастический градиентный спуск (SGD). В отношении функции потерь, в этом исследовании используются три типа для облегчения обучения и прореживания модели: бинарная перекрестная энтропия (BCE) для ветви классификации, дистрибутивная фокальная потеря (Distribution Focal Loss) для ветви регрессии и полная метрика пересечения над объединением (CIoU) для ветви регрессии. Во время обратного распространения эти функции потерь взвешиваются в соотношении 7.5:0.5:1.5. Кроме того, используется функция потерь поканальной дистилляции (CWD) для минимизации различий между сетью-учителем и сетью-студентом во время обучения с дистилляцией знаний.

Оценочной метрикой для обнаружения плодов цитрусовых и сегментации ветвей цитрусовых является средняя средняя точность (mAP) на основе известного набора данных COCO [45]. В экспериментах по обнаружению мы используем mAP50:95. В экспериментах по сегментации мы устанавливаем пороги пересечения над объединением (IoU) на 0.35 (mAP35). Наборы данных CFDD и CBSD используются для экспериментального обучения обнаружению плодов цитрусовых и инстанс-сегментации ветвей цитрусовых соответственно. В процессе обучения пары изображений были обрезаны и улучшены, итоговый размер входного изображения стандартизирован до 640 × 640 пикселей.

3.2. Количественный анализ и оценка KD-YOLOP

Эксперименты для KD-YOLOP включают два этапа: дистилляцию знаний и прореживание модели. Эти два эксперимента основаны на наборе данных CFDD.

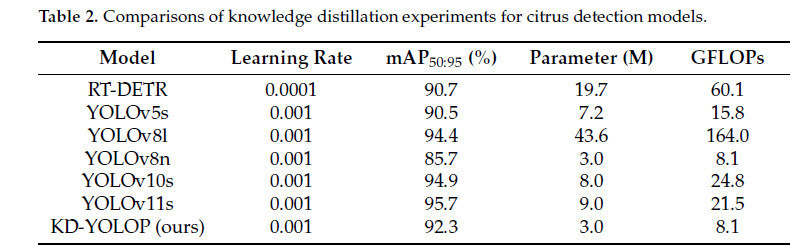

Таблица 2 показывает результаты экспериментов этапа дистилляции знаний (KD) для KD-YOLOP. RT-DETR [46], YOLOv5s, YOLOv8l, YOLOv8n, YOLOv10s [47] и YOLOv11s [48] выбраны в качестве методов сравнения, так как они являются наиболее широко используемыми моделями обнаружения в приложениях. Хотя точность обнаружения YOLOv8l на 8.7% выше, чем у YOLOv8n, однако размер параметров и вычислительные затраты YOLOv8l в 14 и 20 раз превышают таковые у YOLOv8n соответственно. KD-YOLOP сохраняет такое же количество параметров и вычислительные затраты, как YOLOv8n, но точность обнаружения улучшена на 6.6%. Кроме того, мы сравниваем наш метод с YOLOv5s, YOLOv10s и YOLOv11s, которые являются наиболее часто используемыми и новейшими моделями обнаружения в индустрии, а также с RT-DETR, новейшим быстрым Transformer-детектором. Точность обнаружения KD-YOLOP на 1.8% выше, чем у модели YOLOv5s, одновременно превосходя ее по показателям задержки. По сравнению с YOLOv10s и YOLOv11s, KD-YOLOP ниже на 2.6% и 3.4% соответственно. Однако размер параметров и вычислительные затраты у них примерно в 3 раза больше, чем у KD-YOLOP. По сравнению с RT-DETR, он выше на 1.6%. Размер параметров модели KD-YOLOP составляет 3.0 M, а вычислительные затраты — 8.1 GFLOPs, при этом и масштаб модели, и вычислительные затраты KD-YOLOP меньше.

Таблица 2.Сравнение результатов экспериментов по дистилляции знаний для моделей обнаружения цитрусовых.

После дистилляции знаний мы проводим эксперименты по прореживанию модели. Чем больше итераций прореживания, тем меньше точность и параметров сохраняет KD-YOLOP. Чтобы достичь наилучшего баланса между точностью и задержкой, мы проводим четыре итерации. По сравнению с дистиллированной моделью с предыдущего этапа, размер параметров модели уменьшен на 56.7%, вычислительные затраты снижены на 48.1%, а точность снижена на 10.2%.

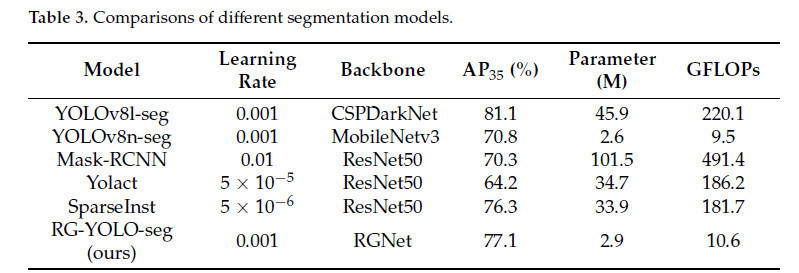

3.3. Количественный анализ и оценка RG-YOLO-seg

Предложенный алгоритм RG-YOLO-seg был оценен на наборе данных CBSD. Как показано в Таблице 3, мы сравниваем RG-YOLO-seg с четырьмя другими легковесными моделями инстанс-сегментации (YOLOv8n-seg, YOLOv8l-seg, Yolact [49], Mask-RCNN [50] и SparseInst [51]) с точки зрения средней точности, размера параметров (M) и GFLOPs. По сравнению с YOLOv8n-seg, который использует легковесный MobileNetV3 [52], наш метод демонстрирует схожее количество параметров и вычислительные затраты. Однако он превосходит YOLOv8n-seg, достигая на 6.3% более высокой точности сегментации. Эти результаты подчеркивают конкурентоспособность нашего метода в балансировании точности и задержки.

Таблица 3. Сравнение различных моделей сегментации.

3.4. Качественный анализ

Мы проводим качественный анализ KD-YOLOP и RG-YOLO-seg на основе визуализированных результатов набора данных CFDD и набора данных CBSD. Кроме того, мы проводим анализ ошибок на изображениях вне двух наборов данных. Мы разделяем наши эксперименты на два сценария: незрелые плоды и спелые плоды; первый используется для имитации применения нашего алгоритма в сценарии прореживания плодов, а второй — для имитации нашего алгоритма в сценарии уборки урожая.

(1) Обнаружение плодов цитрусовых на наборе данных CFDD незрелых плодов

Рисунок 8 представляет экспериментальные сравнения на наборе данных CFDD незрелых плодов. Первый, второй и третий столбцы показывают результаты YOLOv8n, YOLOv8l и KD-YOLOP соответственно. Вторая строка представляет собой увеличенную область, указанную на изображениях в первой строке, а четвертая строка представляет собой увеличенную область, указанную в третьей строке. Как показано во второй и четвертой строках, в областях перекрытия плодов и затенения плодов листьями как дистиллированная модель KD-YOLOP, так и модель-учитель демонстрируют более точную локализацию плодов цитрусовых. Это свидетельствует о том, что KD-YOLOP более адаптивен в обработке сложных деталей, что дополнительно подтверждает успешную передачу знаний от сети-учителя к сети-студенту в процессе дистилляции.

Рисунок 8. Сравнения на наборе данных CFDD незрелых плодов.

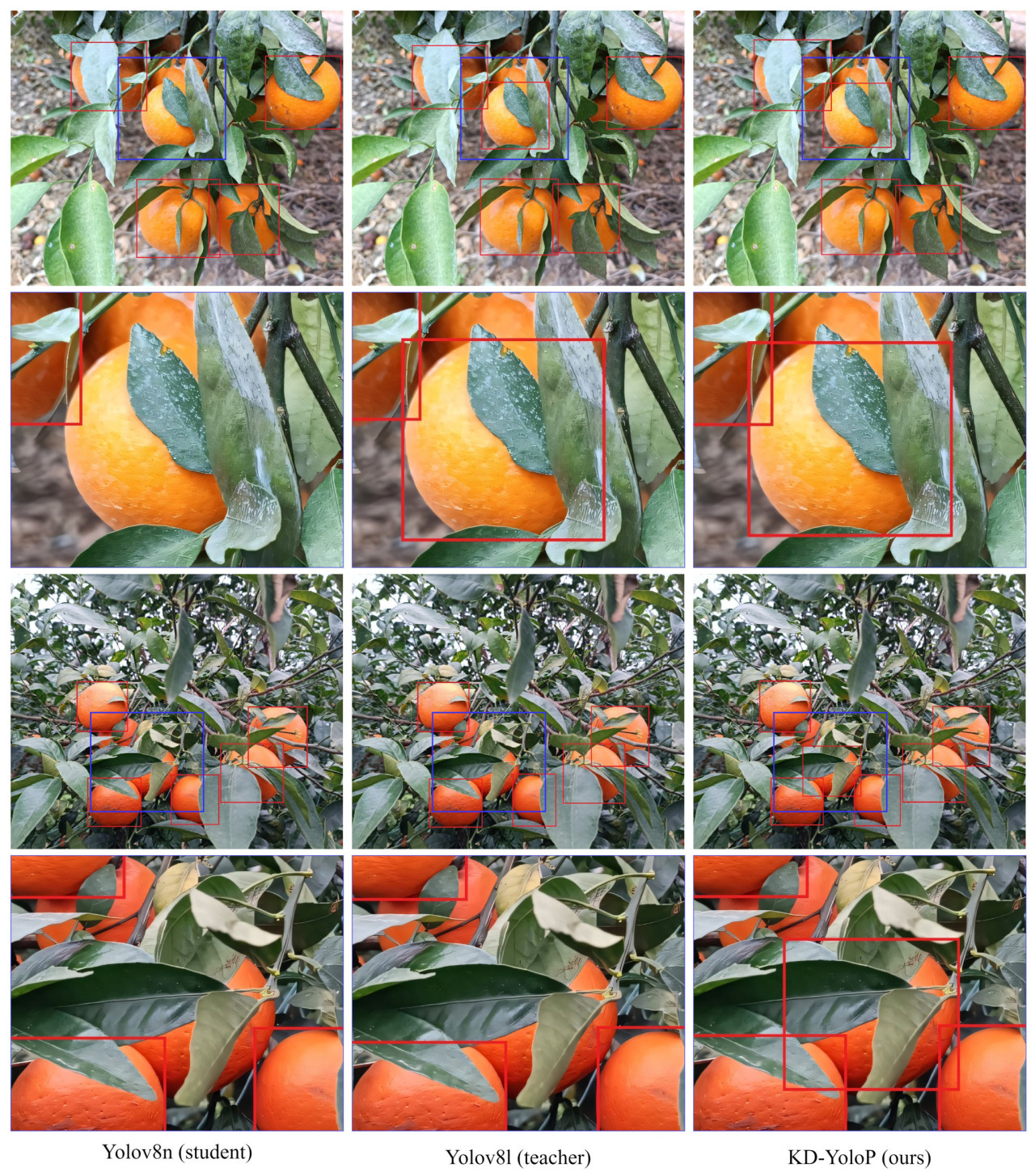

(2) Обнаружение плодов цитрусовых на наборе данных CFDD спелых плодов

Рисунок 9 представляет экспериментальные сравнения на наборе данных CFDD спелых плодов. Первый, второй и третий столбцы показывают результаты YOLOv8n, YOLOv8l и KD-YOLOP соответственно. Вторая строка представляет собой увеличенную область, указанную на изображениях в первой строке, а четвертая строка представляет собой увеличенную область, указанную в третьей строке. Сравнивая вторую и четвертую строки на Рисунке 9, предложенный KD-YOLOP успешно обнаруживает больше плодов цитрусовых, чем другие, в частности в ситуации затенения плода листвой.

Рисунок 9. Сравнения на наборе данных CFDD спелых плодов.

(3) Инстанс-сегментация ветвей цитрусовых на наборе данных CBSD незрелых плодов

Рисунок 10 представляет экспериментальные сравнения на наборе данных CBSD незрелых плодов. Первый, второй и третий столбцы показывают результаты YOLOv8n, YOLOv8l и RG-YOLO-seg соответственно. Как показано в первой, второй и четвертой строках на Рисунке 10, предложенный RG-YOLO-seg успешно сегментирует наиболее полные результаты ветвей цитрусовых. Это означает, что RG-YOLO-seg более подходит для предложенного CPPL, так как он может объединяться с кластерными рамками цитрусовых, дальнейший повышая точность CPPL.

Рисунок 10. Сравнения на наборе данных CBSD незрелых плодов.

(4) Инстанс-сегментация ветвей цитрусовых на наборе данных CBSD спелых плодов

Рисунок 11 представляет экспериментальные сравнения на наборе данных CBSD незрелых плодов. Первый, второй и третий столбцы показывают результаты YOLOv8n-seg, Mask-RCNN и RG-YOLO-seg соответственно. Для спелых плодов показана цветовая разница между плодами цитрусовых и ветвями цитрусовых. За исключением неверного предсказания, сделанного Mask-RCNN, два других метода успешно сегментируют ветвь, соединенную с плодом цитрусового. Сравнивая YOLOv8n-seg и RG-YOLO-seg, как показано в четвертой строке на Рисунке 11, предложенный RG-YOLO-seg успешно сегментирует ветви в ситуации затенения ветви листвой.

Рисунок 11. Сравнения на наборе данных CBSD спелых плодов.

(5) Анализ ошибок

Как показано на Рисунках 12 и 13, мы выбираем несколько ошибочных ситуаций при тестировании наших моделей на неразмеченных изображениях. Рисунок 12 показывает результат обнаружения KD-YOLOP. Наблюдая за результатами обнаружения спелых плодов, показанными в первой строке, мы видим, что для плодов, находящихся далеко, существует затенение, которое создает необнаруживаемую область. Для второй строки мы видим, что модель ошибочно идентифицирует листья как незрелые плоды. Это явление может быть связано с привычкой аннотирования; для спелых плодов мы игнорируем плоды на слишком большом расстоянии, а для незрелых плодов мы тщательно размечаем все плоды, даже если они почти полностью закрыты. Чтобы исправить эти ошибки, наиболее эффективный способ — пересмотреть наш набор данных. Рисунок 13 показывает результат сегментации RG-YOLO-seg. Для спелых и незрелых плодов в обоих случаях модель не может распознать все пиксели ветвей. Когда модель видит ствол дерева на расстоянии, ствол ошибочно распознается как ветвь. Эта проблема может быть интуитивно решена путем объединения с камерой глубины. Когда дело доходит до сценария с незрелыми плодами, модель не может распознать зеленые ветви (как показано в третьей сцене Рисунка 13). Для решения такого рода подобия-интерференции одним из потенциальных направлений улучшения является усиление извлечения высокочастотных признаков.

Рисунок 12. Анализ ошибок обнаружения плодов цитрусовых.

Рисунок 13. Анализ ошибок сегментации ветвей цитрусовых.

3.5. Абляционное исследование

Чтобы оценить эффективность наших предложенных методов, мы проводим многочисленные абляционные исследования на KD-YOLOP и RG-YOLO-seg.

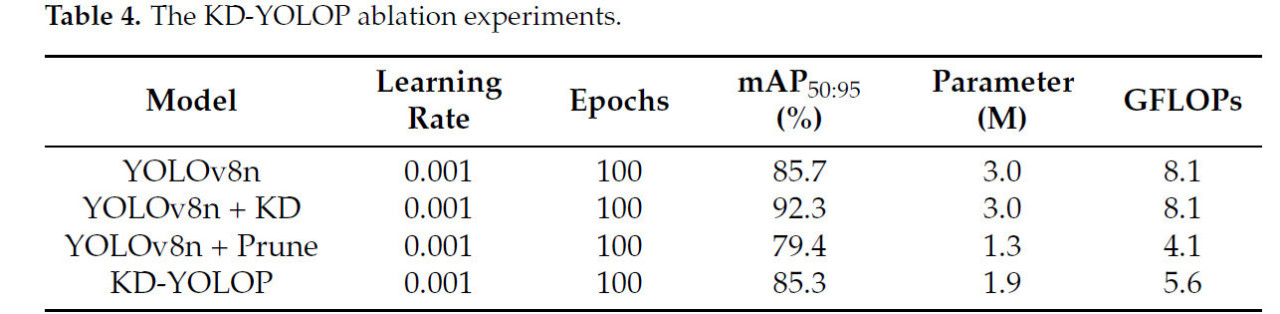

(1) KD-YOLOP для обнаружения плодов цитрусовых

В этой статье абляционные эксперименты по дистилляции знаний и прореживанию модели для KD-YOLOP были проведены с использованием набора данных CFDD для проверки эффективности обоих методов. Как показано в Таблице 4, мы определили YOLOv8n как базовую модель, а YOLOv8l — как сеть-учителя во время обучения с дистилляцией знаний. KD-YOLOP (1) был выбран в качестве репрезентативной модели для сравнения.

Таблица 4. Абляционные эксперименты KD-YOLOP.

Средняя точность (AP) базовой модели составляет 85.7% с количеством параметров 3.0 M и вычислительными затратами 8.1 GFLOPs. Когда применяется дистилляция знаний, AP модели увеличивается на 6.6%, в то время как количество параметров остается неизменным. Напротив, когда применяется только модуль прореживания, модель испытывает снижение AP на 6.3% после четырех итераций прореживания, с сокращением параметров на 56.7% и вычислительных затрат на 49.3%. Однако когда обе техники — дистилляция и прореживание — объединены в нашем предложенном KD-YOLOP, модель достигает AP 85.3%, сохраняя при этом свою легковесную природу. Это выделяет эффективность предложенных методов.

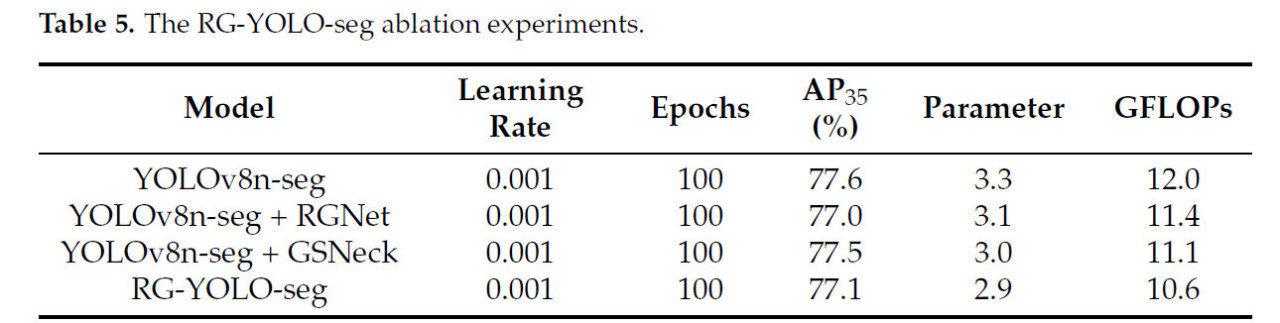

(2) RG-YOLO-seg для инстанс-сегментации ветвей цитрусовых

Мы проводим абляционные эксперименты модулей RGNet и GSNeck на наборе данных CBSD для проверки эффективности двух модулей соответственно. Мы используем YOLOv8n-seg в качестве базовой линии с AP 77.6%, количеством параметров 3.3 M и вычислительными затратами 12.0 GFLOPs. Когда RGNet используется в качестве легковесной основы (backbone), AP снижается на 1.4%, но параметры и вычислительный объем уменьшились на 6% и 5% соответственно. Когда мы используем GSConv для построения легковесного соединения (neck), AP модели снижается на 0.9%, но количество параметров и вычислительные затраты уменьшились на 9% и 7.5% соответственно. Напротив, когда и RGNet, и GSNeck используются для построения модели RG-YOLO-seg, AP модели снижается на 0.4%, в то время как количество параметров и вычислительные затраты уменьшаются на 12% и 11.7%. Хотя каждое легковесное улучшение вызывает определенную потерю AP, производительность задержки модели была эффективно улучшена, и, как показано на Рисунках 10 и 11, незначительное снижение AP сегментации не оказало какого-либо заметного влияния (Таблица 5).

Таблица 5. Абляционные эксперименты RG-YOLO-seg.

3.6. Результаты локализации точек сбора и анализ

Как показано на Рисунке 14, мы тестируем наш предложенный CPPL в различных сценариях; красные точки внутри желтых кругов указывают местоположения точек сбора. Эти сценарии можно классифицировать по относительному положению целевого плода цитрусового и соединенной с ним ветви, включая сценарий «посередине» (как показано в первом столбце Рисунка 14), сценарий «слева» (как показано во втором столбце Рисунка 14), сценарий «справа» (как показано в первой и второй строках третьего столбца Рисунка 14) и особый сценарий «снизу вверх» (как показано во второй и третьей строках третьего ряда Рисунка 14). Эти результаты подтверждают, что предложенный метод сохраняет отличную точность локализации, одновременно обеспечивая эффективность модели.

Рисунок 14. Визуализированные результаты локализации точек сбора цитрусовых.

4. Обсуждение

Наша оптимизация модели сосредоточена на облегчении (лайтвейтинге) с целью достижения наилучшего баланса между точностью и задержкой. Наша практика показывает, что изменения на несколько процентных пунктов в метриках обнаружения или сегментации существенно не влияют на идентификацию точек сбора. В частности, испытания в реальном саду полностью отличаются от лабораторных, где сравниваются значения. Когда метрики обнаружения или сегментации достигают определенного высокого значения, узким местом локализации точек сбора цитрусовых становится задержка этих моделей обнаружения и сегментации, а наша разработанная алгоритмическая логика использует результаты обнаружения плодов цитрусовых и сегментации ветвей цитрусовых. Однако логика проектирования всей системы непрерывно изменяется и итерируется во время полевых испытаний. Поэтому наиболее значимой особенностью нашей оптимизированной модели глубокого обучения является то, что она обеспечивает достаточно стабильную точность при минимально возможной задержке (меньше параметров и вычислительных затрат) при использовании в качестве части CPPL.

В области автоматического сбора плодов были изучены различные методологии, включая классические техники компьютерного зрения, методы на основе трехмерной реконструкции и методы на основе LiDAR. Каждый из этих подходов имеет свои уникальные сильные стороны и области применения, в частности в использовании разнообразных сенсорных технологий. Классические техники компьютерного зрения были широко распространены благодаря их способности эффективно обрабатывать двумерные изображения до подъема методов глубокого обучения, предлагая решения для обнаружения объектов и сегментации. Однако их зависимость от монокулярной визуальной информации может ограничивать их возможности в более сложных задачах пространственного восприятия. С другой стороны, методы на основе трехмерной реконструкции превосходны в пространственном понимании и восприятии глубины, позволяя точно моделировать сложные среды. Аналогично, методы на основе LiDAR с их точными возможностями измерения расстояния особенно выгодны для задач, требующих высокой точности в картографировании окружающей среды и обнаружении препятствий.

Мы признаем продуманное использование этих разнообразных сенсоров в вышеупомянутых техниках и их значительный вклад в автоматизацию сельского хозяйства. Несмотря на их преимущества, важно отметить, что подходы на основе компьютерного зрения (CV) достигли замечательных успехов в последние годы, чему способствовало быстрое развитие алгоритмов глубокого обучения и улучшенная вычислительная эффективность. Эти достижения сделали CV-методы все более устойчивыми и масштабируемыми для реальных приложений.

На данном этапе наша работа сосредоточена на CV-решениях из-за их стабильности и адаптируемости в различных сценариях. Тем не менее, мы признаем потенциал интеграции методов трехмерной реконструкции и LiDAR-методов для дальнейшего расширения возможностей автоматических систем сбора плодов. Будущие исследования будут направлены на изучение такой интеграции, используя взаимодополняющие сильные стороны этих методов для продвижения области.

5. Выводы

В этом исследовании предложенный рабочий процесс для локализации точек сбора цитрусовых (CPPL) был направлен на устранение ограничений автоматической уборки цитрусовых в реальных садовых условиях. Мы сотрудничали с партнером по аппаратному обеспечению, и основной идеей нашей стратегии было балансирование точности и задержки алгоритмов, используемых в процессе автоматической уборки урожая. Поэтому мы предлагаем KD-YOLOP для обнаружения плодов цитрусовых и RG-YOLO-seg для инстанс-сегментации ветвей цитрусовых. Используя дистилляцию знаний и прореживание модели для KD-YOLOP, а также легковесную модель для RG-YOLO-seg, мы в итоге достигли локализации точек сбора цитрусовых в реальном времени. Мы создали Набор данных для обнаружения плодов цитрусовых (CFDD) и Набор данных для сегментации ветвей цитрусовых (CBSD) для наших обширных экспериментов. Мы провели обширные эксперименты на основе наборов данных CFDD и CBSD для оценки нашего метода; многочисленные результаты показывают, что предложенный CPPL превосходит упомянутые методы и достигает адекватной точности. Он предоставляет эффективный и надежный новый метод для сбора цитрусовых в реальном времени в сельскохозяйственных приложениях.

Насколько нам известно и согласно изученной литературе, модель YOLOv8 широко используется в самых разных приложениях. Чтобы быть более обобщаемой, предложенные KD-YOLOP и RG-YOLO-seg основаны на YOLOv8. Поскольку предложенный CPPL является масштабируемым и гибким в адаптации различных моделей, производительность CPPL может быть легко улучшена с помощью более совершенных моделей в будущем. Эта особенность также повышает обобщаемость нашего метода для автоматической уборки других плодов.

Ссылки

1. Qi, L.; Qi, C. Status Quo and Development Trend of World’s Citrus Industry. Agric. Outlook 2016, 12, 46–52. [Google Scholar] [CrossRef]

2. FreshPlaza. Global Market Report; FreshPlaza: Citrus, TX, USA, 2025. [Google Scholar]

3. Humes, A. Severe Labour Shortage to Harvest Crop Plagues the Citrus Industry; Up to $15 Million in Losses Possible. 2022. Available online: https://www.breakingbelizenews.com/2022/03/04/severe-labour-shortage-to-harvest-crop-plagues-the-citrus-industry-up-to-15-million-in-losses-possible/ (accessed on 1 October 2024).

4. Citrus Industry Magazine. Program Provides Incentives to Address Labor Challenges. 2023. Available online: https://citrusindustry.net/2023/10/13/program-provides-incentives-to-address-labor-challenges/ (accessed on 1 October 2024).

5. FreshFruitPortal. Chinese Citrus Production to Increase Slightly, Despite Challenges. 2025. Available online: https://www.freshfruitportal.com/news/2025/01/07/chinese-citrus-production-to-increase-slightly-despite-challenges/ (accessed on 1 October 2024).

6. Hou, G.; Chen, H.; Jiang, M.; Niu, R. An Overview of the Application of Machine Vision in Recognition and Localization of Fruit and Vegetable Harvesting Robots. Agriculture 2023, 13, 1814. [Google Scholar] [CrossRef]

7. Xin, Q.; Luo, Q.; Zhu, H. Key Issues and Countermeasures of Machine Vision for Fruit and Vegetable Picking Robot. In Mechatronics and Automation Technology; IOS Press: Amsterdam, The Netherlands, 2024; pp. 69–78. [Google Scholar] [CrossRef]

8. Wang, C.; Pan, W.; Zou, T.; Li, C.; Han, Q.; Wang, H.; Yang, J.; Zou, X. A Review of Perception Technologies for Berry Fruit-Picking Robots: Advantages, Disadvantages, Challenges, and Prospects. Agriculture 2024, 14, 1346. [Google Scholar] [CrossRef]

9. Li, W.; Yin, H.; Li, Y.; Liu, X.; Liu, J.; Wang, H. Research on the Jet Distance Enhancement Device for Blueberry Harvesting Robots Based on the Dual-Ring Model. Agriculture 2024, 14, 1563. [Google Scholar] [CrossRef]

10. Chen, Z.; Lei, X.; Yuan, Q.; Qi, Y.; Ma, Z.; Qian, S.; Lyu, X. Key Technologies for Autonomous Fruit-and Vegetable-Picking Robots: A Review. Agronomy 2024, 14, 2233. [Google Scholar] [CrossRef]

11. He, F.; Zhang, Q.; Deng, G.; Li, G.; Yan, B.; Pan, D.; Luo, X.; Li, J. Research Status and Development Trend of Key Technologies for Pineapple Harvesting Equipment: A Review. Agriculture 2024, 14, 975. [Google Scholar] [CrossRef]

12. Zhang, Q.; Su, W.H. Real-Time Recognition and Localization of Apples for Robotic Picking Based on Structural Light and Deep Learning. Smart Cities 2023, 6, 3393–3410. [Google Scholar] [CrossRef]

13. Gu, B.; Wen, C.; Liu, X.; Hou, Y.; Hu, Y.; Su, H. Improved YOLOv7-tiny complex environment citrus detection based on lightweighting. Agronomy 2023, 13, 2667. [Google Scholar] [CrossRef]

14. Yu, Y.; Liu, Y.; Li, Y.; Xu, C.; Li, Y. Object Detection Algorithm for Citrus Fruits Based on Improved YOLOv5 Model. Agriculture 2024, 14, 1798. [Google Scholar] [CrossRef]

15. Yan, B.; Li, X. RGB-D Camera and Fractal-Geometry-Based Maximum Diameter Estimation Method of Apples for Robot Intelligent Selective Graded Harvesting. Fractal Fract. 2024, 8, 649. [Google Scholar] [CrossRef]

16. Fan, P.; Zheng, C.; Sun, J.; Chen, D.; Lang, G.; Li, Y. Enhanced Real-Time Target Detection for Picking Robots Using Lightweight CenterNet in Complex Orchard Environments. Agriculture 2024, 14, 1059. [Google Scholar] [CrossRef]

17. Liu, J.; Zhao, G.; Liu, S.; Liu, Y.; Yang, H.; Sun, J.; Yan, Y.; Fan, G.; Wang, J.; Zhang, H. New Progress in Intelligent Picking: Online Detection of Apple Maturity and Fruit Diameter Based on Machine Vision. Agronomy 2024, 14, 721. [Google Scholar] [CrossRef]

18. Wang, W.; Shi, Y.; Liu, W.; Che, Z. An Unstructured Orchard Grape Detection Method Utilizing YOLOv5s. Agriculture 2024, 14, 262. [Google Scholar] [CrossRef]

19. Zhao, J.; Yao, X.; Wang, Y.; Yi, Z.; Xie, Y.; Zhou, X. Lightweight-Improved YOLOv5s Model for Grape Fruit and Stem Recognition. Agriculture 2024, 14, 774. [Google Scholar] [CrossRef]

20. Wu, M.; Lin, H.; Shi, X.; Zhu, S.; Zheng, B. MTS-YOLO: A Multi-Task Lightweight and Efficient Model for Tomato Fruit Bunch Maturity and Stem Detection. Horticulturae 2024, 10, 1006. [Google Scholar] [CrossRef]

21. Cai, Y.; Cui, B.; Deng, H.; Zeng, Z.; Wang, Q.; Lu, D.; Cui, Y.; Tian, Y. Cherry Tomato Detection for Harvesting Using Multimodal Perception and an Improved YOLOv7-Tiny Neural Network. Agronomy 2024, 14, 2320. [Google Scholar] [CrossRef]

22. Cao, H.; Zhang, G.; Zhao, A.; Wang, Q.; Zou, X.; Wang, H. YOLOv8n-CSE: A Model for Detecting Litchi in Nighttime Environments. Agronomy 2024, 14, 1924. [Google Scholar] [CrossRef]

23. Zhang, G.; Yang, X.; Lv, D.; Zhao, Y.; Liu, P. YOLOv8n-CSD: A Lightweight Detection Method for Nectarines in Complex Environments. Agronomy 2024, 14, 2427. [Google Scholar] [CrossRef]

24. Yang, Y.; Su, L.; Zong, A.; Tao, W.; Xu, X.; Chai, Y.; Mu, W. A New Kiwi Fruit Detection Algorithm Based on an Improved Lightweight Network. Agriculture 2024, 14, 1823. [Google Scholar] [CrossRef]

25. Sun, Q.; Li, P.; He, C.; Song, Q.; Chen, J.; Kong, X.; Luo, Z. A Lightweight and High-Precision Passion Fruit YOLO Detection Model for Deployment in Embedded Devices. Sensors 2024, 24, 4942. [Google Scholar] [CrossRef]

26. Li, Y.; Liao, J.; Wang, J.; Luo, Y.; Lan, Y. Prototype Network for Predicting Occluded Picking Position Based on Lychee Phenotypic Features. Agronomy 2023, 13, 2435. [Google Scholar] [CrossRef]

27. Gonzalez, S.; Arellano, C.; Tapia, J.E. Deepblueberry: Quantification of blueberries in the wild using instance segmentation. IEEE Access 2019, 7, 105776–105788. [Google Scholar] [CrossRef]

28. Ni, X.; Li, C.; Jiang, H.; Takeda, F. Deep learning image segmentation and extraction of blueberry fruit traits associated with harvestability and yield. Hortic. Res. 2020, 7, 110. [Google Scholar] [CrossRef] [PubMed]

29. Luo, L.; Liu, W.; Lu, Q.; Wang, J.; Wen, W.; Yan, D.; Tang, Y. Grape berry detection and size measurement based on edge image processing and geometric morphology. Machines 2021, 9, 233. [Google Scholar] [CrossRef]

30. Chen, Y.; Li, X.; Jia, M.; Li, J.; Hu, T.; Luo, J. Instance Segmentation and Number Counting of Grape Berry Images Based on Deep Learning. Appl. Sci. 2023, 13, 6751. [Google Scholar] [CrossRef]

31. Wang, Y.; Lv, J.; Xu, L.; Gu, Y.; Zou, L.; Ma, Z. A segmentation method for waxberry image under orchard environment. Sci. Hortic. 2020, 266, 109309. [Google Scholar] [CrossRef]

32. Pérez-Borrero, I.; Marín-Santos, D.; Gegúndez-Arias, M.E.; Cortés-Ancos, E. A fast and accurate deep learning method for strawberry instance segmentation. Comput. Electron. Agric. 2020, 178, 105736. [Google Scholar] [CrossRef]

33. Cai, C.; Tan, J.; Zhang, P.; Ye, Y.; Zhang, J. Determining strawberries’ varying maturity levels by utilizing image segmentation methods of improved deeplabv3+. Agronomy 2022, 12, 1875. [Google Scholar] [CrossRef]

34. Xu, P.; Fang, N.; Liu, N.; Lin, F.; Yang, S.; Ning, J. Visual recognition of cherry tomatoes in plant factory based on improved deep instance segmentation. Comput. Electron. Agric. 2022, 197, 106991. [Google Scholar] [CrossRef]

35. Huang, X.; Peng, D.; Qi, H.; Zhou, L.; Zhang, C. Detection and Instance Segmentation of Grape Clusters in Orchard Environments Using an Improved Mask R-CNN Model. Agriculture 2024, 14, 918. [Google Scholar] [CrossRef]

36. Yan, B.; Liu, Y.; Yan, W. A novel fusion perception algorithm of tree branch/trunk and apple for harvesting robot based on improved yolov8s. Agronomy 2024, 14, 1895. [Google Scholar] [CrossRef]

37. Santos, T.T.; De Souza, L.L.; dos Santos, A.A.; Avila, S. Grape detection, segmentation, and tracking using deep neural networks and three-dimensional association. Comput. Electron. Agric. 2020, 170, 105247. [Google Scholar] [CrossRef]

38. Jia, W.; Zhang, Z.; Shao, W.; Ji, Z.; Hou, S. RS-Net: Robust segmentation of green overlapped apples. Precis. Agric. 2022, 23, 492–513. [Google Scholar] [CrossRef]

39. Fu, L.; Feng, Y.; Majeed, Y.; Zhang, X.; Zhang, J.; Karkee, M.; Zhang, Q. Kiwifruit detection in field images using Faster R-CNN with ZFNet. IFAC-PapersOnLine 2018, 51, 45–50. [Google Scholar] [CrossRef]

40. Yang, C.; Xiong, L.; Wang, Z.; Wang, Y.; Shi, G.; Kuremot, T.; Zhao, W.; Yang, Y. Integrated detection of citrus fruits and branches using a convolutional neural network. Comput. Electron. Agric. 2020, 174, 105469. [Google Scholar] [CrossRef]

41. Wang, C.; Ding, F.; Wang, Y.; Wu, R.; Yao, X.; Jiang, C.; Ling, L. Real-Time Detection and Instance Segmentation of Strawberry in Unstructured Environment. Comput. Mater. Contin. 2024, 78, 1481–1501. [Google Scholar] [CrossRef]

42. Li, H.; Li, J.; Wei, H.; Liu, Z.; Zhan, Z.; Ren, Q. Slim-neck by GSConv: A better design paradigm of detector architectures for autonomous vehicles. arXiv 2022, arXiv:2206.02424. [Google Scholar] [CrossRef]

43. Chen, C.; Guo, Z.; Zeng, H.; Xiong, P.; Dong, J. Repghost: A hardware-efficient ghost module via re-parameterization. arXiv 2022, arXiv:2211.06088. [Google Scholar] [CrossRef]

44. Gou, J.; Yu, B.; Maybank, S.J.; Tao, D. Knowledge distillation: A survey. Int. J. Comput. Vis. 2021, 129, 1789–1819. [Google Scholar] [CrossRef]

45. Lin, T.Y.; Maire, M.; Belongie, S.; Hays, J.; Perona, P.; Ramanan, D.; Dollár, P.; Zitnick, C.L. Microsoft coco: Common objects in context. In Proceedings of the Computer Vision–ECCV 2014: 13th European Conference, Zurich, Switzerland, 6–12 September 2014; Proceedings, Part V 13. Springer: Berlin, Germany, 2014; pp. 740–755. [Google Scholar]

46. Zhao, Y.; Lv, W.; Xu, S.; Wei, J.; Wang, G.; Dang, Q.; Liu, Y.; Chen, J. DETRs Beat YOLOs on Real-time Object Detection. In Proceedings of the 2024 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Seattle, WA, USA, 16–22 June 2024; pp. 16965–16974. [Google Scholar] [CrossRef]

47. Wang, A.; Chen, H.; Liu, L.; Chen, K.; Lin, Z.; Han, J.; Ding, G. YOLOv10: Real-Time End-to-End Object Detection. arXiv 2024, arXiv:2405.14458. [Google Scholar] [CrossRef]

48. Ultralytics. YOLOv11: Real-Time Object Detection and Tracking. 2025. Available online: https://github.com/ultralytics/ultralytics (accessed on 1 October 2024).

49. Bolya, D.; Zhou, C.; Xiao, F.; Lee, Y.J. Yolact: Real-time instance segmentation. In Proceedings of the IEEE/CVF International Conference on Computer Vision, Seoul, Republic of Korea, 27 October–2 November 2019; pp. 9157–9166. [Google Scholar] [CrossRef]

50. He, K.; Gkioxari, G.; Dollár, P.; Girshick, R. Mask r-cnn. In Proceedings of the IEEE International Conference on Computer Vision, Venice, Italy, 22–29 October 2017; pp. 2961–2969. [Google Scholar] [CrossRef]

51. Cheng, T.; Wang, X.; Chen, S.; Zhang, W.; Zhang, Q.; Huang, C.; Zhang, Z.; Liu, W. Sparse Instance Activation for Real-Time Instance Segmentation. In Proceedings of the IEEE Conference Computer Vision and Pattern Recognition (CVPR), New Orleans, LA, USA, 18–24 June 2022. [Google Scholar]

52. Howard, A.; Sandler, M.; Chu, G.; Chen, L.C.; Chen, B.; Tan, M.; Wang, W.; Zhu, Y.; Pang, R.; Vasudevan, V.; et al. Searching for mobilenetv3. In Proceedings of the IEEE/CVF International Conference on Computer Vision, Seoul, Republic of Korea, 27 October–2 November 2019; pp. 1314–1324. [Google Scholar] [CrossRef]

Liang Y, Jiang W, Liu Y, Wu Z, Zheng R. Picking-Point Localization Algorithm for Citrus Fruits Based on Improved YOLOv8 Model. Agriculture. 2025; 15(3):237. https://doi.org/10.3390/agriculture15030237

Перевод статьи «Picking-Point Localization Algorithm for Citrus Fruits Based on Improved YOLOv8 Model» авторов Liang Y, Jiang W, Liu Y, Wu Z, Zheng R., оригинал доступен по ссылке. Лицензия: CC BY. Изменения: переведено на русский язык

Комментарии (0)